地图

区块链

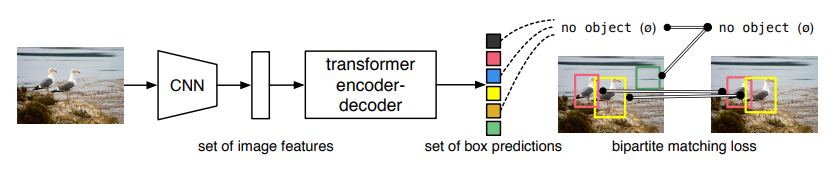

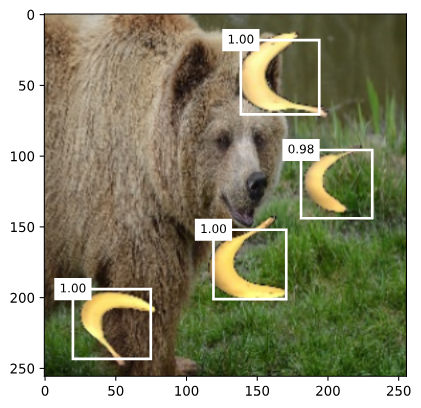

目标检测

教育电商

自动控制

kinect

螺旋折线

mongodb

PCB

数据统计

neo4j

Lock

azkaban

文档管理系统

redux

远程医疗

预处理器

requests库

择时策略

路径规划

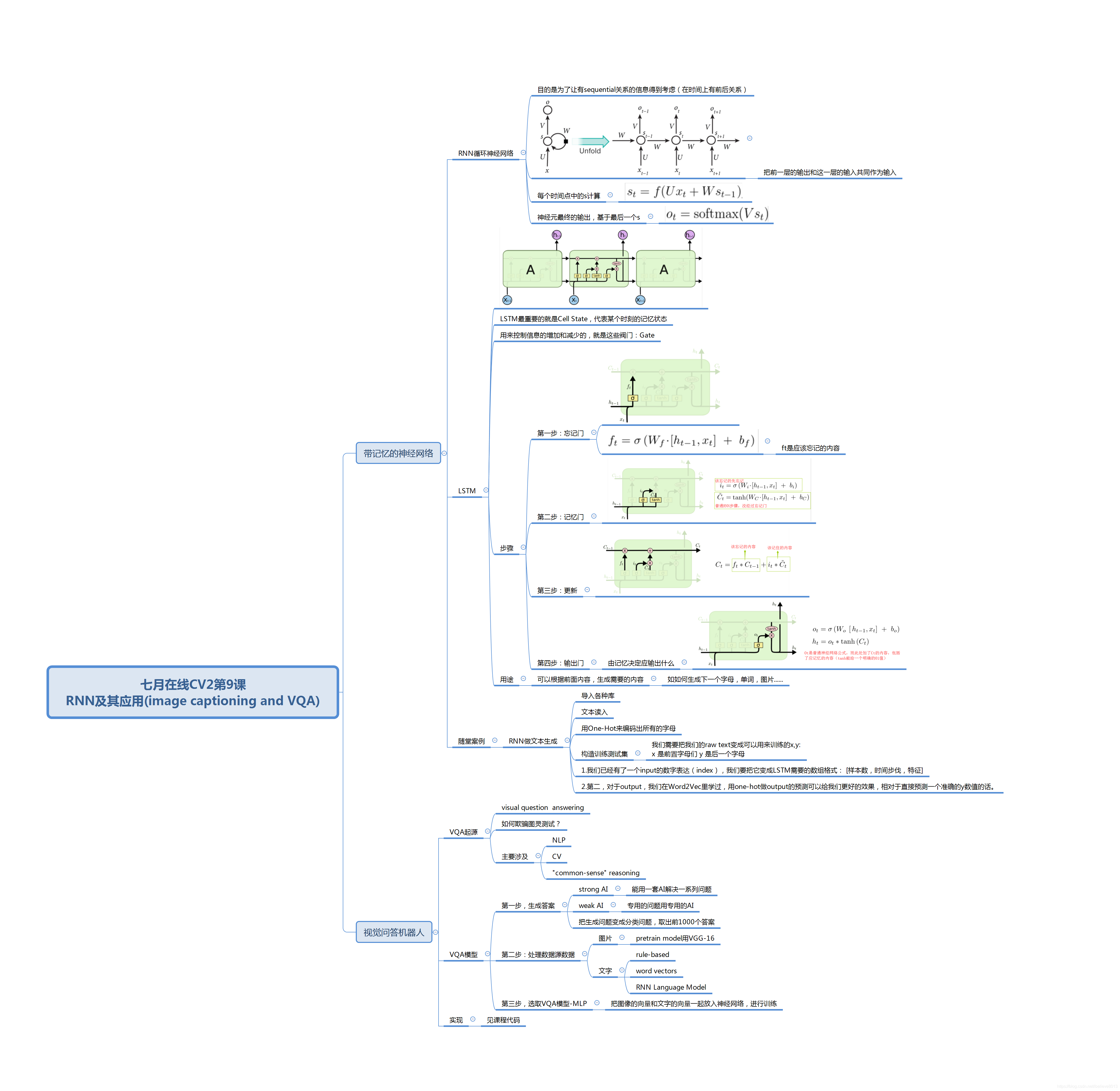

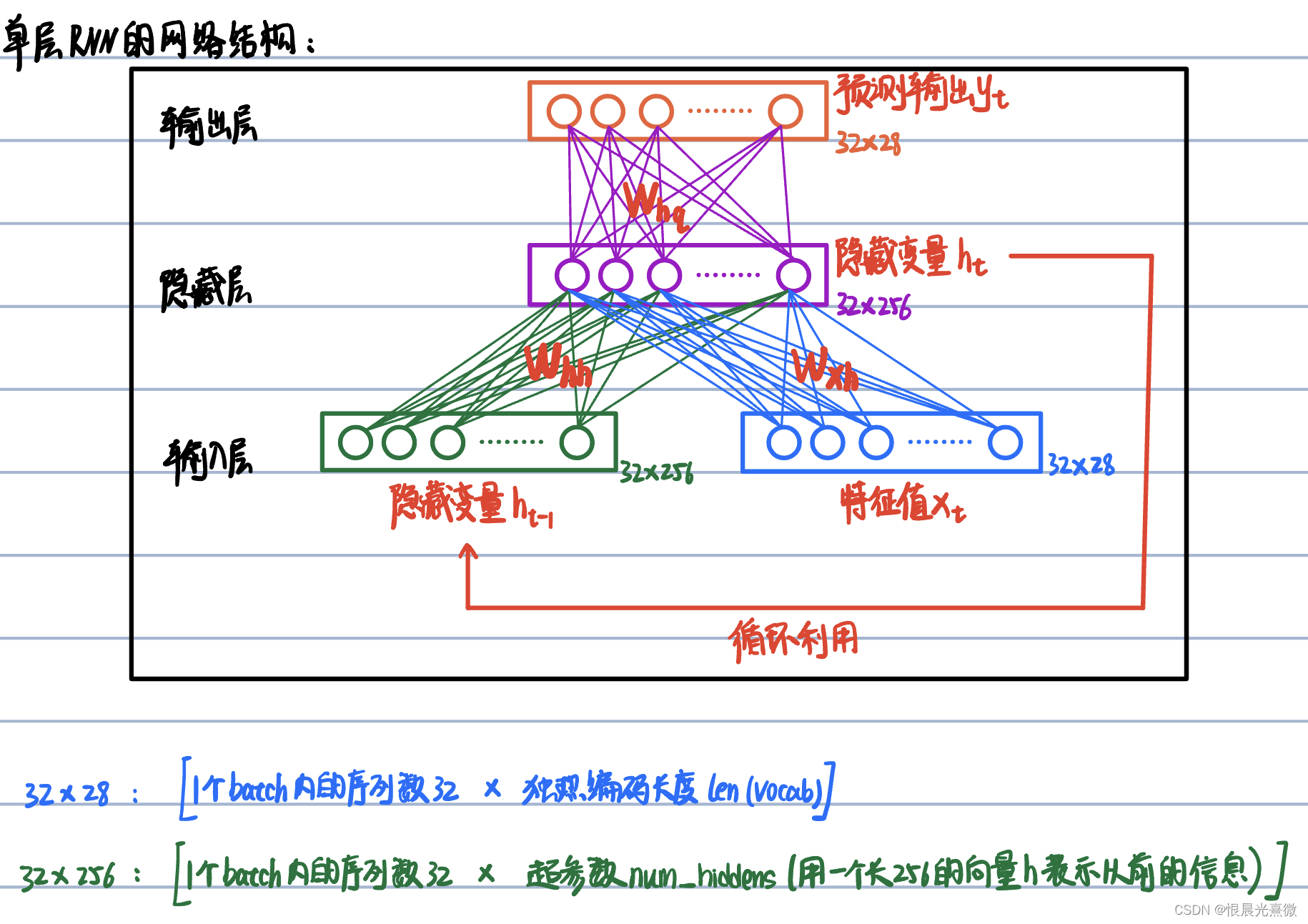

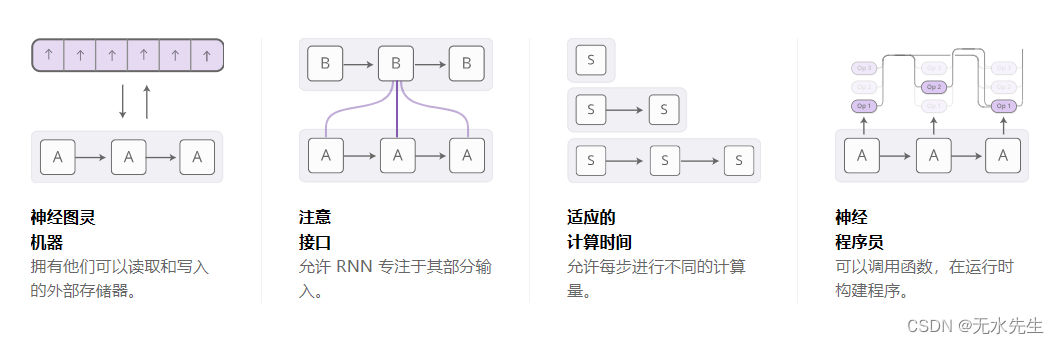

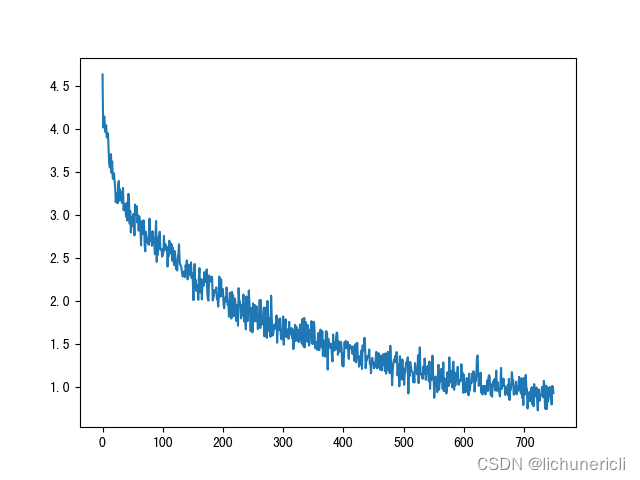

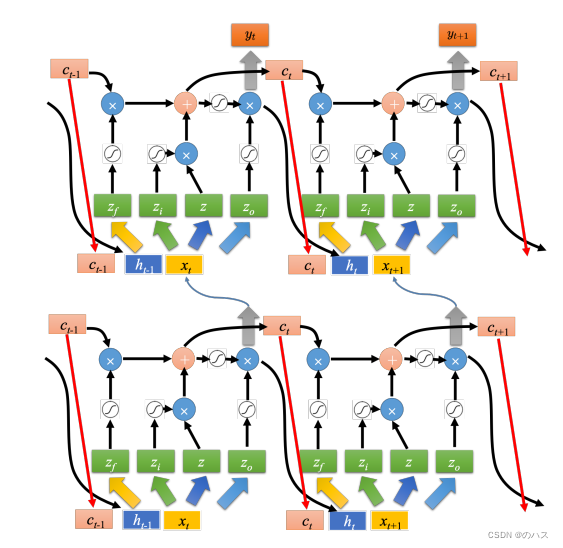

rnn

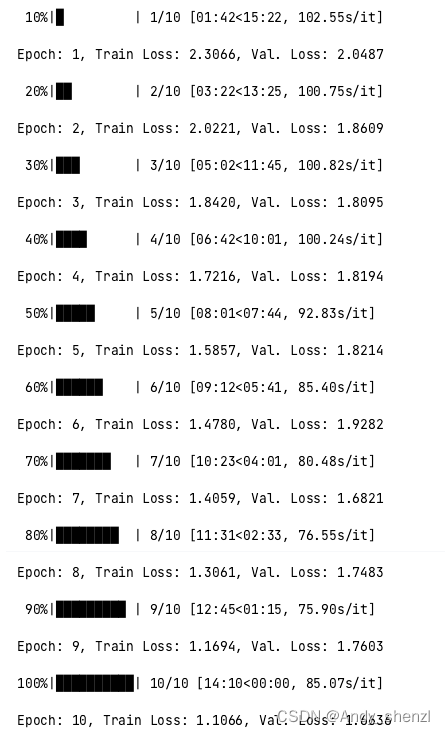

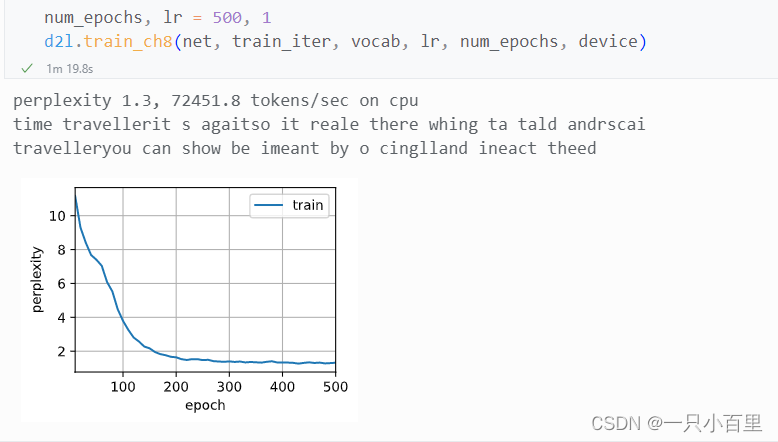

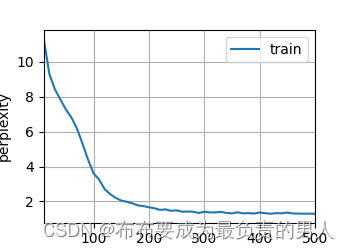

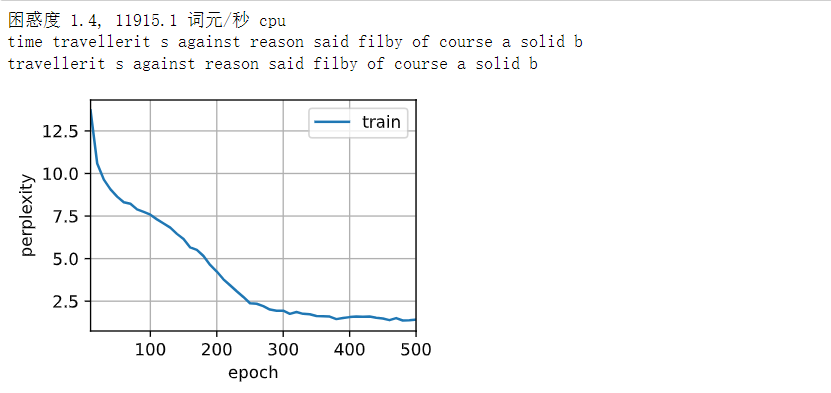

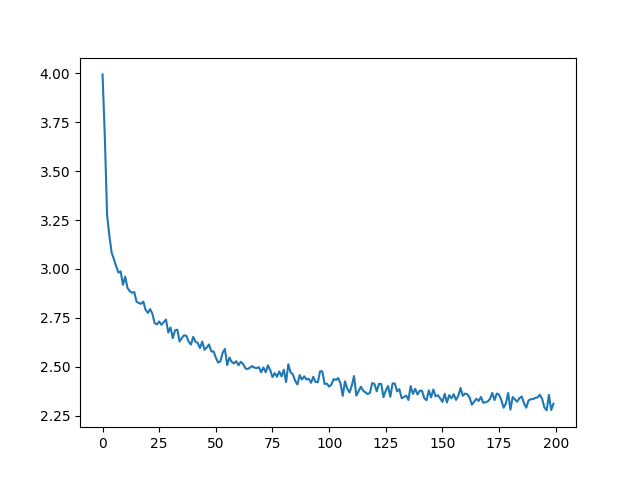

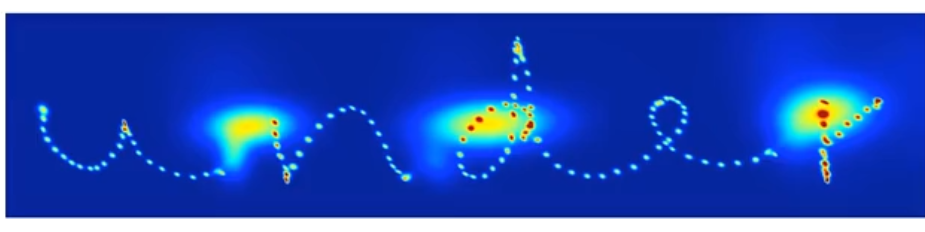

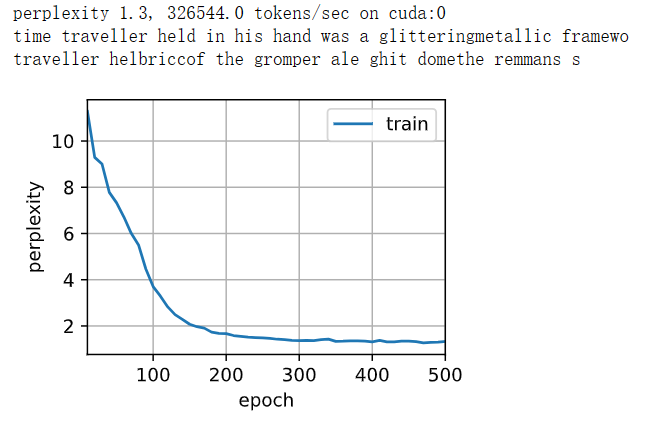

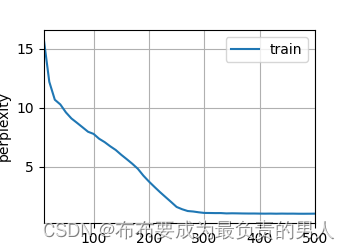

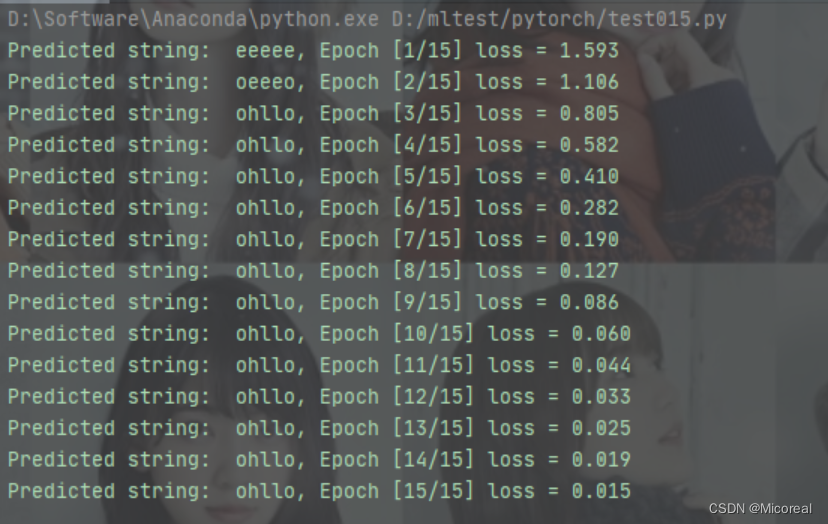

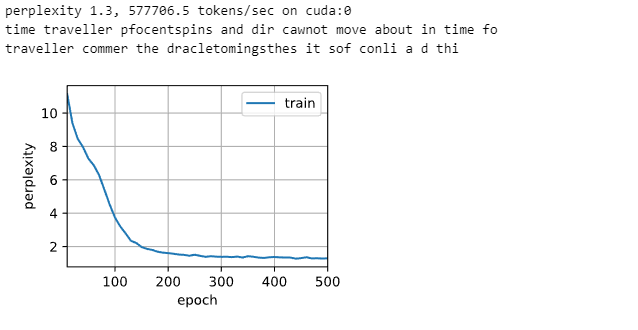

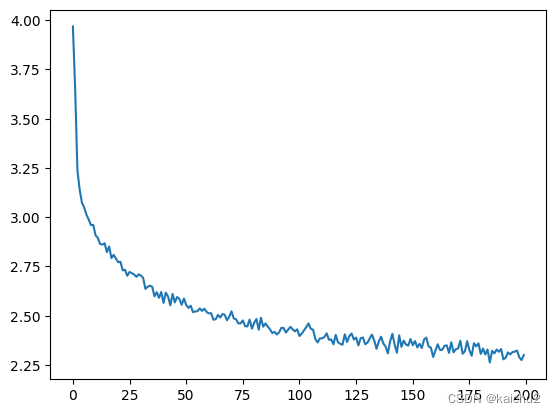

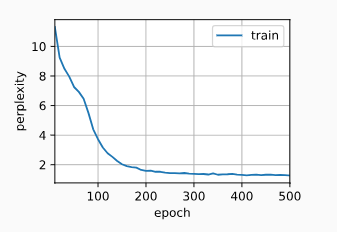

2024/4/11 15:40:20动手学深度学习——循环神经网络的从零开始实现(原理解释+代码详解)

文章目录 循环神经网络的从零开始实现1. 独热编码2. 初始化模型参数3. 循环神经网络模型4. 预测5. 梯度裁剪6. 训练 循环神经网络的从零开始实现

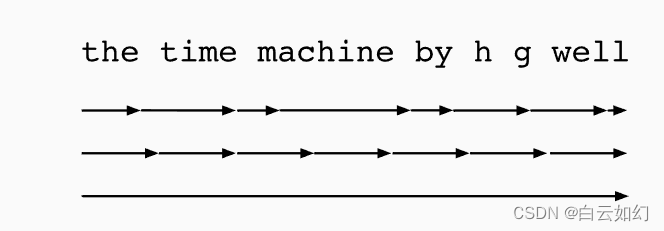

从头开始基于循环神经网络实现字符级语言模型。

# 读取数据集

%matplotlib inline

import math

import torchfrom torch import …

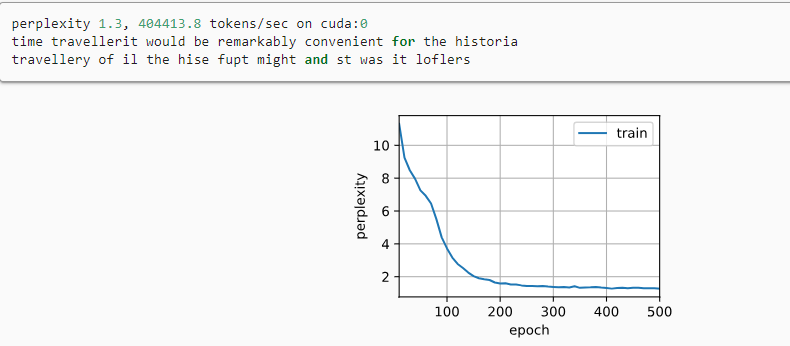

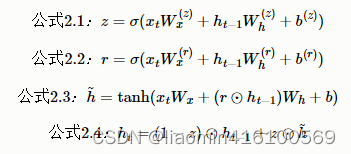

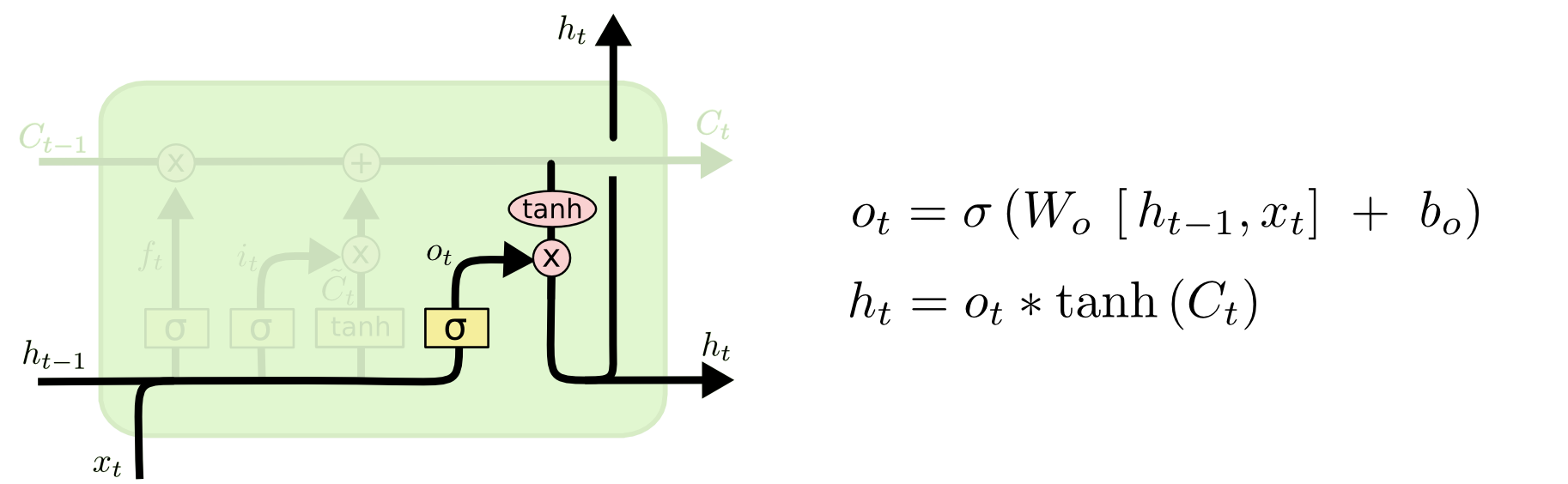

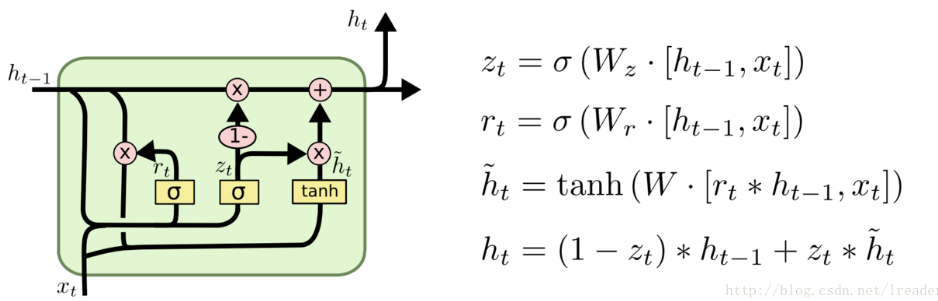

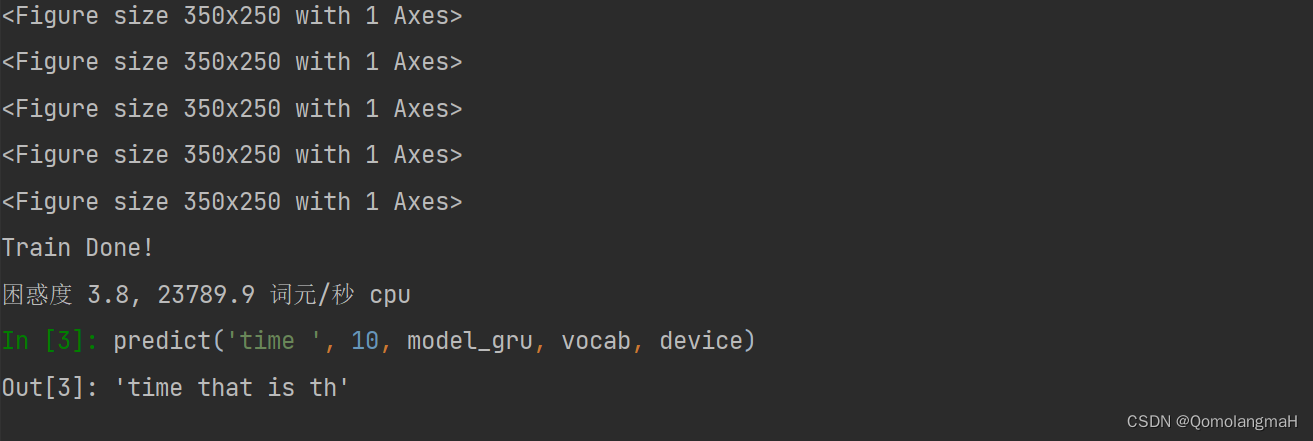

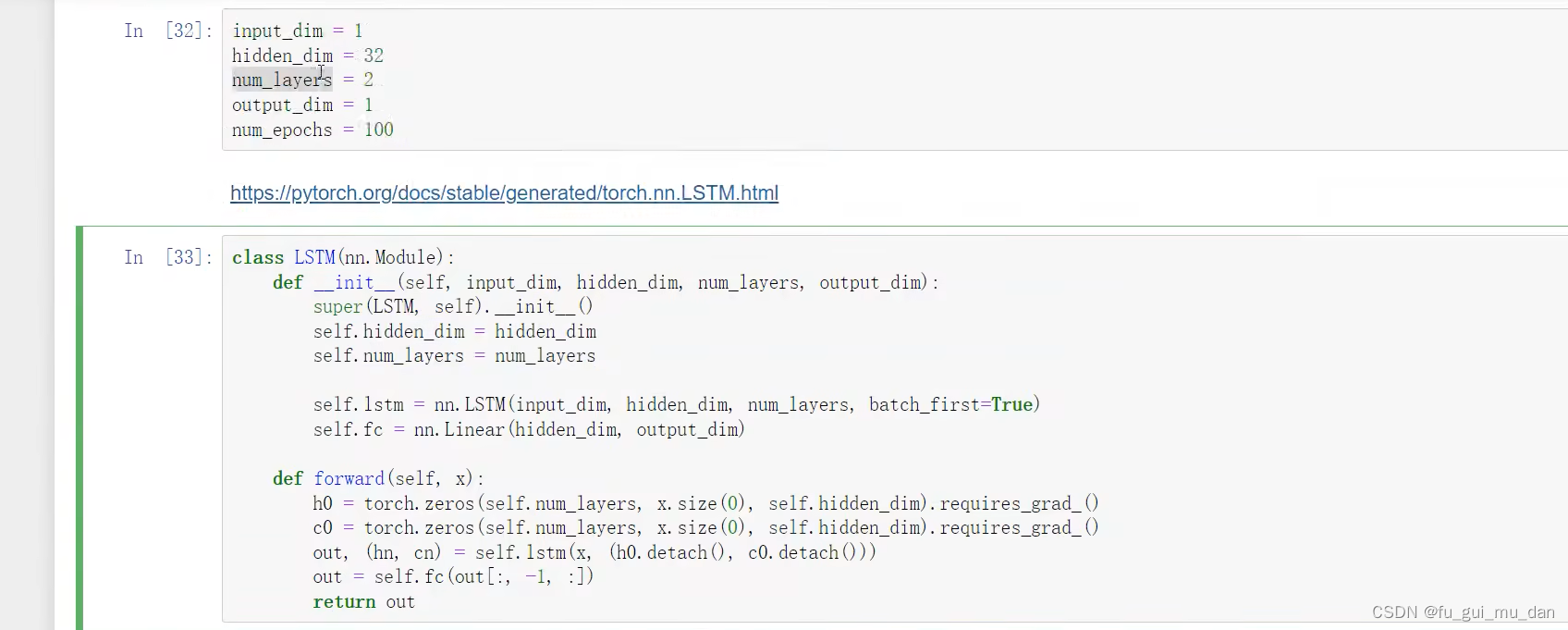

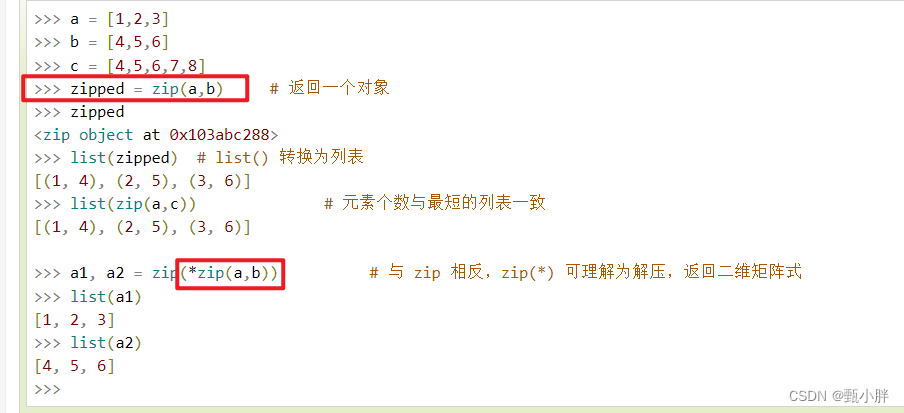

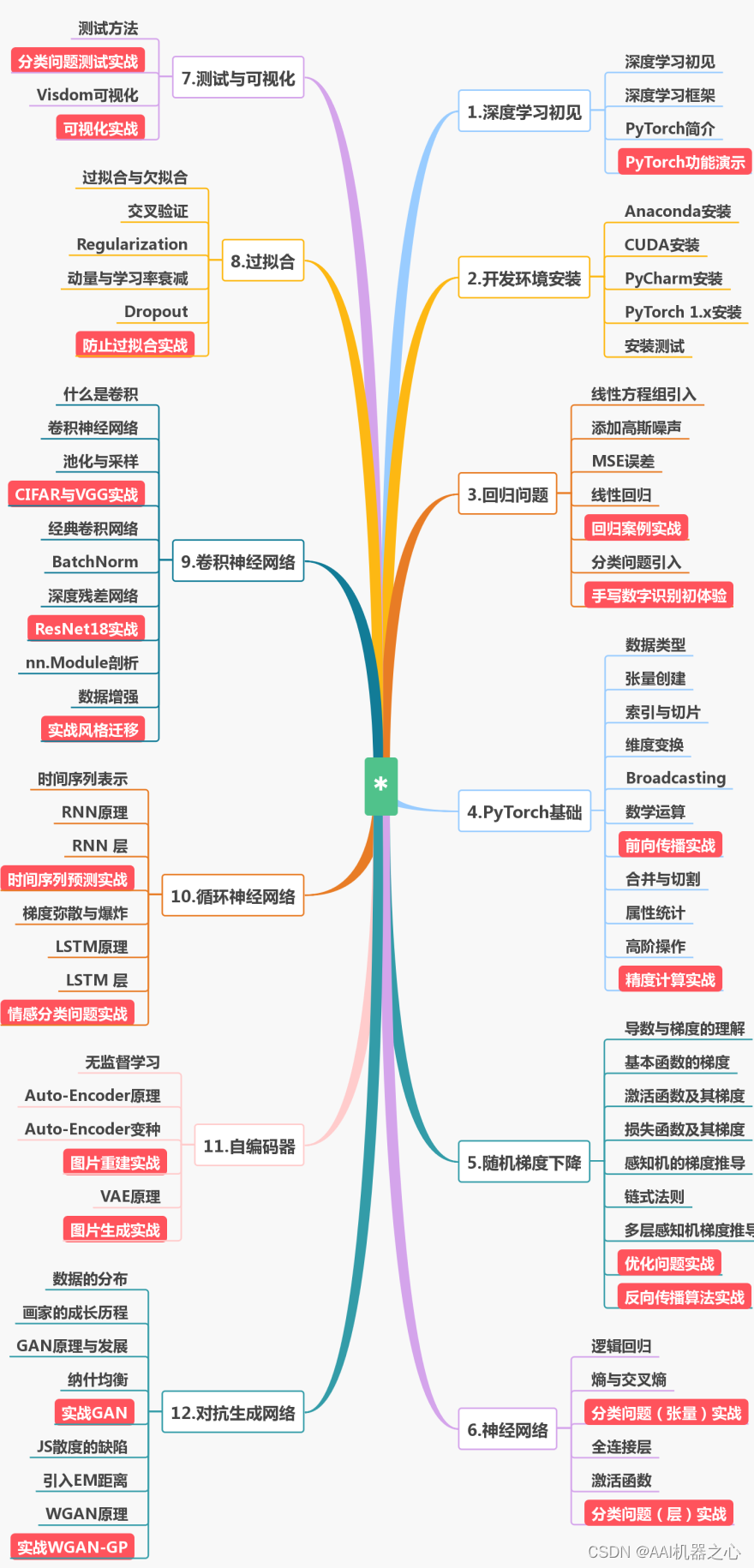

Python深度学习026:基于Pytorch的典型循环神经网络模型RNN、LSTM、GRU的公式及简洁案例实现(官方)

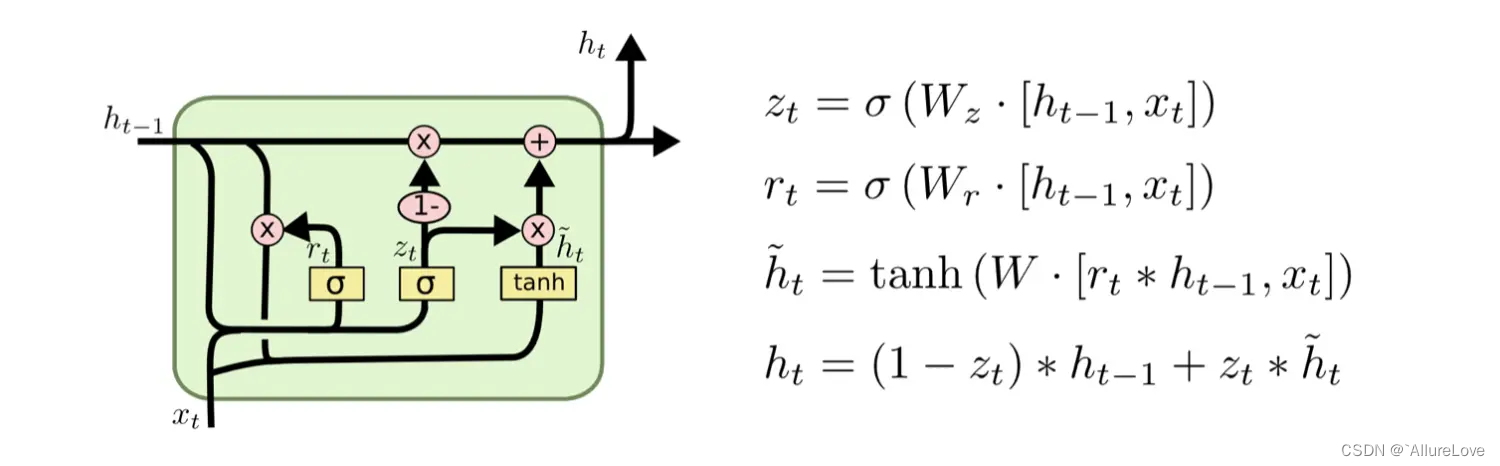

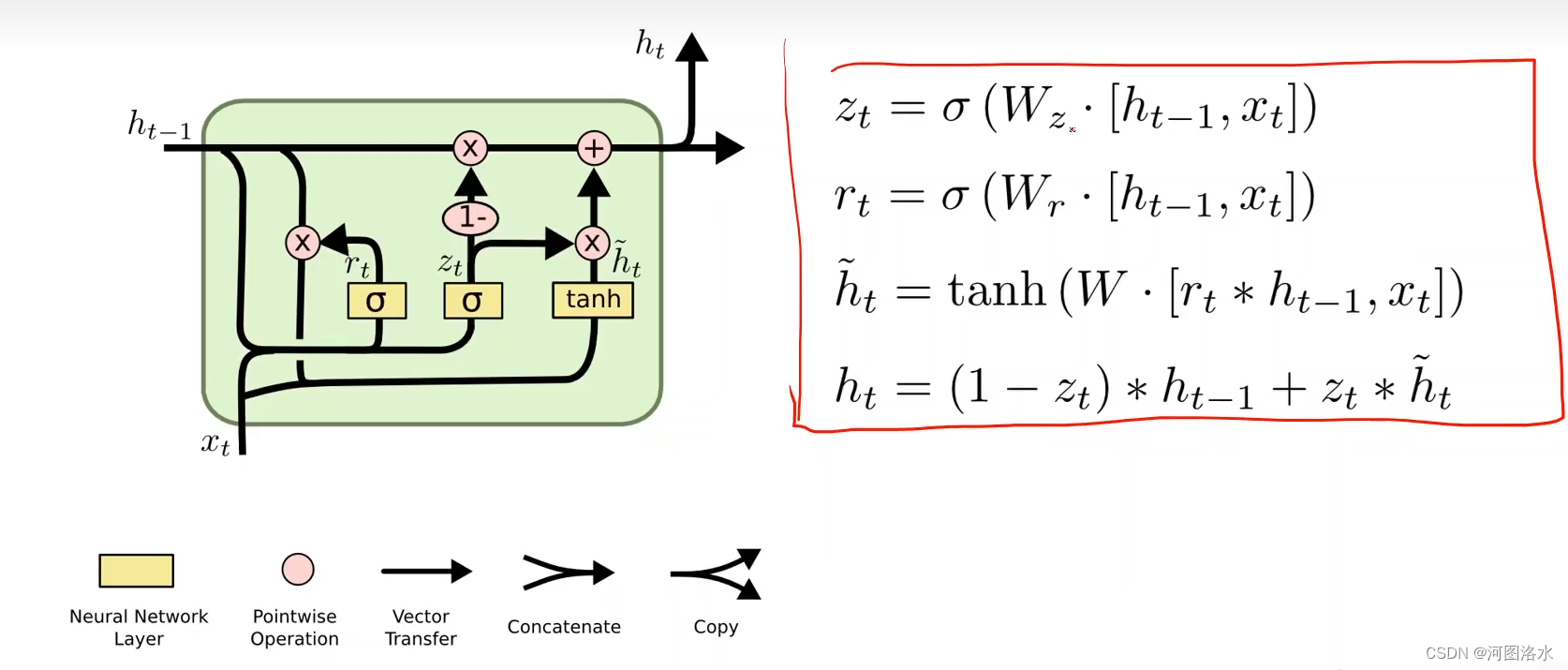

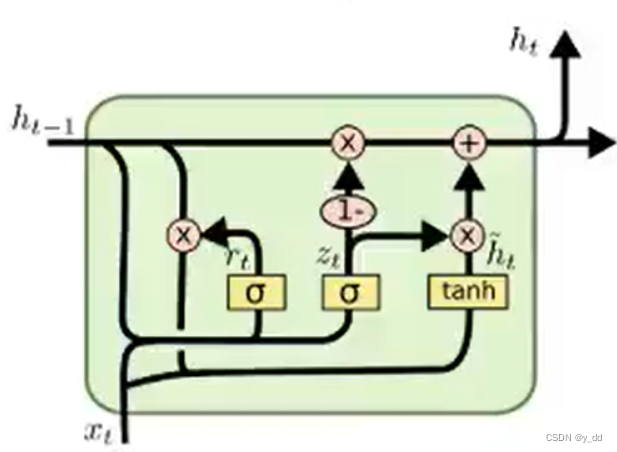

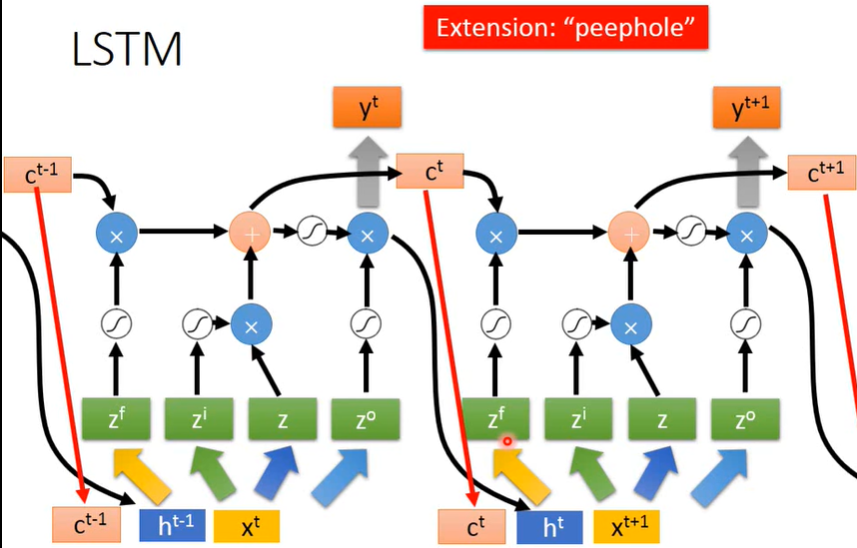

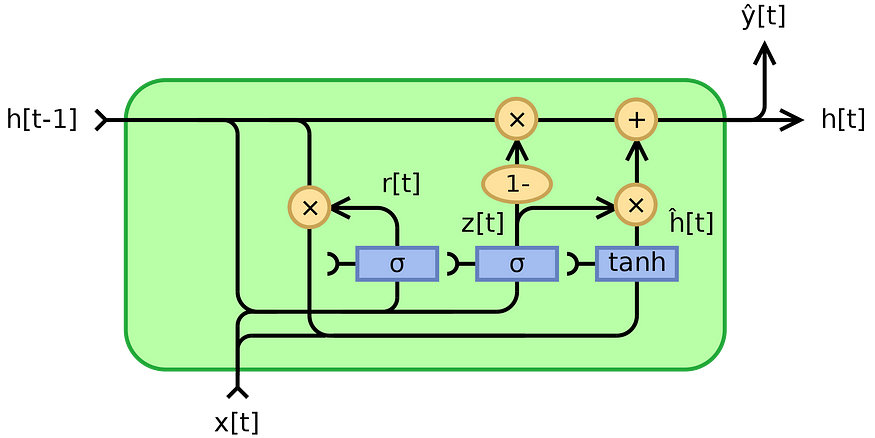

文章目录 1. 简介2. 参数的理解2.1. 层数的概念2.2. 官方案例中的三个参数的解释3. 官方公式及案例3.1. RNN3.2. LSTM3.3. GRU1. 简介

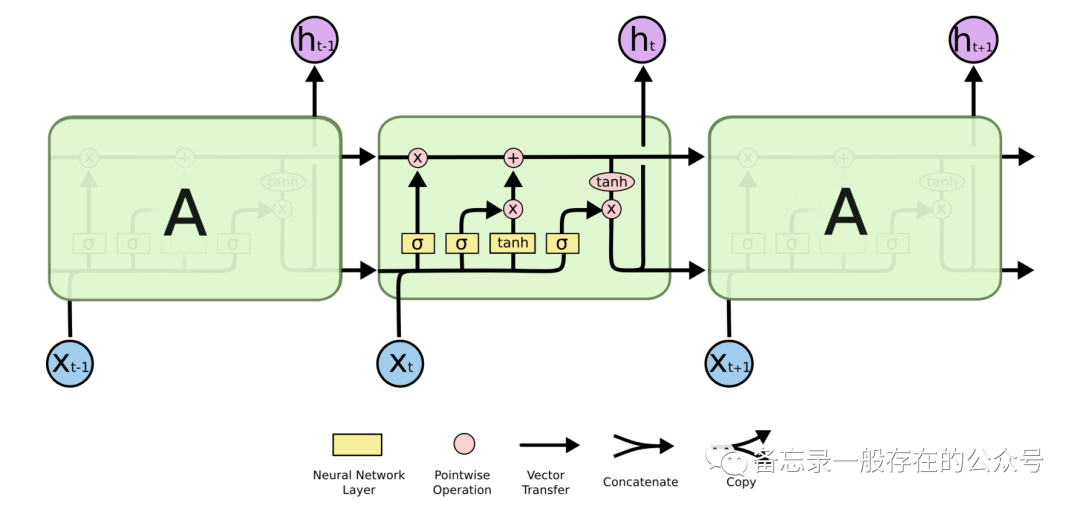

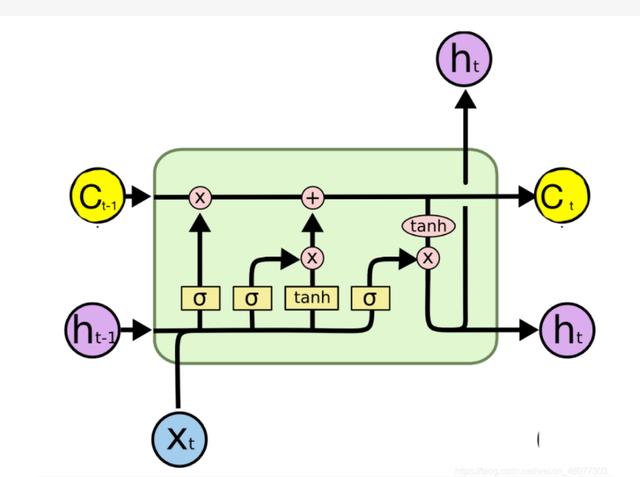

循环神经网络(也有翻译为递归神经网络)最典型的三种网络结构是: RNN(Recurrent Neural Network,循环神经网络)LSTM(Long Short-Term …

PyTorch深度学习(六)【循环神经网络-基础】

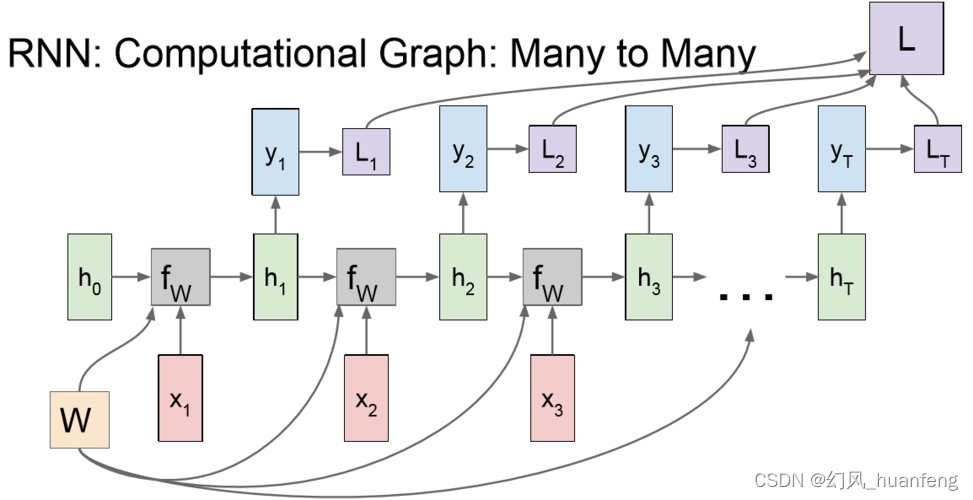

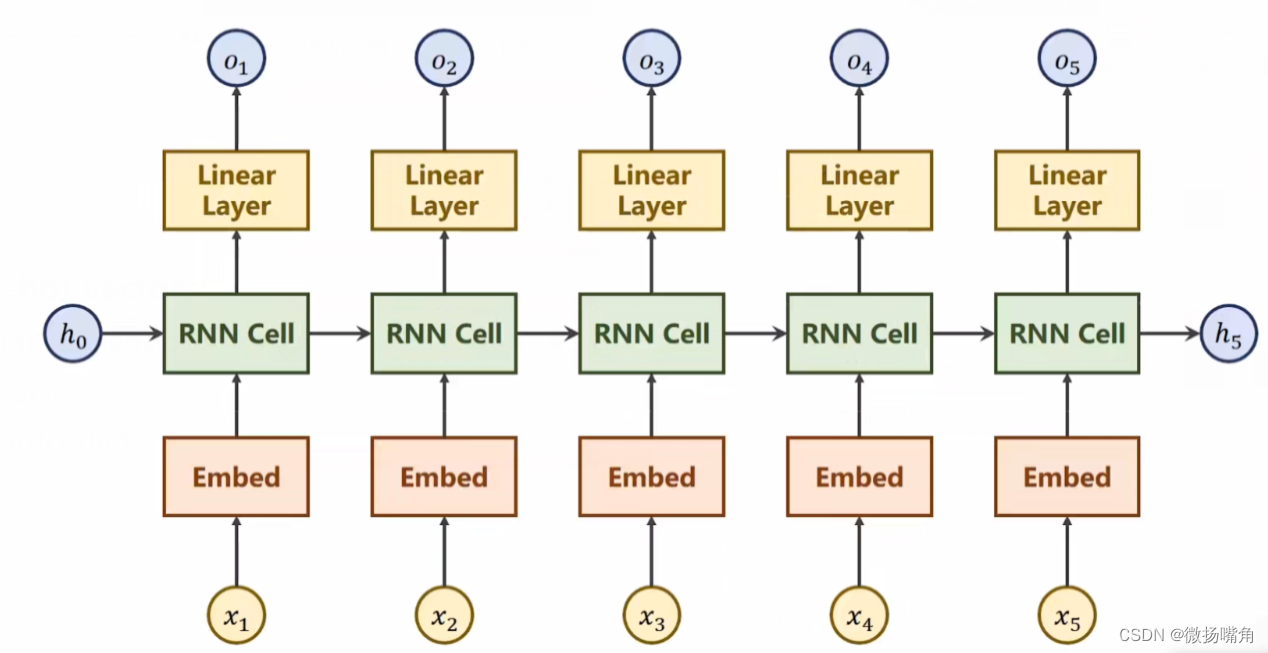

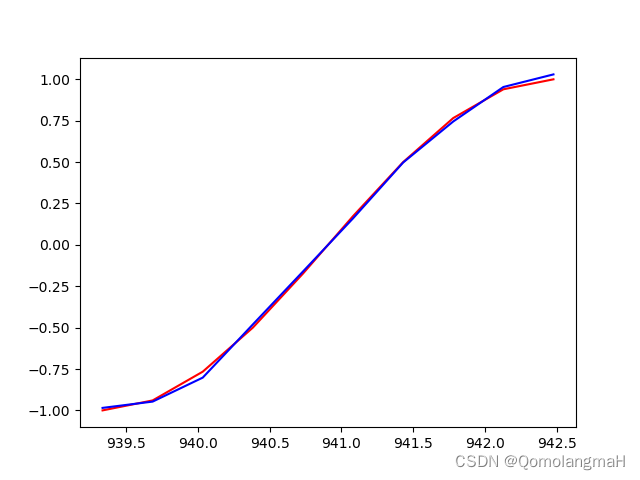

RNN Cell: h0和x1生成h1,把h1作为输出送到下一次的RNN Cell里面。(h1linear(h0,x1)) RNN计算过程: 输入先做线性变换,循环神经网络常用的激活函数是tanh(1区间)。 构造RNN Cell: 代码…

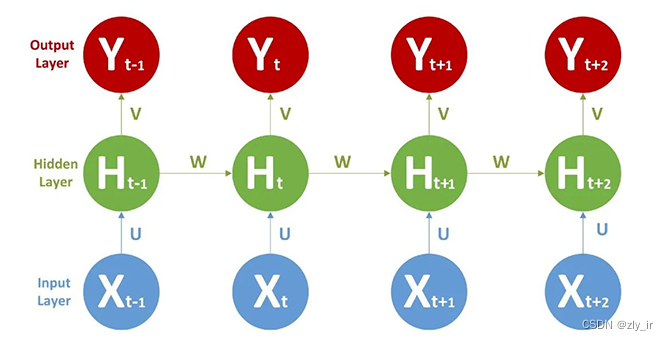

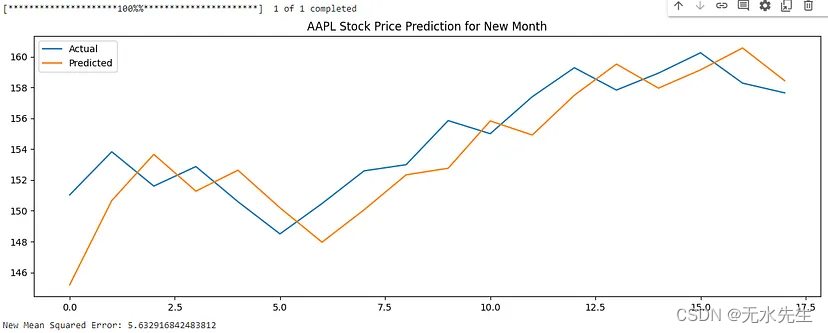

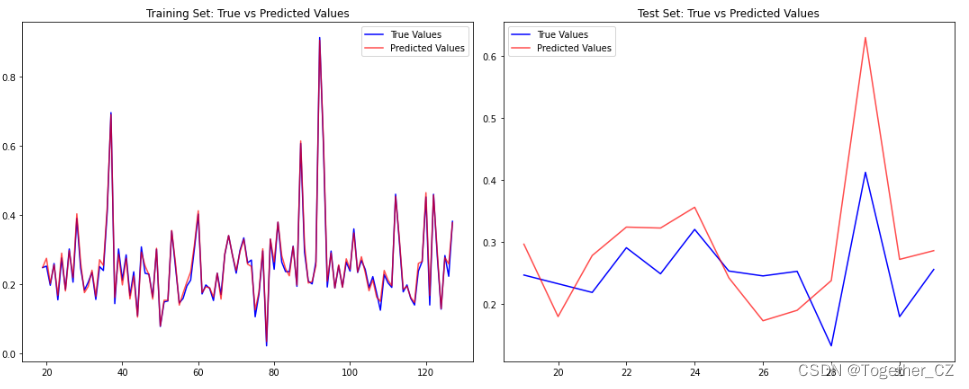

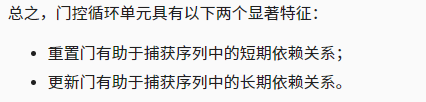

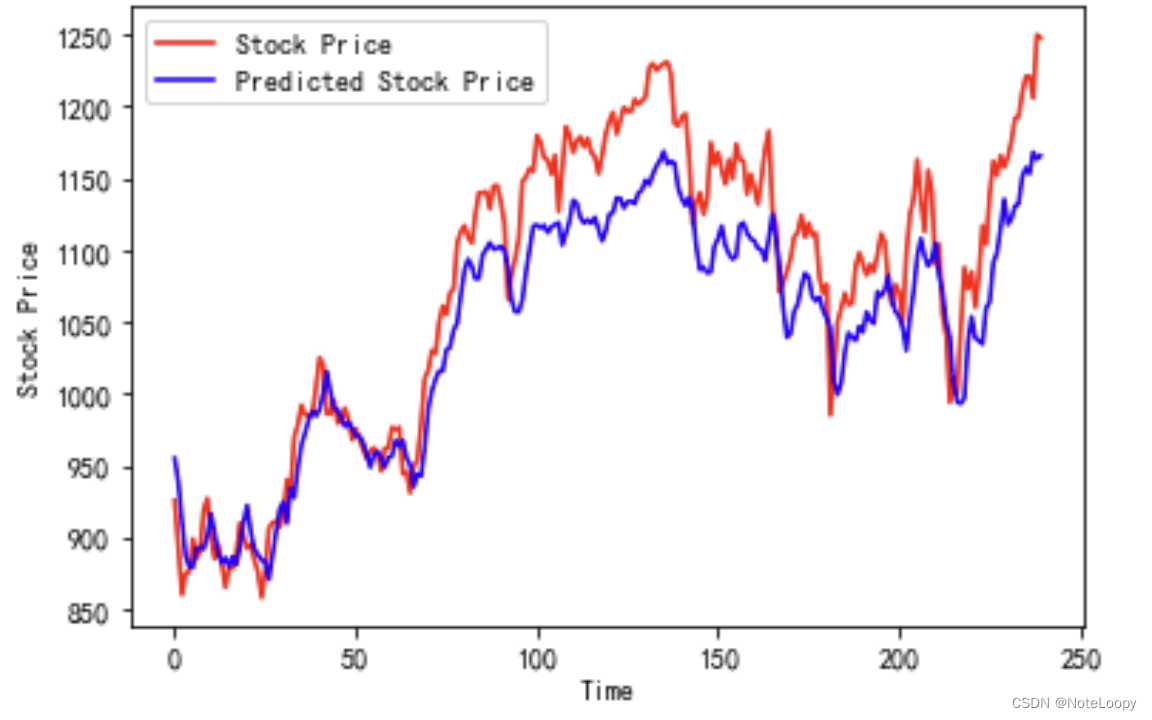

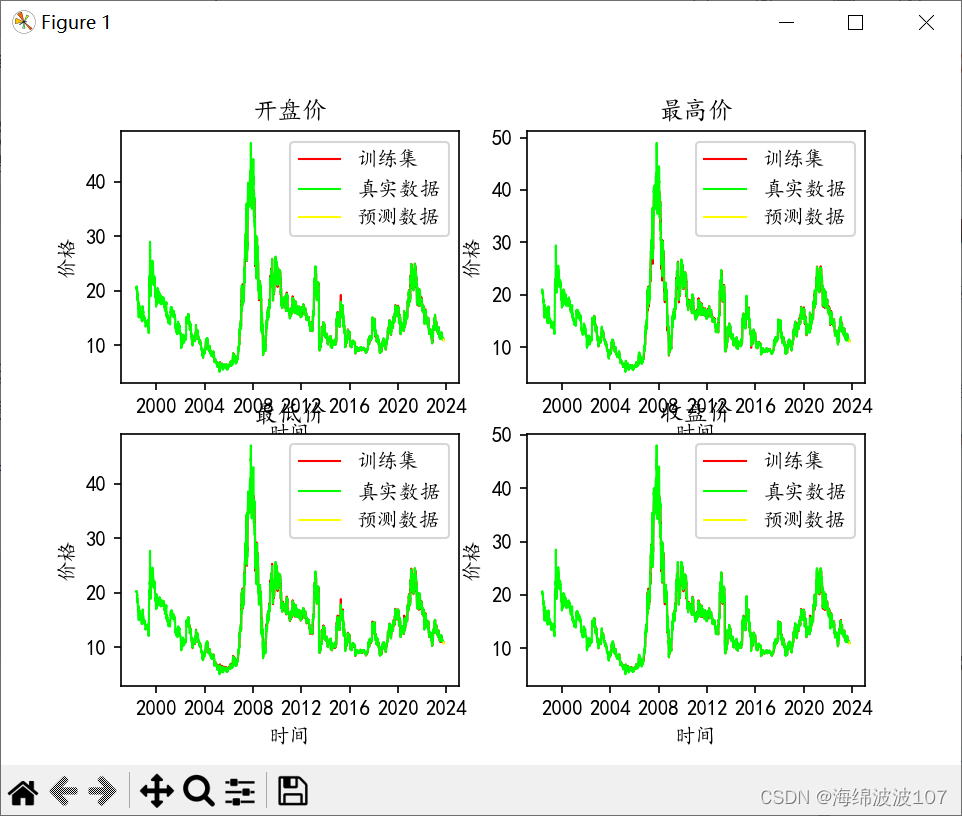

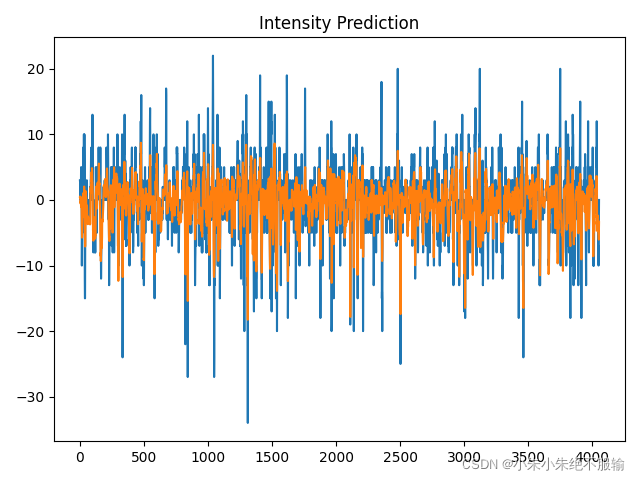

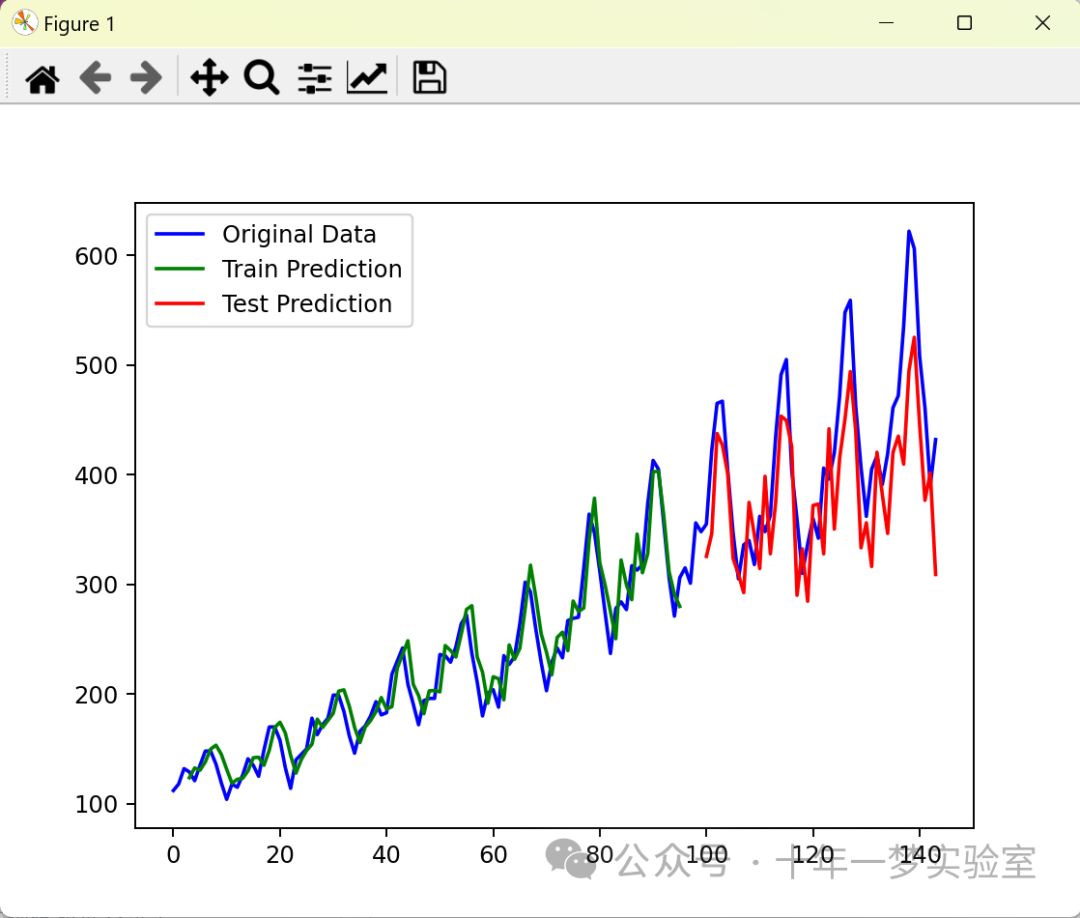

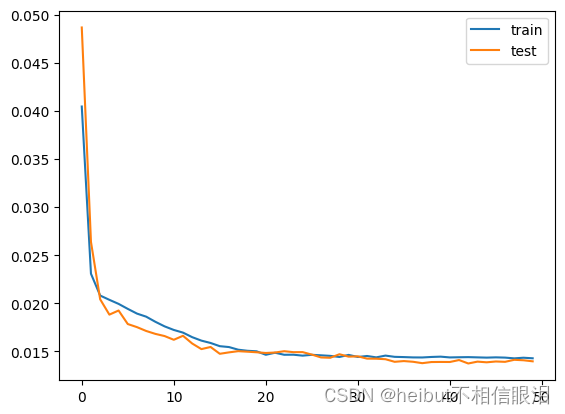

股票价格预测 | Python基于RNN股票预测实战

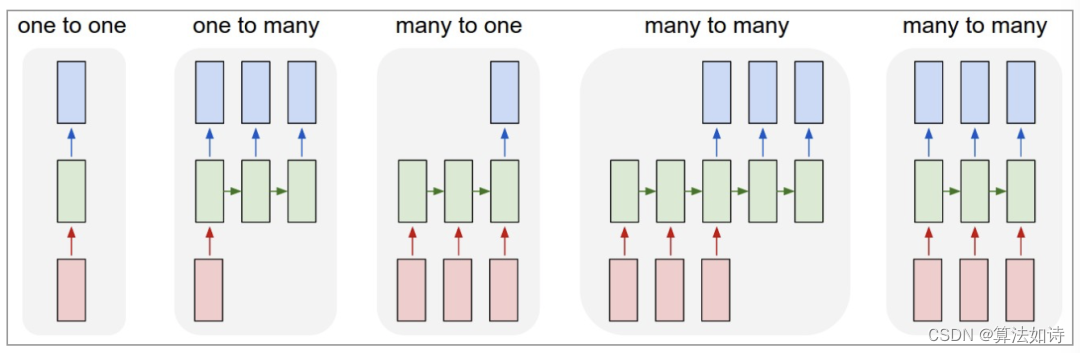

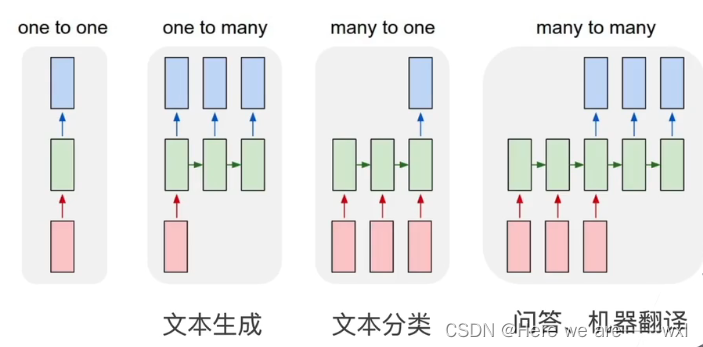

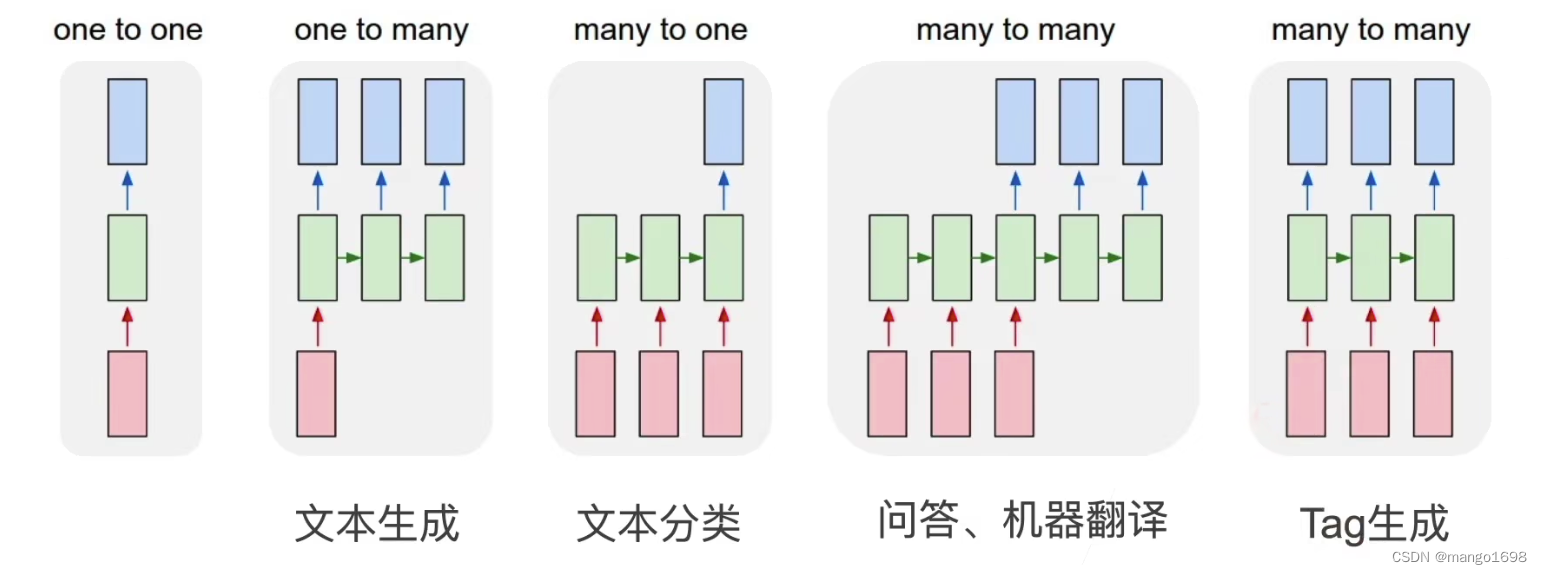

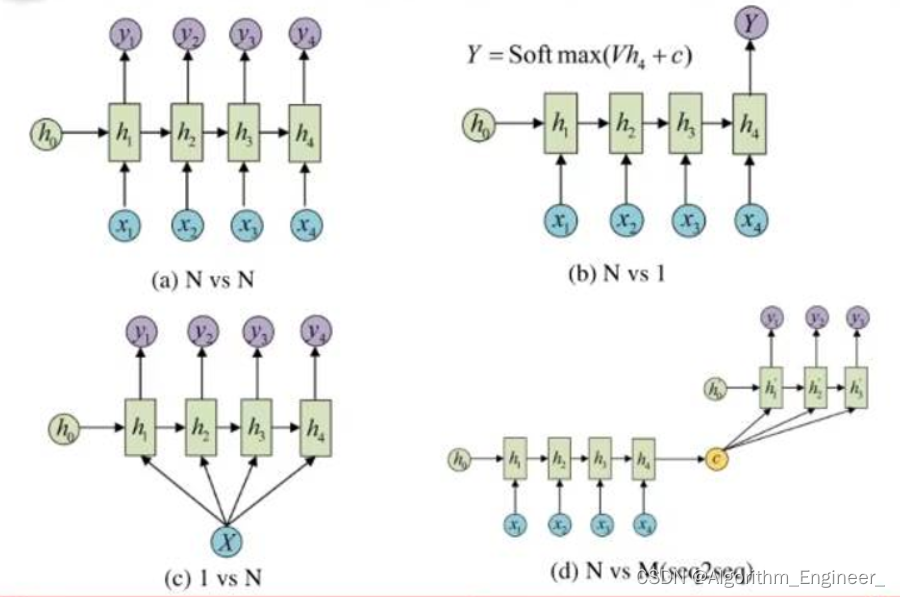

循环神经网络(RNN)是基于序列数据(如语言、语音、时间序列)的递归性质而设计的,是一种反馈类型的神经网络,其结构包含环和自重复,因此被称为“循环”。它专门用于处理序列数据,如逐字生成文本或预测时间序列数据(例如股票价格)。 (1)one to one:其实和全连接神经网络…

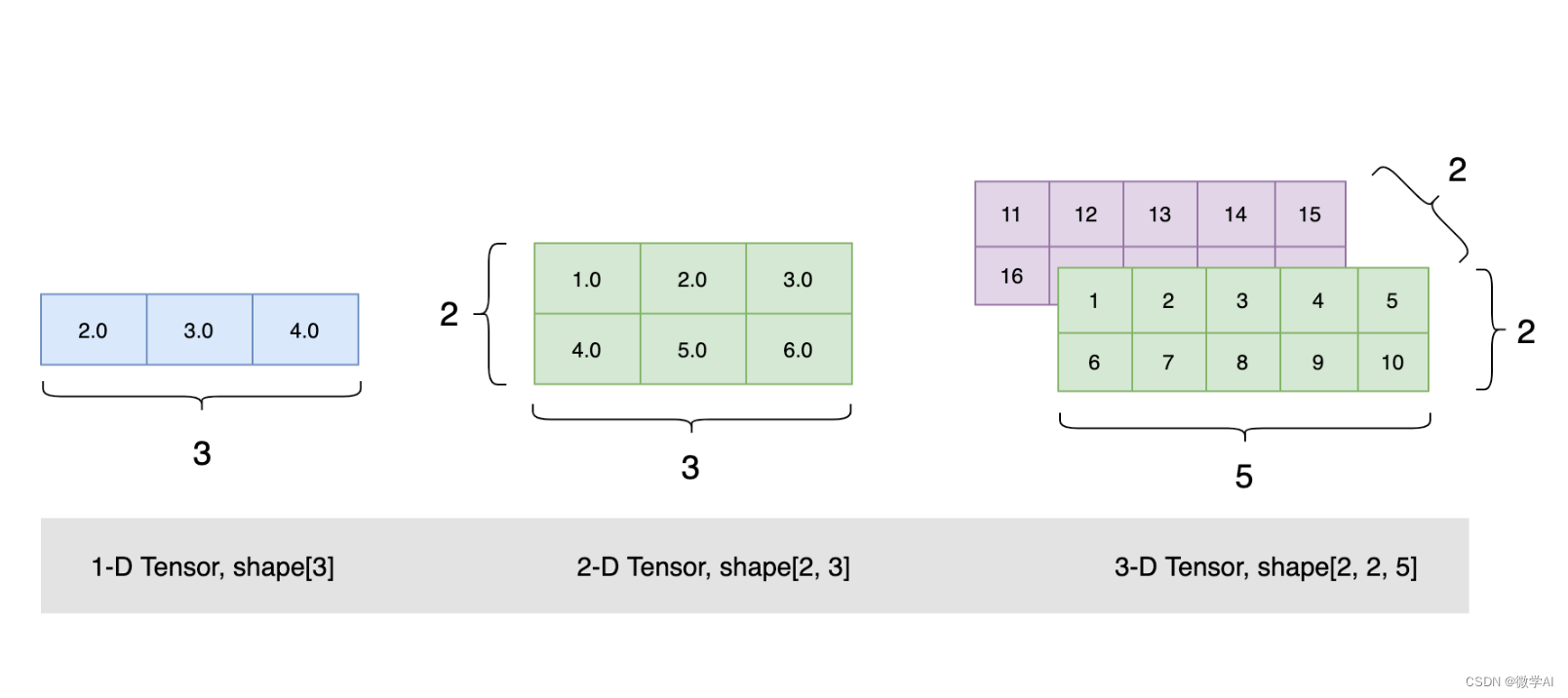

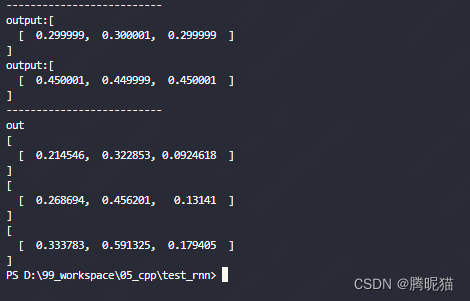

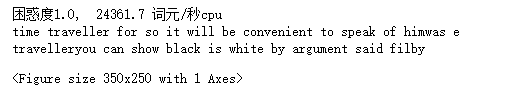

rnn, lstm, gru三种神经网络数据格式详解

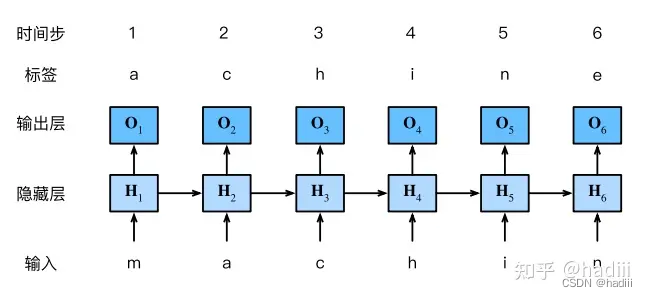

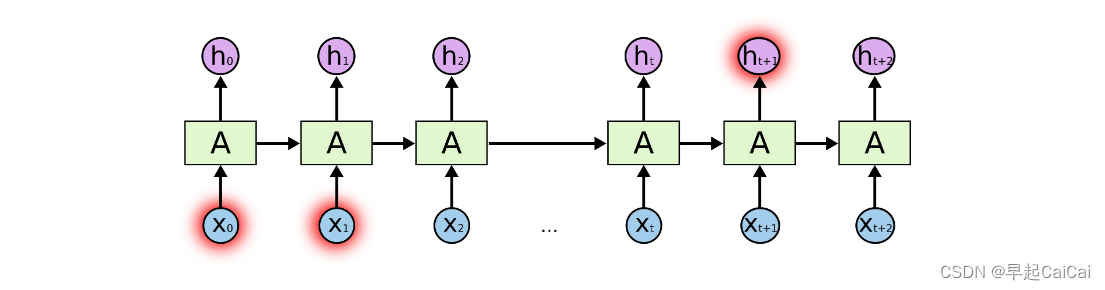

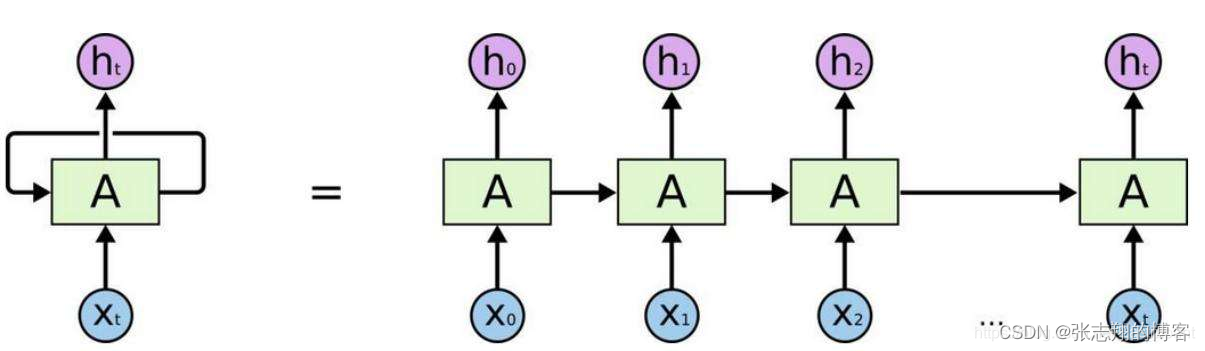

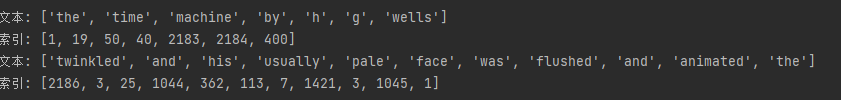

先上一张rnn图来直观理解一下。 RNN,LSTM,GRU三种神经网络的输入数据格式都是**[seq_len, batch_size, input_dim]**

seq_len: 输入的每句话的长度,图中表示为n_stepsbatch_size: 输入的句子数量,图中表示为batchinput_dim: 输入的每个字的向量维度表示…

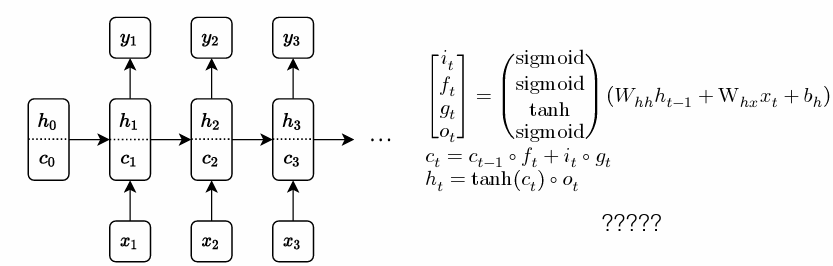

RNN->LSTM->BiLSTM神经网络结构

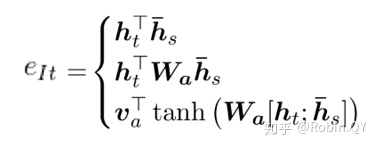

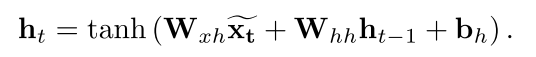

最近在学习《自然语言处理 基于预训练模型的方法》,打打公式吧。

RNN(Recurrent Neural Network) httanh(WxhxtbxhWhhht−1bhh)h_t tanh(W^{xh}x_{t}b^{xh}W^{hh}h_{t-1}b^{hh})httanh(WxhxtbxhWhhht−1bhh) ysoftmax(Whyhnbhy)ysoft…

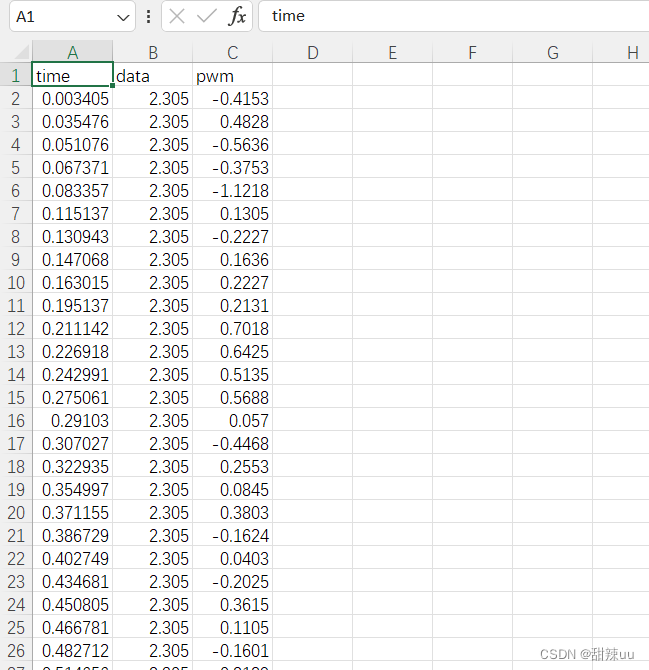

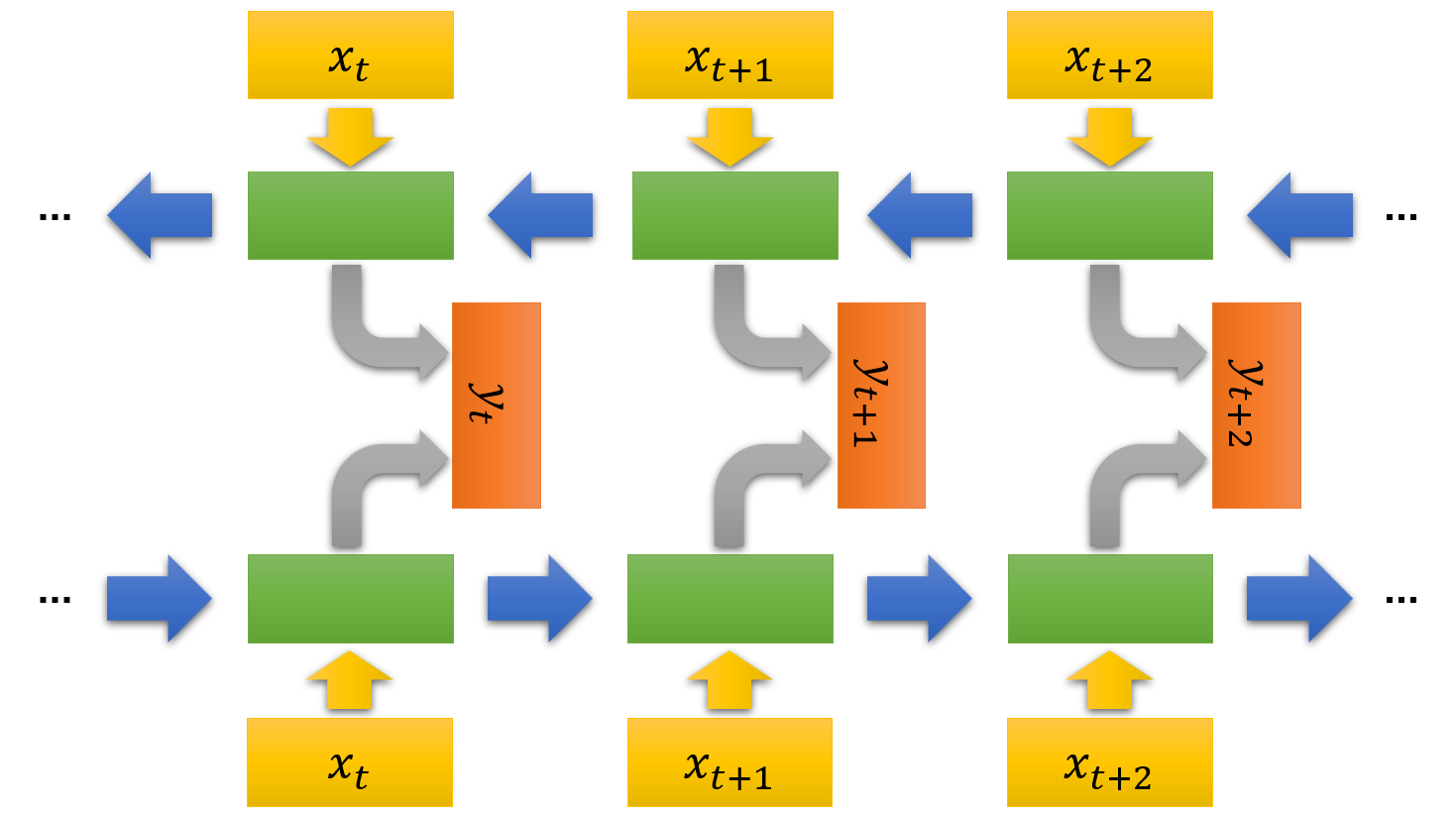

时间序列预测—双向LSTM(Bi-LSTM)

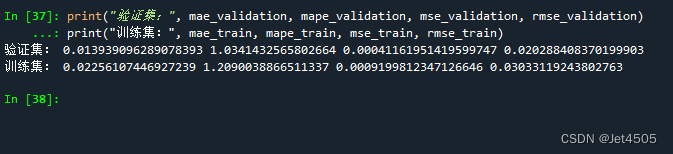

本文展示了使用双向LSTM(Bi-LSTM)进行时间序列预测的全过程,包含详细的注释。整个过程主要包括:数据导入、数据清洗、结构转化、建立Bi-LSTM模型、训练模型(包括动态调整学习率和earlystopping的设置)、预测、结果展示、误差评估等…

第三十八周周报:文献阅读 +BILSTM+GRU+Seq2seq

目录

摘要

Abstract

文献阅读:耦合时间和非时间序列模型模拟城市洪涝区洪水深度

现有问题

提出方法

创新点

XGBoost和LSTM耦合模型

XGBoost算法

编辑

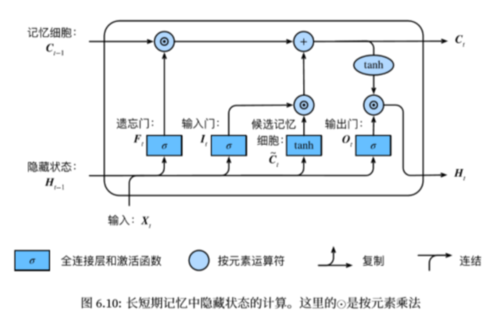

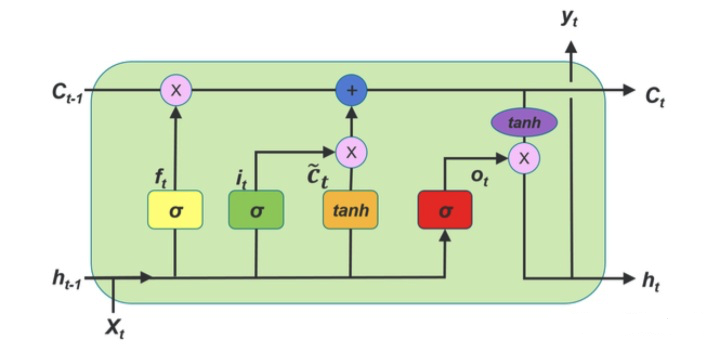

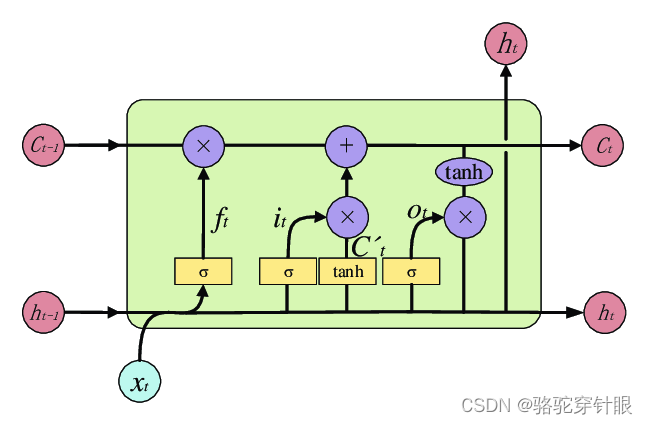

LSTM(长短期记忆网络)

耦合模型

研究实验

数据集

评估指标

研究目的

洪…

动手学深度学习——循环神经网络的简洁实现(代码详解)

文章目录 循环神经网络的简洁实现1. 定义模型2. 训练与预测 循环神经网络的简洁实现

# 使用深度学习框架的高级API提供的函数更有效地实现相同的语言模型

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2lbatch_size, …

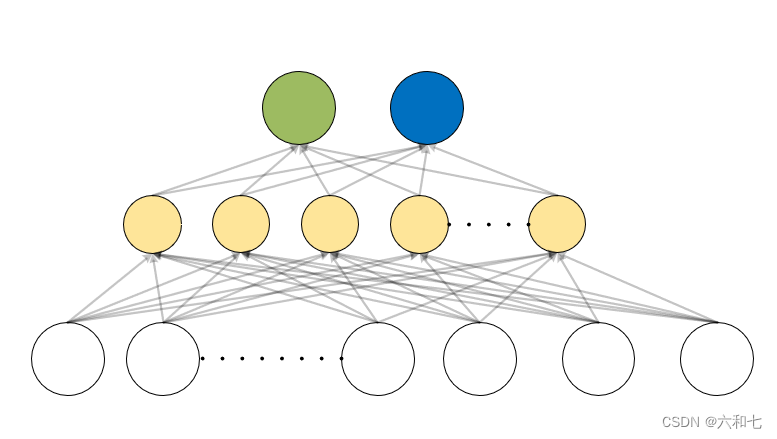

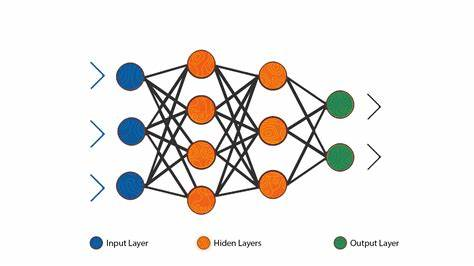

每日一篇机器学习公众号D1-独家 | NLP的深度学习:ANN,RNN和LSTM详解

链接:https://mp.weixin.qq.com/s/uS-KLIQ23DXHctJalzcuSA

1、在这篇文章中,我们将学习人工神经网络,深度学习,递归神经网络和长短期记忆网络。

感知器Perception

1、一个神经元就是将输入***加权求和***

2、 当以这种方式构…

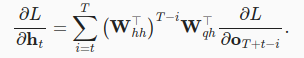

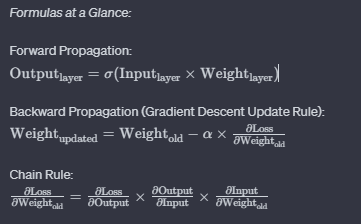

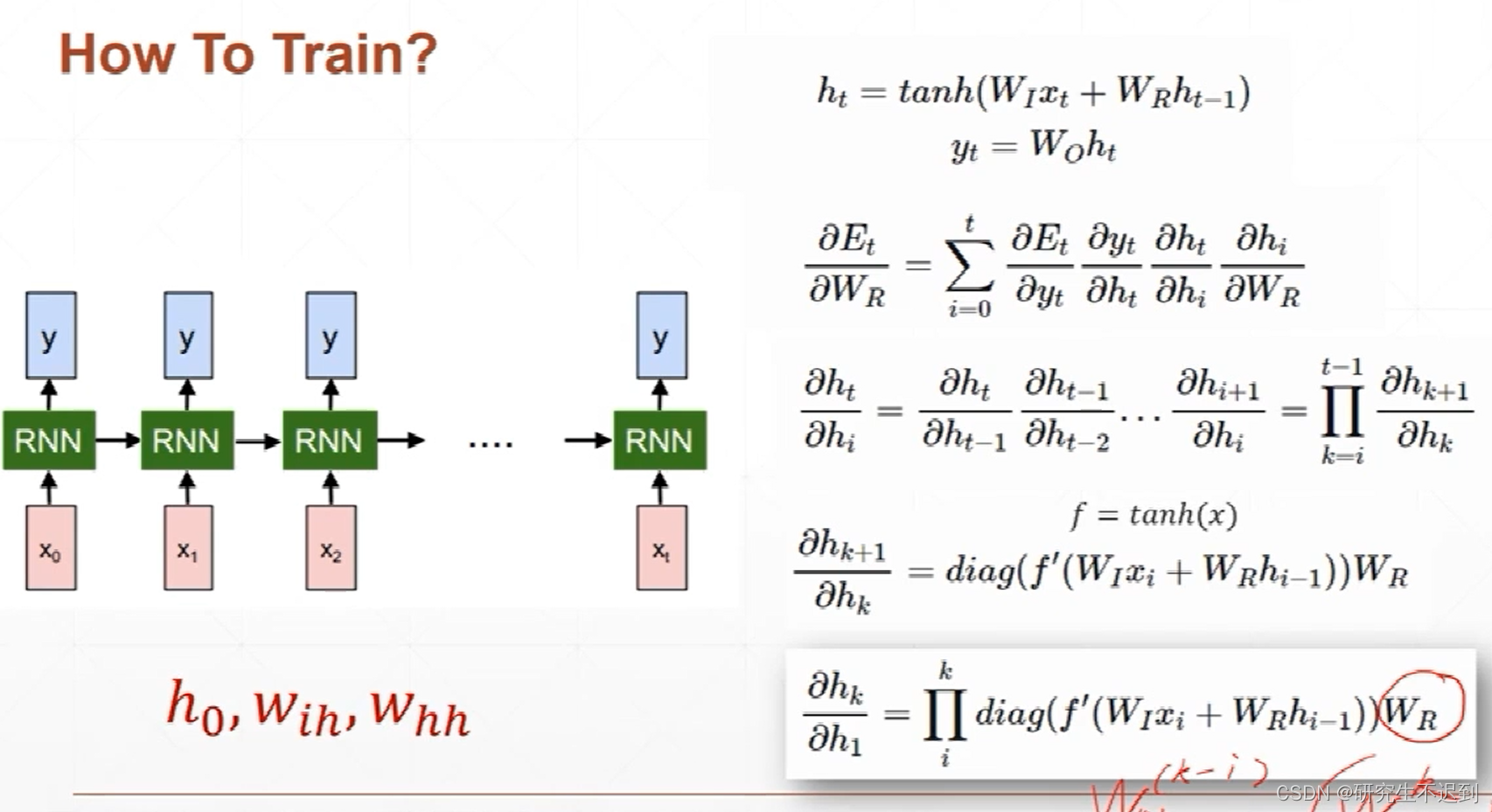

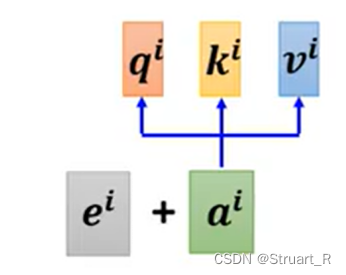

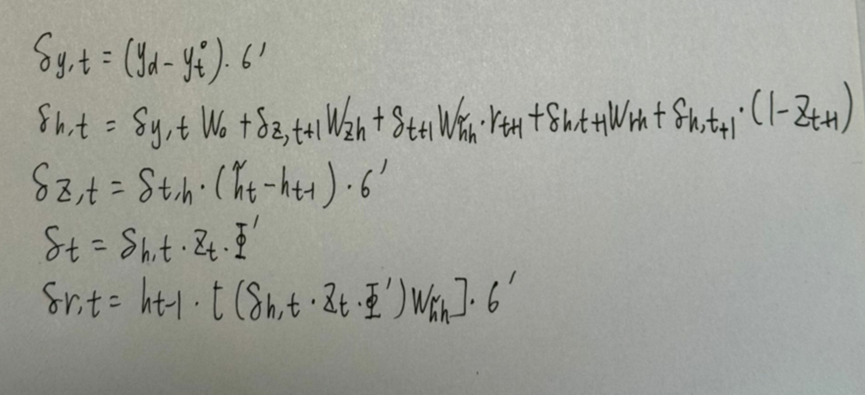

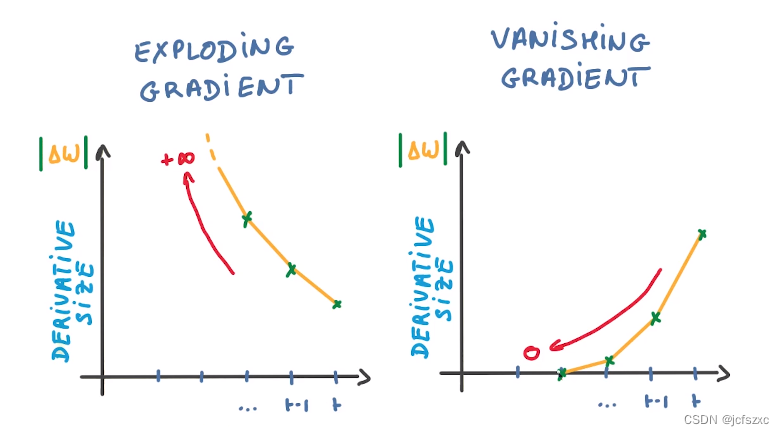

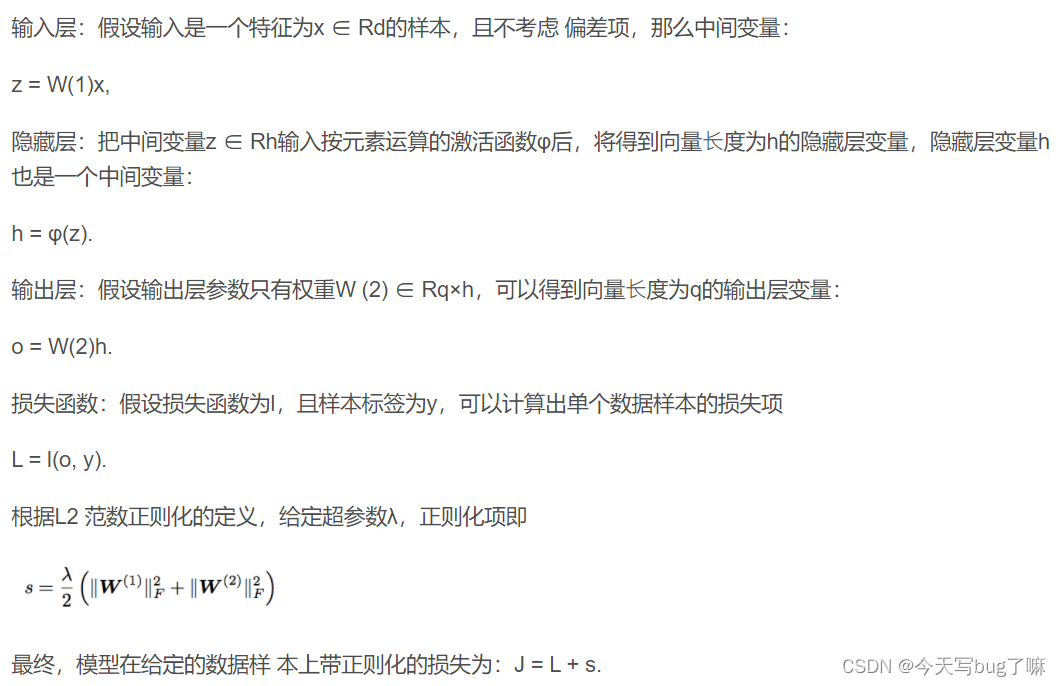

人工智能-循环神经网络通过时间反向传播

到目前为止,我们已经反复提到像梯度爆炸或梯度消失, 以及需要对循环神经网络分离梯度。 例如,我们在序列上调用了detach函数。 为了能够快速构建模型并了解其工作原理, 上面所说的这些概念都没有得到充分的解释。 本节将更深入地探…

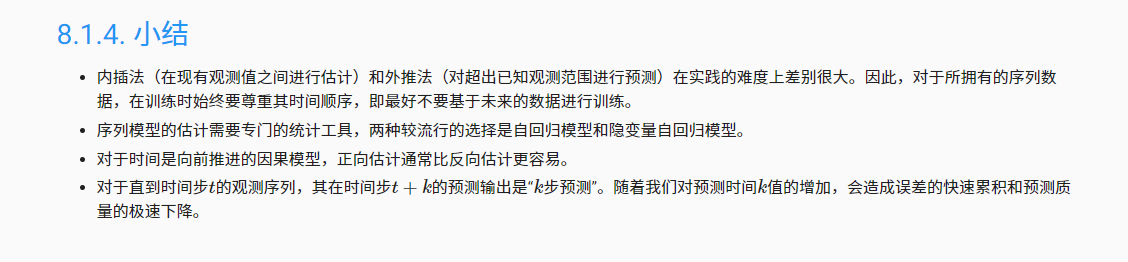

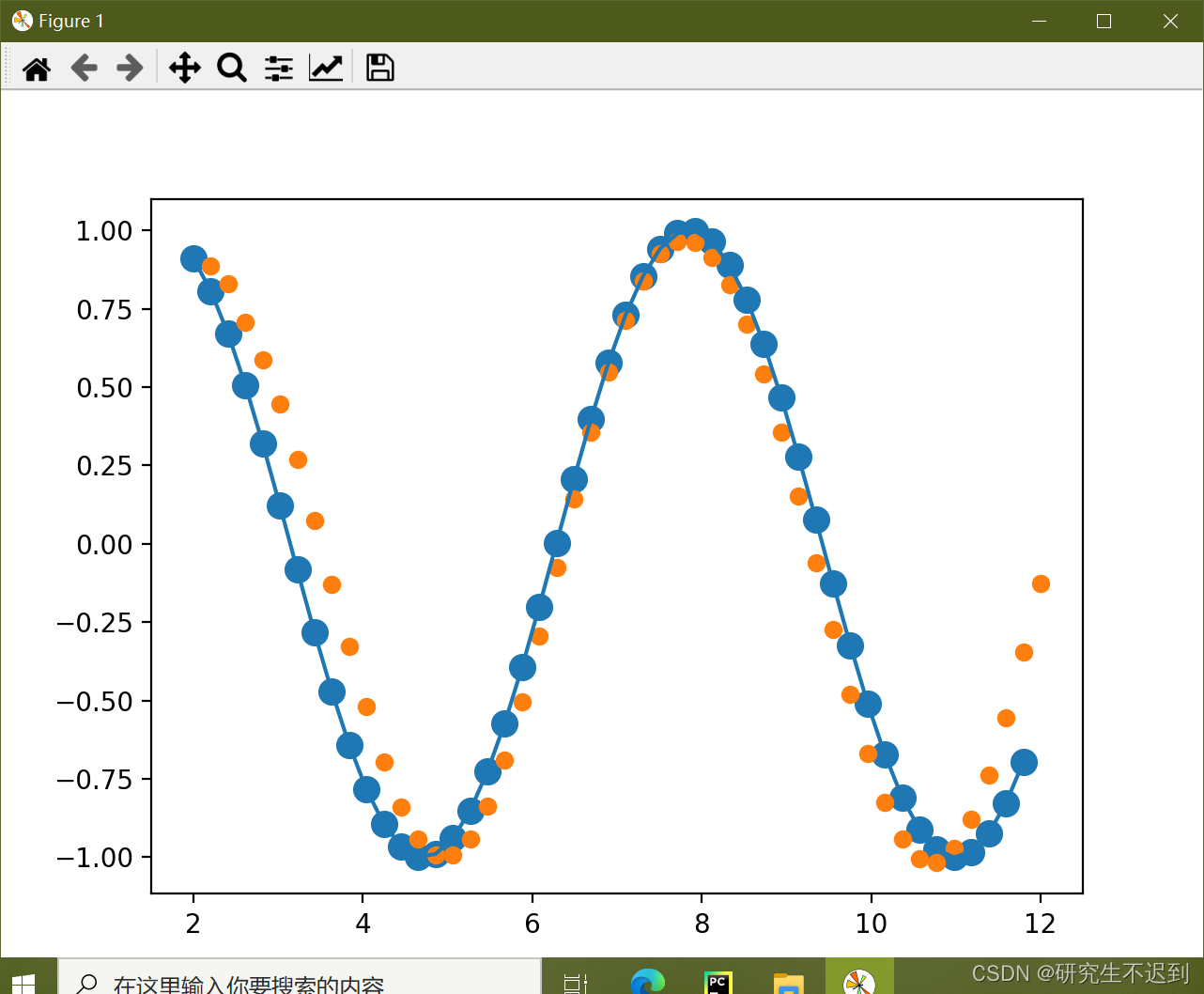

RNN+LSTM正弦sin信号预测 完整代码数据视频教程

视频讲解:RNN+LSTM正弦sin信号预测_哔哩哔哩_bilibili

效果演示: 数据展示: 完整代码:

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

import matplotlib.pyplot as plt

import pandas as pd

from sklearn.preprocessing import…

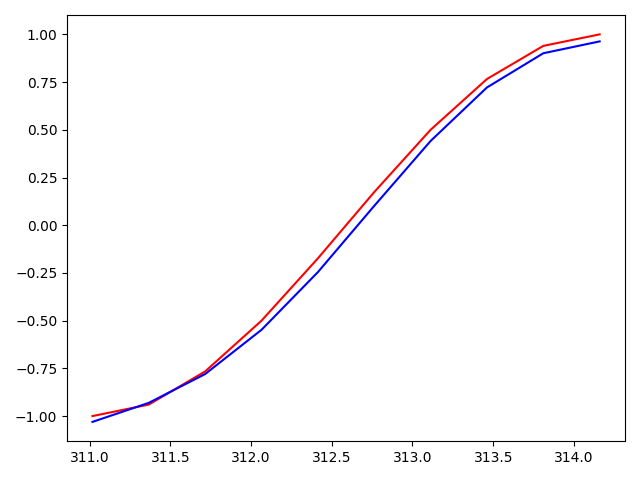

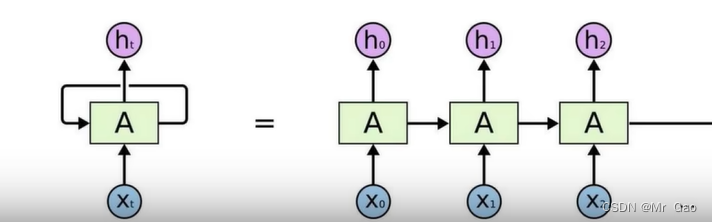

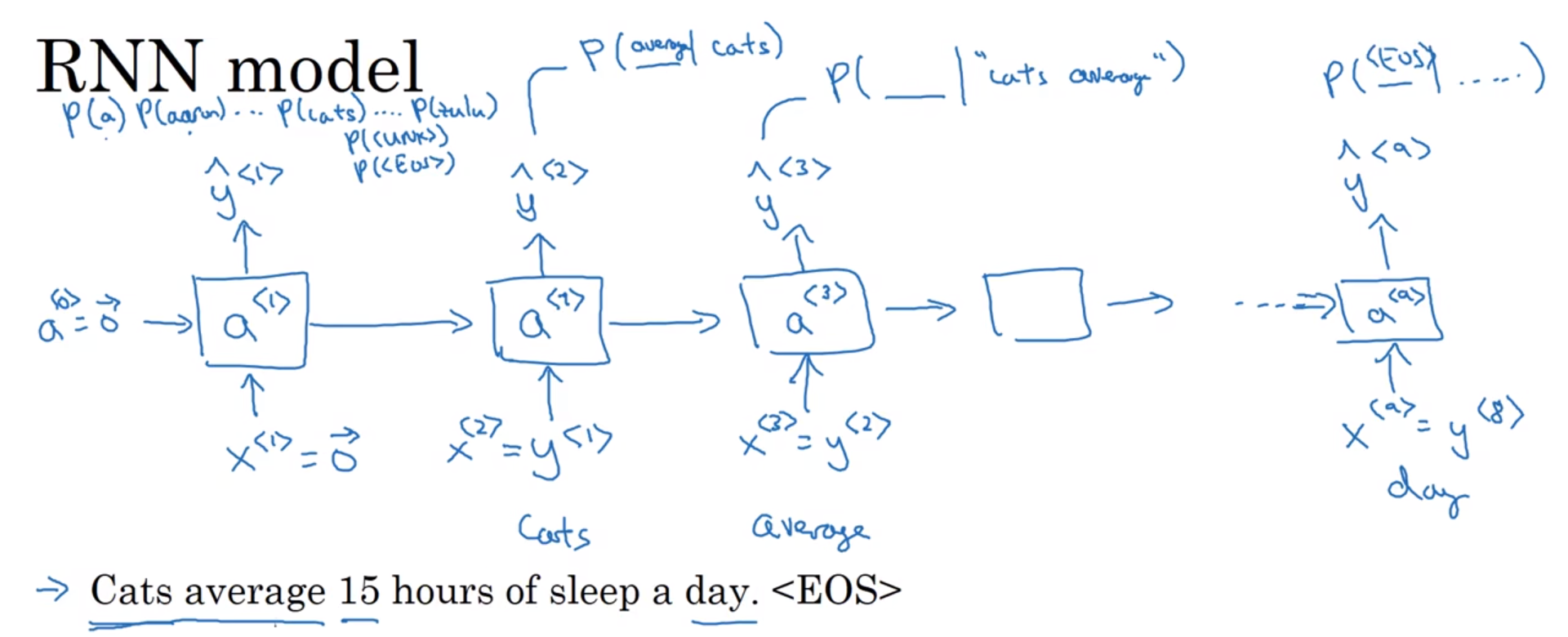

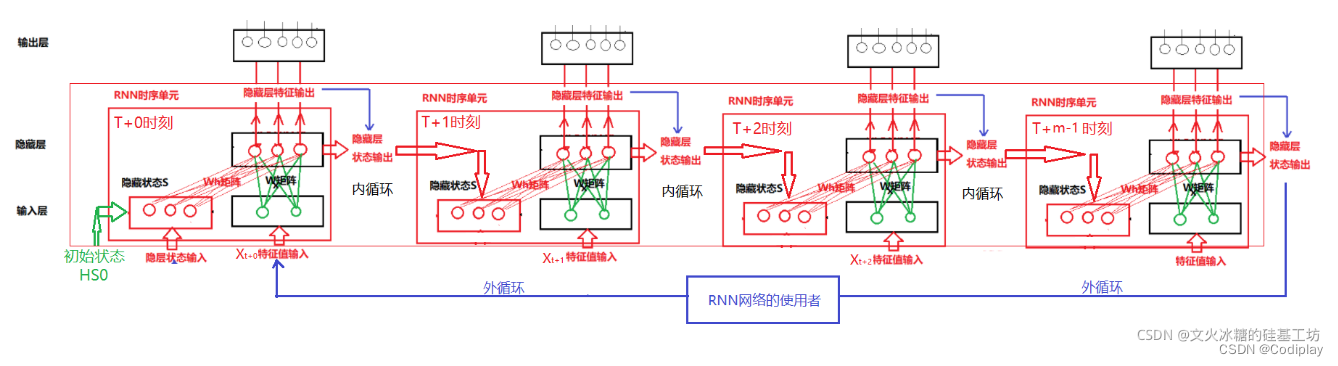

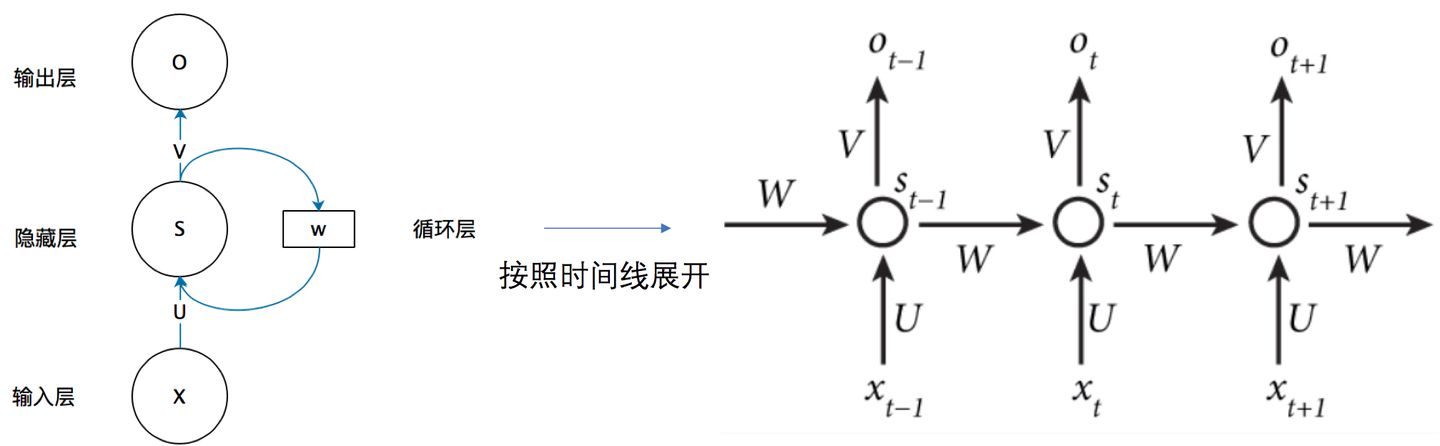

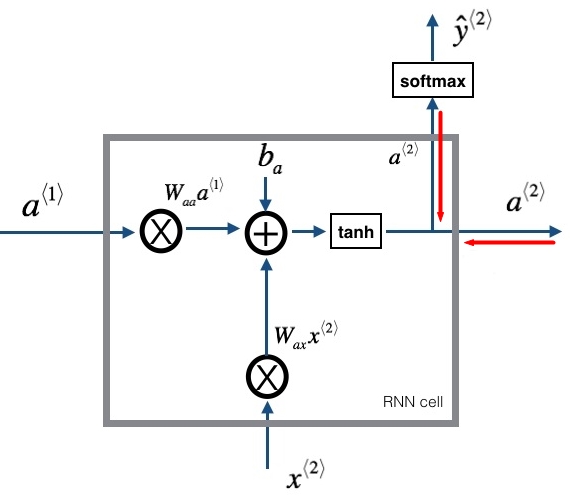

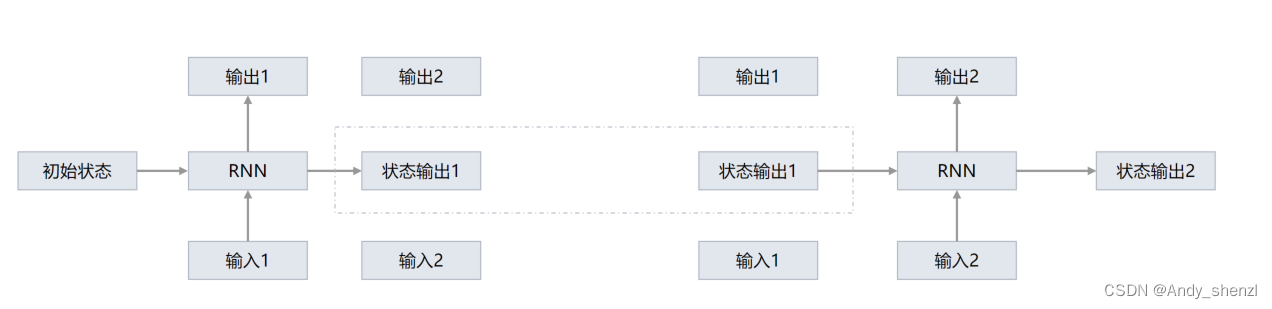

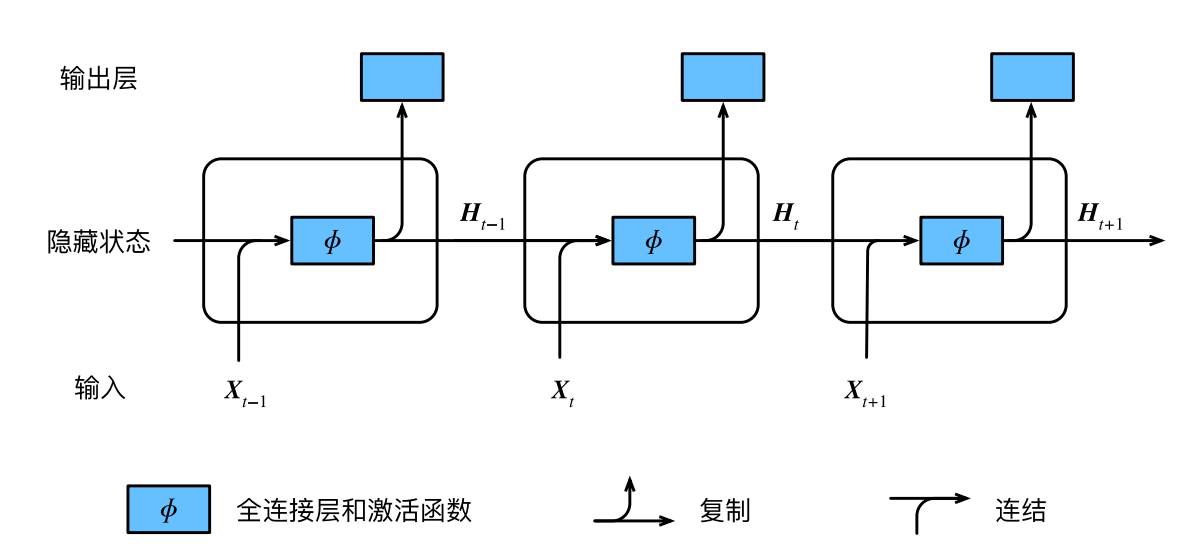

【nlp】2.2 传统RNN模型

传统RNN模型 1 传统RNN模型1.1 RNN结构分析1.2 使用Pytorch构建RNN模型1.3 传统RNN优缺点1 传统RNN模型

1.1 RNN结构分析

结构解释图:

内部结构分析:

我们把目光集中在中间的方块部分, 它的输入有两部分, 分别是h(t-1)以及x(t), 代表上一时间步的隐层输出, 以及此时间步的…

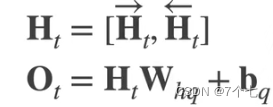

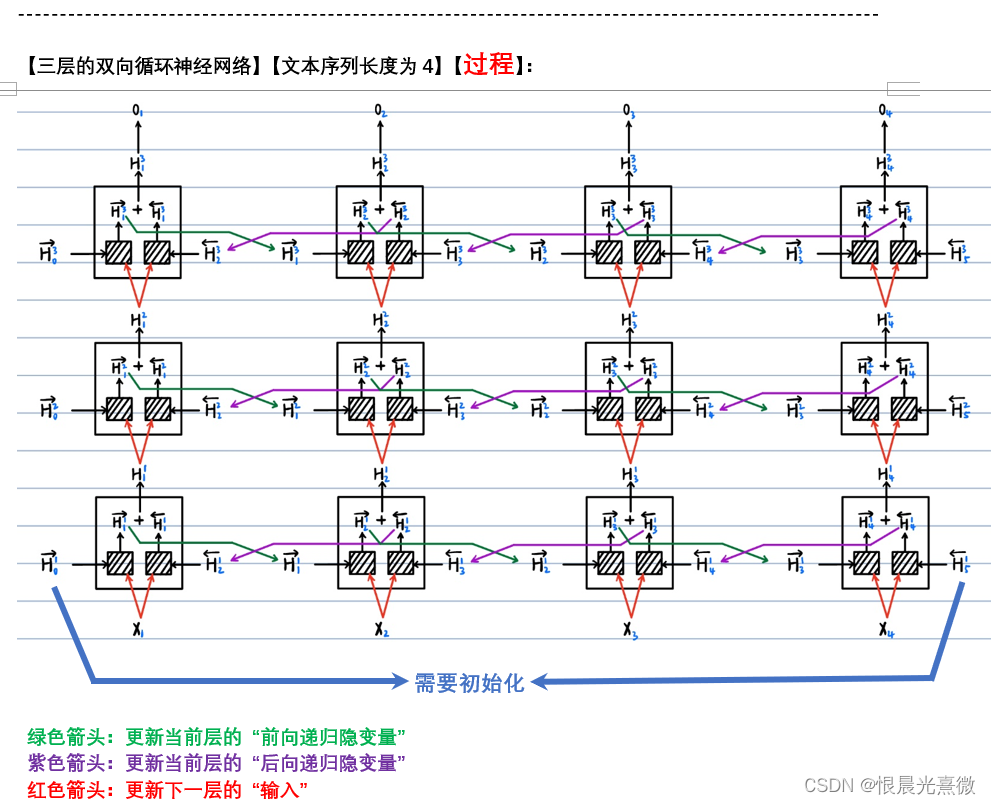

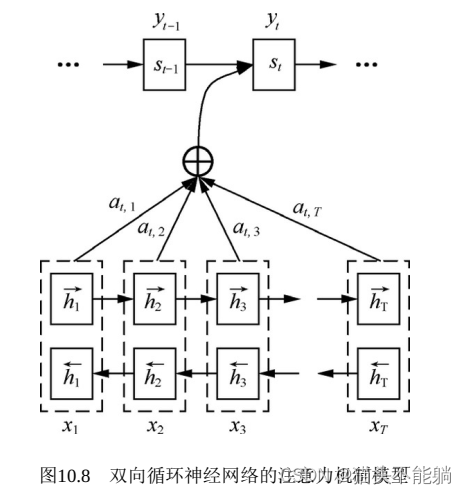

笔记57:双向循环神经网络

本地笔记地址:D:\work_file\DeepLearning_Learning\03_个人笔记\3.循环神经网络\第9章:动手学深度学习~现代循环神经网络

a

a

a

a a

a

a

a a

a

a

a

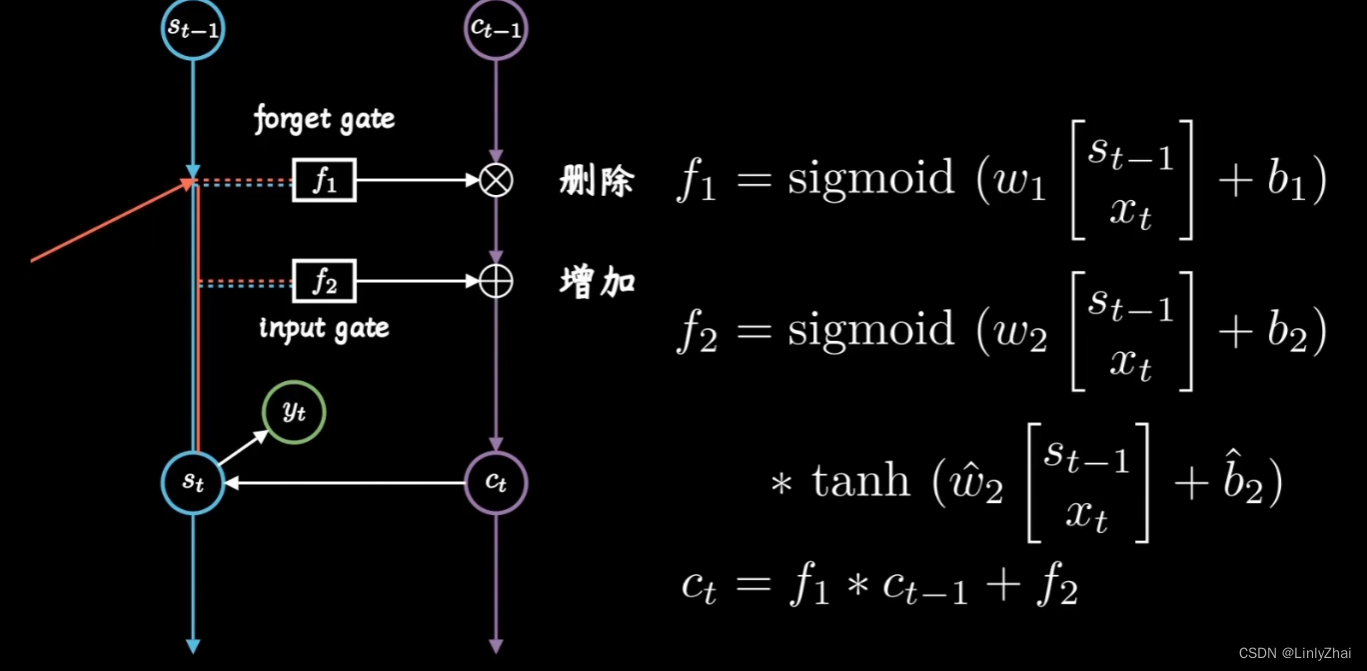

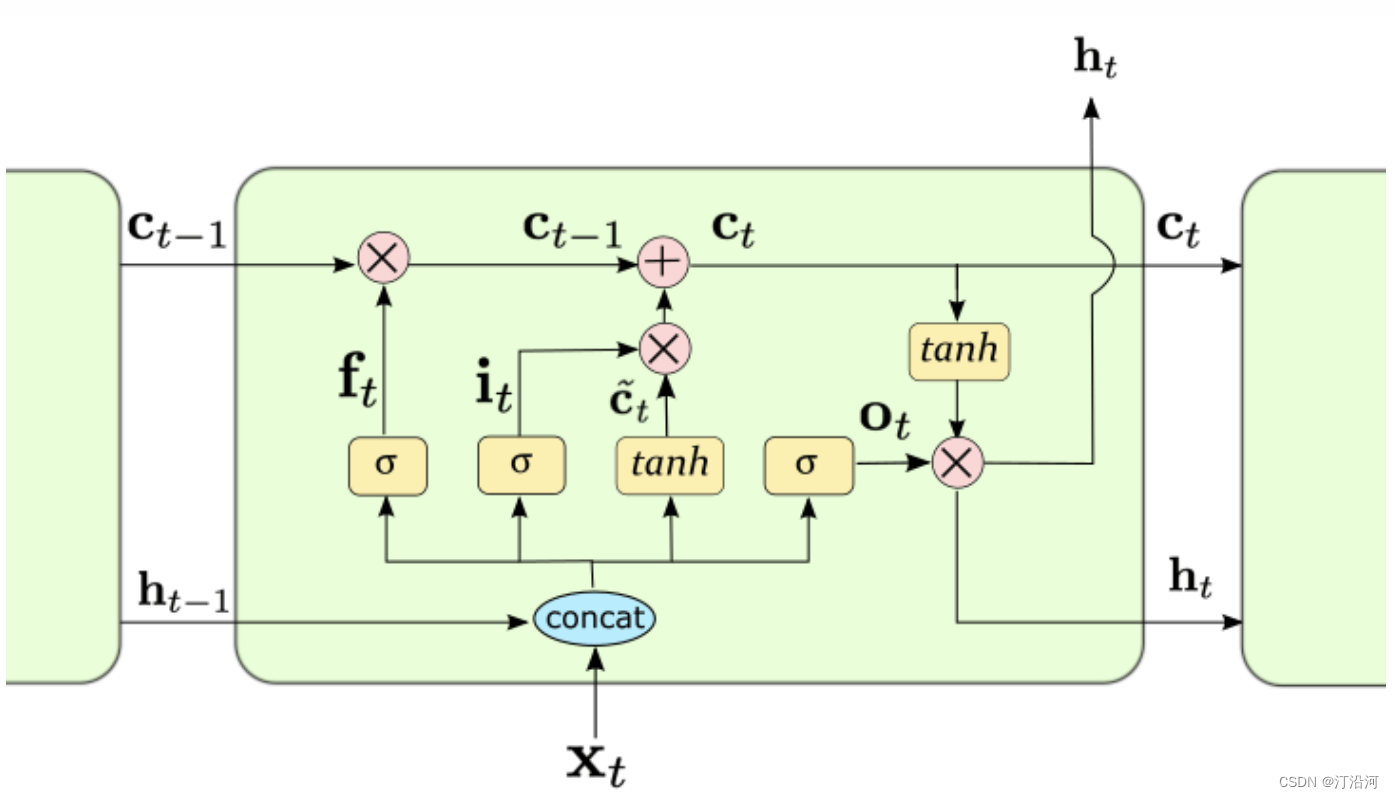

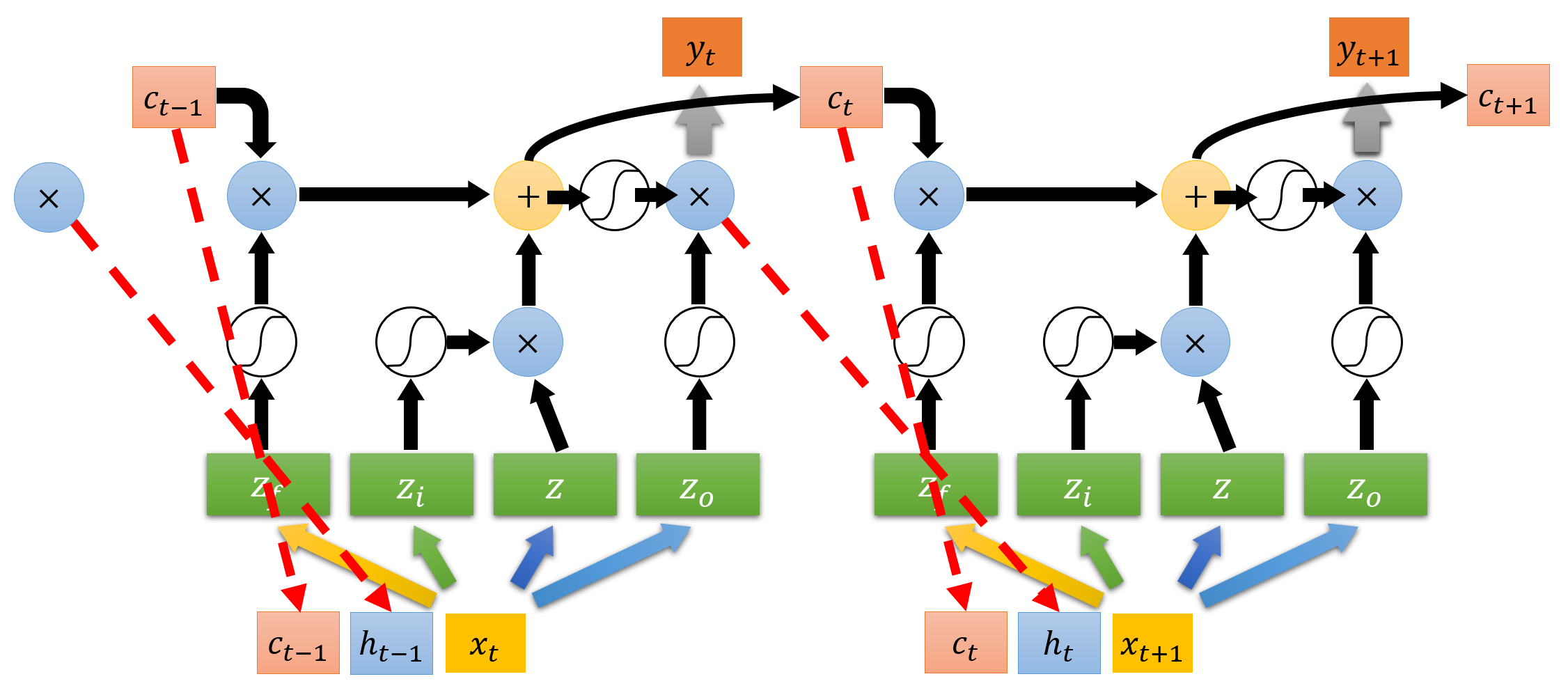

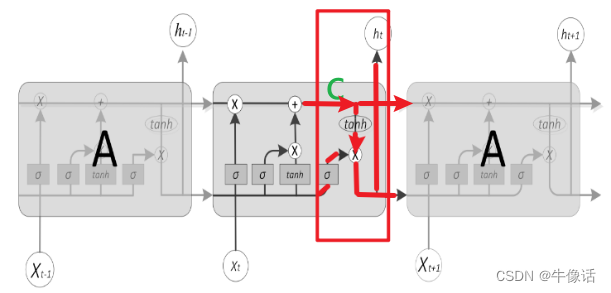

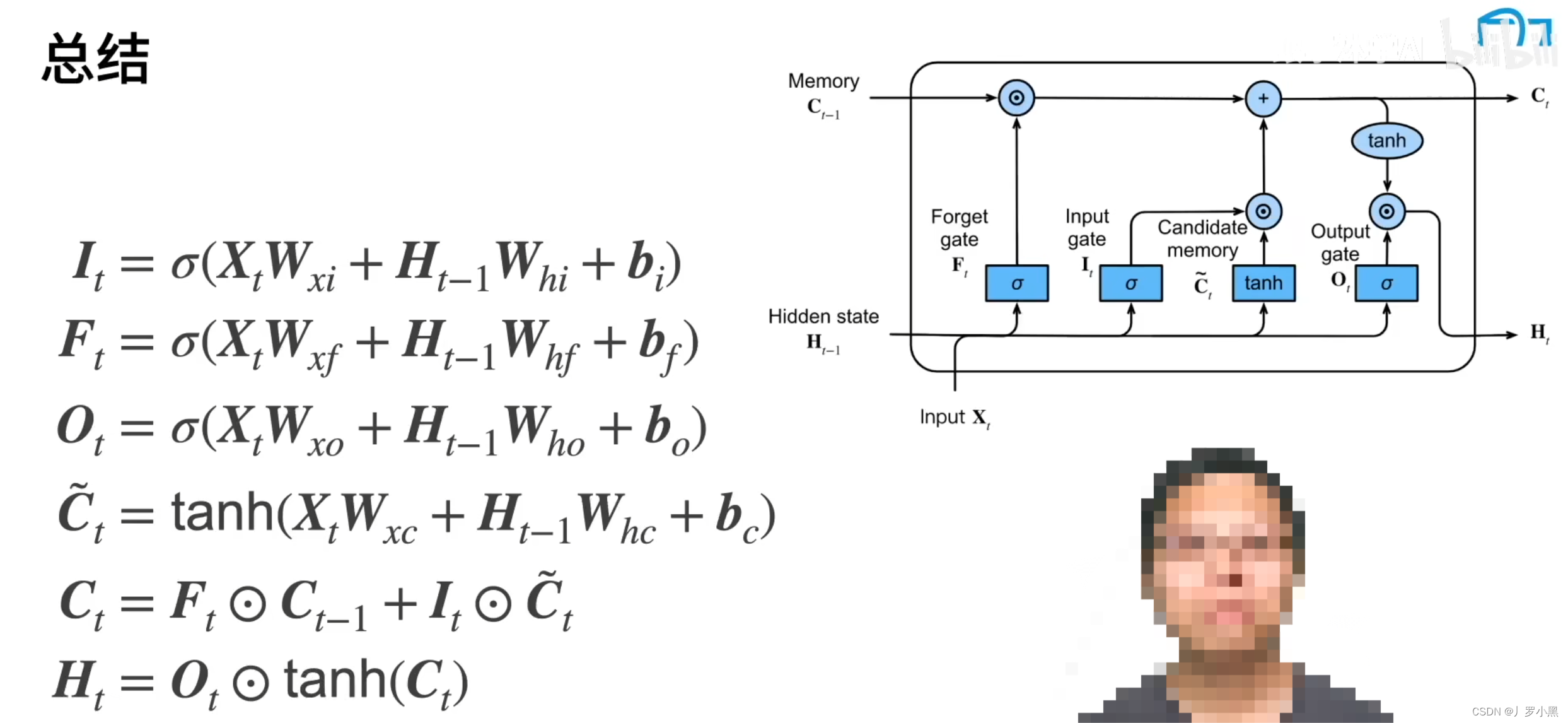

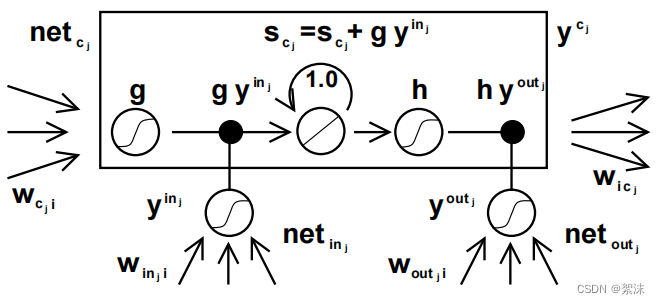

【深度学习实验】循环神经网络(三):门控制——自定义循环神经网络LSTM(长短期记忆网络)模型

目录

一、实验介绍

二、实验环境

1. 配置虚拟环境

2. 库版本介绍

三、实验内容

0. 导入必要的工具包

1. LSTM类

a.__init__(初始化)

b. init_state(初始化隐藏状态)

c. forward(前向传播) 2. RNNModel类

a.__init__&am…

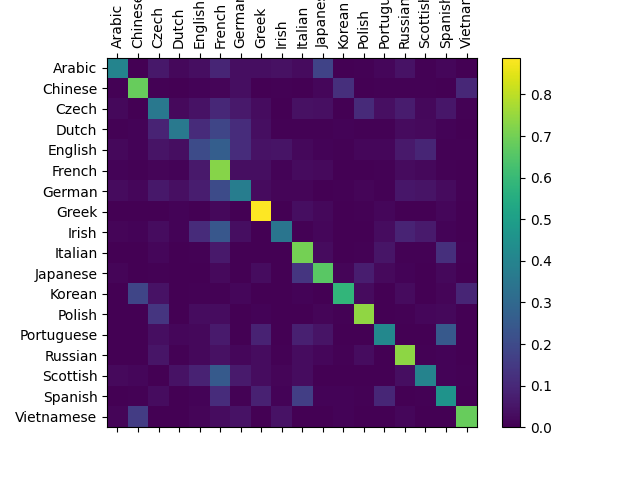

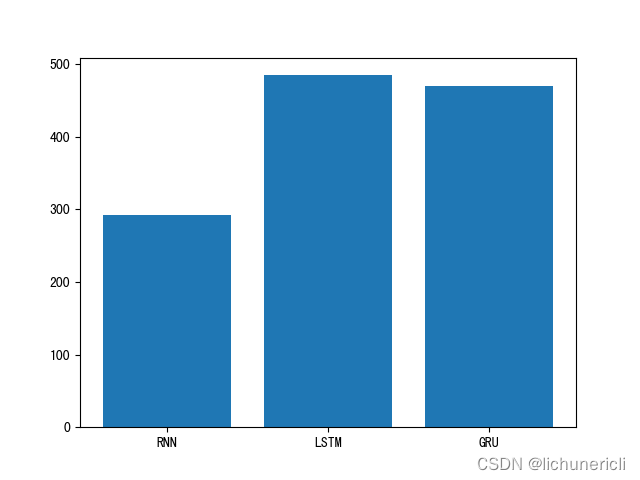

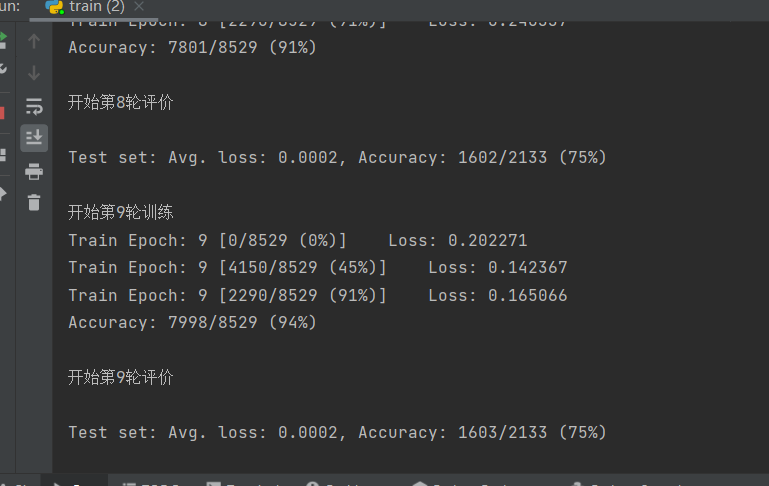

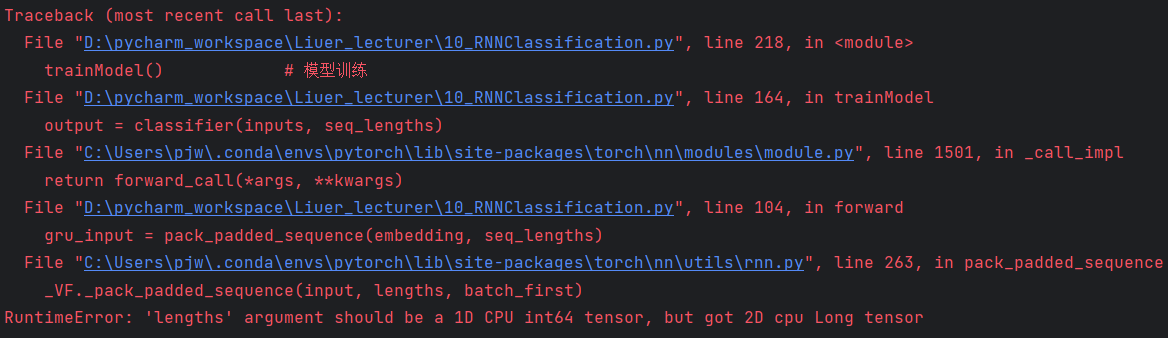

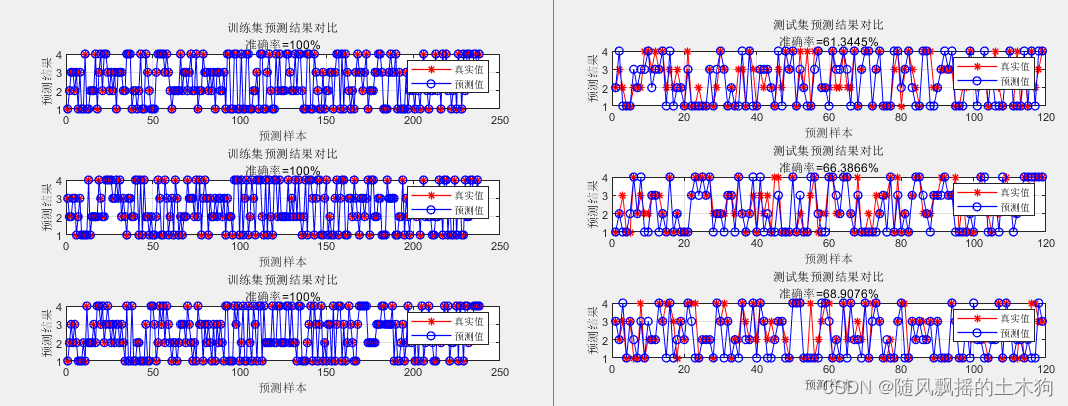

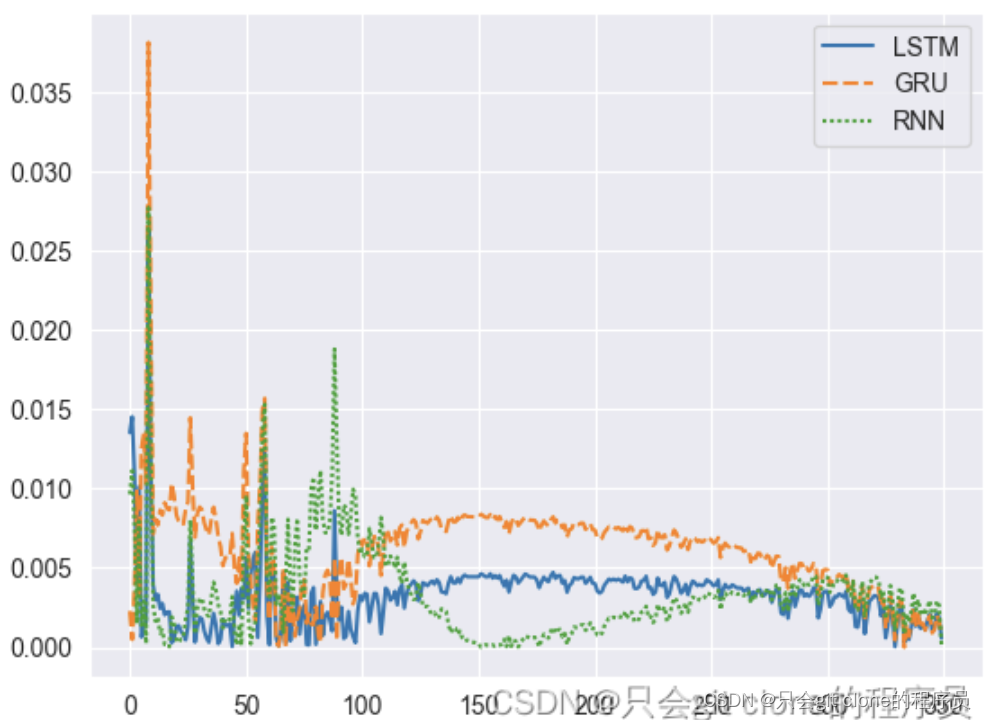

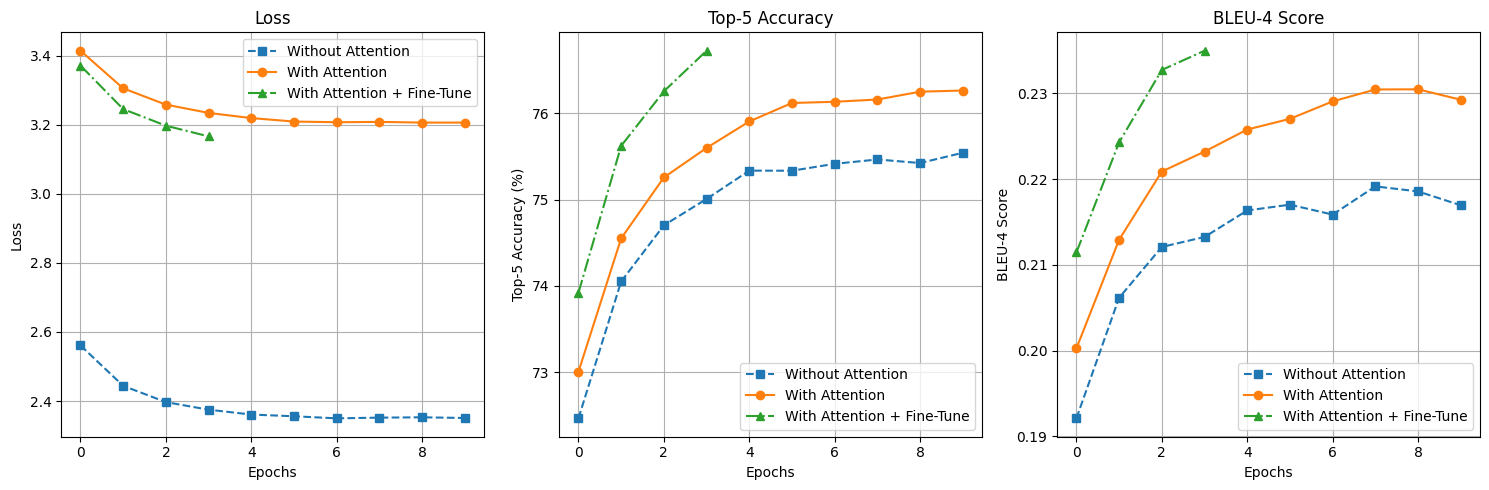

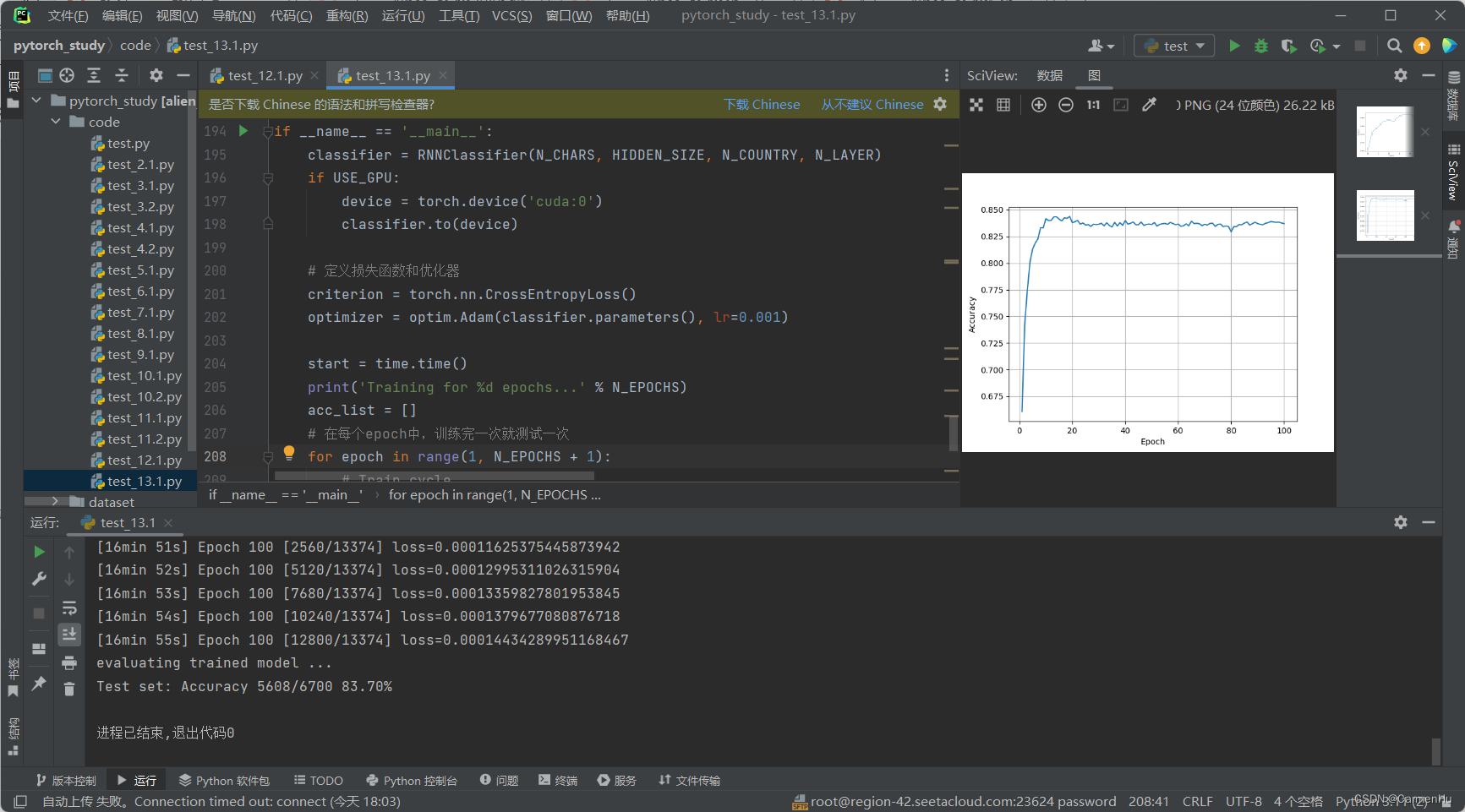

【nlp】2.5(gpu version)人名分类器实战项目(对比RNN、LSTM、GRU模型)工程管理方式

人名分类器实战项目 0 说明1 工程项目设计2 数据预处理data_processing3 创建模型model4 模型测试test5 训练配置config6 模型训练train7 模型对比绘图plotfigure8 模型预测predict9 代码测试demo0 说明

本项目对前一个博客内容2.5(cpu version) 人名分类器实战项目(对比RNN、…

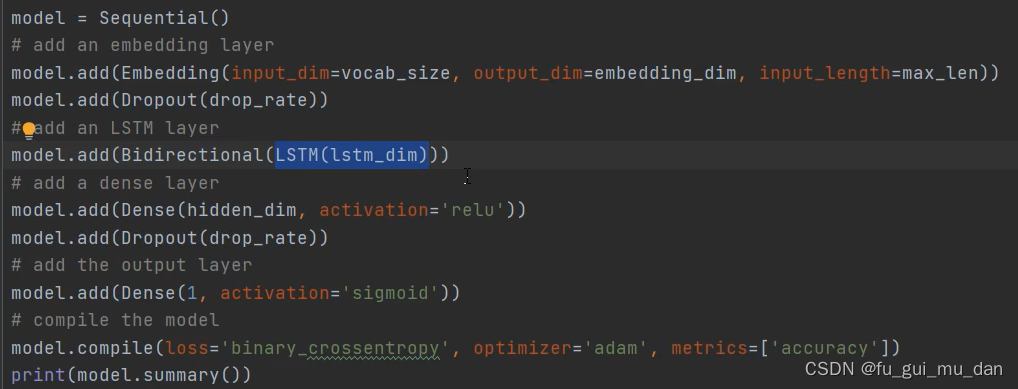

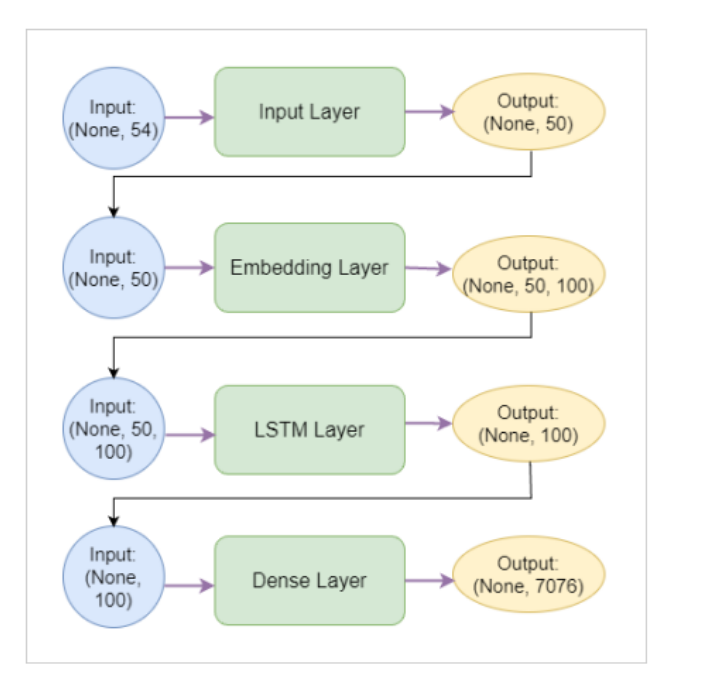

使用循环神经网络RNN进行IMDB影评分类

简介 这是一个使用深度学习处理文本序列的示例。

我们已经尝试使用密集连接层处理过IMDB数据集,回顾请参考Imdb影评分类。

本文使用循环神经网络来处理文本序列。

文本处理 文本可以理解为单词序列或字符序列。

现在已经广泛使用的自然语言理解、文档分类、自动…

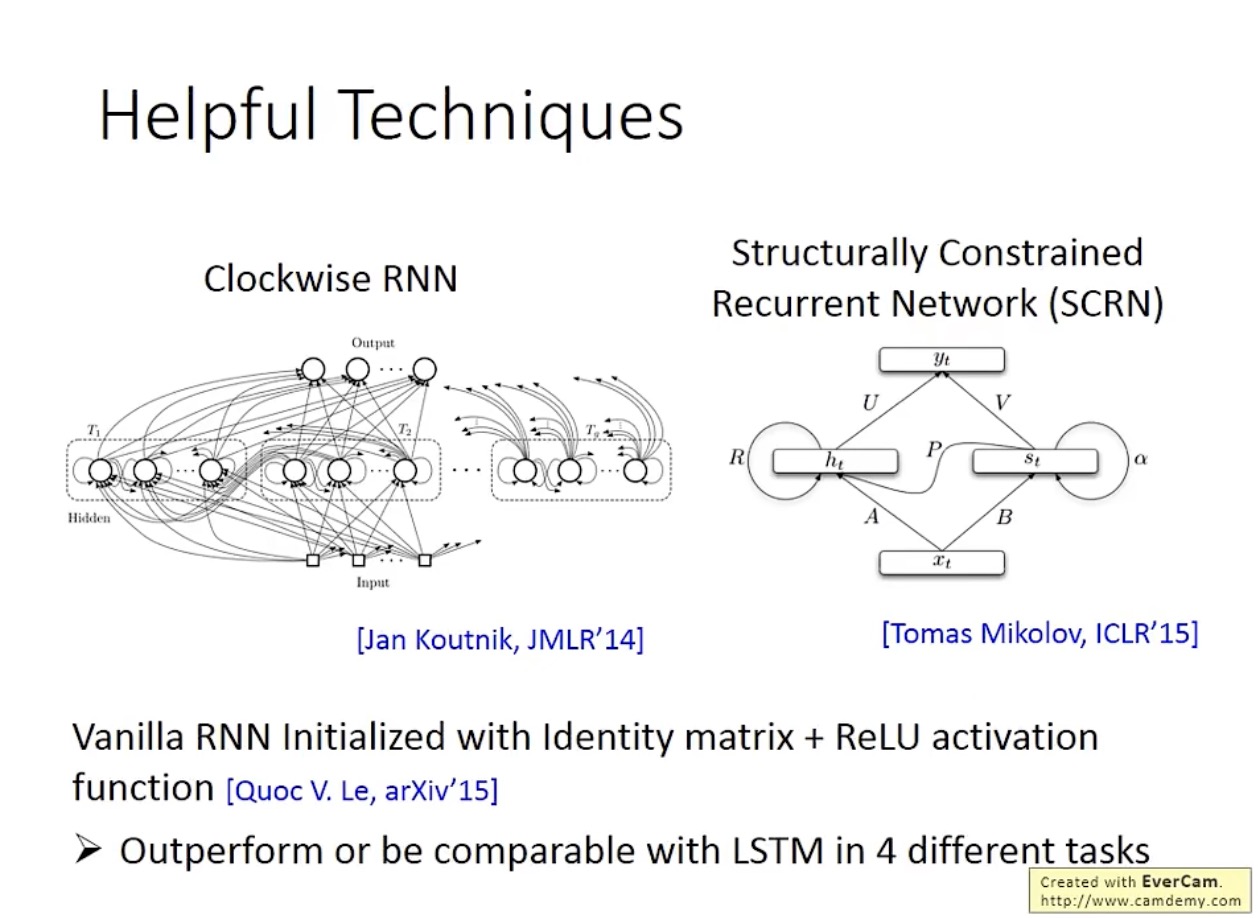

深度学习(CNN+RNN)笔记1

文章目录 视频课 第四课:卷积神经网络(Convolutional Neural Networks)第一周:Convolutional Neural Networks 卷积神经网络第二周:Case Studies 案例学习第三周:Object Detection 目标检测第四周ÿ…

深入理解循环神经网络(RNN)及其变体

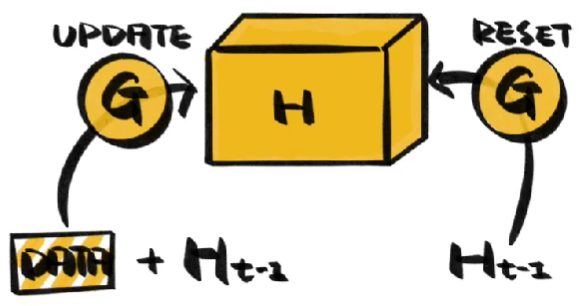

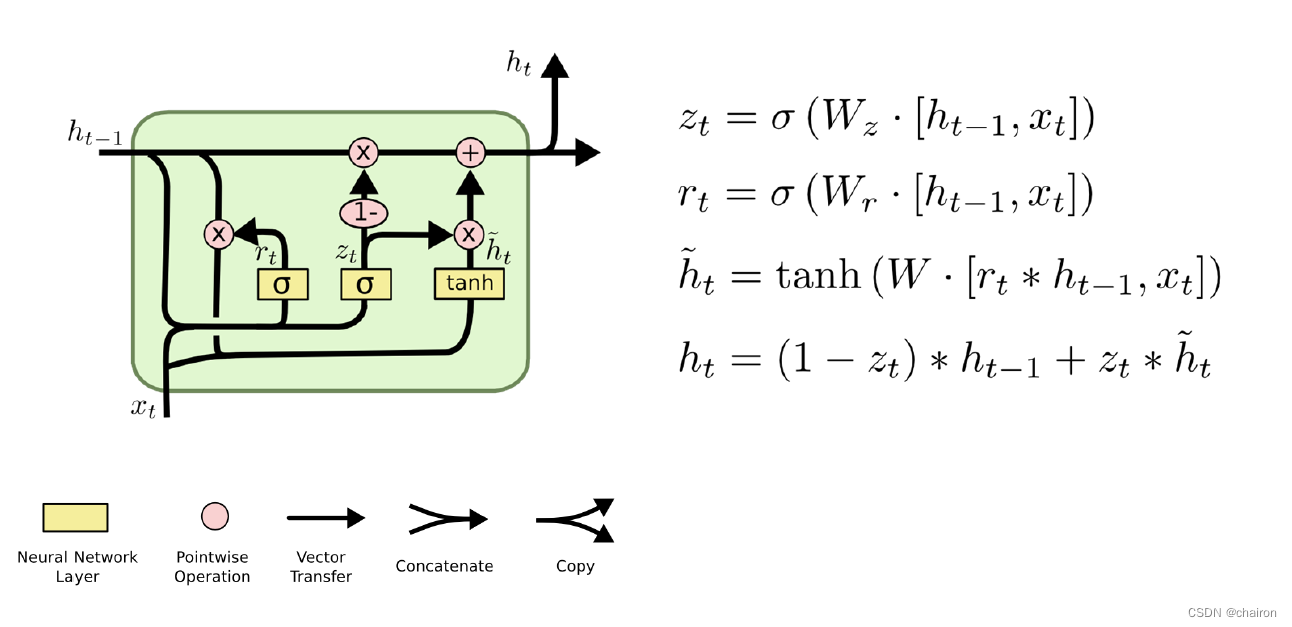

目录 前言1 RNN实现顺序记忆1.1 RNN的序列处理能力1.2 梯度问题:RNN的局限性1.3 应对梯度问题的策略 2 RNN变体:解决梯度问题2.1 GRU(门控循环单元)2.2 LSTM(长短期记忆网络)2.3 变体优势:处理长…

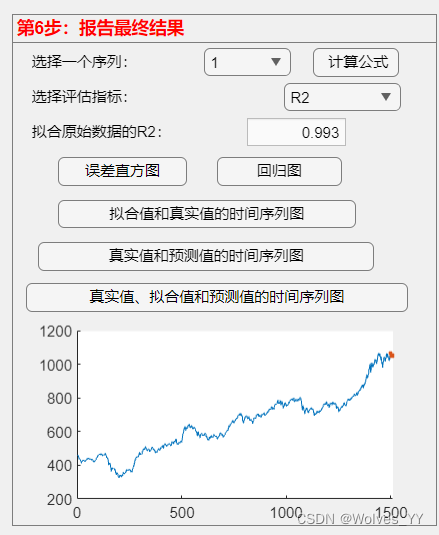

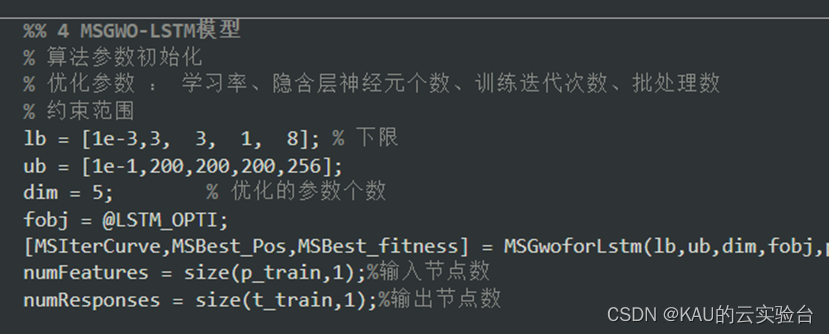

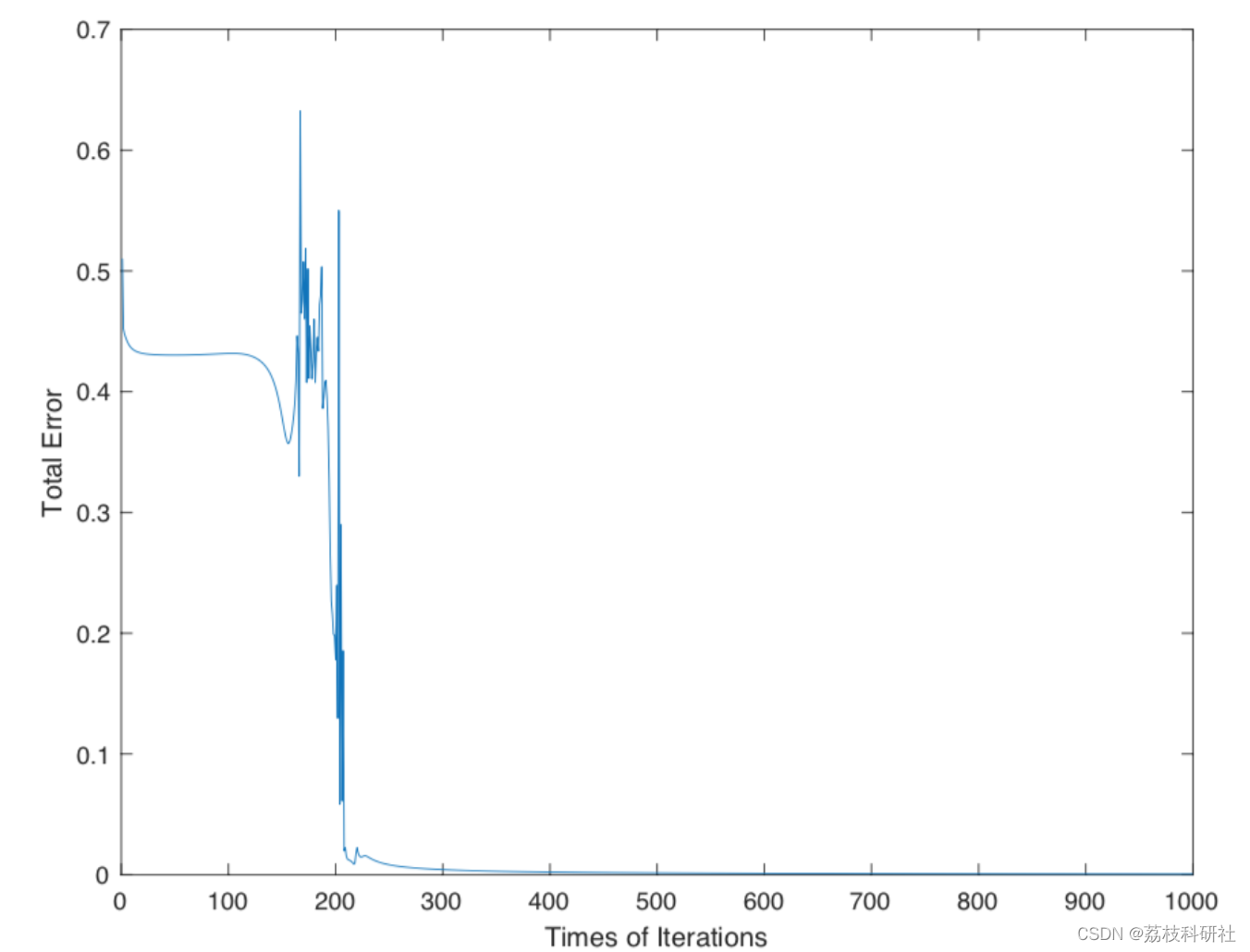

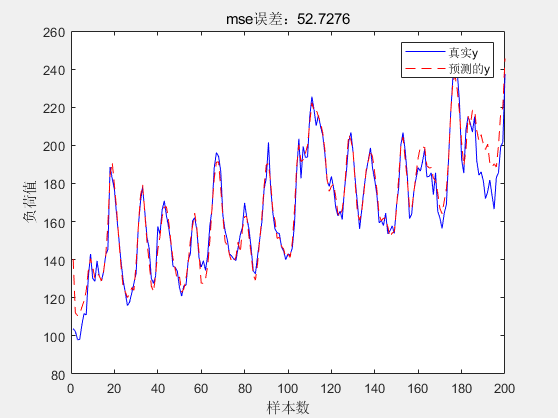

LSTM时间序列预测

本文借鉴了数学建模清风老师的课件与思路,可以点击查看链接查看清风老师视频讲解:【1】演示:基于LSTM深度学习网络预测时间序列(MATLAB工具箱)_哔哩哔哩_bilibili % Forecast of time series based on LSTM deep learn…

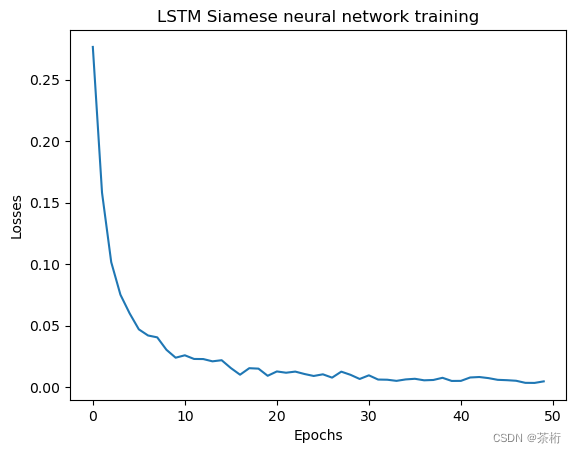

LSTM Siamese neural network

本文中的代码在Github仓库或Gitee仓库中可找到。 Hi, 你好。我是茶桁。

大家是否还记得,在「核心基础」课程中,我们讲过CNN以及LSTM。

卷积神经网络(CNN)已经在计算机视觉处理中得到广泛应用,不过,2017年…

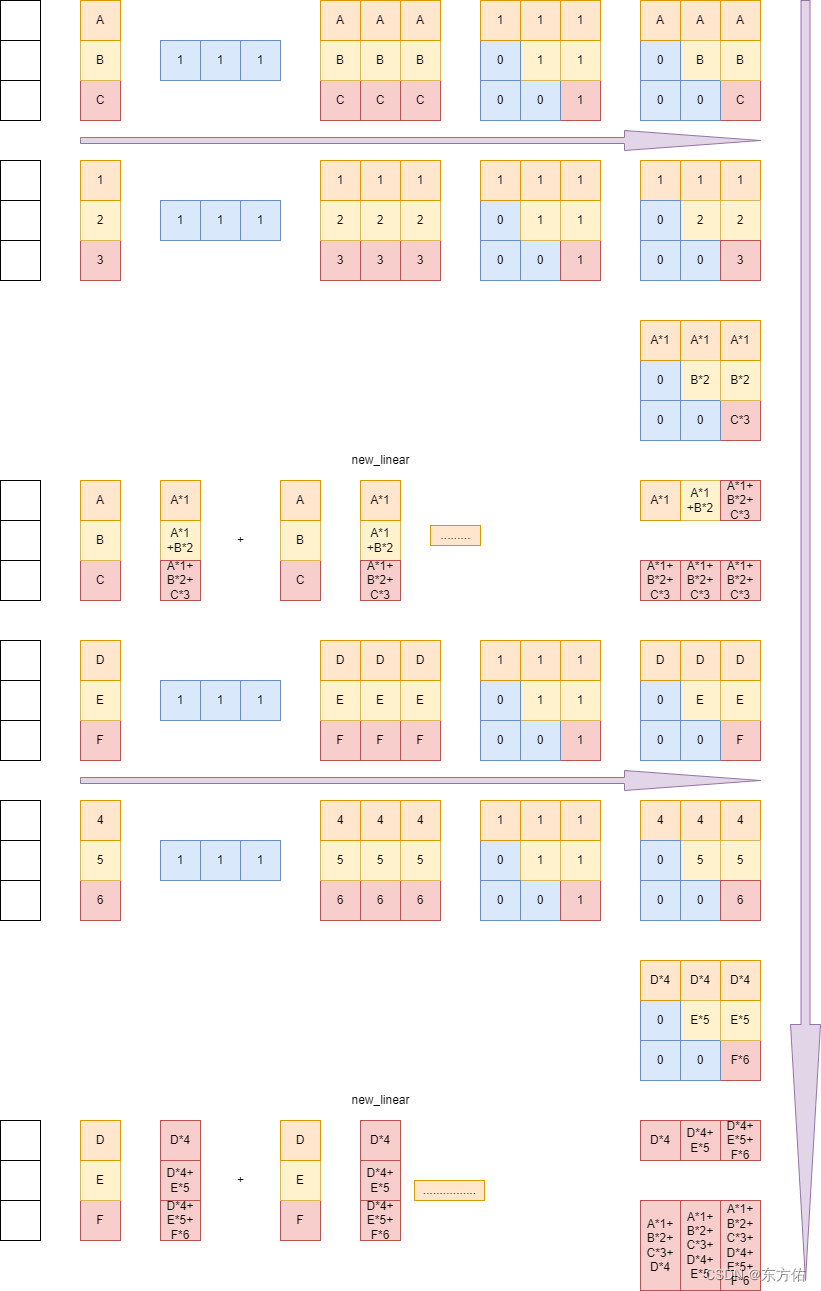

RNN输入数据加工问题与循环流程分析(torch)

RNN输入数据加工问题与循环流程分析(torch) RNN 输入序列数据加工处理 1.1 原始数据 # 假设训练样本text,为4行文本,每个词的词向量为torch.size(1),单元素0维量,tensor.item()获取其中元素text [我,我 爱 你,爱 ,你]--》[[1],[1…

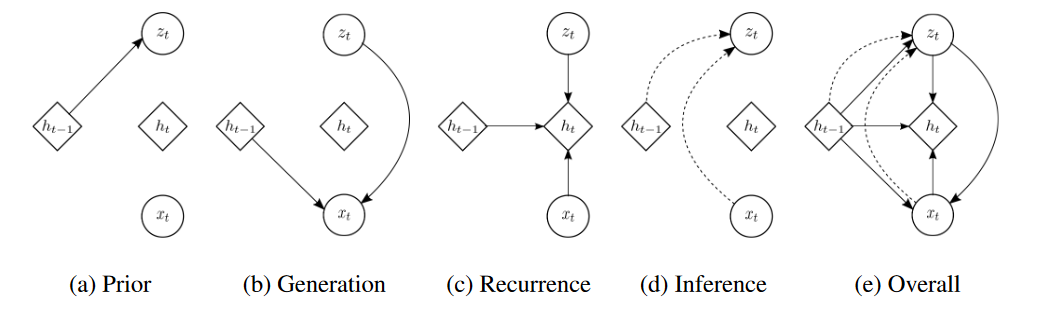

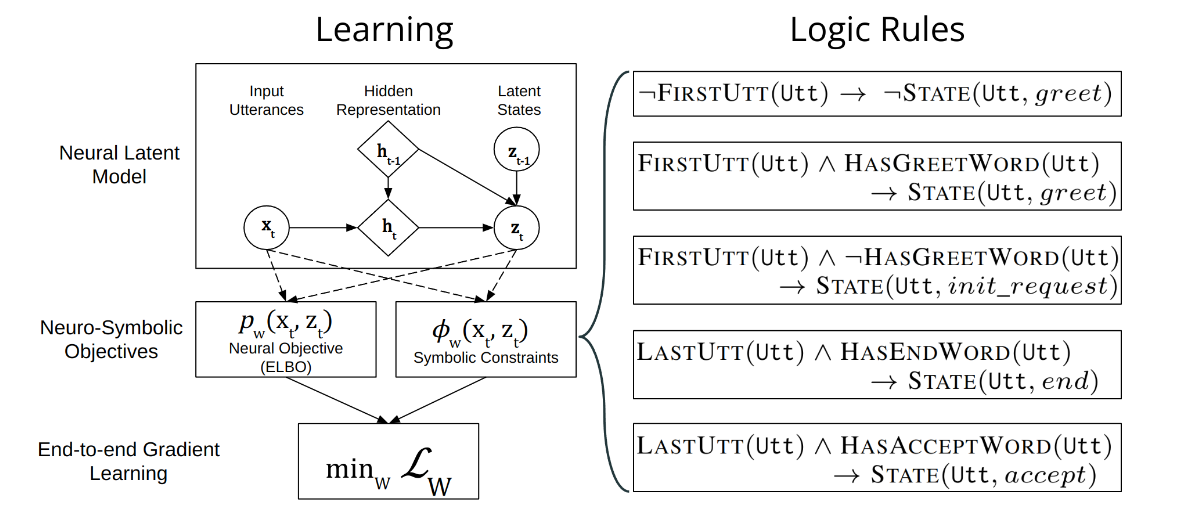

论文《Unsupervised Dialog Structure Learning》笔记:详解DD-VRNN

D-VRNN模型和DD-VRNN模型

总体架构 离散-可变循环变分自编码器(D-VRNN)和直接-离散-可变循环变分自编码器(DD-VRNN)概述。D-VRNN和DD-VRNN使用不同的先验分布来建模 z t z_t zt之间的转换,如红色实线所示。 x t x_t…

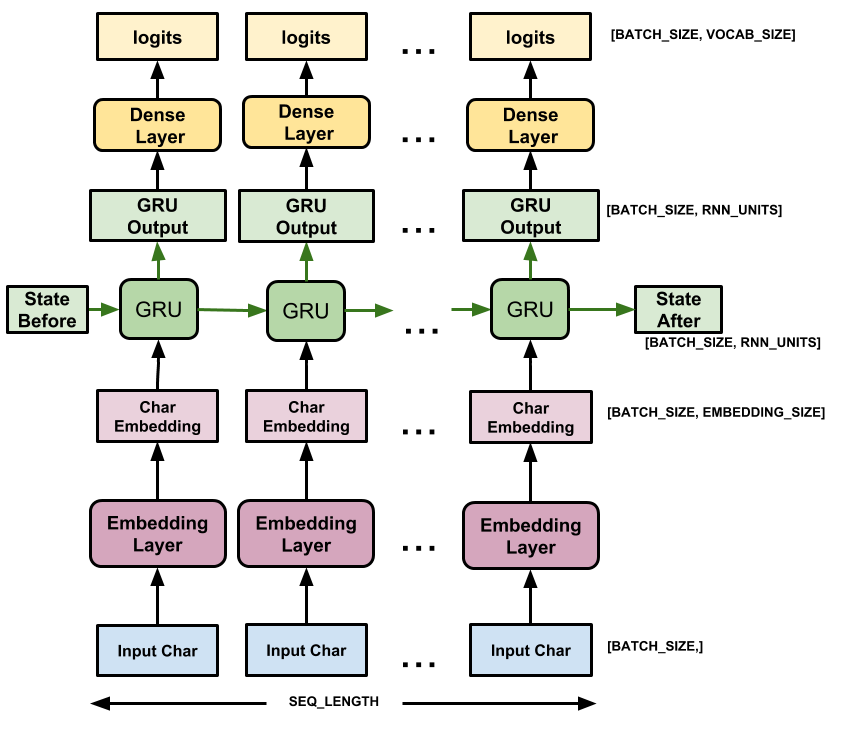

PyTorch翻译官网教程-NLP FROM SCRATCH: GENERATING NAMES WITH A CHARACTER-LEVEL RNN

官网链接

NLP From Scratch: Generating Names with a Character-Level RNN — PyTorch Tutorials 2.0.1cu117 documentation 使用字符级RNN生成名字

这是我们关于“NLP From Scratch”的三篇教程中的第二篇。在第一个教程中</intermediate/char_rnn_classification_tutor…

深度学习技巧应用22-构建万能数据生成类的技巧,适用于CNN,RNN,GNN模型的调试与训练贯通

大家好,我是微学AI,今天给大家介绍一下深度学习技巧应用22-构建万能数据生成类的技巧,适用于CNN,RNN,GNN模型的调试与训练贯通。本文将实现了一个万能数据生成类的编写,并使用PyTorch框架训练CNN、RNN和GNN模型。

目录࿱…

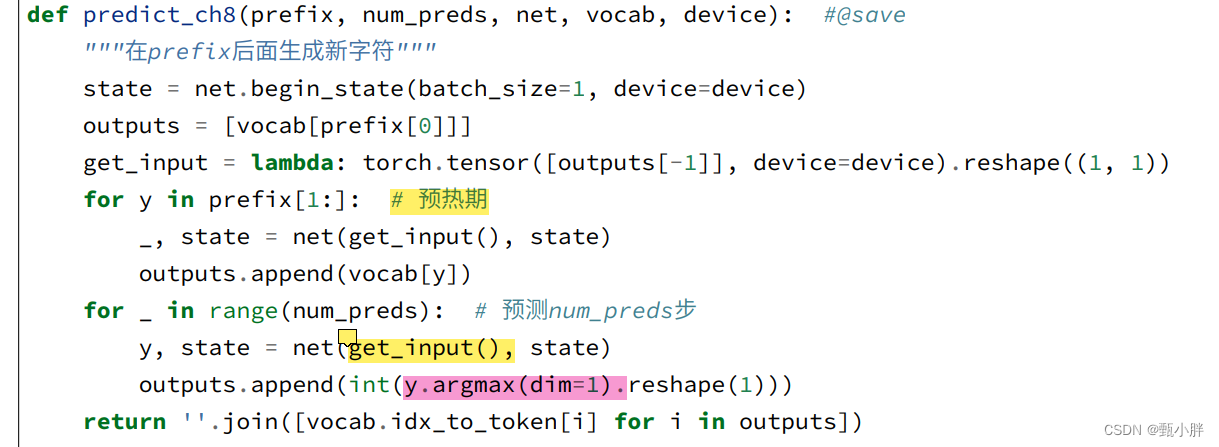

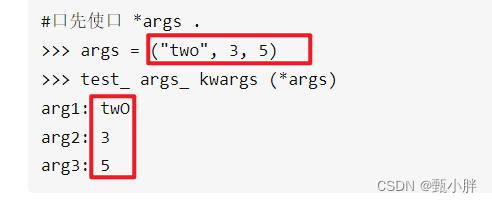

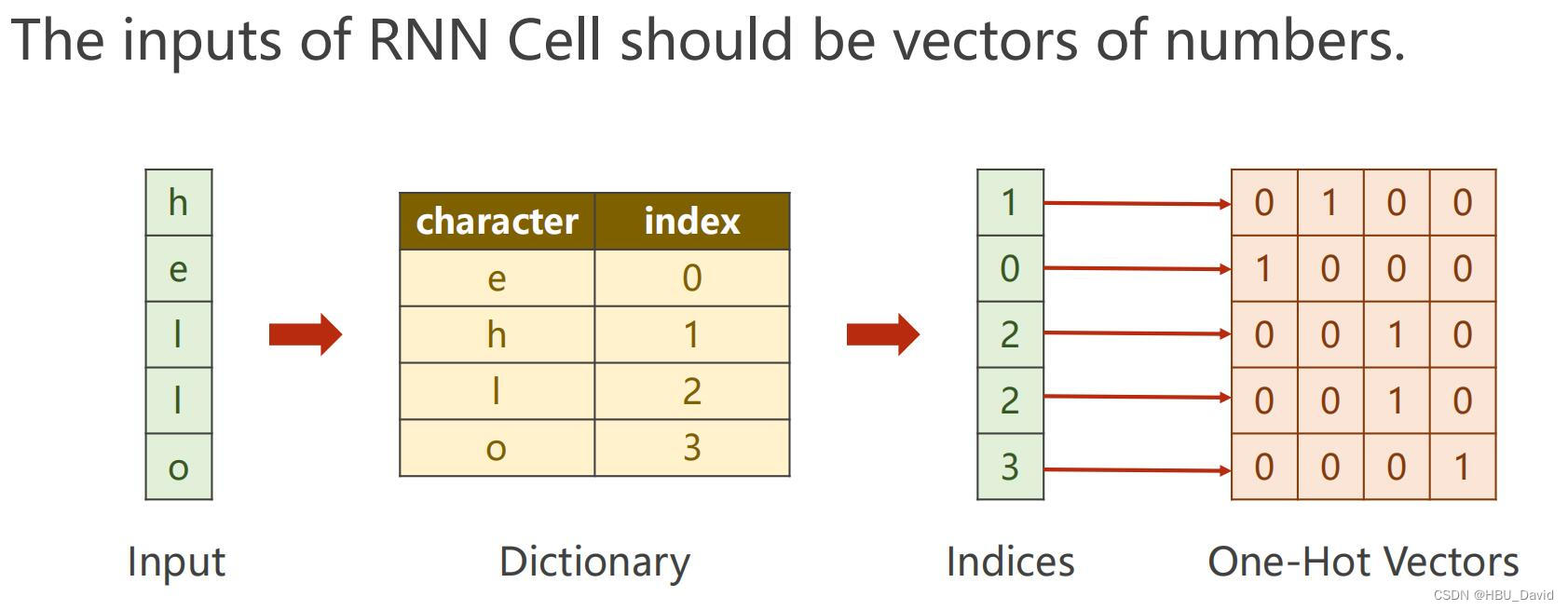

d2l从零与简洁实现RNN

详解一下该章的代码

目录

1.从零实现RNN

1.1加载数据

1.2One-hot独热向量

1.3初始化参数

1.4.1tuple补充

1.5封装一下上面的函数

1.6预测

1.6.1函数里面lambada的探索

1.7梯度剪裁

1.8训练

2.简洁版RNN

2.1同样的数据载入

2.2模型定义

2.3训练

3.rnn总结一下输…

基于空洞卷积DCNN与长短期时间记忆模型LSTM的dcnn-lstm的回归预测模型

周末的时候有时间鼓捣的一个小实践,主要就是做的多因子回归预测的任务,关于时序数据建模和回归预测建模我的专栏和系列博文里面已经有了非常详细的介绍了,这里就不再多加赘述了,这里主要是一个模型融合的实践,这里的数…

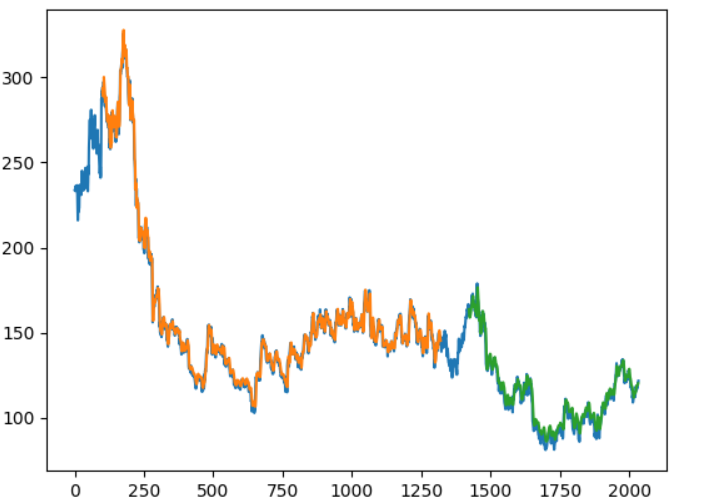

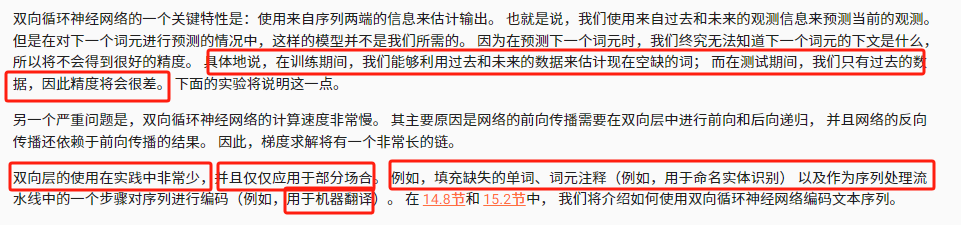

《动手学深度学习 Pytorch版》 9.4 双向循环神经网络

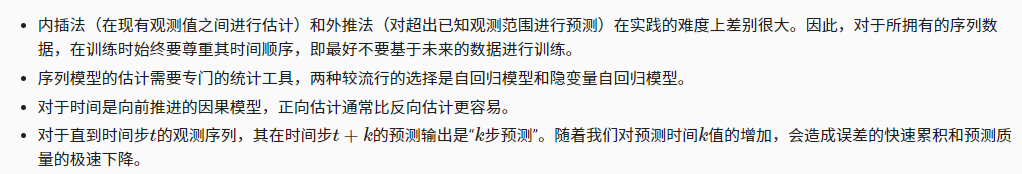

之前的序列学习中假设的目标是在给定观测的情况下对下一个输出进行建模,然而也存在需要后文预测前文的情况。

9.4.1 隐马尔可夫模型中的动态规划

数学推导太复杂了,略。

9.4.2 双向模型

双向循环神经网络(bidirectional RNNs)…

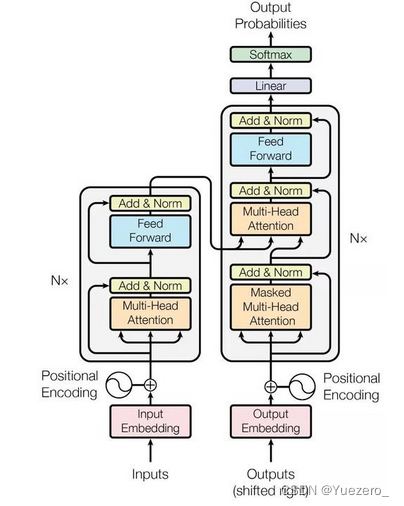

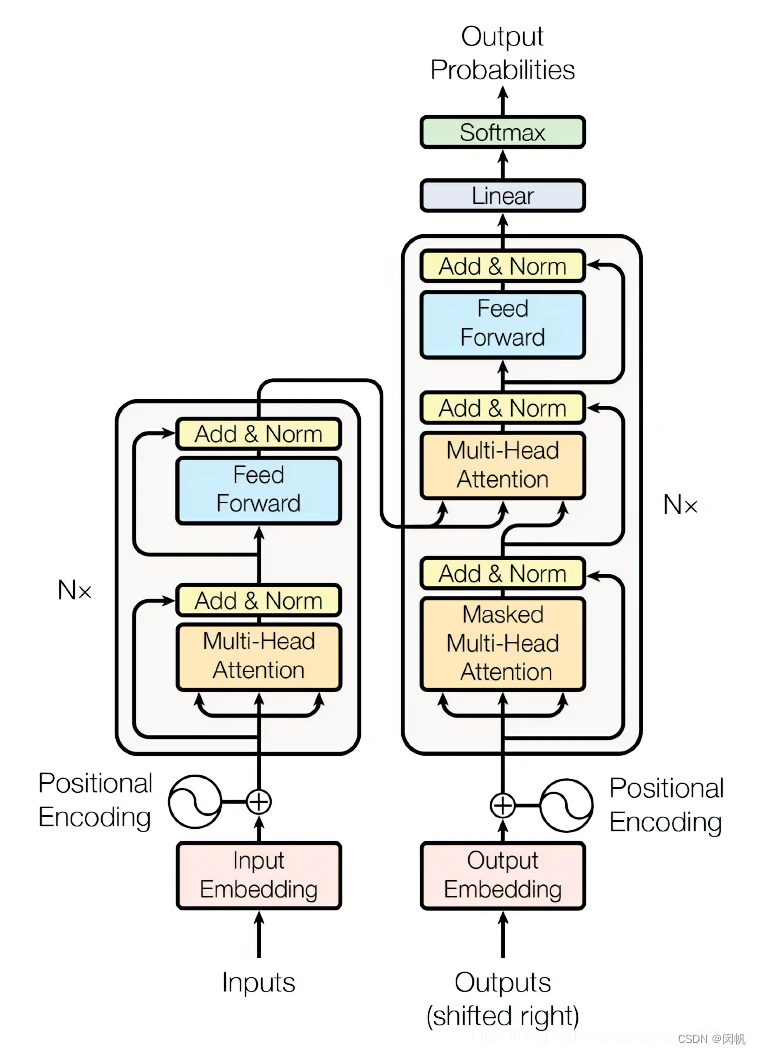

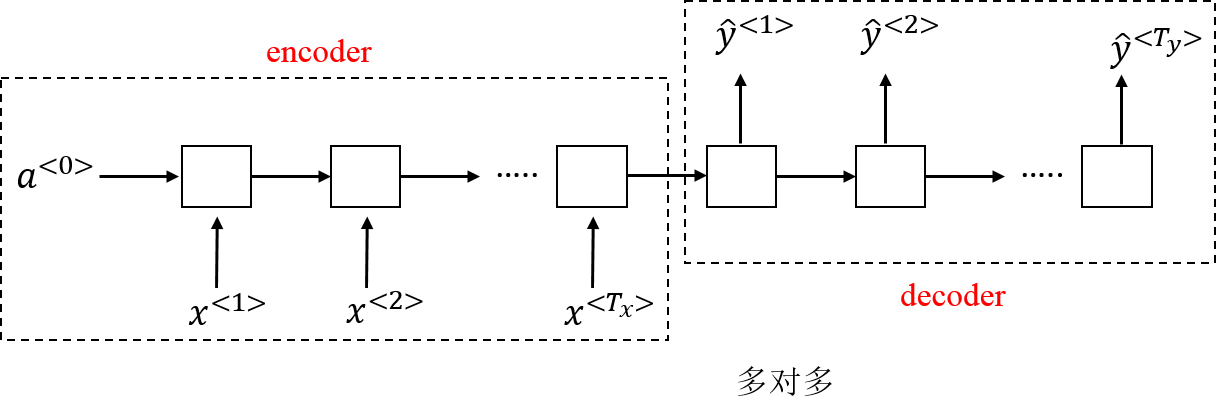

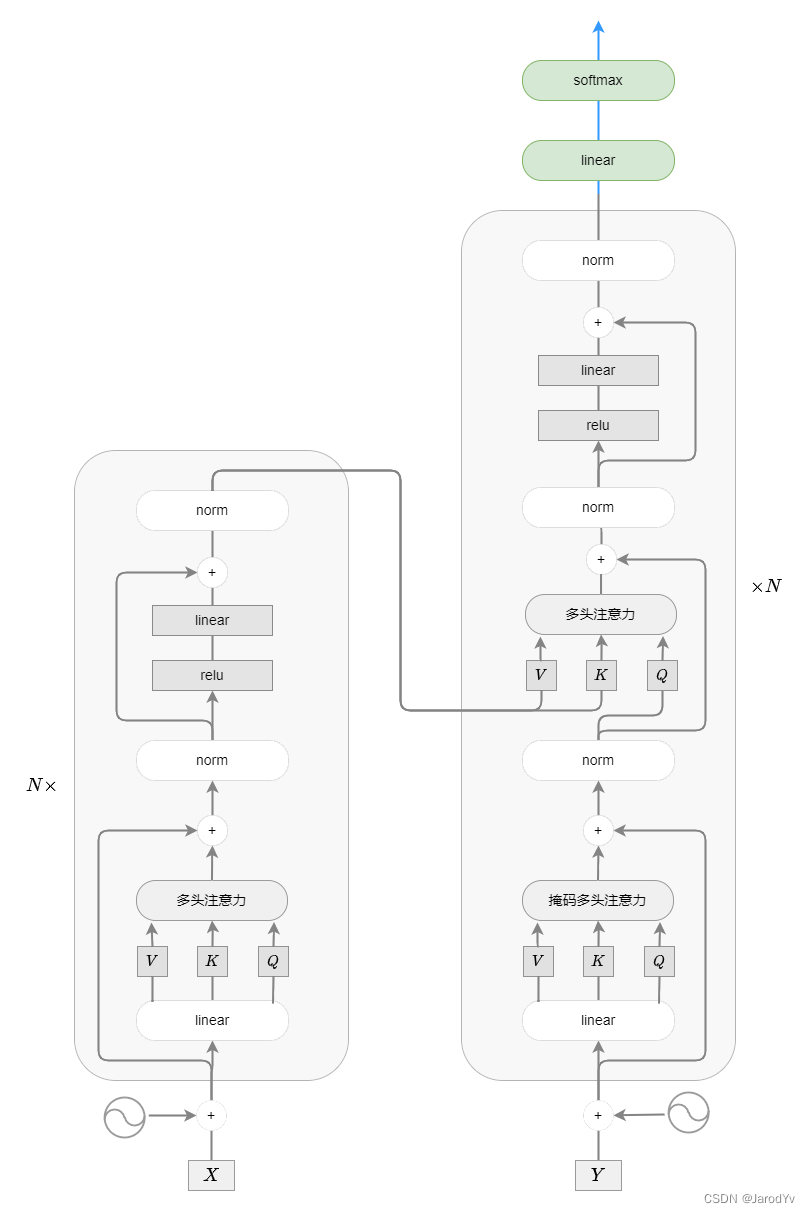

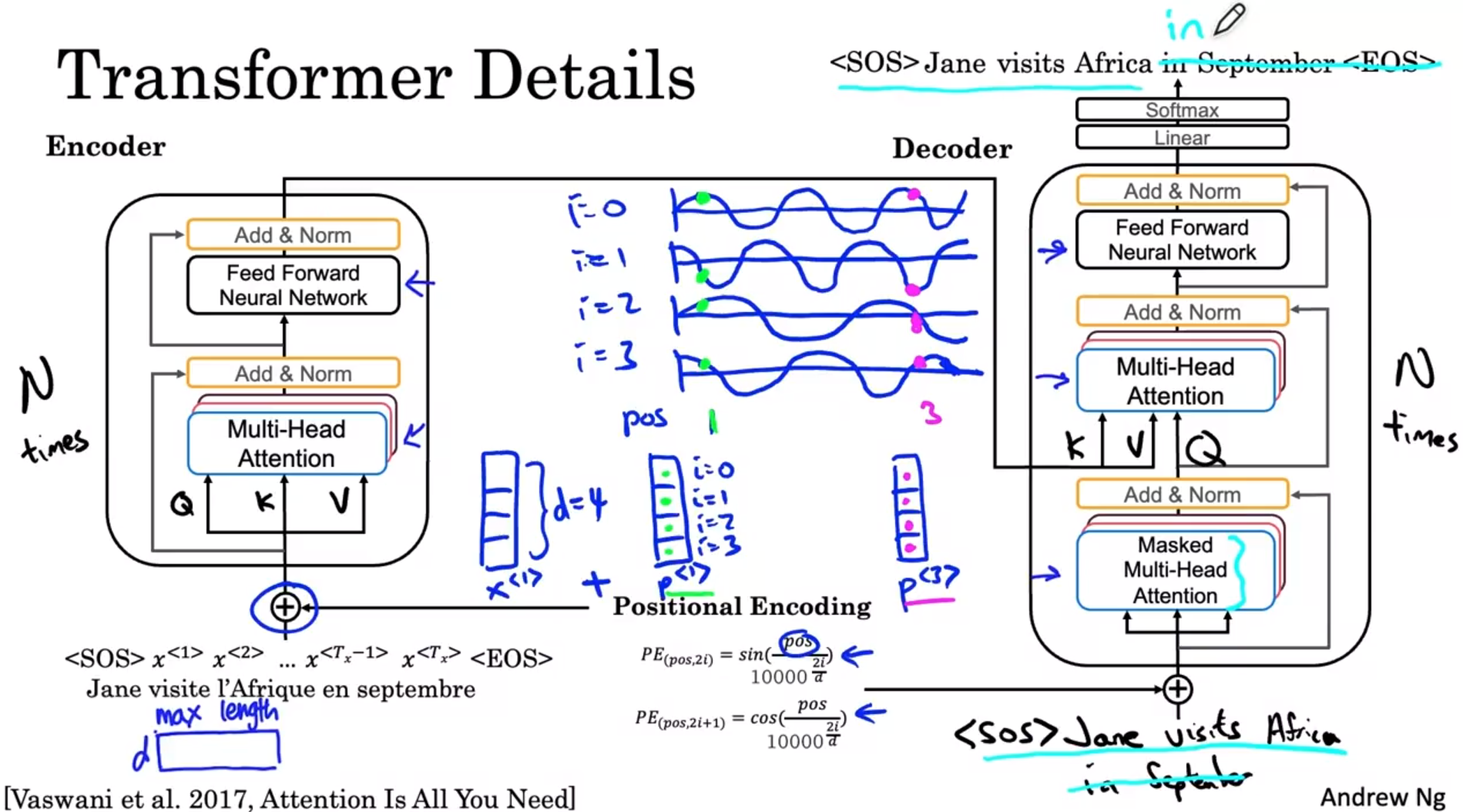

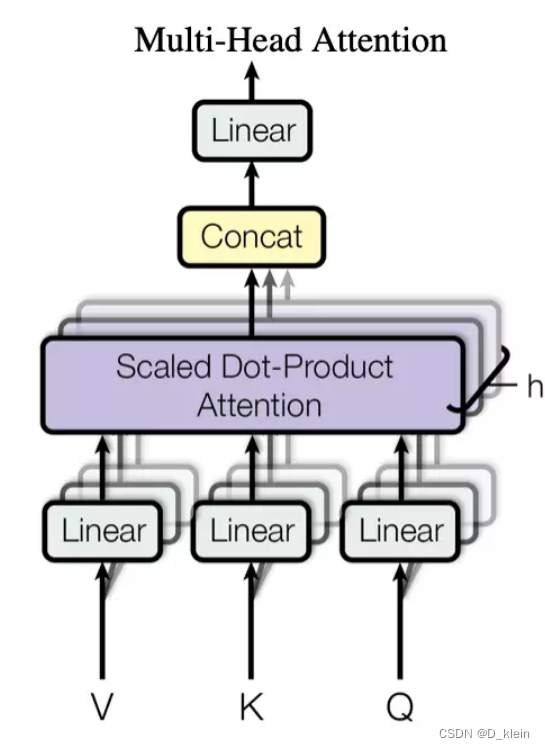

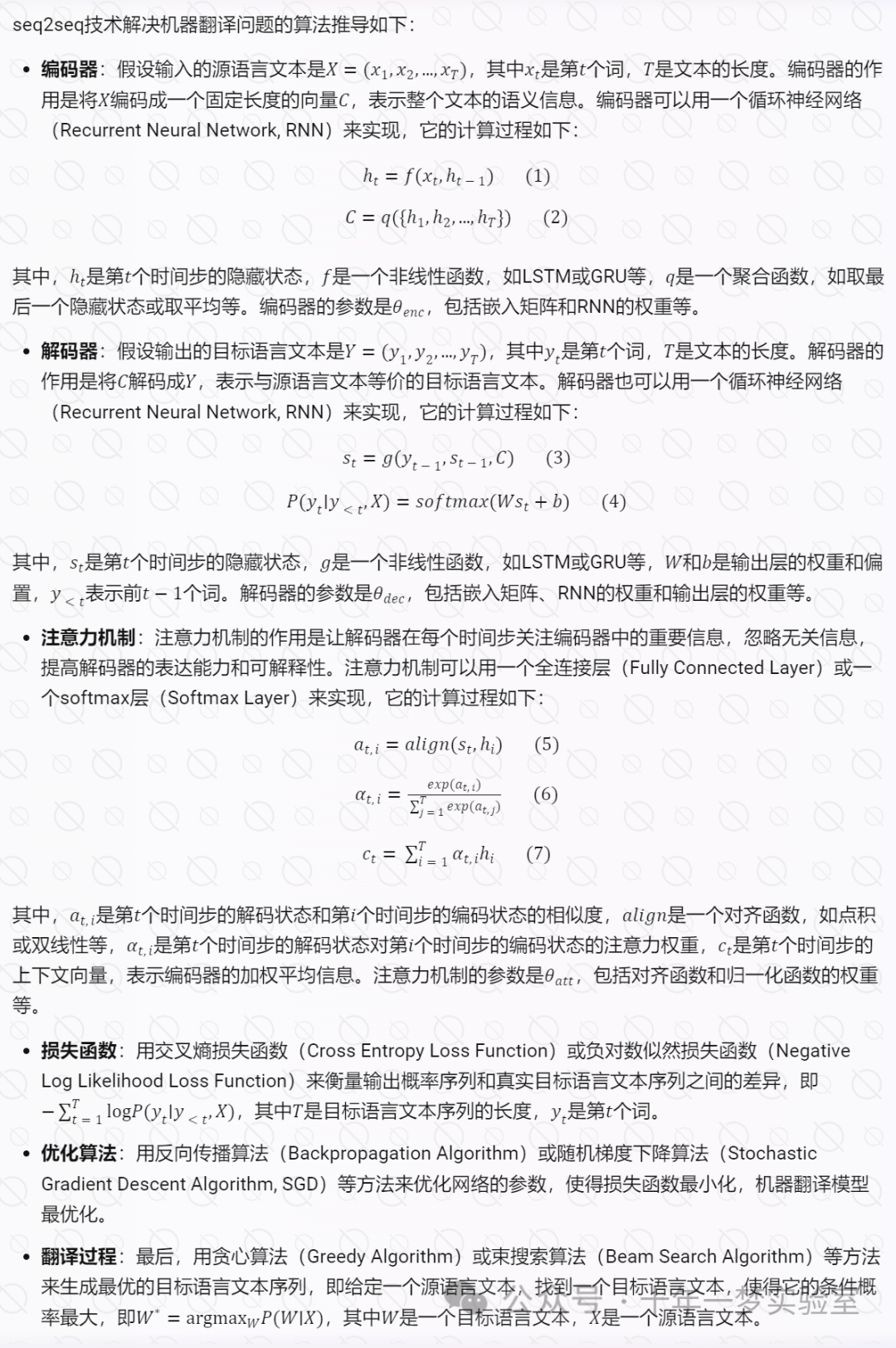

Transformer---RNN网络

1、什么是seq2seq?

简单来说就是模型输入是序列,输出也是序列。典型的任务有:机器翻译任务,文本摘要任务。

2、seq2seq模型如何处理文本/长文本序列?

使用循环神经网络来处理长文本序列,循环神经网络设置…

Tensorflow学习笔记十——循环神经网络

循环神经网络对长度可变的序列数据有较强的处理能力,在NLP领域独领风骚。 10.1 循环神经网络简介 1.循环神经网络的前向传播程序设计

import numpy as npx[0.8,0.1]

init_state[0.3,0.6]

Wnp.asarray([[0.2,0.4],[0.7,0.3]])

Unp.asarray([0.8,0.1])

b_hnp.asarray…

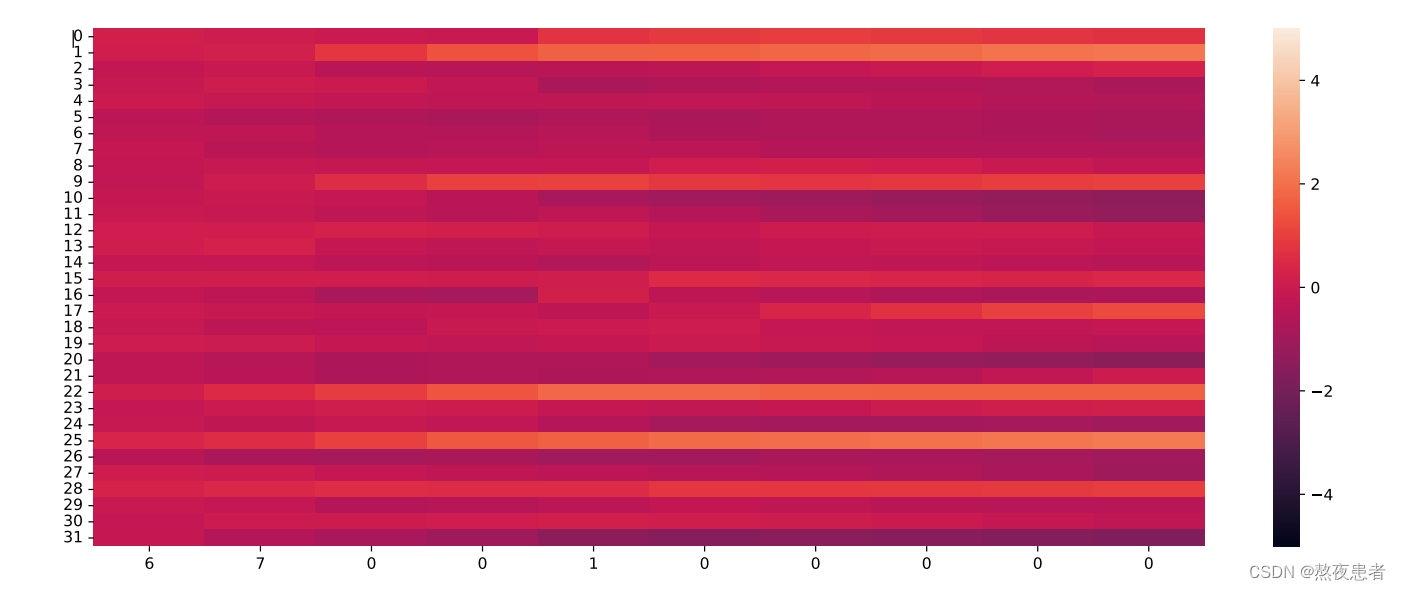

动手深度学习笔记(四十九)8.5. 循环神经网络的从零开始实现

动手深度学习笔记(四十九)8.5. 循环神经网络的从零开始实现 8.5. 循环神经网络的从零开始实现8.5.1. 独热编码8.5.2. 初始化模型参数8.5.3. 循环神经网络模型8.5.4. 预测8.5. 循环神经网络的从零开始实现

本节将根据 8.4节中的描述, 从头开始基于循环神经网络实现字符级语言…

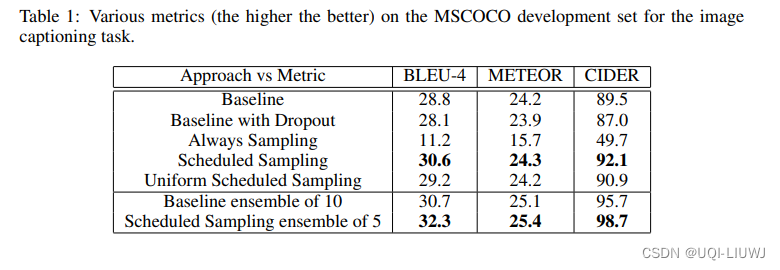

Teacher Forcing策略在RNN的应用

简介

Teacher Forcing策略在RNN中经常被用到,例如machine translation、image caption、text summarization等语言模型任务。 Teacher Forcing策略使训练RNN更快速收敛且效果还挺好。

RNN模型表示

公式 P(y1,y2,...,yT)P(y1)∏t2TP(yt∣y1,y2,...,yt−1)P(y_{1},…

Transformer和RNN的区别?

Transformer和循环神经网络(RNN)是两种不同的序列建模模型,它们在结构和工作原理上有一些重要的区别。 结构: Transformer:Transformer模型是一种基于自注意力机制的序列建模模型。它主要由编码器和解码器组成…

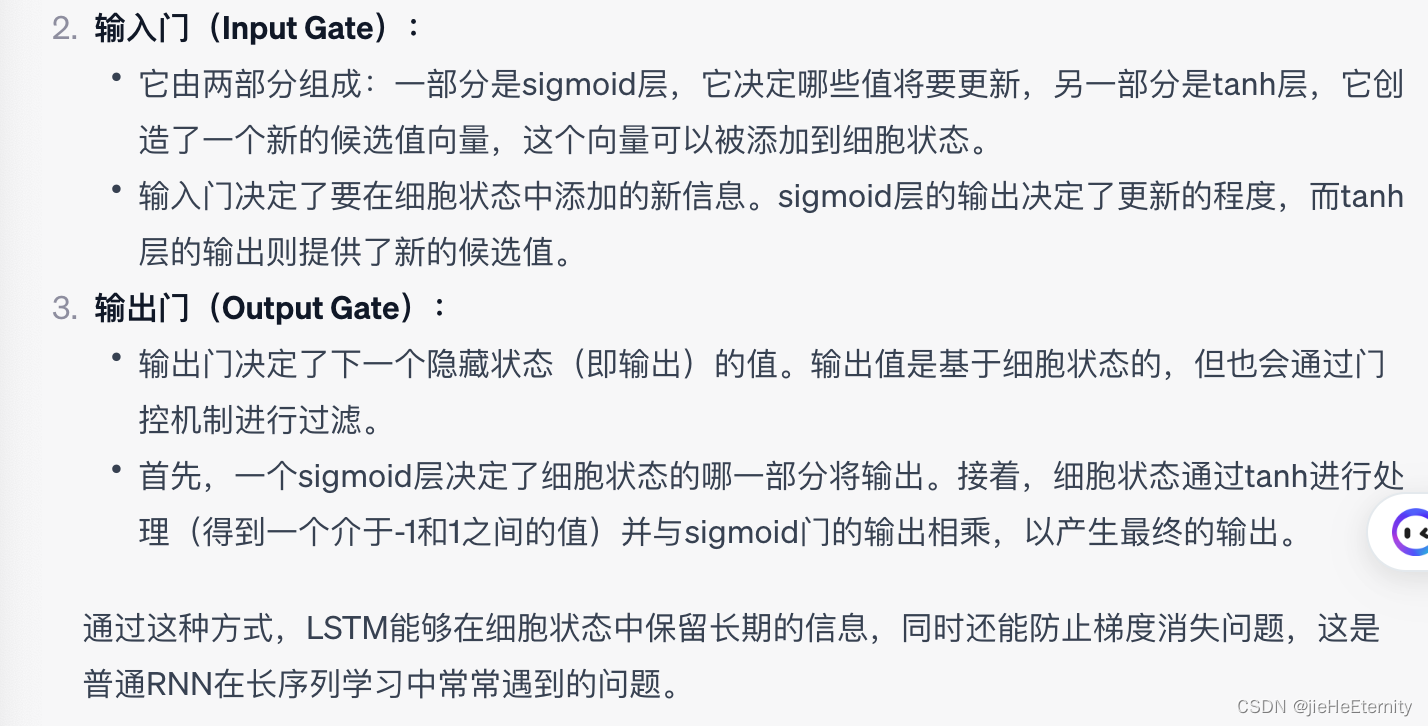

什么是长短时记忆网络(LSTM)

什么是长短时记忆网络(LSTM)

RNN有一定的记忆能力,但不幸的是它只能保留短期记忆,在各类任务上表现并不好,那该怎么办?

人们将目光投向了自己,人类的记忆是有取舍的,我们不会记住每时每刻发生的所有事,会…

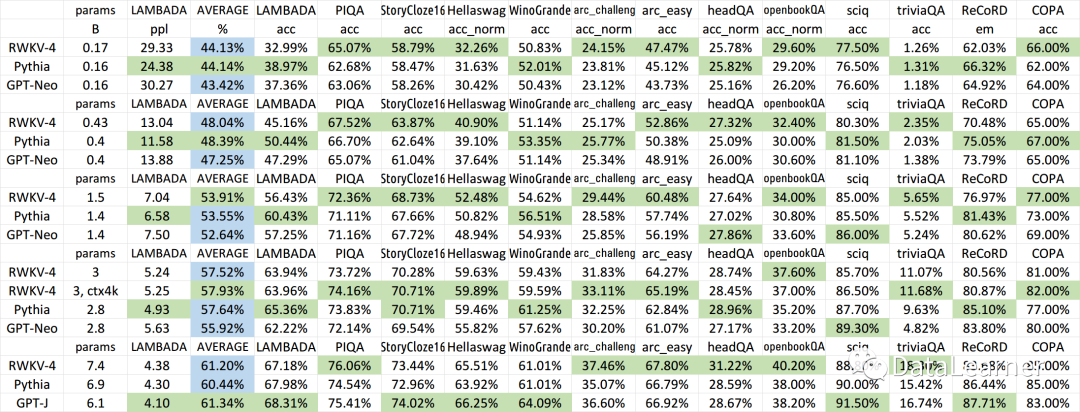

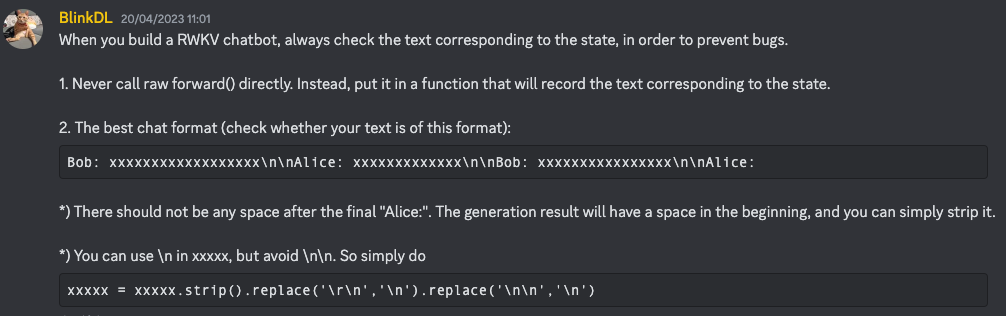

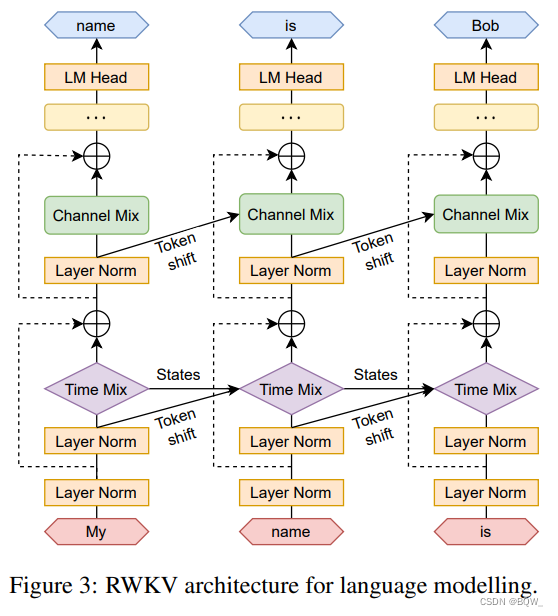

HF宣布在transformers库中引入首个RNN模型:RWKV,一个结合了RNN与Transformer双重优点的模型

RWKV是一个结合了RNN与Transformer双重优点的模型架构。由香港大学物理系毕业的彭博首次提出。简单来说,RWKV是一个RNN架构的模型,但是可以像transformer一样高效训练。今天,HuggingFace官方宣布在transformers库中首次引入RNN这样的模型&…

RNN和LSTM学习笔记-初学者

提示: 目录 前言一、RNN介绍二、LSTM介绍总结 前言

提示: 提示:

一、RNN介绍 RNN是一种短时记忆,而LSTM是长短时记忆网络

二、LSTM介绍 总结

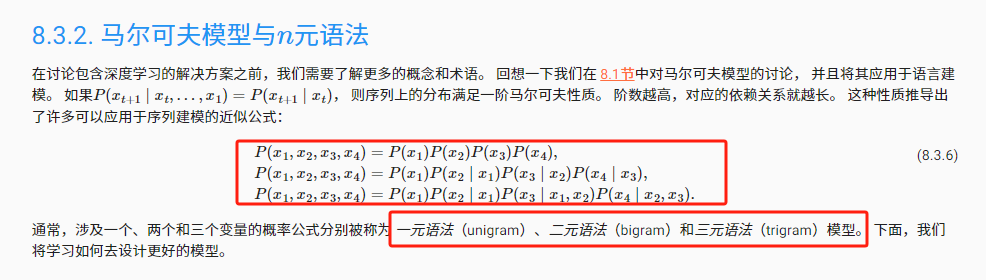

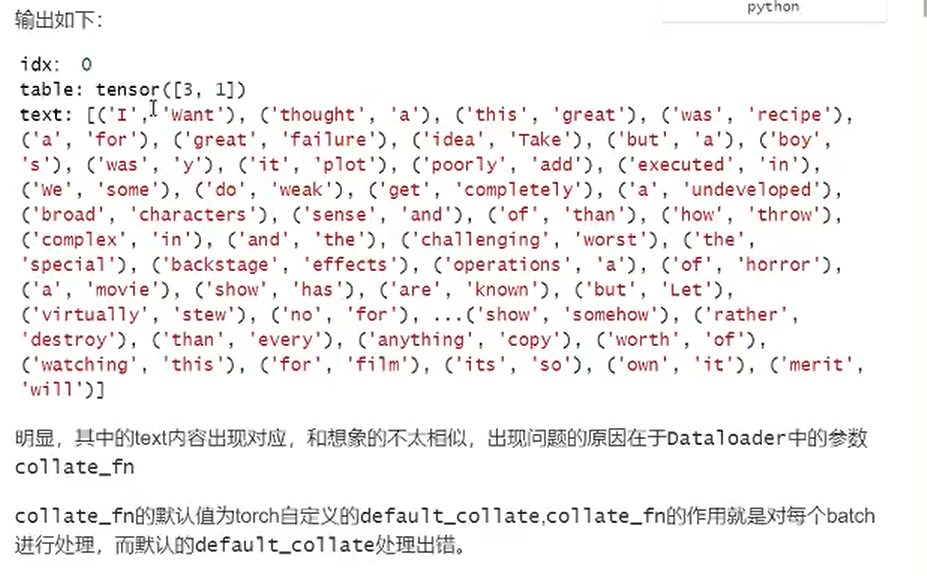

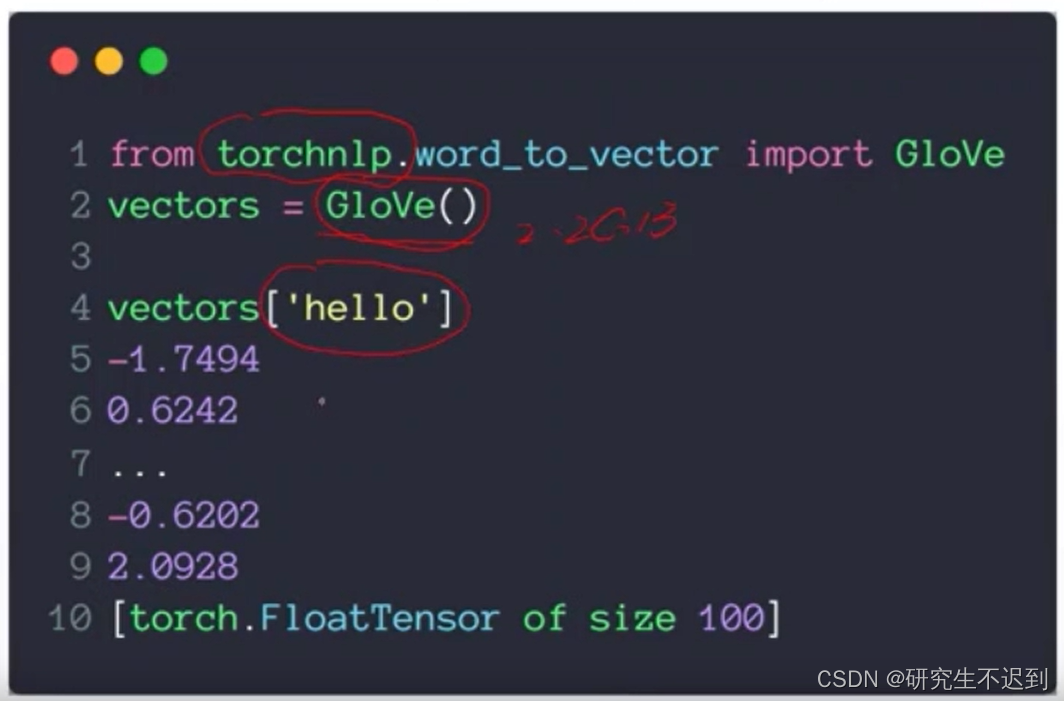

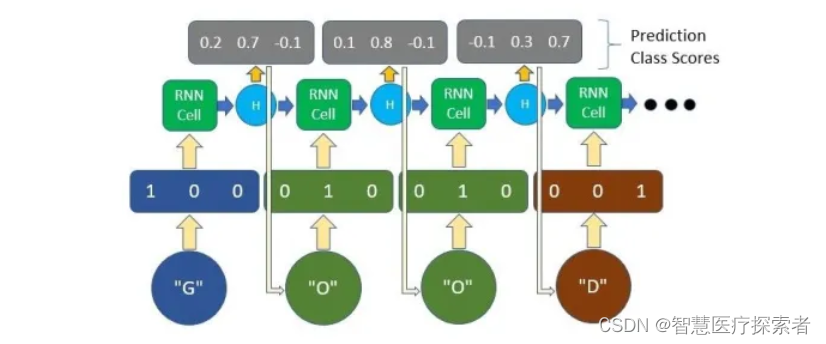

Pytorch深度学习——循环神经网络基础 (07)

文章目录1 RNN第一部分1.1 概念和工具介绍1.2 N-garm表示方法2 文本转换为向量2.1 one-hot2.2 word embedding2.3 word embedding API2.4 数据的形状变化3 举例:文本情感分类3.1 数据集3.2 思路分析3.3 准备数据集3.4 综上代码3.5 分词操作3.6 DataLoader中collate_…

现代循环神经网络实战:机器翻译

专栏:神经网络复现目录

机器翻译

机器翻译是一种利用计算机技术将一种语言的文本自动翻译成另一种语言的过程。机器翻译技术旨在解决语言障碍问题,使不同语言之间的交流更加便捷。机器翻译使用的算法包括统计机器翻译、神经机器翻译等。机器翻译技术已…

使神经网络具有记忆力——RNN及LSTM

我们在进行判断决策时,除了会依据当前的情况,也会调动大脑中的记忆,协同分析。记忆分为长期记忆和短期记忆,短期记忆可以认为是对之前较短时间内发生事件的印象,这对于一些日常生活应用非常的有必要。比如以下两个句子…

TensorFlow-Keras 10.CNN+RNN 处理文本序列-温度预测问题

一.引言

上一篇文章基础文本处理 processing && embedding 介绍了常用的文本处理方法,趁热打铁了解一下处理连续文本的 demo 流程。 二.数据信息与获取

下面例子将用到气象记录站的天气时间序列,数据集中每10分钟记录14个不同的指标࿰…

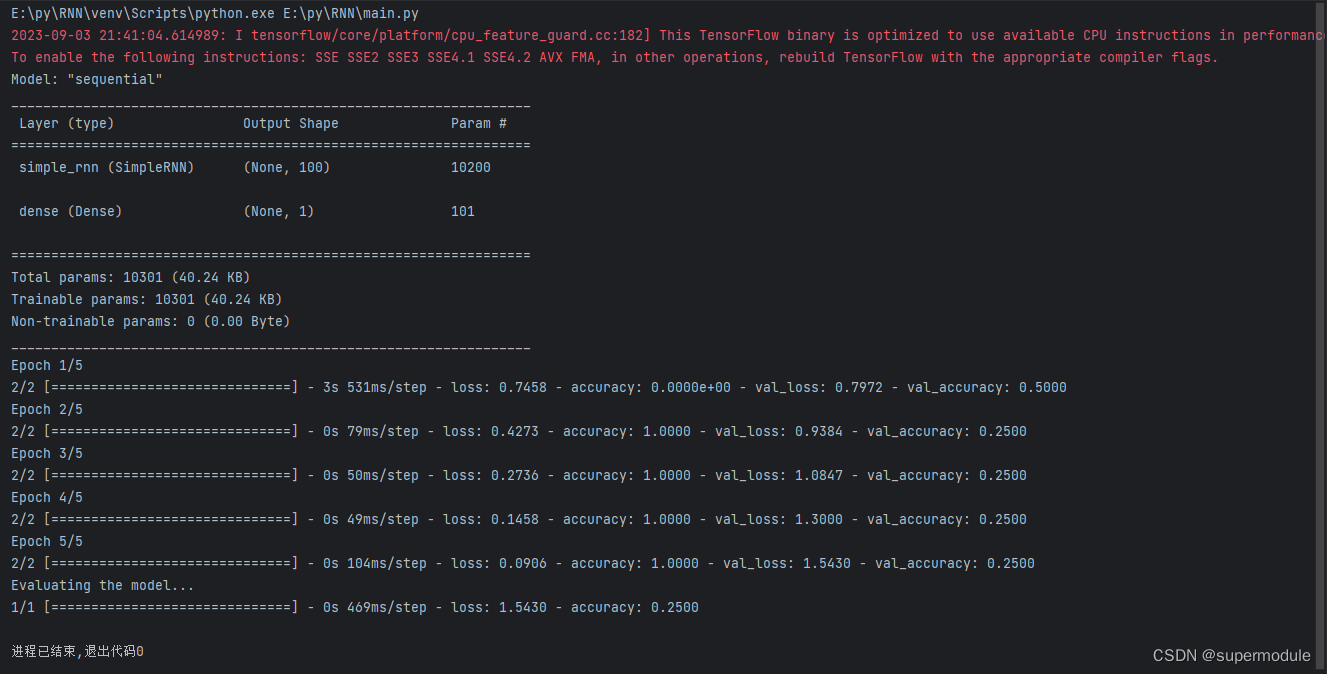

NLP之搭建RNN神经网络

文章目录 代码展示代码意图代码解读知识点介绍1. Embedding2. SimpleRNN3. Dense 代码展示

# 构建RNN神经网络

from tensorflow.keras.models import Sequential

from tensorflow.keras.layers import Dense, SimpleRNN, Embedding

import tensorflow as tfrnn Sequential()

…

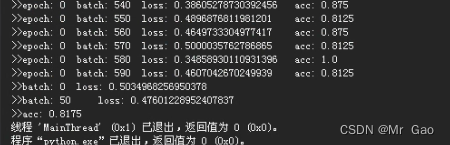

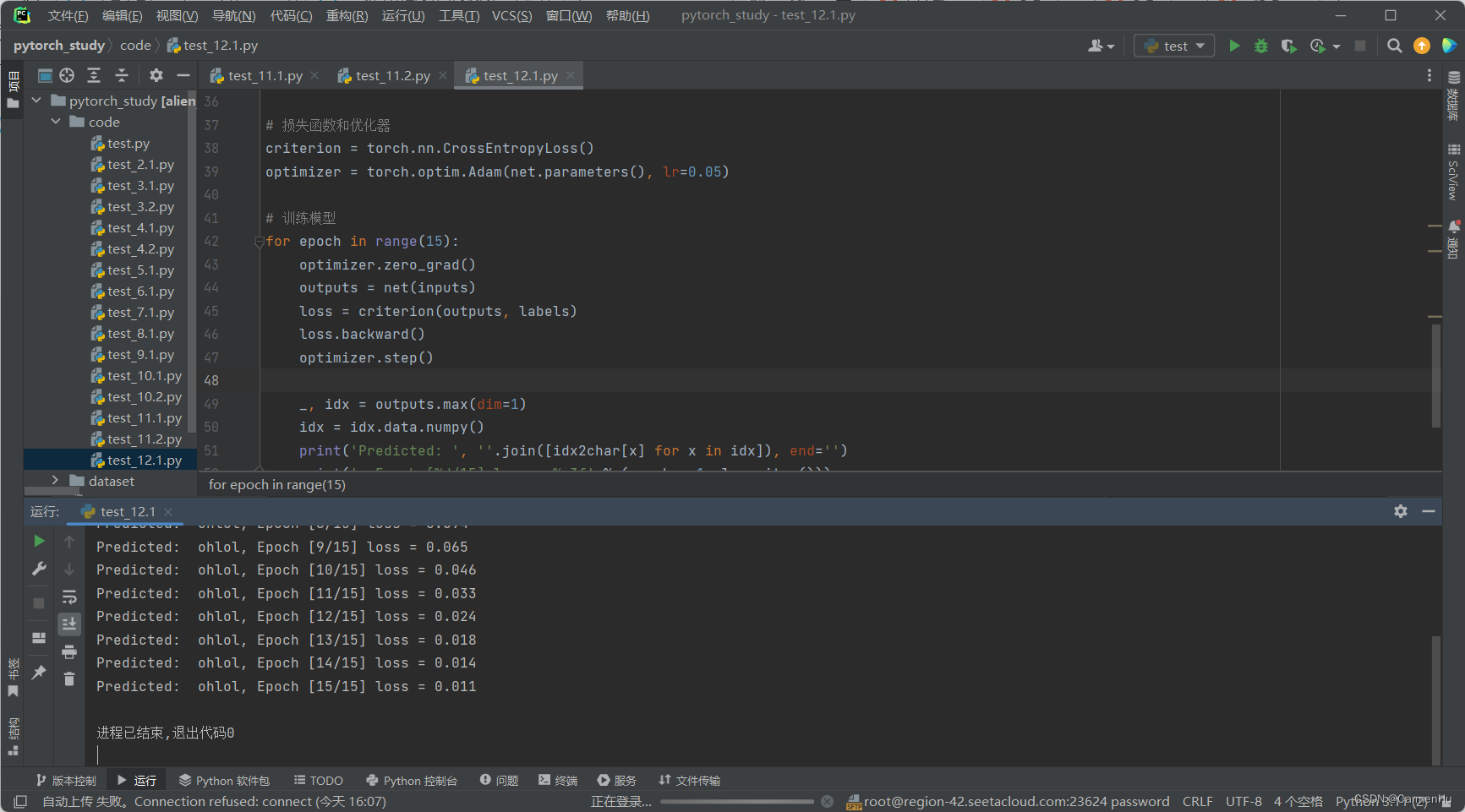

【深度学习实验】循环神经网络(一):循环神经网络(RNN)模型的实现与梯度裁剪

目录

一、实验介绍

二、实验环境

1. 配置虚拟环境

2. 库版本介绍

三、实验内容

0. 导入必要的工具包

1. 数据处理

2. rnn

测试

3. grad_clipping

4. 代码整合 经验是智慧之父,记忆是智慧之母。 ——谚语 一、实验介绍 本实验介绍了一个简单的循环神经网络…

人工智能-循环神经网络的简洁实现

循环神经网络的简洁实现

如何使用深度学习框架的高级API提供的函数更有效地实现相同的语言模型。 我们仍然从读取时光机器数据集开始。

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2lbatch_size, num_steps 32, 35…

深度学习与自然语言处理(8)_斯坦福cs224d RNN,MV-RNN与RNTN

原文作者:Richard Socher 翻译:胥可 && 熊杰 && 杨帆 && 陈沛 && Molly 校对调整:寒小阳 && 龙心尘 时间:2016年7月 出处: http://blog.csdn.net/han_xiaoyang/article/…

C++元编程——深度双向RNN实验

使用C的标准库实现了双向RNN的功能。最近对DRNN做了一些改进,同时进行了实验,首先DRNN的代码如下:

#ifndef _RNN_HPP_

#define _RNN_HPP_

#include <stdio.h>

#include <stdlib.h>

#include <vector>

#include "mat.…

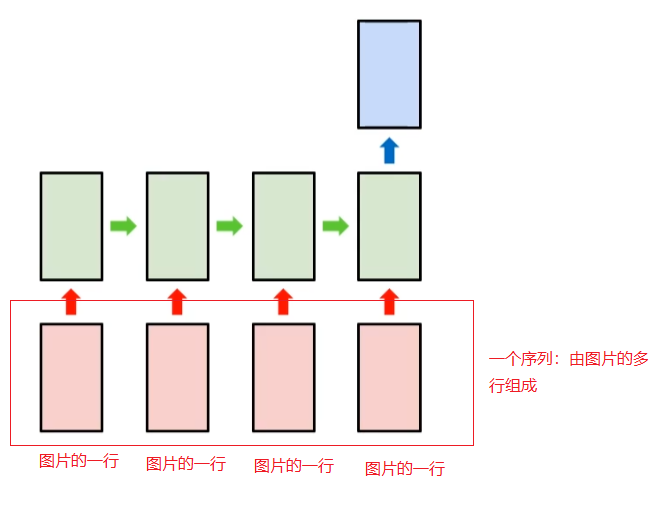

pytorch_神经网络构建4

文章目录 循环神经网络LSTM词嵌入skip-Gram模型N-Gram模型词性预测RNN循环神经网络的基础模块实现RNN识别图片RNN时间序列预测词向量模块词向量运用N-Gram模型lstm词性预测 循环神经网络

这个网络主要用来处理序列信息,之前处理图片时大部分是分析图片的结构信息, 什么是序列信…

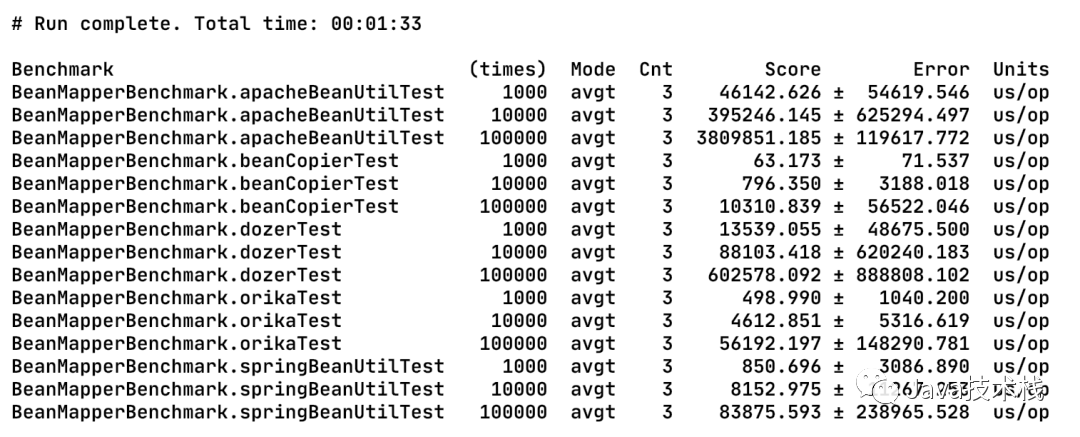

BeanUtils、BeanCopier、Dozer、Orika 哪个性能最强?

来源:https://albenw.github.io/posts/f6a7daea/背景在分层的代码架构中,层与层之间的对象避免不了要做很多转换、赋值等操作,这些操作重复且繁琐,于是乎催生出很多工具来优雅,高效地完成这个操作,有BeanUt…

DeepLearning AI-序列模型-第一周

为什么要序列模型

语音识别 输入是声音,输出文字

音乐生成 输入是空或者首个音符,输出一首音乐音符

情感打分 输入一段评论,输出是星级

机器翻译 输出一种语言的文字,输出另一种语言的文字

动作识别 输入连续的多帧图片&…

RNN循环神经网络(recurrent neural network)

自己开发了一个股票智能分析软件,功能很强大,需要的点击下面的链接获取:

https://www.cnblogs.com/bclshuai/p/11380657.html

1.1 RNN循环神经网络(recurrent neural network)

1.1.1 RNN简介

RNN循环神经…

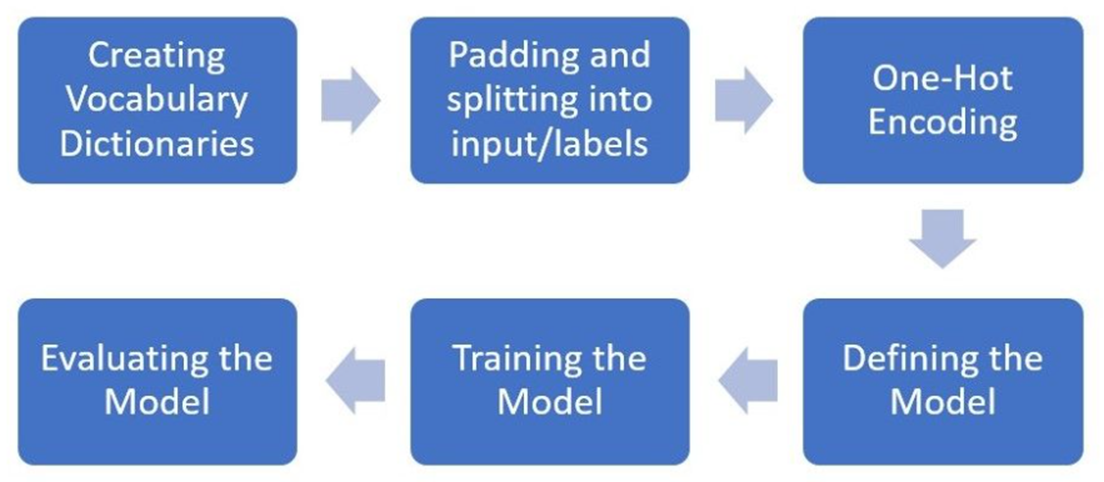

python pytorch实现RNN,LSTM,GRU,文本情感分类

python pytorch实现RNN,LSTM,GRU,文本情感分类

数据集格式: 有需要的可以联系我

实现步骤就是: 1.先对句子进行分词并构建词表 2.生成word2id 3.构建模型 4.训练模型 5.测试模型

代码如下: import pandas as pd

im…

【nlp】2.1 认识RNN模型

认识RNN模型 1 什么是RNN模型2 RNN模型的作用3 RNN模型的分类:1 什么是RNN模型

RNN(Recurrent Neural Network),,中文称作循环神经网络,它一般以序列数据为输入, 通过网络内部的结构设计有效捕捉序列之间的关系特征,一般也是以序列形式进行输出。

一般单层神经网络结构:…

循环神经网络的变体模型-LSTM、GRU

一.LSTM(长短时记忆网络)

1.1基本介绍

长短时记忆网络(Long Short-Term Memory,LSTM)是一种深度学习模型,属于循环神经网络(Recurrent Neural Network,RNN)的一种变体。…

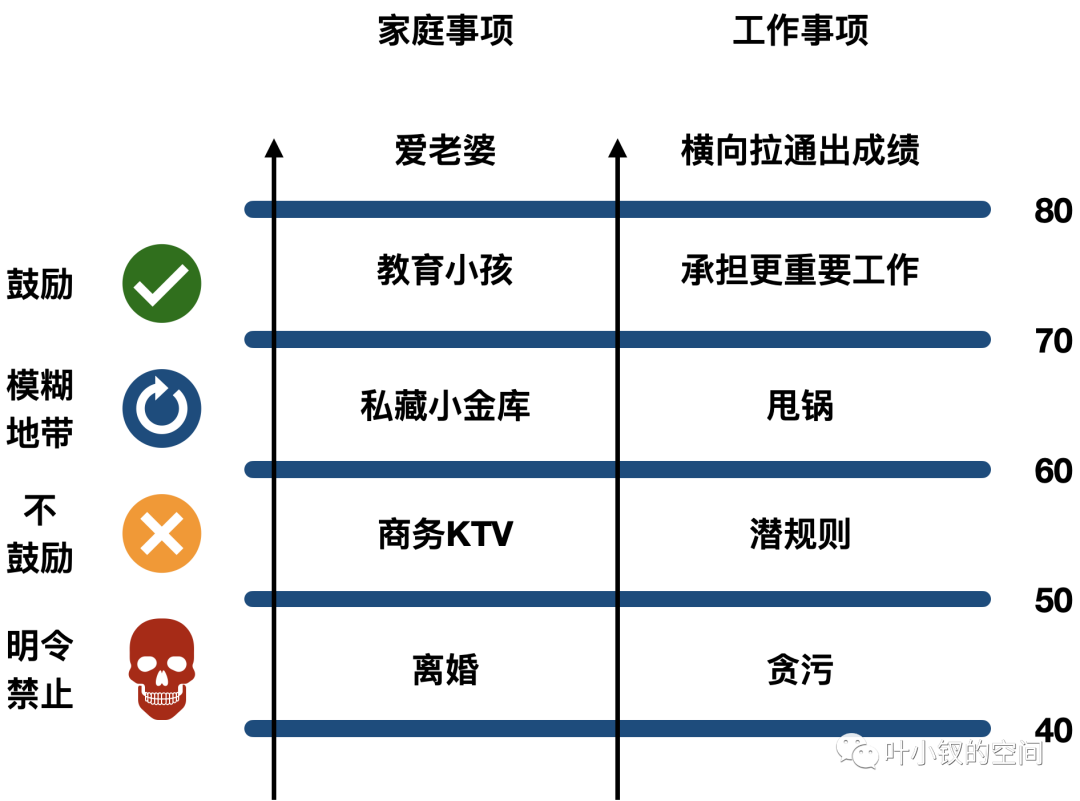

不要让“破事”、“烂人”毁了你的工作

本文更多的是个人认知,有不足请批评。之前讨论管理五维模型(新晋总监生存指南开篇之总监二三事)时提到了一个属性“持之以恒”:持之以恒其实更不好测量,更多的是一个品质,但如果没有这种坚持的能力…

RNN:Recurrent Neural Network(上)

目录

1 为什么提出 RNN

1.1 什么是 Slot Filling

1.2 为什么 FFN 做不好 Slot Filling

1.3 为什么 RNN 能做好 Slot Filling

2 RNN 的整体结构

3 更高级的 RNN 结构

3.1 Deep RNN

3.2 Elman Network & Jordan Network

3.3 Bidirectional RNN 原视频&…

(PyTorch)TCN和RNN/LSTM/GRU结合实现时间序列预测

目录 I. 前言II. TCNIII. TCN-RNN/LSTM/GRU3.1 TCN-RNN3.2 TCN-LSTM3.3 TCN-GRU IV. 实验结果 I. 前言

前面已经写了一系列有关LSTM时间序列预测的文章:

深入理解PyTorch中LSTM的输入和输出(从input输入到Linear输出)PyTorch搭建LSTM实现时…

NLP中的RNN、Seq2Seq与attention注意力机制

目录

NLP自然语言处理 的RNN、Seq2Seq与attention注意力机制

RNN循环神经网络

前馈网络入门

前馈网络

循环网络

多层感知器架构示例

循环神经网络的运作原理

展开 RNN

seq2seq模型

Attention(注意力机制)

总结

引用 NLP自然语言处理 的RNN、…

【AI】深度学习——循环神经网络

神经元不仅接收其他神经元的信息,也能接收自身的信息。 循环神经网络(Recurrent Neural Network,RNN)是一类具有短期记忆能力的神经网络,可以更方便地建模长时间间隔的相关性 常用的参数学习可以为BPTT。当输入序列比较…

从零开始完整实现-循环神经网络RNN

一 简介

使用 pytorch 搭建循环神经网络RNN,循环神经网络(Recurrent Neural Network,RNN)是一类用于 处理序列数据的神经网络架构。与传统神经网络不同,RNN 具有内部循环结构,可以在处理序列数据时保持状态…

【nlp】2.5 人名分类器实战项目(对比RNN、LSTM、GRU模型)

人名分类器实战项目 0 项目说明1 案例介绍2 案例步骤2.1 导入必备的工具包2.2 数据预处理2.2.1 获取常用的字符数量2.2.2 国家名种类数和个数2.2.3 读数据到python环境中2.2.4 构建数据源NameClassDataset2.2.5 构建迭代器遍历数据2.3 构建RNN及其变体模型2.3.1 构建RNN模型2.3…

TensorFlow2实战-系列教程11:RNN文本分类3

🧡💛💚TensorFlow2实战-系列教程 总目录 有任何问题欢迎在下面留言 本篇文章的代码运行界面均在Jupyter Notebook中进行 本篇文章配套的代码资源已经上传 6、构建训练数据

所有的输入样本必须都是相同shape(文本长度,…

循环神经网络(一)(文本预处理,分词,独热编码,词嵌入,keras 代码)

文章目录文本预处理One-hot 编码词嵌入从原始文本到数据集References循环神经网络(recurrent neural network,RNN)是一类用于处理序列数据的神经网络。RNN 在序列数据的每一个位置上具有相同的结构(因此是“循环”的)&…

深度学习-循环神经网络-RNN实现股价预测-LSTM自动生成文本

序列模型(Sequence Model) 基于文本内容及其前后信息进行预测 基于目标不同时刻状态进行预测 基于数据历史信息进行预测 序列模型:输入或者输出中包含有序列数据的模型 突出数据的前后序列关系 两大特点: 输入(输出)元素之间是具有顺序关系。不同的顺序,得到的结果应…

回归算法|长短期记忆网络LSTM及其优化实现

本期文章将介绍LSTM的原理及其优化实现 序列数据有一个特点,即“没有曾经的过去则不存在当前的现状”,这类数据以时间为纽带,将无数个历史事件串联,构成了当前状态,这种时间构筑起来的事件前后依赖关系称其为时间依赖&…

NLP之多循环神经网络情感分析

文章目录 代码展示代码意图代码解读知识点介绍 代码展示

import pandas as pd

import tensorflow as tf# 构建RNN神经网络

tf.random.set_seed(1)

df pd.read_csv("../data/Clothing Reviews.csv")

print(df.info())df[Review Text] df[Review Text].astype(str)

…

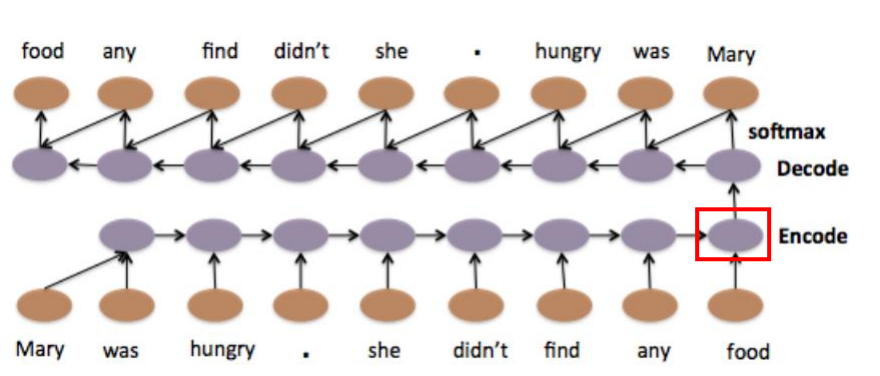

Seq2Seq模型详解

Seq2Seq

在RNN模型需要解决的问题中,有一类N v M的问题,即输入输出不等长问题。例如Machine Translation、Summarization就是这类问题的一些经典粒例子。这种结构又叫做Seq2Seq模型,或者叫Encoder-Decoder模型。

Intuition

我们以机器翻译…

国庆中秋特辑(一)浪漫祝福方式 用循环神经网络(RNN)或长短时记忆网络(LSTM)生成祝福诗词

目录 一、使用深度学习中的循环神经网络(RNN)或长短时记忆网络(LSTM)生成诗词二、优化:使用双向 LSTM 或 GRU 单元来更好地捕捉上下文信息三、优化:使用生成对抗网络(GAN)或其他技术…

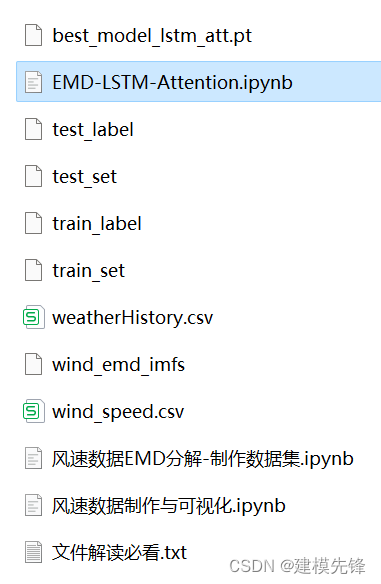

风速预测(三)EMD-LSTM-Attention模型

目录

1 风速数据EMD分解与可视化

1.1 导入数据

1.2 EMD分解

2 数据集制作与预处理

2.1 先划分数据集,按照8:2划分训练集和测试集

2.2 设置滑动窗口大小为7,制作数据集

3 基于Pytorch的EMD-LSTM-Attention模型预测

3.1 数据加载&#…

G1D1-复习RNN基础

好久不用csdn了,看到有人关注我啦hh突然想继续更一更啦

一、RNN基础复习

做了一点rnn的复习~好久不看了,都忘了。 1、预测股票 复习了一下rnn:比如,对于股票预测来说,其实整体的data是1-60天的股票数据,训…

《动手学深度学习 Pytorch版》 8.5 循环神经网络的从零开始实现

%matplotlib inline

import math

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2lbatch_size, num_steps 32, 35

train_iter, vocab d2l.load_data_time_machine(batch_size, num_steps) # 仍然使用时间机器数据集8.…

深度学习05-RNN循环神经网络

概述

循环神经网络(Recurrent Neural Network,RNN)是一种具有循环连接的神经网络结构,被广泛应用于自然语言处理、语音识别、时序数据分析等任务中。相较于传统神经网络,RNN的主要特点在于它可以处理序列数据…

02- pytorch 实现 RNN

一 导包

import torch

from torch import nn

from torch.nn import functional as F

import dltools

1.1 导入训练数据

batch_size, num_steps 32, 35

# 更改了默认的文件下载方式,需要将 article 文件放入该文件夹

train_iter, vocab dltools.load_data_time_…

【文本到上下文 #5】:RNN、LSTM 和 GRU

一、说明 欢迎来到“完整的 NLP 指南:文本到上下文 #5”,这是我们对自然语言处理 (NLP) 和深度学习的持续探索。从NLP的基础知识到机器学习应用程序,我们现在深入研究了神经网络的复杂世界及其处理语言的深刻能力。 在…

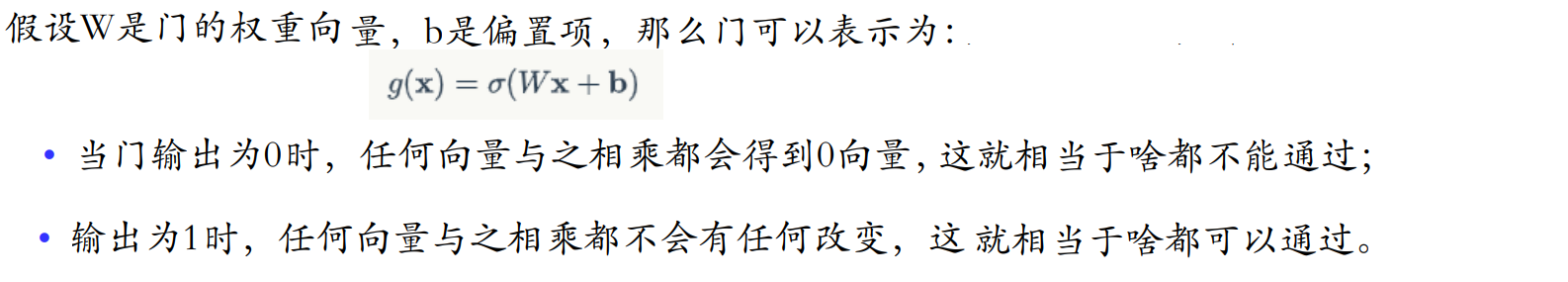

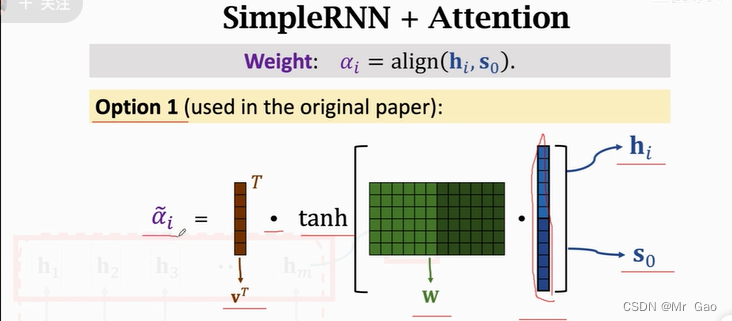

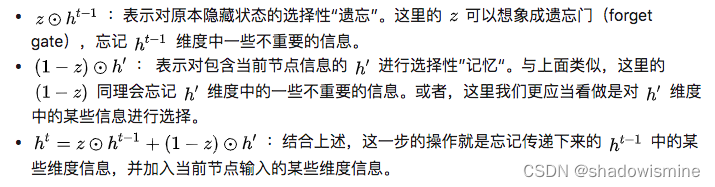

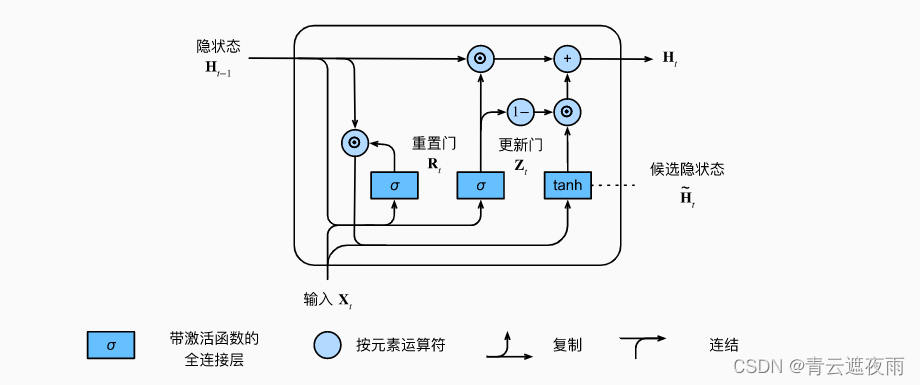

现代循环神经网络-门控循环单元(GRU)

理论

门控隐状态

门控循环单元与普通的循环神经网络之间的关键区别在于: 前者支持隐状态的门控。 这意味着模型有专门的机制来确定应该何时更新隐状态, 以及应该何时重置隐状态。 这些机制是可学习的,并且能够解决了上面列出的问题。 例如&…

循环神经网络(三)(常用循环神经网络,LSTM、GRU)

文章目录长短期记忆网络(LSTM)模型定义模型特点门控循环单元网络(GRU)模型定义模型特点References长短期记忆网络(LSTM)

模型定义

简单循环神经网络(S-RNN)的每一个位置的状态以递…

解密长短时记忆网络(LSTM):从理论到PyTorch实战演示

目录 1. LSTM的背景人工神经网络的进化循环神经网络(RNN)的局限性LSTM的提出背景 2. LSTM的基础理论2.1 LSTM的数学原理遗忘门(Forget Gate)输入门(Input Gate)记忆单元(Cell State)…

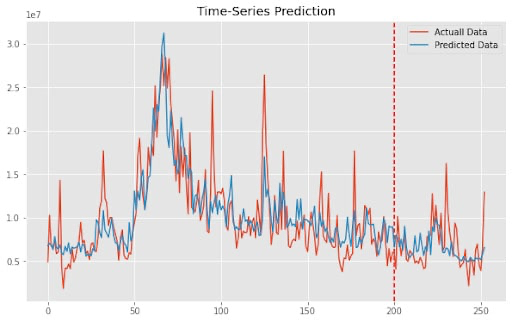

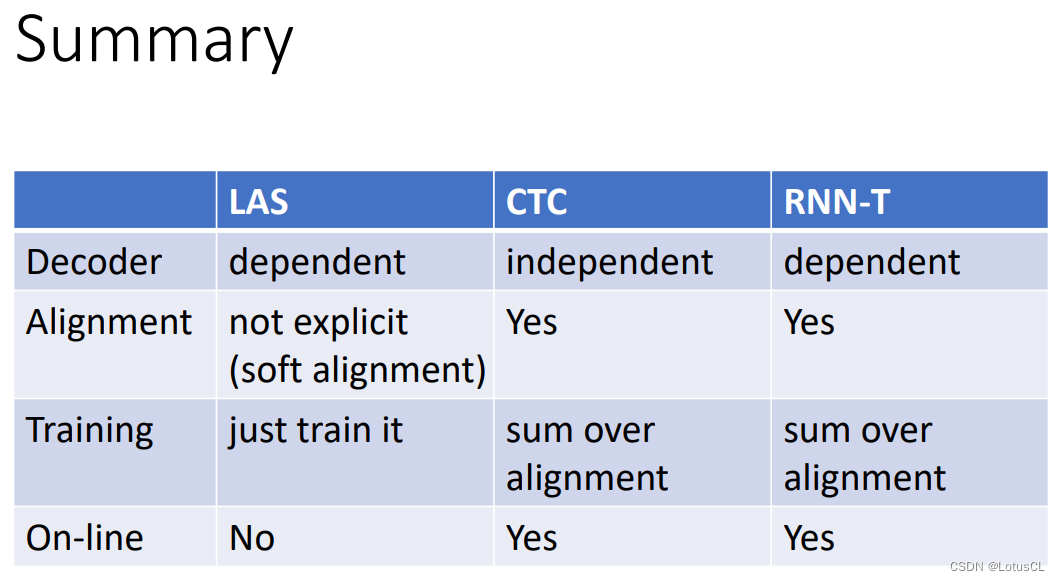

Alignment of HMM, CTC and RNN-T,对齐方式详解——语音信号处理学习(三)(选修二)

参考文献: Speech Recognition (option) - Alignment of HMM, CTC and RNN-T哔哩哔哩bilibili 2020 年 3月 新番 李宏毅 人类语言处理 独家笔记 Alignment - 7 - 知乎 (zhihu.com) 本次省略所有引用论文 目录

一、E2E 模型和 CTC、RNN-T 的区别

E2E 模型的思路

C…

【学习笔记】Understanding LSTM Networks

Understanding LSTM Networks 前言Recurrent Neural NetworksThe Problem of Long-Term DependenciesLSTM Networks The Core Idea Behind LSTMsStep-by-Step LSTM Walk ThroughForget Gate LayerInput Gate LayerOutput Gate Layer Variants on Long Short Term MemoryConclus…

[代码实践]利用LSTM构建基于conll2003数据集的命名实体实体识别NER模型

1. conll2003数据集介绍以及数据集预处理请看下面博客

conll2003数据集下载与预处理_茫茫人海一粒沙的博客-CSDN博客

2. 取预处理过的数据集

import tensorflow as tf

from keras.models import Model

from keras.layers import Input, Embedding, LSTM, Dense, TimeDistrib…

RNN循环神经网络(深入浅出)

文章目录 1. 什么是RNNRNN(递归神经网络)简介RNN 的关键特性RNN 的结构RNN 的应用RNN 的局限性总结 2. RNN的结构1. 基本单元2. 输入、隐藏状态和输出3. 权重矩阵4. 循环结构5. 展开过程6. 变体总结 1. 什么是RNN

很高兴为您解释什么是 RNN(…

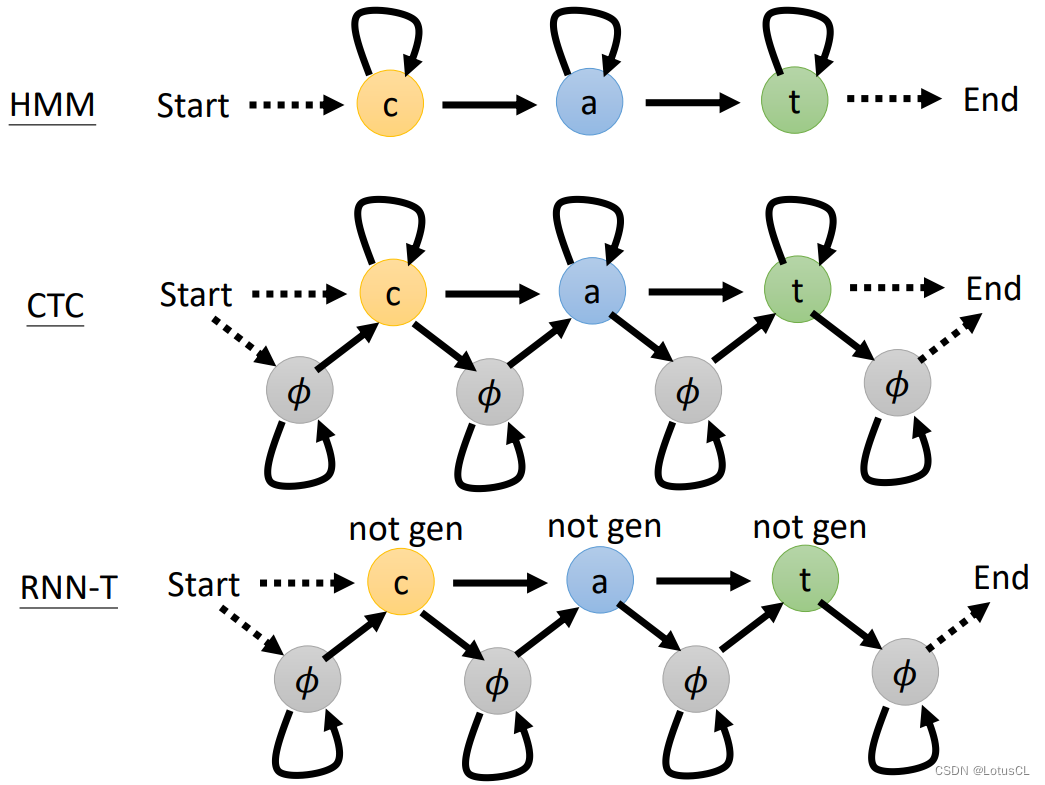

NLP 学习笔记十-simple RNN+attention(注意力机制)

NLP 学习笔记十-simple RNNattention(注意力机制)

感兴趣的伙伴,看这个笔记,最好从头开始看哈,而且我的笔记,其实不面向零基础,最好有过一些实践经历的来看最好。 紧接上一回,我们谈…

王树森《RNN Transformer》系列公开课

本课程主要介绍NLP相关,包括RNN、LSTM、Attention、Transformer、BERT等模型,以及情感识别、文本生成、机器翻译等应用

ShusenWang的个人空间-ShusenWang个人主页-哔哩哔哩视频 (bilibili.com) (一)NLP基础

1、数据处理基础

数…

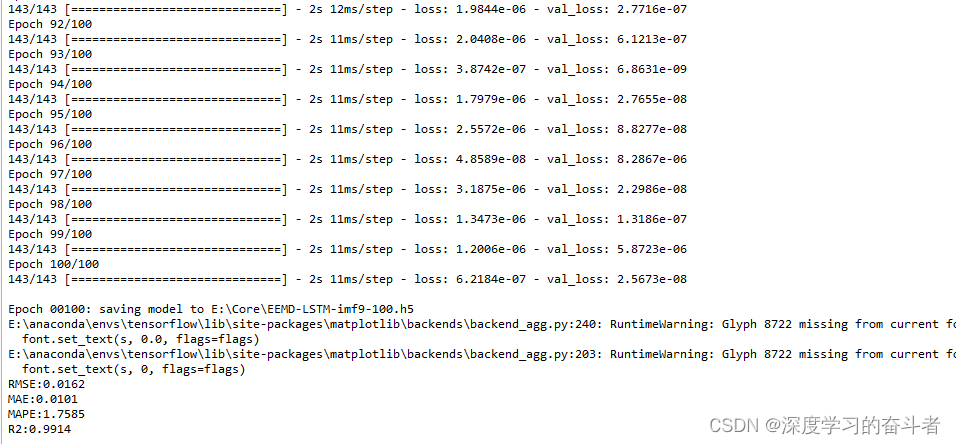

时序数据利用EEMD_LSTM模型进行预测(Python编程,数据集和代码均在压缩包,解压缩后可以直接运行,数据可以替换为股票数据,交通流量等时序数据)

运行效果(为减少录屏时间,视频中epoch设置为30,改为100效果更佳):利用EEMD_LSTM模型对时序数据进行预测(视频中epoch为30,当为100 的时候效果更佳)_哔哩哔哩_bilibili

1.数据介绍:以每天为间隔的时序数据 …

人工智能|机器学习——循环神经网络的简洁实现

循环神经网络的简洁实现 如何使用深度学习框架的高级API提供的函数更有效地实现相同的语言模型。 我们仍然从读取时光机器数据集开始。 import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2lbatch_size, num_steps 32, 35

t…

机器学习入门--循环神经网络原理与实践

循环神经网络

循环神经网络(RNN)是一种在序列数据上表现出色的人工神经网络。相比于传统前馈神经网络,RNN更加适合处理时间序列数据,如音频信号、自然语言和股票价格等。本文将介绍RNN的基本数学原理、使用PyTorch和Scikit-Learn…

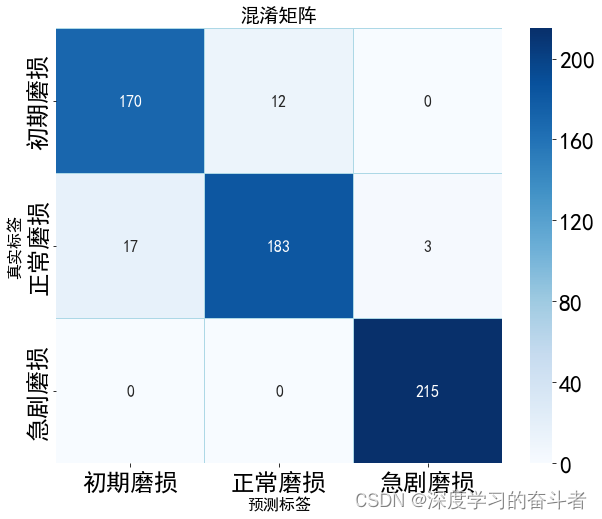

刀具磨损状态识别(Python代码,MSCNN_LSTM_Attention模型,初期磨损、正常磨损和急剧磨损分类,解压缩直接运行)

1.运行效果:刀具磨损状态识别(Python代码,MSCNN_LSTM_Attention模型,初期磨损、正常磨损和急剧磨损)_哔哩哔哩_bilibili

环境库:

NumPy 版本: 1.19.4 Pandas 版本: 0.23.4 Matplotlib 版本: 2.2.3 Keras …

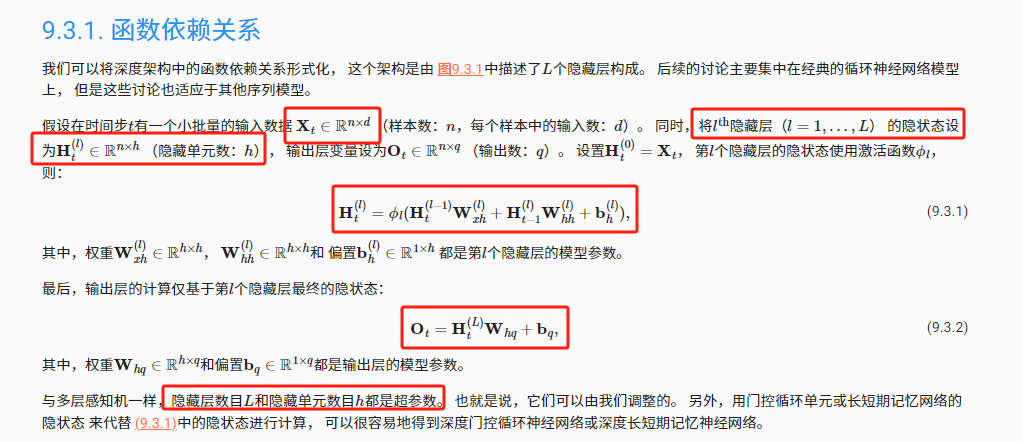

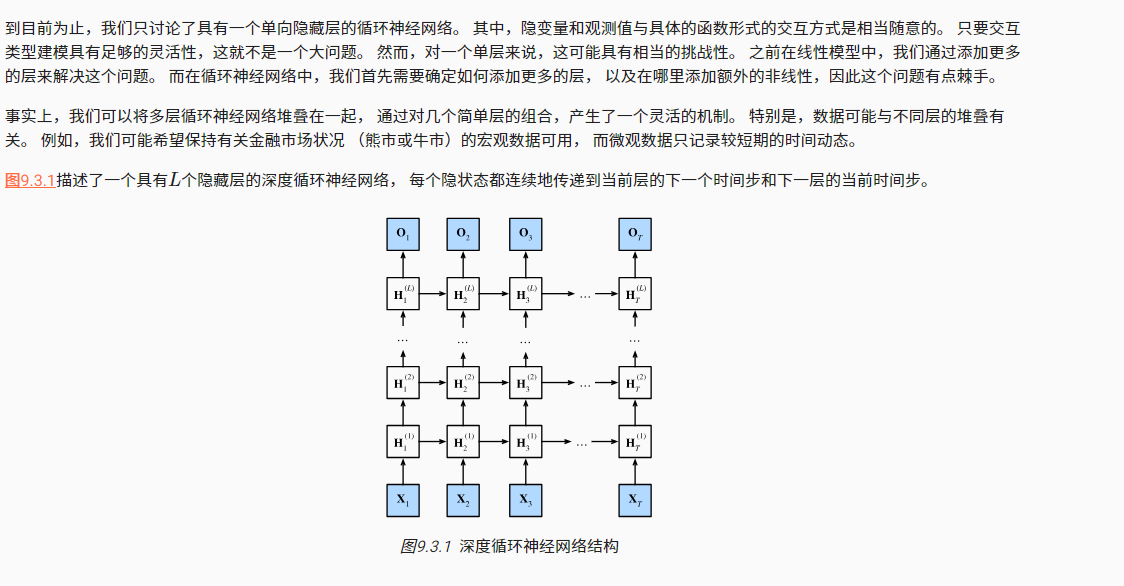

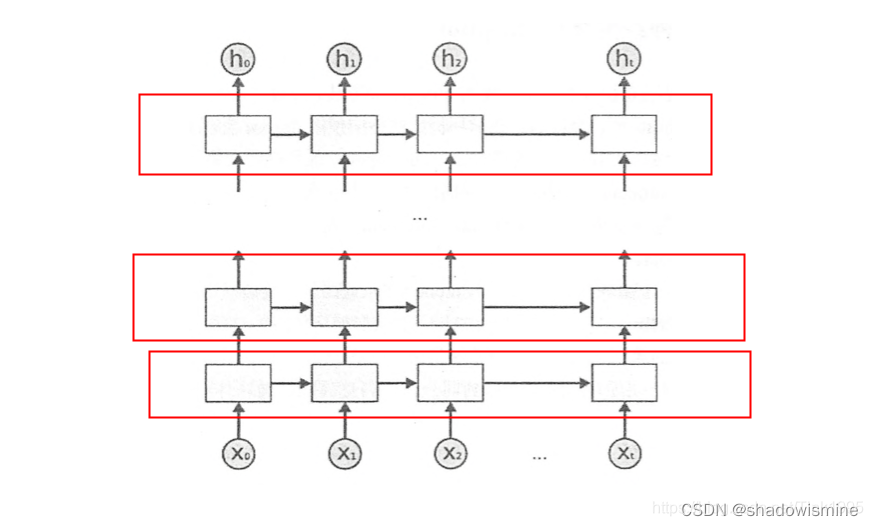

《动手学深度学习 Pytorch版》 9.3 深度循环神经网络

将多层循环神经网络堆叠在一起,通过对几个简单层的组合,产生一个灵活的机制。其中的数据可能与不同层的堆叠有关。 9.3.1 函数依赖关系

将深度架构中的函数依赖关系形式化,第 l l l 个隐藏层的隐状态表达式为: H t ( l ) ϕ l …

【深度学习实验】循环神经网络(四):基于 LSTM 的语言模型训练

目录

一、实验介绍

二、实验环境

1. 配置虚拟环境

2. 库版本介绍

三、实验内容

0. 导入必要的工具包

1. RNN与梯度裁剪

2. LSTM模型

3. 训练函数

a. train_epoch

b. train

4. 文本预测

5. GPU判断函数

6. 训练与测试

7. 代码整合 经验是智慧之父,记忆…

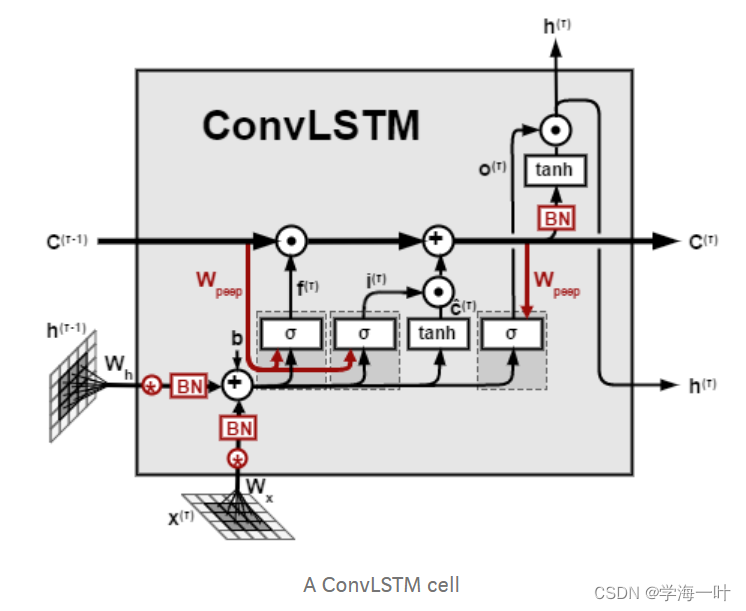

时间序列预测系列之循环神经网络

文章目录 1.前言2.RNN基础组件1.RNN2.LSTM3.GRU4.FC-LSTM5.ConvLSTM6.CNN-LSTM 1.前言

循环神经网络(Recurrent Neural Network,简称RNN)是一类在处理序列数据和时间序列数据时非常有用的神经网络架构。RNN的主要特点是它们具有循环连接&…

时间序列学习(2)——【循环神经网络基本原理】

文章目录1 介绍一个简单的案例1.1 主要思想1.2 模型缺点1.3 提出需求1 介绍一个简单的案例

淘宝处理好评还是差评 1.1 主要思想 在此之前,我们已经在 时间序列学习(1) 的学习中,掌握了用GloVe来把单词转换成一个100d的词向量。 …

时间序列学习(1)——【时间序列初认识】

文章目录1 时序数据的表示sequence representation2 举个时序数据的例子3 举一个图片数据的例子4 词向量表示4.1 one-hot 编码方式5 一次Batch 的数据结构重组6 nn.embedding 集成好的查表操作7 下载GloVe来表示词向量1 时序数据的表示sequence representation

序列的表示&…

使用循环神经网络预测温度

简介 本文以天气时间序列数据集为例,讨论如何使用深度学习模型预测未来天气温度。

使用的是由德国耶拿马克思普朗克生物地球化学研究所的气象站记录。

数据每10分钟记录一次,共记录14种不同的量,如气温、气压、湿度、风向等,原始…

LSTM已死,Transformer永生(面试问答RNN/LSTM/Transformer)

计算机视觉面试题-Transformer相关问题总结:https://zhuanlan.zhihu.com/p/554814230 计算机视觉面试31题 CV面试考点,精准详尽解析:https://zhuanlan.zhihu.com/p/257883797

1. 循环神经网络(Recurrent Neural Networks, RNN&am…

CNN(卷积神经网络)、RNN(循环神经网络)、DNN(深度神经网络)的内部网络结构有什么区别?

【导师不教?我来教!】同济计算机博士半小时就教会了我五大深度神经网络,CNN/RNN/GAN/transformer/LSTM一次学会,简直不要太强!_哔哩哔哩_bilibili了解的五大神经网络,整理笔记如下:

视频是唐宇…

【机器学习10】循环神经网络

1循环神经网络

RNN通过将神经元串行起来处理序列化的数据。 由于每个神经元能用它的内部变量保存之前输入的序列信息,因此整个序列被浓缩成抽象的表示, 并可以据此进行分类或生成新的序列。

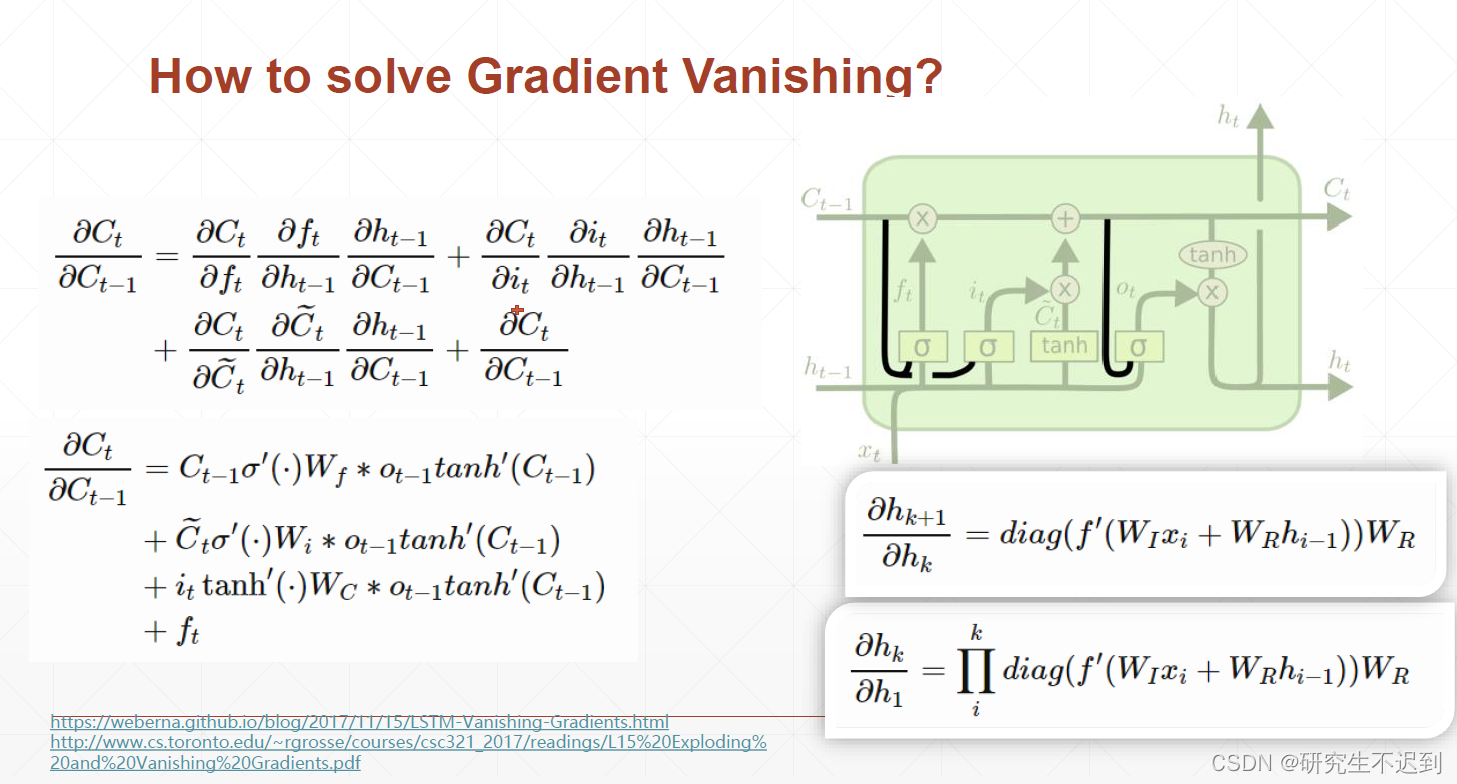

2 循环神经网络的梯度消失或梯度爆炸问题

传统的循环神经网…

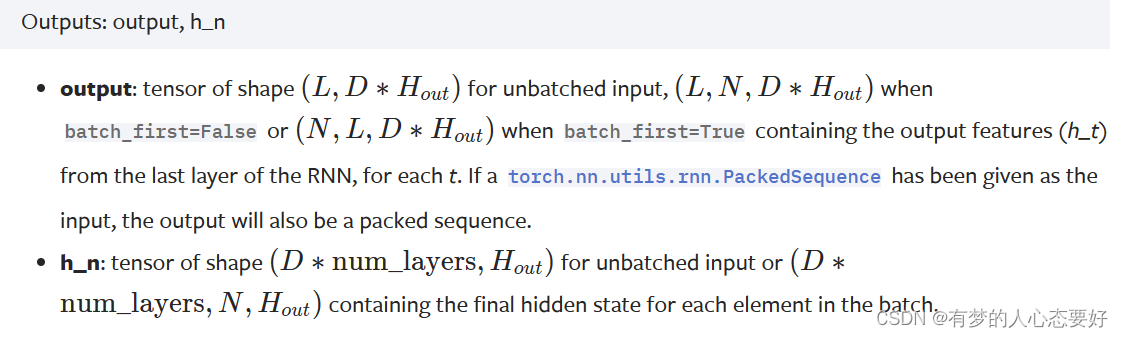

笔记53:torch.nn.rnn() 函数详解

参数解释:

(1)input_size():即输入信息 Xt 的每个序列的独热编码向量的长度,即 len(vocab)

(2)hidden_size():即隐变量 h 的维度(维度是多少,就代表用几个数…

LSTM 与 GRU

RNN无法处理长距离依赖问题,通俗点就是不能处理一些较长的序列数据,那么今天就来介绍一下两个能处理长距离依赖问题地RNN变种结构,LSTM和GRU。

1. LSTM(Long short-term memory)

1.1 LSTM结构 上左图是普通RNN结构图…

BPTT算法 / LSTM的细胞状态和隐藏状态 / GRU

1:BPTT: 其实就是BP算法正常的链式推导展开,只是因为它涉及到了之前时刻的ht输出,所以将时间信息给带进去了;而这也是为什么说RNN不能很好的保存长期记忆的原因,因为偏导的连乘,长期的记忆被不断的缩小,很容…

Pytorch intermediate(四) Language Model (RNN-LM)

前一篇中介绍了一种双向的递归神经网络,将数据进行正序输入和倒序输入,兼顾向前的语义以及向后的语义,从而达到更好的分类效果。 之前的两篇使用递归神经网络做的是分类,可以发现做分类时我们不需要使用时序输入过程中产生的输出&…

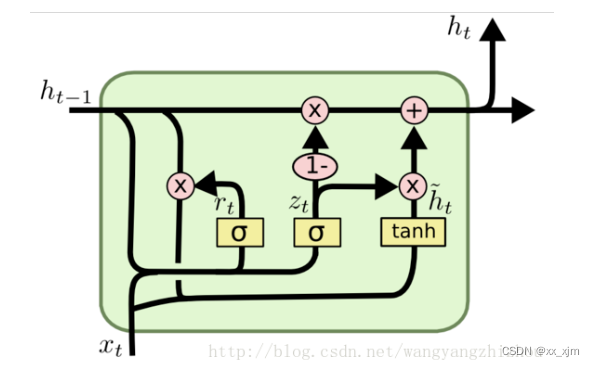

NLP(1)--NLP基础与自注意力机制

目录

一、词向量

1、概述

2、向量表示

二、词向量离散表示

1、one-hot

2、Bag of words

3、TF-IDF表示

4、Bi-gram和N-gram

三、词向量分布式表示

1、Skip-Gram表示

2、CBOW表示

四、RNN

五、Seq2Seq 六、自注意力机制

1、注意力机制和自注意力机制

2、单个输出…

RNN与反向传播算法(BPTT)的理解

RNN是序列建模的强大工具。 今天主要搬运两天来看到的关于RNN的很好的文章:

Anyone Can Learn To Code an LSTM-RNN in Python (Part 1: RNN) 这个博客相当赞,从Toy Code学习确实是个很好的方法(便于理解抓住核心)!。…

人工智能超分辨率重建:揭秘图像的高清奇迹

导言 人工智能超分辨率重建技术,作为图像处理领域的一项重要创新,旨在通过智能算法提升图像的分辨率,带来更为清晰和细致的视觉体验。本文将深入研究人工智能在超分辨率重建方面的原理、应用以及技术挑战。

1. 超分辨率重建的基本原理 …

Pytorch实现RNN预测模型并使用C++相应的ONNX模型推理

Pytorch实现RNN模型

代码

import torch

import torch.nn as nnclass RNN(nn.Module):def __init__(self, seq_len, input_size, hidden_size, output_size, num_layers, device):super(RNN, self).__init__()self._seq_len seq_lenself._input_size input_sizeself._output…

深度学习4. 循环神经网络 – Recurrent Neural Network | RNN

目录

循环神经网络 – Recurrent Neural Network | RNN

为什么需要 RNN ?独特价值是什么?

RNN 的基本原理

RNN 的优化算法

RNN 到 LSTM – 长短期记忆网络

从 LSTM 到 GRU

RNN 的应用和使用场景

总结

百度百科维基百科 循环神经网络 – Recurre…

RNN模型与NLP应用(1/9):数据处理基础Data Processing Basics

文章目录 处理分类特征把分类特征转化为数值特征应用one-hot编码indice要从1开始而不能从0开始数据处理为什么使用one-hot向量 处理文本数据Step1:将文本分割成单词Step2:计算单词的频度按频度递减的方式排序 Step3:One-Hot编码 处理分类特征…

时间序列预测实战(二十四)PyTorch实现RNN进行多元和单元预测(附代码+数据集+完整解析)

一、本文介绍

本篇文章给大家带来的是利用我个人编写的架构进行RNN时间序列卷积进行时间序列建模(专门为了时间序列领域新人编写的架构,简单且不同于市面上大家用GPT写的代码),包括结果可视化、支持单元预测、多元预测、模型拟合…

深度学习的十大核心算法

引言

深度学习是人工智能领域中最热门和最具影响力的分支之一。其核心在于通过构建复杂的神经网络模型,从大量的数据中自动学习并提取出有用的特征,从而实现各种高级的任务,如图像识别、自然语言处理等。本文将介绍深度学习中的十大核心算法…

RNN Seq2Seq

Feedforward v.s. Recurrent

Feedforward network does not have input at each stepFeedforward network has different parameters for each layer 双向RNN 双向递归层可以提供更好的识别预测效果,但却不能实时预测,由于反向递归的计算需要从最末时刻…

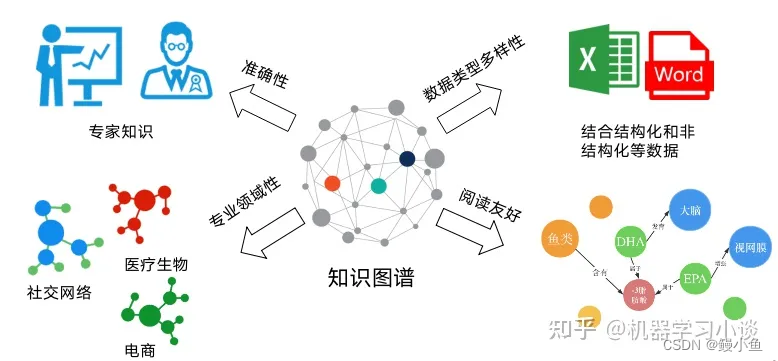

人工智能知识图谱:智慧连接的未来

导言 人工智能知识图谱作为知识管理和智能推理的重要工具,正在为人工智能领域带来革命性的变化。本文将深入研究人工智能知识图谱的发展、技术特点以及对多领域的深远影响。

1. 背景与定义 人工智能知识图谱是一个庞大的知识网络,将实体、关系、…

神经网络NLP基础 循环神经网络 LSTM

用的时候,只关心token的输入,以及hidden state就好了 sequence的length是多少,lstm的cell的数量就是多少

LSTM BI-LSTM stacked lstm GRU 实现

pytorch RNN

RNN

from torch import nn

import torch

# # 表示feature_len=100(如每个单词用100维向量表示), hidden_len=10(隐藏单元的尺寸)

# rnn = nn.RNN(100, 10,1,batch_first=True)

# # odict_keys([weight_ih_l0, weight_hh_l0, bias_ih_l0, bias_hh_l0])

# print(rnn._parameters…

RWKV – transformer 与 RNN 的强强联合

在 NLP (Natural Language Processing, 自然语言处理) 领域,ChatGPT 和其他的聊天机器人应用引起了极大的关注。每个社区为构建自己的应用,也都在持续地寻求强大、可靠的开源模型。自 Vaswani 等人于 2017 年首次提出 Attention Is All You Need 之后&am…

59 双向循环神经网络【动手学深度学习v2】

59 双向循环神经网络【动手学深度学习v2】 深度学习学习笔记 学习视频:https://www.bilibili.com/video/BV12X4y1c71W/?spm_id_fromautoNext&vd_source75dce036dc8244310435eaf03de4e330 核心思想:取决于过去和未来的上下文,来预测当前的…

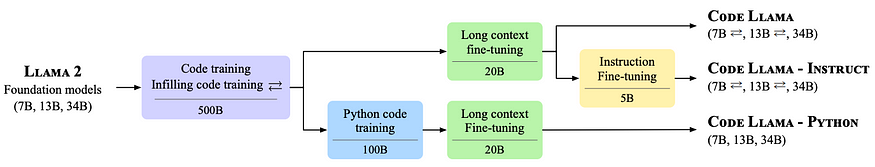

破解密码 LLM(代码LLM如何从 RNN 发展到 Transformer)

舒巴姆阿加瓦尔 一、说明 近年来,随着 Transformer 的引入,语言模型发生了显着的演变,它彻底改变了我们执行日常任务的方式,例如编写电子邮件、创建文档、搜索网络甚至编码方式。随着研究人员在代码智能任务中应用大型语言模型&am…

LSTM(长短期记忆网络)的设计灵感和数学表达式

1、设计灵感 LSTM(长短期记忆网络)的设计灵感来源于传统的人工神经网络在处理序列数据时存在的问题,特别是梯度消失和梯度爆炸的问题。 在传统的RNN(循环神经网络)中,信息在网络中的传递是通过隐状态向量进…

043、循环神经网络

之——RNN基础 杂谈 第一个对于序列模型的网络,RNN。 正文

1.潜变量自回归模型 潜变量总结过去的信息,再和当前信息一起结合出新的信息。 2.RNN 循环神经网络将观察作为x,与前层隐变量结合得到输出 其中Whh蕴含了整个模型的时序信息…

RNN 相比于前馈神经网络的优势。

相比于前馈神经网络(Feedforward Neural Network),循环神经网络(Recurrent Neural Network,RNN)具有以下优势: 处理序列数据:RNN是一种专门用于处理序列数据的神经网络结构。它能够通…

LSTM和GRU vs 循环神经网络RNN

1、考虑下列三种情况下,对比一下普通RNN的表现和LSTM和GRU表现:

(1)早期观测值对预测未来观测者具有非常重要的意义。 考虑一个极端情况,其中第一个观测值包含一个校验和, 目标是在序列的末尾辨别校验和是…

第87步 时间序列建模实战:LSTM回归建模

基于WIN10的64位系统演示

一、写在前面

这一期,我们介绍大名鼎鼎的LSTM回归。

同样,这里使用这个数据:

《PLoS One》2015年一篇题目为《Comparison of Two Hybrid Models for Forecasting the Incidence of Hemorrhagic Fever with Renal…

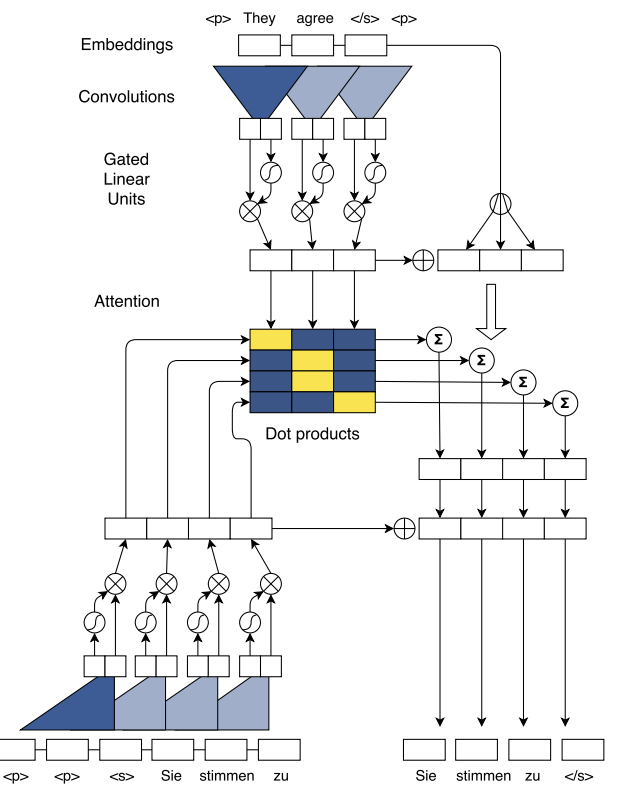

Transformer实战-系列教程1:Transformer算法解读

现在最火的AI内容,chatGPT、视觉大模型、研究课题、项目应用现在都是Transformer大趋势了

1、传统的RNN Transformer是基于RNN改进提出的,RNN不同于CNN、MLP是一个需要逐个计算的结构来进行分类回归的任务,它的每一个循环单元不仅仅要接受当…

PyTorch翻译官网教程-NLP FROM SCRATCH: CLASSIFYING NAMES WITH A CHARACTER-LEVEL RNN

官网链接

NLP From Scratch: Classifying Names with a Character-Level RNN — PyTorch Tutorials 2.0.1cu117 documentation 使用CHARACTER-LEVEL RNN 对名字分类

我们将建立和训练一个基本的字符级递归神经网络(RNN)来分类单词。本教程以及另外两个“from scratch”的自然…

【深度学习--RNN 循环神经网络--附LSTM情感文本分类】

deep learning 系列 --RNN 循环神经网络

什么是序列模型

包括了RNN LSTM GRU等网络模型,主要用途是自然语言处理、语音识别等方面,比如生成乐曲,音频转换为文字,文本情感分类,机器翻译等等

标准模型的缺陷

以往的标…

RNN以及其改进版(附2个代码案列)

感谢阅读RNN简介传统RNN内部结构过程演示内部计算公式RNN輸出激活函数tanhPytorch构建传统RNN梯度计算LSTM介绍遗忘门结构分析:输入门结构分析:细胞状态更新分析:输出门结构分析:结构图梯度公式现实生活列子加强理解代码示例GRU介绍结构图个人对GRU的理解LSTM难以比…

基于RNN系列的人名分类器【数据处理-训练-预测-评估-调优】

基于RNN系列的人名分类器第一步:导入必备工具包第二步:数据处理文本信息规范化编码第三步:构建RNN系列网络RNN网络LSTM网络GRU网络第四步:构建模型训练RNN训练函数LSTM训练函数GRU训练函数第五步:训练模型第六步&#…

【nlp】2.5(cpu version) 人名分类器实战项目(对比RNN、LSTM、GRU模型)

人名分类器实战项目 0 项目说明1 案例介绍2 案例步骤2.1 导入必备的工具包2.2 数据预处理2.2.1 获取常用的字符数量2.2.2 国家名种类数和个数2.2.3 读数据到python环境中2.2.4 构建数据源NameClassDataset2.2.5 构建迭代器遍历数据2.3 构建RNN及其变体模型2.3.1 构建RNN模型2.3…

循环神经网络(RNN)实现股票预测

文章目录 一、前言二、前期工作1. 设置GPU(如果使用的是CPU可以忽略这步)2. 导入数据 四、数据预处理1.归一化2.设置测试集训练集 五、构建模型六、激活模型七、训练模型八、结果可视化1.绘制loss图2.预测3.评估 一、前言

我的环境:

语言环…

pytorch学习-7:RNN 循环神经网络 (分类)

pytorch学习-7:RNN 循环神经网络(分类)1. 加载MNIST手写数据1.1 数据预处理2. RNN模型建立3. 训练4. 预测参考循环神经网络让神经网络有了记忆, 对于序列话的数据,循环神经网络能达到更好的效果.

1. 加载MNIST手写数据

import torch

from t…

工智能基础知识总结--什么是RNN

什么是RNN RNN(循环神经网络)是一种用于处理时序数据的特殊结构的神经网络。所谓时序数据,是指句子、语音、股票这类具有时间顺序或者是逻辑顺序的序列数据。 RNN的折叠图和展开图为: RNN的参数为U、W和V三个矩阵,其中U为输出到隐藏层的参数矩阵,W为上一个时刻到当前时刻…

【深度学习】深度学习实验四——循环神经网络(RNN)、dataloader、长短期记忆网络(LSTM)、门控循环单元(GRU)、超参数对比

一、实验内容

实验内容包含要进行什么实验,实验的目的是什么,实验用到的算法及其原理的简单介绍。

1.1 循环神经网络

(1)理解序列数据处理方法,补全面向对象编程中的缺失代码,并使用torch自带数据工具将数据封装为dataloader。 (2)分别采用手动方式以及调用接口方式…

时间序列学习(6)——LSTM中Layer的使用

文章目录1 复习一下 nn.RNN 的参数2 LSTM的 __init__函数3 LSTM.forward()4 动手写一个简单的lstm层1 复习一下 nn.RNN 的参数

参数介绍:

(1)input_size : The number of expected features in the input x (x的特征…

机器学习常识 22: 循环神经网络

摘要: 循环神经网络 (Recurrent Neural Network, RNN) 用于处理序列数据.

本贴以前的算法, 我都用 Java 代码实现过. 很遗憾, 从本贴开始, 就只知道一点概念了.

1. 动机

序列数据中, 前后数据之间不是独立的, 而是会产生上下文影响. 如:

文本, 机器翻译一个句子的时候, 不是…

十四、Pytorch实现RNN Classifier

一、项目需求

数据集:姓名和对应的国籍 要求:输入一个姓名,通过模型可以得到TA所属的国籍 数据集下载:name_country_datasets

二、思路步骤分析

①准备数据集

将下载好的数据集解压,放到一个指定的位置,…

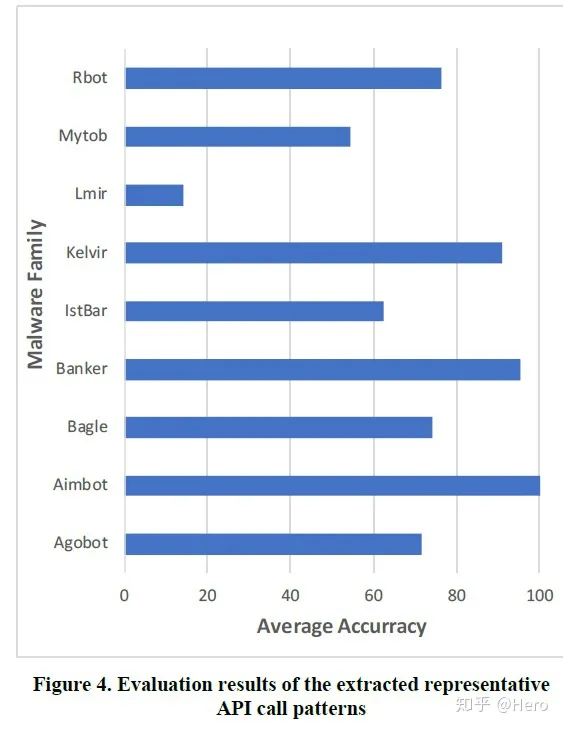

Paper: 利用RNN来提取恶意软件家族的API调用模式

论文 摘要

恶意软件家族分类是预测恶意软件特征的好方法,因为属于同一家族的恶意软件往往有相似的行为特征恶意软件检测或分类方法分静态分析和动态分析两种: 静态分析基于恶意软件中包含的特定签名进行分析,优点是分析的范围覆盖了整个代码…

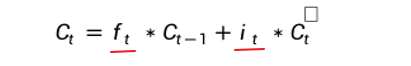

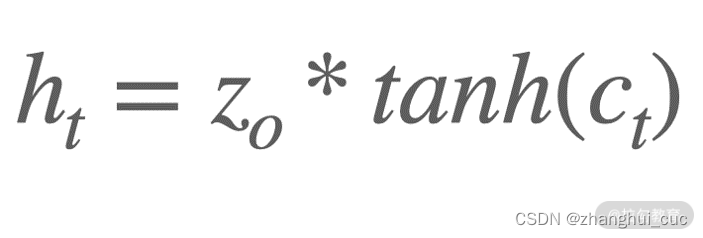

时间序列学习(5)——LSTM 基本原理

文章目录1 从 RNN 说起2 RNN的缺点,为什么要引入LSTM3 介绍LSTM 的门结构3.1 遗忘门(遗忘阶段)3.2 输入门3.3 相加得到 Ct3.4 输出门3.5 总结公式推导4 为什么LSTM能够解决Gradient Vanishing的问题1 从 RNN 说起 循环神经网络Recurrent Neur…

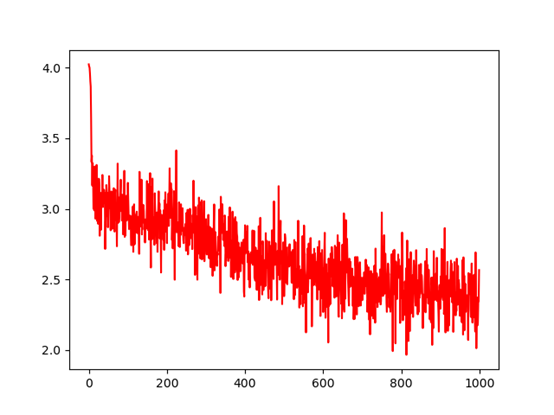

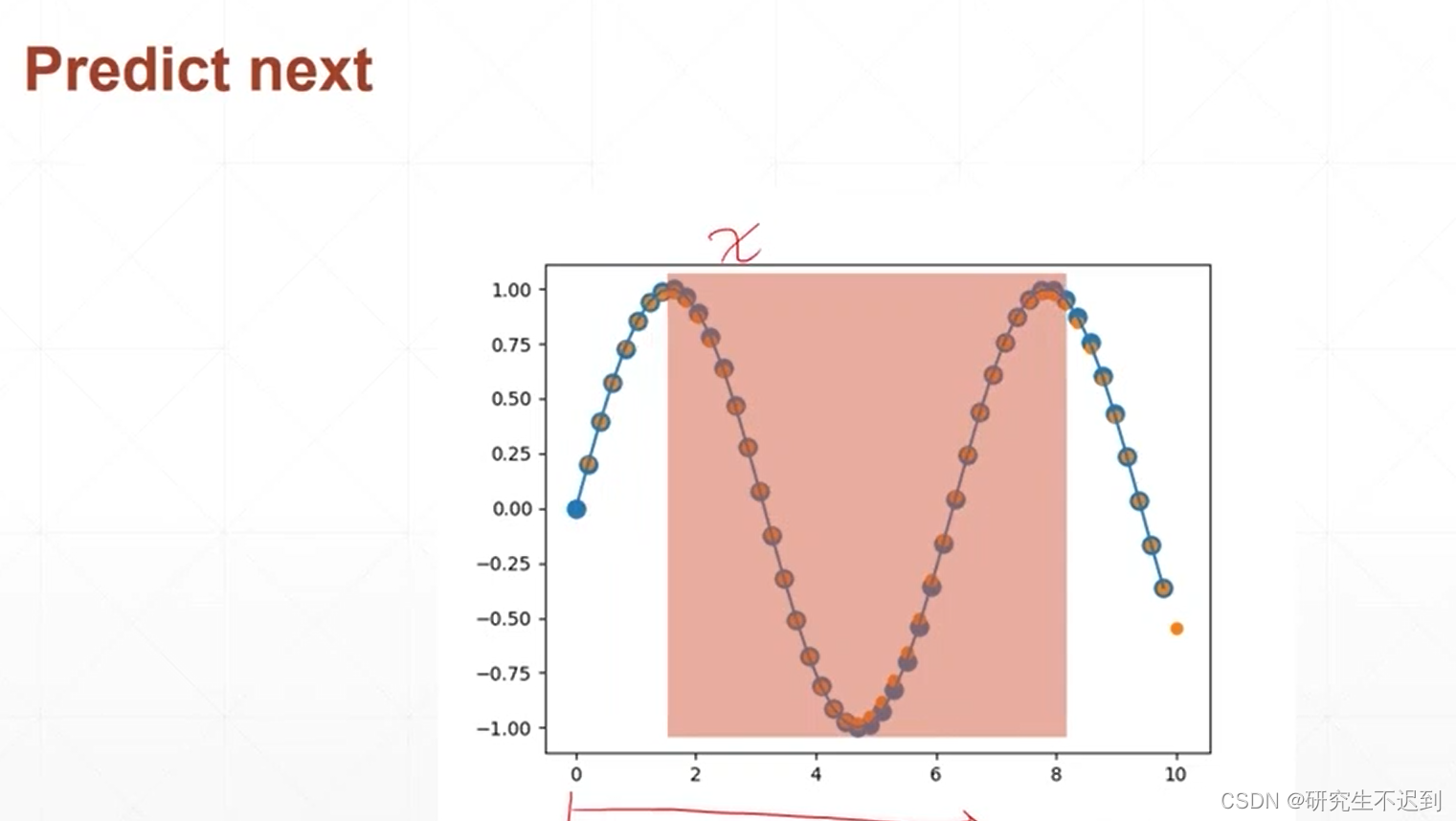

时间序列学习(4)——【正弦函数预测,RNN,代码+详解】非常清楚,强烈推荐

文章目录1 问题描述2 数据处理部分2.1 np.random.randint()2.2 np.linspace()2.3 最终的数据情况3 模型介绍3.1 模型代码3.2 介绍 __init__ 函数3.3 介绍forward函数4 模型训练部分4.1 同数据处理部分4.2 喂数据给模型、计算loss、梯度更新,反向传播5 模型预测部分5…

时间序列学习(3)——【循环神经网络中layer的使用】

文章目录1 输入数据的维度表示2 介绍nn.RNN2.1 __init__函数2.2 out, ht forward(x, h0)3 单层single layer RNN3.1 分析 输出out的shape3.2 分析 输出h 的shape4 多个RNN 层4 简单时序预测问题本文记录学习循环神经网络layer 使用,是时间序列学习(3&am…

葫芦书笔记----循环神经网络(RNN)

循环神经网络

循环神经网络(RNN)是用来建模序列化数据的一种主流深度学习模型。

##循环神经网络和卷积神经网络

速记:循环圣经网络可以很好地处理文本数据变长并且有序的输入序列

详细:RNN可以将前面阅读到的有用信息编码到状…

NLP-D26--RNN+感到代码能力提高

—0441今天终结掉沐沐的代码,就可以看宝可梦的nlp了!!!加油!

1、reshape(-1)的用法 将数组铺平。 参考:https://blog.51cto.com/u_13977270/3395824 2、这一部分还挺难理解的,k步推理横纵坐标。…

NLP-D28-深度Bi循环神经网络| 翻译模型与预测模型之预处理|data.DataLoader(*arrays)|encoder-decoder|*args**kwargs

----0530虽然昨天1点才睡,但是早上5点就行醒了,除了眼睛有点不适之外,没什么别的感觉。今天打算先把毕业设计的视频录一下,然后就可以把沐沐 的课和代码看完了,然后!!!终于ÿ…

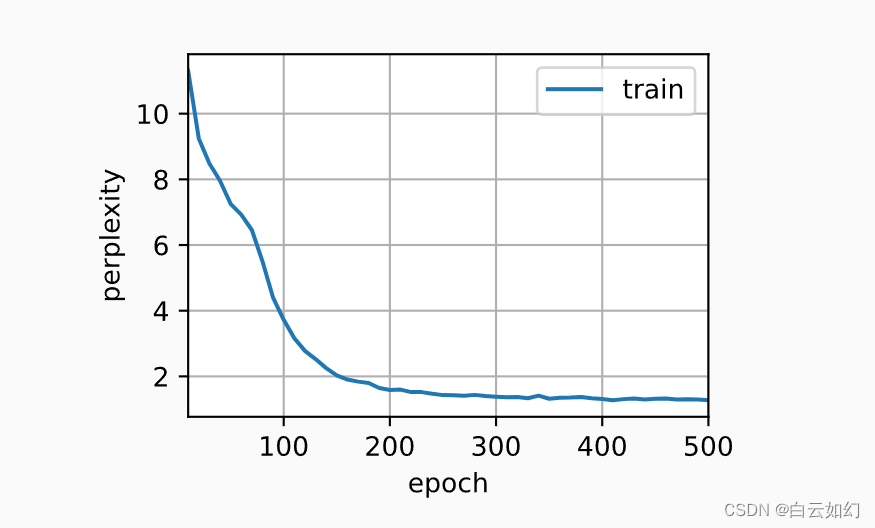

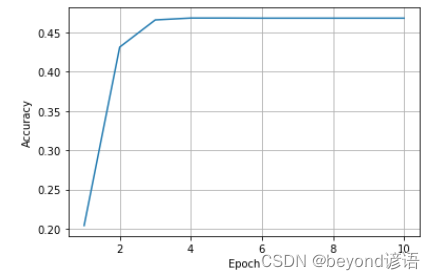

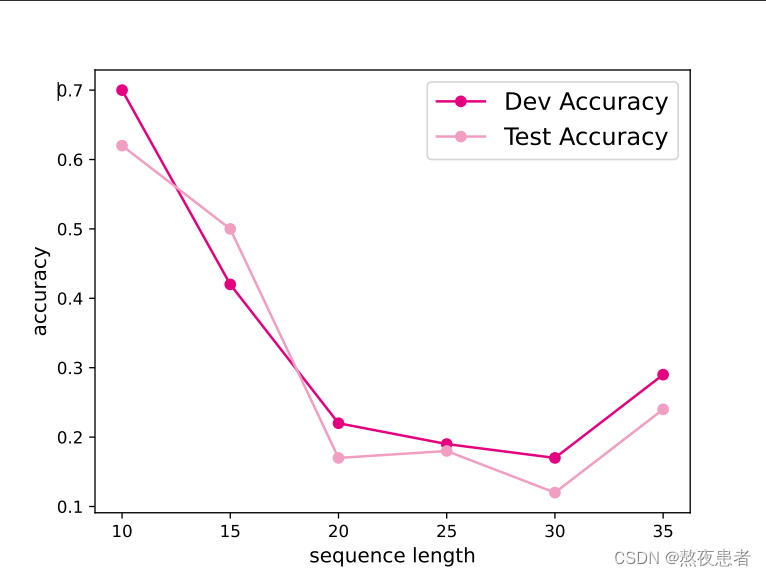

LSTM的记忆能力实验

目录

1 模型构建 1.1 LSTM层

2 模型训练 2.1 训练指定长度的数字预测模型 2.2 多组训练 2.3 损失曲线展示

3 模型评价 3.1 在测试集上进行模型评价 3.2 模型在不同长度的数据集上的准确率变化图 3.3 LSTM模型门状态和单元状态的变化 总结 长短期记忆网络(Long Sh…

NNDL 作业8:RNN - 简单循环网络

简单循环网络(Simple Recurrent Network,SRN)只有一个隐藏层的神经网络.目录 1. 使用Numpy实现SRN 2. 在1的基础上,增加激活函数tanh 3. 分别使用nn.RNNCell、nn.RNN实现SRN 4. 分析“二进制加法” 源代码(…

基于循环神经网络长短时记忆(RNN-LSTM)的大豆土壤水分预测模型的建立

Development of a Soil Moisture Prediction Model Based on Recurrent Neural Network Long Short-Term Memory in Soybean Cultivation 1、介绍2、方法2.1 数据获取2.2.用于预测土壤湿度的 LSTM 模型2.3.土壤水分预测的RNN-LSTM模型的建立条件2.4.预测土壤水分的RNN-LSTM模型…

自然语言处理---RNN经典案例之构建人名分类器

1 案例介绍 关于人名分类问题:以一个人名为输入, 使用模型帮助判断它最有可能是来自哪一个国家的人名,这在某些国际化公司的业务中具有重要意义,在用户注册过程中,会根据用户填写的名字直接给他分配可能的国家或地区选项ÿ…

【NLP】Attention机制和RNN

一、说明 循环神经网络是深度学习的主要内容之一,它允许神经网络处理文本、音频和视频等数据序列。它们可用于将序列简化为高级理解、注释序列,甚至从头开始生成新序列! 二、引进长记忆网络 基本的 RNN 设计很难处理较长的序列,但一种特殊的变体——“长短期记忆”网络 [1]…

循环神经网络时间序列预测

循环神经网络时间序列预测

循环神经网络用于时间序列预测比较好,先使用股票价格数据集来理解和掌握该算法。

数据来源

数据要先在Tushare注册登录一下,获取足够的积分 注册完之后有100积分,然后个人信息完善一下获取20积分,然后…

通过展开序列ISTA(SISTA)算法创建的递归神经网络(RNN)(Matlab代码实现)

💥💥💞💞欢迎来到本博客❤️❤️💥💥 🏆博主优势:🌞🌞🌞博客内容尽量做到思维缜密,逻辑清晰,为了方便读者。 ⛳️座右铭&a…

RNN使用sin曲线预测cos曲线

1. 导入我们需要的库

import torch

from torch import nn

import numpy as np

import matplotlib.pyplot as plt # 随机种子

torch.manual_seed(1) 2.定义我们的超参数

# 超参数 …

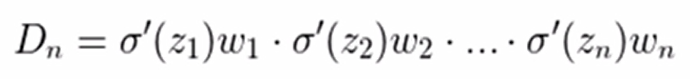

循环神经网络中的梯度消失或梯度爆炸问题产生原因分析(二)

上一篇中讨论了一般性的原则,这里我们具体讨论通过时间反向传播(backpropagation through time,BPTT)的细节。我们将展示目标函数对于所有模型参数的梯度计算方法。

出于简单的目的,我们以一个没有偏置参数的循环神经…

LSTM进行情感分析

LSTM进行情感分析的复现–pytorch的实现

关于TextCNN的复现参考本文章

TextCNN的复现–pytorch实现 - 知乎 (zhihu.com)

接下来主要是对代码内容的详解,完整代码将在文章末尾给出。

使用的数据集为电影评论数据集,其中正面数据集5000条左右ÿ…

TensorFlow2实战-系列教程9:RNN文本分类1

🧡💛💚TensorFlow2实战-系列教程 总目录 有任何问题欢迎在下面留言 本篇文章的代码运行界面均在Jupyter Notebook中进行 本篇文章配套的代码资源已经上传 1、文本分类任务

1.1 文本分类

数据集构建:影评数据集进行情感分析&…

【动手学深度学习】--循环神经网络

文章目录 循环神经网络1.算法介绍1.1无隐状态的神经网络(多层感知机)1.2有隐状态的循环神经网络1.3基于循环神经网络的字符级语言模型1.4困惑度 2.RNN从零开始实现2.1读取数据集2.2独热编码2.3初始化模型参数2.4循环神经网络模型2.5预测2.6梯度裁剪2.7训练 3.RNN简洁实现3.1读取…

LSTM 双向 Bi-LSTM

目录

一.Bi-LSTM介绍

二.Bi-LSTM结构

Bi-LSTM 代码实例 一.Bi-LSTM介绍

由于LSTM只能从序列里由前往后预测,为了既能够从前往后预测,也能从后往前预测,Bi-LSTM便被发明了出来。简单来说,BiLSTM就是由前向LSTM与后向LSTM组合而成。

二.Bi-LSTM结构

转自:

NLP基础之RNN基础

感谢阅读自然语言处理概述词嵌入层通用代码:循环网络层自然语言处理概述

自然语言处理(Nature language Processing, NLP)研究的主要是通过计算机算法来理解自然语言。对于自然语言来说,处理的数据主要就是人类的语言,…

1 时间序列模型入门: LSTM

0 前言 循环神经网络(Recurrent Neural Network,RNN)是一种用于处理序列数据的神经网络。相比一般的神经网络来说,他能够处理序列变化的数据。比如某个单词的意思会因为上文提到的内容不同而有不同的含义,RNN就能够很好…

Python数据分析案例25——海上风力发电预测(多变量循环神经网络)

本案例适合理工科。

承接上一篇的硬核案例:Python数据分析案例24——基于深度学习的锂电池寿命预测

本次案例类似,只是进一步拓展了时间序列预测到多变量的情况。上一个案例的时间序列都是只有电池容量一个特征变量,现在采用多个变量进行神…

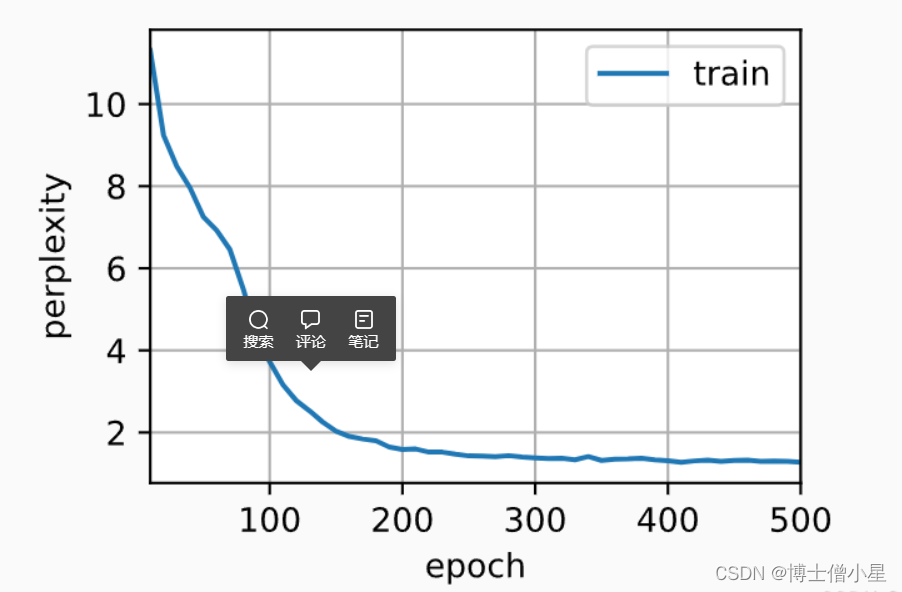

【UCAS自然语言处理作业二】训练FFN, RNN, Attention机制的语言模型,并计算测试集上的PPL

前言

本次实验主要针对前馈神经网络,RNN,以及基于注意力机制的网络学习语言建模任务,并在测试集上计算不同语言模型的PPL

PPL计算:我们采用teacher forcing的方式,给定ground truth context,让其预测next…

RNN 网络结构及训练过程简介

本文通过整理李宏毅老师的机器学习教程的内容,介绍 RNN(recurrent neural network)的网络结构。

RNN 网络结构, 李宏毅

RNN RNN 的特点在于存储功能,即可以记忆前面时刻的信息。

最简单的 RNN 结构如下:

当然&a…

小白的第一个RNN(情感分析模型)

平台:window10,python3.11.4,pycharm

框架:keras

编写日期:20230903

数据集:英语,自编,训练集和测试集分别有4个样本,标签有积极和消极两种

环境搭建

新建文件夹&am…

计算机循环神经网络(RNN)

计算机循环神经网络(RNN)

一、引言

循环神经网络(RNN)是一种常见的深度学习模型,适用于处理序列数据,如文本、语音、时间序列等。RNN通过捕捉序列数据中的时间依赖关系和上下文信息,能够解决很…

tensorflow之seq2seq阅读笔记

学习tensorflow最好的方式还是阅读官方文档:https://www.tensorflow.org/versions/r0.12/tutorials/seq2seq/

一、tensorflow的RNN使用:

1.使用LSTM lstm rnn_cell.BasicLSTMCell(lstm_size)# Initial state of the LSTM memory.state tf.zeros([bat…

从零开始实现神经网络(三)_RNN循环神经网络

参考文章:rnn循环神经网络介绍 循环神经网络 (RNN) 是一种专门处理序列的神经网络。它们通常用于自然语言处理 (NLP) 任务,因为它们在处理文本方面很有效。在这篇文章中,我们将探讨什么是 RNN&a…

深度学习(2)---循环神经网络(RNN)

文章目录 一、序列数据和语言模型1.1 序列数据1.2 语言模型 二、循环神经网络(RNN)2.1 概述2.2 门控循环单元(GRU)2.3 长短期记忆网络(LSTM) 一、序列数据和语言模型

1.1 序列数据 1. 在深度学习中,序列数据(Sequence data)是指具有前后顺序…

动手学习深度学习学习-循环神经网络

循环神经网络

序列模型

自回归模型

自回归模型(AR模型)和隐变量自回归模型是时间序列分析中的两种重要模型。它们都用于预测和分析时间序列数据,但各有特点和应用场景。

定义:自回归模型是一种时间序列模型,它使用先前时间点的…

【23-24 秋学期】NNDL 作业9 RNN - SRN

简单循环网络(Simple Recurrent Network,SRN)只有一个隐藏层的神经网络.

目录

1. 实现SRN

(1)使用Numpy

(2)在1的基础上,增加激活函数tanh

(3࿰…

GRU,LSTM,encoder-decoder架构,seq2seq的相关概念

门控记忆单元(GRU)

GRU模型有专门的机制来确定应该何时更新隐状态,以及应该何时重置隐状态。这些机制是可学习的。门控循环单元具有以下两个显著特征:

重置门有助于捕获序列中的短期依赖关系;更新门有助于捕获序列中…

27. 深度学习进阶 - 为什么RNN

文章目录 一个柯基的例子为什么RNN or CNN Hi,你好。我是茶桁。 这节课开始,我们将会讲一个比较重要的一种神经网络,它对应了咱们整个生活中很多类型的一种问题结构,它就是咱们的RNN网络。

咱们首先回忆一下,上节课咱…

【自然语言处理】【大模型】RWKV:基于RNN的LLM

相关博客 【自然语言处理】【大模型】RWKV:基于RNN的LLM 【自然语言处理】【大模型】CodeGen:一个用于多轮程序合成的代码大语言模型 【自然语言处理】【大模型】CodeGeeX:用于代码生成的多语言预训练模型 【自然语言处理】【大模型】LaMDA&a…

深度学习 | Pytorch深度学习实践 (Chapter 12 Basic RNN)

十二、Basic RNN —— 实际上就是对线性层的复用 使用RNN最重要的两点:

了解序列数据的维度;循环过程所用的权重共享机制; 一般就是自己写个循环,权重层重复用就行了; 回顾:-----------------------------…

PyTorch中如何查看神经网络模型的参数(两种高效的方法,简单上手)

文章目录1 用for循环打印parameters2 安装依赖:torchsummary2.1 如果是单输入,比如CNN 模型2.1.1 代码12.1.2 代码22.2 如果是多输入的情况,比如说RNN需要输入x和h_01 用for循环打印parameters

import torch

import torch.nn as nn

import t…

RNN:Long Short-term Memory(中)

目录

1 LSTM 的简图

2 LSTM 的整体结构

2.1 结构图

2.2 流程图

3 举个例子

3.1 简单看看

3.2 代入 LSTM

4 Original Network v.s. LSTM

5 细看 LSTM 原视频:李宏毅 2020:Recurrent Neural Network (Part I) 1 LSTM 的简图

LSTM 实际…

【人工智能概论】 RNN、LSTM、GRU简单入门与应用举例、代码耗时计算

【人工智能概论】 RNN、LSTM、GRU简单入门与应用举例、代码耗时计算 文章目录 【人工智能概论】 RNN、LSTM、GRU简单入门与应用举例、代码耗时计算一. RNN简介1.1 概念简介1.2 方法使用简介 二. 编码层embedding2.1 embedding的参数2.2 embedding的理解 三. Linear层与CrossEnt…

自动驾驶技术:驶向未来的智能之路

导言 自动驾驶技术正引领着汽车产业向着更安全、高效、智能的未来演进。本文将深入研究自动驾驶技术的核心原理、关键技术、应用场景以及对交通、社会的深远影响。

1. 简介 自动驾驶技术是基于先进传感器、计算机视觉、机器学习等技术的创新,旨在实现汽车在不需要人…

什么是RNN(循环神经网络)

什么是RNN(循环神经网络)

循环神经网络(Recurrent Neural Network),在识别图像时,输入的每张图片都是孤立的,认出这张图片是苹果,并不会对认出下一张图片是梨造成影响。 但对语言来说,顺序是十分重要的,“…

序列模型,语言模型,RNN的相关概念

序列模型,语言模型,RNN

循环神经网络(RNN)通过引入状态变量来存储过去的信息和当前的输入,从而确定当前的输出。这种结构使得RNN非常适合处理序列信息,因为它可以捕捉到序列中的时间依赖性。这与卷积神经网…

深入理解人工智能中的图神经网络:原理、应用与未来展望

导言: 图神经网络(Graph Neural Networks, GNNs)作为人工智能领域的一项前沿技术,在社交网络分析、推荐系统、生物信息学等多个领域展现出卓越的性能。本文将深入剖析图神经网络的原理、当前应用场景以及未来可能的发展方向。

1.…

tf中的循环神经网络(RNN)

tf中的循环神经网络(RNN) 目录tf中的循环神经网络(RNN)1. 序列数据的表示方法2. 循环神经网络(RNN)3. TensorFlow中RNN实现4. RNN实战1. 序列数据的表示方法

与时间相关的数据称为时间序列(Seq…

循环神经网络-RNN记忆能力实验 [HBU]

目录

一、循环神经网络

二、循环神经网络的记忆能力实验 三、数据集构建

数据集的构建函数

加载数据并进行数据划分

构造Dataset类

四、模型构建

嵌入层

SRN层

五、模型训练

训练指定长度的数字预测模型

多组训练

损失曲线展示

六、模型评价

参考《神经网络与深度…

理解RNN与LSTM网络

本文重点讲解RNN与LSTM的原理与区别LSTM通过细胞状态可以长期保留数据。因为RNN每次都是用上一次的输出和本次的输入concat作为本次的实际输入,在迭代几次之后,基本上循环的输出就会遗留很小的影响对接下来的循环,且对之前循环的结果没有补救…

RNN理解(基于莫凡的视频)

莫凡的笔记(pytorch and RNN)

通过sin函数预测cos函数

RNN简介

普通神经网络的弊端,普通的神经网络对于有关联的数据的输入,不能很好的处理RNN就是对上一次的输入产生了一定的记忆,然后去预测,下一次的结…

《PyTorch深度学习实践》第十一讲 循环神经网络(基础篇 + 高级篇)

b站刘二大人《PyTorch深度学习实践》课程第十一讲循环神经网络(基础篇 高级篇)笔记与代码: https://www.bilibili.com/video/BV1Y7411d7Ys?p12&vd_sourceb17f113d28933824d753a0915d5e3a90 https://www.bilibili.com/video/BV1Y7411d7Y…

神经网络ANN(MLP),CNN以及RNN区别和应用

1. Artificial Neural Network(ANN)

又称为Multilayer Perception Model(MLP) 2. CNN

AAA

3. RNN

22 先占坑,后期再整理

References

[1] CNN vs.RNN vs.ANN——浅析深度学习中的三种神经网络 - 知乎

[2] https://www.youtube.com/watch?vu7obuspdQu4

[3] 深…

论文阅读:Adding Attentiveness to the Neurons in Recurrent Neural Networks

目录

Summary

Details (Implementation)

原来的 RNN 结构

变为 Element-wise-Attention Gate (EleAttG) 后 论文名称:Adding Attentiveness to the Neurons in Recurrent Neural Networks(2018 ECCV)

下载地址:https://arxiv…

RNN(recurrent neural network)(二)——动手实现一个RNN

RNN(recurrent neural network)(二)——动手实现一个RNNRNN系列博客:

RNN(recurrent neural network)(一)——基础知识RNN(recurrent neural network&#x…

RNN(recurrent neural network)(一)——基础知识

RNN(recurrent neural network)(一)——基础知识 RNN系列博客:

RNN(recurrent neural network)(一)——基础知识RNN(recurrent neural network)&…

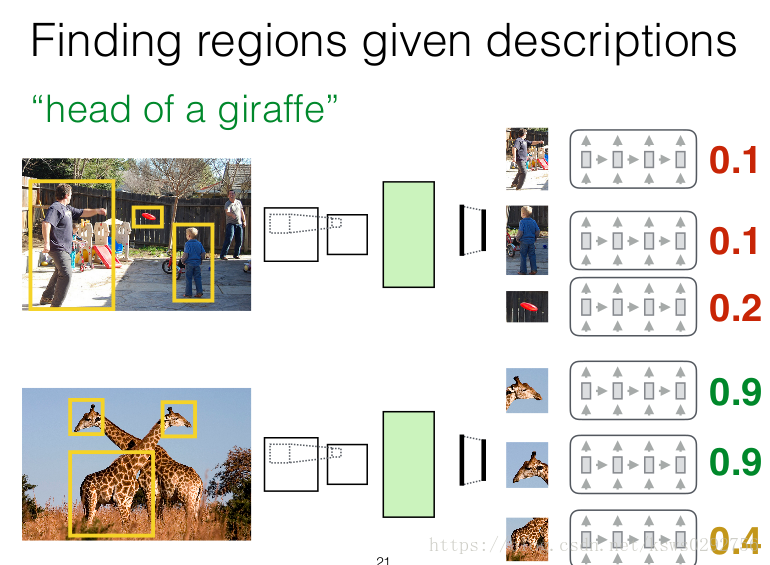

论文解读:DenseCap: Fully Convolutional Localization Networks for Dense Captioning

本篇论文解读的排版主要参见原文的格式,针对原文中的每一个小节进行展开,有的是对原文的一个提炼和简单概括,有的是对原文中涉及但是又没有详细介绍的技术的补充和说明。 原文连接:https://cs.stanford.edu/people/karpathy/dens…

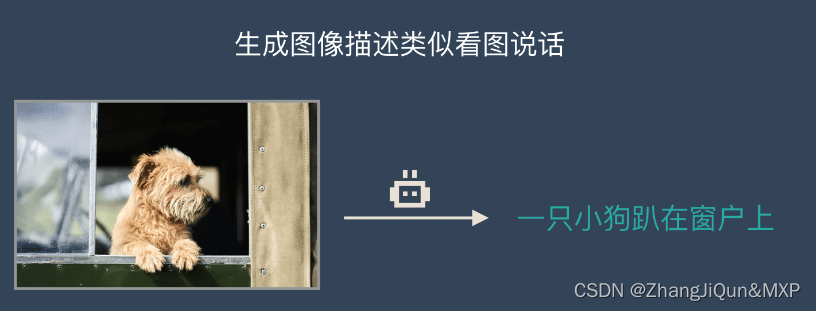

图片描述(image cpationing) 源码实现——让计算机用简短的句子描述一张图片

自动生成图片描述:NeuralTalk2

一、基本信息

NeuralTalk2是斯坦福计算机视觉人工智能实验室的一个项目,利用循环神经网络(RNN)和卷积神经网络(CNN)来描述图片内容,NeuralTalk2 比第一版训练速…

CNN和RNN的区别是什么?

CNN(卷积神经网络)和RNN(循环神经网络)是深度学习中的两种主要神经网络类型,它们在结构、功能和应用领域上有显著的区别:

核心结构与工作原理:

CNN: CNN主要用于处理具有网格状拓扑结构的数据,…

循环神经网络训练情感分析

文章目录 1 循环神经网络训练情感分析2 完整代码3 代码详解 1 循环神经网络训练情感分析

下面介绍如何使用长短记忆模型(LSTM)处理情感分类LSTM模型是循环神经网络的一种,按照时间顺序,把信息进行有效的整合,有的信息…

深度学习与自然语言处理(7)_斯坦福cs224d 语言模型,RNN,LSTM与GRU

翻译:胡杨(superhy199148hotmail.com) && 胥可(feitongxiaokegmail.com) 校对调整:寒小阳 && 龙心尘 时间:2016年7月 出处: http://blog.csdn.net/han_xiaoyang/article/details/51932536 http://blog.csdn.…

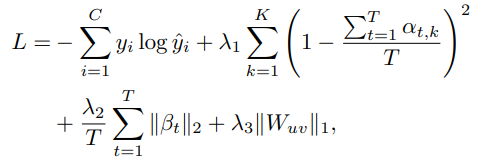

论文阅读:An end-to-end spatio-temporal attention model for human action recognition from skeleton data

目录

创新点(Main Contributions)

Proposed Method

Spatial Attention

Temperal Attention

Joint Training of the Networks

Regularized Objective Function 论文名称:An end-to-end spatio-temporal attention model for human actio…

RNN循环神经网络原理理解

一、基础

正常的神经网络 一般情况下,输入层提供数据,全连接进入隐藏层,隐藏层可以是多层,层与层之间是全连接,最后输出到输出层;通过不断的调整权重参数和偏置参数实现训练的效果。深度学习的网络都是水…

pytorch入门10--循环神经网络(RNN)

一、简要介绍 RNN适用了处理序列性的数据,并利用权重共享机制(即一个RNN网络使用多次)。序列性数据用一个例子来理解,比如我们想要预知某一天是否会下雨,我们采集了大量天数的气象信息,气象信息包括温度、气…

图解NLP模型发展:从RNN到Transformer

图解NLP模型发展:从RNN到Transformer

自然语言处理 (NLP) 是深度学习中一个颇具挑战的问题,与图像识别和计算机视觉问题不同,自然语言本身没有良好的向量或矩阵结构,且原始单词的含义也不像像素值那么确定和容易表示。一般我们需…

LSTM-理解 Part-2(RNN的局限性)

之前写过一部分LSTM-理解 Part-1(RNN:循环神经网络) 这是其中的第二部分,阐述RNN的局限性。

The Problem of Long-Term Dependencies 长期依赖问题 长期依赖问题指的是在序列数据中,某些元素之间存在着较长时间的依赖…

神经网络——循环神经网络(RNN)

神经网络——循环神经网络(RNN) 文章目录 神经网络——循环神经网络(RNN)一、循环神经网络(RNN)二、循环神经网络结构1、一对一(One to One)2、一对多(One to Many&#…

【22-23 春学期】人工智能基础--AI作业11-RNN

1.前馈网络存在的问题 前馈网络是一种最基本的神经网络结构,它将信息从输入层经过隐藏层传递到输出层,但也存在一些问题。首先,前馈网络缺乏记忆能力,无法处理序列数据和时间依赖性。这限制了其在处理语言、音频和视频等具有时间性…

深入理解循环神经网络(RNN):原理与代码解析

文章目录 1. RNN的原理1.1 结构1.2 循环连接1.3 前向传播1.4 反向传播算法 2. RNN文本生成任务应用3.参考文献: 循环神经网络(RNN)是一种在序列数据建模方面表现优异的神经网络模型。它通过循环连接的方式,使得当前时刻的输出可以…

深度学习05-CNN循环神经网络

概述

循环神经网络(Recurrent Neural Network,RNN)是一种具有循环连接的神经网络结构,被广泛应用于自然语言处理、语音识别、时序数据分析等任务中。相较于传统神经网络,RNN的主要特点在于它可以处理序列数据…

【pytorch】nn.utils.rnn.pad_sequence的使用

目录 错误使用说明样例代码 错误

The size of tensor a (3) must match the size of tensor b (5) at non-singleton dimension 1

在使用nn.utils.rnn.pad_sequence时,遇到如上错误,原因是使用方式错误.

使用说明

用padding_value填充可变长度张量列表 pad_sequence 沿新维…

手搓 自然语言模型 LLM 拆分em结构设计 网络参数对比

数据

数据集

新的em编码参数表 voc_sizehidden_sizetotaltotal Bmax_lensecondsdays65536512374865920.03749B10242560.2655361024828375040.08284B20485120.5655362048<

机器学习深度学习——常见循环神经网络结构(RNN、LSTM、GRU)

👨🎓作者简介:一位即将上大四,正专攻机器学习的保研er 🌌上期文章:机器学习&&深度学习——RNN的从零开始实现与简洁实现 📚订阅专栏:机器学习&&深度学习 希望文章…

DeepAR代码详析(pytorch版)实现用电量预测

DeepAR代码详析(pytorch版)实现用电量预测 – 潘登同学的RNN学习笔记 文章目录DeepAR代码详析(pytorch版)实现用电量预测 -- 潘登同学的RNN学习笔记数据集说明数据预处理代码构造模型Loss函数评估指标相关utils工具类训练模型前言…

深度学习激活函数与正则化问题

深度学习激活函数与正则化问题–潘登同学的深度学习笔记 文章目录深度学习激活函数与正则化问题--潘登同学的深度学习笔记梯度消失问题(Vanishing Gradients)Relu的缺点其他Relu变形参数初始化问题pre-trainingrandom initialization代码验证Xavier init…

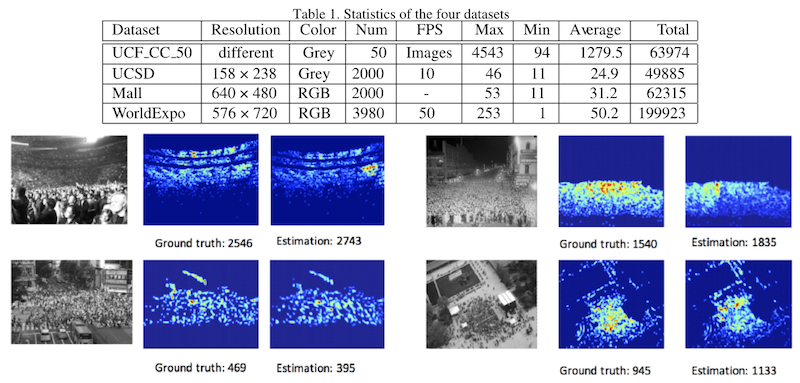

人群密度估计-Crowd Density

一. 应用背景在安防大背景下,对敏感区域人流量的管控是一个重要的课题,防止人群骚乱、踩踏现象的发生,对非预期的人员汇聚进行预警等等,最常用的方法是检测到每个目标,然后借助 Perspective 矩阵完成到实际位置的映射&…

【Paper reading】可变剪接预测ENCODEC数据集

可变剪接预测&ENCODEC数据集

1. Epigenome-based splicing prediction using a recurrent neural network

2. An integrative ENCODE resource for cancer genomics 文章目录可变剪接预测&ENCODEC数据集1. Epigenome-based splicing prediction using a recurrent ne…

LSTM网络模型:从基础到应用播

目录

介绍

LSTM的基础结构

LSTM的训练方法

LSTM的应用场景

总结 LSTM(Long Short-Term Memory)网络模型是一种递归神经网络,被广泛应用于自然语言处理、语音识别、图像处理等领域。本文将从LSTM的基础结构、训练方法、应用场景等方面进行…

基于进制嵌入及累计解码的大模型研究

摘要: 随着深度学习领域的快速发展,许多复杂的神经网络已经在各个领域取得了重要的突破。然而,大型神经网络一般需要大量的计算能力、存储空间和时间复杂度,在现有的硬件资源下,降低这些巨型模型的训练和预测成本仍具有挑战性。为此,本文提出了基于进制嵌入(EmAdd)和累…

深度学习之----循环神经网络(RNN) 基础

目录

1.RNN的背景

设计RNNs的目的,就是处理序列数据。

2.RNN的价值

3. RNN的基本结构

4. RNN的高级形式

4.1 双向RNN (Bidirectional RNN )

4.2 LSTM(Long Short-term Memory)

4.3 GRU(Gated Recurrent Unit)

5. RNN的训练

5.1 普通的RNN(simple RNN)不好…

CTC、RNN-T穷举输出

(李宏毅深度学习HLP课程笔记) 对于CTC和RNN-T,计算的目标概率函数都是 Pθ(Y∣X)∑h∈align(Y)P(h∣X)P_\theta(Y|X)\sum_{h\in align(Y)}P(h|X)Pθ(Y∣X)h∈align(Y)∑P(h∣X) 其中,X代表输入的语音,h是为了解决a…

李宏毅机器学习笔记:RNN循环神经网络

RNN 一、RNN1、场景引入2、如何将一个单词表示成一个向量3种典型的RNN网络结构 二、LSTMLSTM和普通NN、RNN区别 三、 LSTM的训练 一、RNN

1、场景引入 例如情景补充的情况,根据词汇预测该词汇所属的类别。这个时候的Taipi则属于目的地。但是,在订票系统…

[Deep Learning 译文] LeCun、Bengio和Hinton三大牛的联合综述(下)

【翻译】本文为该综述文章中文译文的下半部分,详细介绍了CNN、分布式特征表示、RNN及其不同的应用,并对深度学习技术的未来发展进行展望。接上文:[Deep Learning 译文] LeCun、Bengio和Hinton三大牛的联合综述(上)卷积…

深度学习:基于循环神经网络RNN实现自然语言生成

目录 1 循环神经网络介绍

1.1 什么是循环神经网络

1.2 RNN的网络结构

1.3 RNN的工作原理

编辑

1.4 RNN的应用场景

2 基于RNN实现语句生成

2.1 句子生成介绍

2.2 基于pytorch实现语句生成

2.3 完整代码

2.4 该模型的局限

3 总结 1 循环神经网络介绍

1.1 什么是循环…

RNN项目实战——文本输入与预测

在本篇博客文章中,我们将使用pytorch搭建RNN模型来生成文本。

文本输入 神经网络不像人类那样善于处理文本数据。因为绝大多数的NLP任务,文本数据都会先通过嵌入码(Embedding code),独热编码(One-hot encoding)等方式转为数字编码…

Understanding LSTM Networks

文章目录Recurrent Neural NetworksThe Problem of Long-Term DependenciesLSTM NetworksThe Core Idea Behind LSTMs.Step-by-Step LSTM Walk Through本篇文章记述了自己对“Understanding LSTM Networks”的理解

Recurrent Neural Networks

Humans don’t start their thin…

(三)循环神经网络RNN之LSTM和GRU

LSTM介绍

LSTM(Long Short Term Memory)是 Hochreater 和 Schmidhuber 在 1997 年提出的一种网络结构,尽管该模型在序列建模上的特性非常突出,但由于当时正是神经网络的下坡期,没有能够引起学术界足够的重视。随着深度学习逐渐发展ÿ…

循环神经网络——中篇【深度学习】【PyTorch】【d2l】

文章目录 6、循环神经网络6.4、循环神经网络(RNN)6.4.1、理论部分6.4.2、代码实现 6.5、长短期记忆网络(LSTM)6.5.1、理论部分6.5.2、代码实现 6.6、门控循环单元(GRU)6.6.1、理论部分6.6.2、代码实现 6、循…

12 循环神经网络(基础篇) Basic RNN

文章目录问题引入关于权重权重共享RNN CellRNN原理RNN计算过程代码实现RNN Cell维度说明代码RNN维度说明NumLayers说明计算过程代码参考实例问题分析多分类问题代码RNN CellRNN改进Embedding网络结构Embedding说明Linear说明代码课程来源:

链接课程文本参考…

现代循环神经网络:门控循环单元(GRU)

专栏:神经网络复现目录

门控循环单元(GRU)

门控循环神经网络(Gated Recurrent Neural Network,简称“门控循环神经网络”或“门循环神经网络”)是一种改进的循环神经网络(RNN)架构。它包含了一些门控机制…

循环神经网络——下篇【深度学习】【PyTorch】【d2l】

文章目录 6、循环神经网络6.7、深度循环神经网络6.7.1、理论部分6.7.2、代码实现 6.8、双向循环神经网络6.8.1、理论部分6.8.2、代码实现 6.9、机器翻译6.9.1、理论部分 6.10、编码器解码器架构6.10.1、理论部分 6、循环神经网络

6.7、深度循环神经网络

6.7.1、理论部分

设计…

举例说明什么是循环神经网络

循环神经网络(Recurrent Neural Network, RNN)是一种处理时间序列数据和自然语言等具有顺序信息的数据的神经网络模型。与普通的前馈神经网络(Feedforward Neural Network)不同,RNN具有循环连接,使得网络能…

大话循环神经网络RNN、LSTM、GRU

CNN主要处理图像信息,主要应用于计算机视觉领域。 RNN(recurrent neural network)主要就是处理序列数据(自然语言处理、语音识别、视频分类、文本情感分析、翻译),核心就是它能保持过去的记忆。但RNN有着梯…

循环神经网络——上篇【深度学习】【PyTorch】【d2l】

文章目录 6、循环神经网络6.1、序列模型6.1.1、序列模型6.1.2、条件概率建模6.1.2、代码实现 6.2、文本预处理6.2.1、理论部分6.2.2、代码实现 6.3、语言模型和数据集 6、循环神经网络

6.1、序列模型

6.1.1、序列模型

序列模型主要用于处理具有时序结构的数据, *…

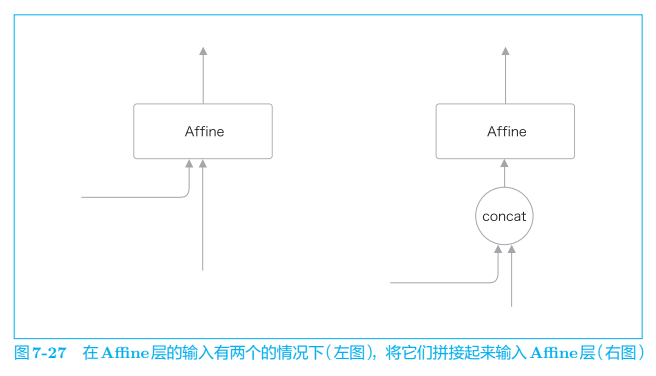

第七章 基于 RNN 的生成文本

目录7.1 使用语言模型生成文本7.1.1 使用 RNN 生成文本的步骤7.1.2 文本生成的实现7.1.3 更好的文本生成7.2 seq2seq 模型7.2.1 seq2seq 的原理7.2.2 时序数据转换的简单尝试7.2.3 可变长度的时序数据7.2.4 加法数据集7.3 seq2seq 的实现7.3.1 Encoder类7.3.2 Decoder类7.3.3 S…

一步一步详解LSTM网络【从RNN到LSTM到GRU等,直至attention】

一步一步详解LSTM网络【从RNN到LSTM到GRU等,直至attention】 0、前言1、Recurrent Neural Networks循环神经网络2、The Problem of Long-Term Dependencies长期依赖的问题3、LSTM Networks4、The Core Idea Behind LSTMs5、Step-by-Step LSTM Walk Through6、Varian…

从RNN到LSTM:深度学习在自然语言处理领域的惊艳算法

当谈到计算机科学时,算法是一个重要的话题,因为它们能帮助解决很多问题。而有些算法,其高效性和惊人表现,令人感到惊艳。

在自然语言处理领域,有很多受到关注的算法,比如词向量、语言模型、注意力机制等&a…

tensorflow是如何实现RNN的递归计算

我们都知道RNN是一种循环神经网络,其实可以认为是一种递归计算,每一个时刻的输出都是根据上一个时刻的输出和本时刻的输入得到: Ht1f(Ht,xt1)H_{t1} f(H_t, x_{t1})Ht1f(Ht,xt1)

那么在tensorflow是如何实现这种递归计算的呢ÿ…

【让我们深度理解语音识别:Siri与Alexa如何运用深度学习和循环神经网络将声音转化为文字

语音识别技术是近年来人工智能领域的重要研究对象,它的出现大大改善了人与机器的交互方式,增强了人们生活的便捷度。今天,我将带领大家深度了解语音识别技术的内部运作原理,以及语音助手如Siri和Alexa如何运用这些先进技术&#x…

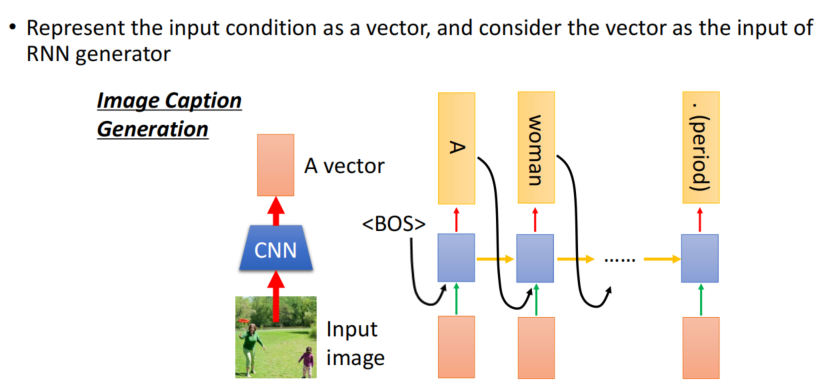

计算机视觉与深度学习-循环神经网络与注意力机制-Attention(注意力机制)-【北邮鲁鹏】

目录 引出Attention定义Attention-based model通俗解释应用在图像领域图像字幕生成(image caption generation)视频处理 序列到序列学习:输入和输出都是长度不同的序列 引出Attention

传统的机器翻译是,将“机器学习”四个字都学…

【动手学深度学习-Pytorch版】循环神经网络-从零开始实现

"""导包并设置batch和steps大小"""

import math

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2l

# num_steps是输入的小批量句子的长度

batch_size, num_steps 32, 35# device torch.…

Keras实现RNN和LSTM做回归预测(python)

学习了RNN和LSTM的理论知识,下面再来使用Keras实现一下这些模型。

理论知识:

循环神经网络(RNN)LSTM神经网络和GRU

Keras实现神经网络:

Keras实现全连接神经网络(python)

Keras的安装过程&…

RNN、LSTM、GRU

近年来循环神经网络在自然语言处理,语音技术,甚至图像方面都有不错的应用。本文主要介绍基础的RNN,RNN所面对的问题,以及RNN的改进版本:LSTM和GRU

RNN(Recurrent Neural Network) 我们先放一张RNN的结构图,…

基于普通RNN、LSTM、加入atttention的LSTM的指代消解【代码在文末】

基于普通RNN、LSTM、加入atttention的LSTM的指代消解【代码在文末】 题目要求描述摘要1 指代消解简介2 RNN框图和机理分析3 LSTM框图和机理分析4 加入 atttention 的 LSTM框图和机理分析测试分析5 模型对比梯度分析RNN梯度分析LSTM梯度分析基于attention的LSTM梯度分析性能对比…

RNN循环神经网络 2022-1-12

人工智能基础总目录 RNN一、 出现背景二、 RNN 模型说明三、 LSTM 模型3.1 PEEPHOLE的LSTM四、 GRU五、存在问题六、 LSTM 代码实践6.1 构造数据集6.2 搭建模型6.3. 模型训练 与预测一、 出现背景

序列问题, 输入的前后元素存在相关性,全连接神经网络无…

NLP 02 RNN

一、RNN

RNN(Recurrent Neural Network),中文称作循环神经网络它一般以序列数据为输入通过网络内部的结构设计有效捕捉序列之间的关系特征,一般也是以序列形式进行输出。 传统神经网络(包括CNN),输入和输出都是互相独立的。但有些任务,后续的输出和之前…

Python实现RNN算法对MFCC特征的简单语音识别

Python实现RNN算法对MFCC特征的简单语音识别

1、实现步骤

借助深度学习库 TensorFlow/Keras 来构建模型

1.对标签进行编码,将文本标签转换为整数标签。

2.对 MFCC 特征数据进行填充或截断,使其长度一致,以便于输入到 RNN 模型中

3.如果是二维数据需要转成三维:

Simpl…

股票价格预测 | Python基于RNN及股票预测实战

循环神经网络(RNN)是基于序列数据(如语言、语音、时间序列)的递归性质而设计的,是一种反馈类型的神经网络,其结构包含环和自重复,因此被称为“循环”。它专门用于处理序列数据,如逐字生成文本或预测时间序列数据(例如股票价格)。 (1)one to one:其实和全连接神经网络…

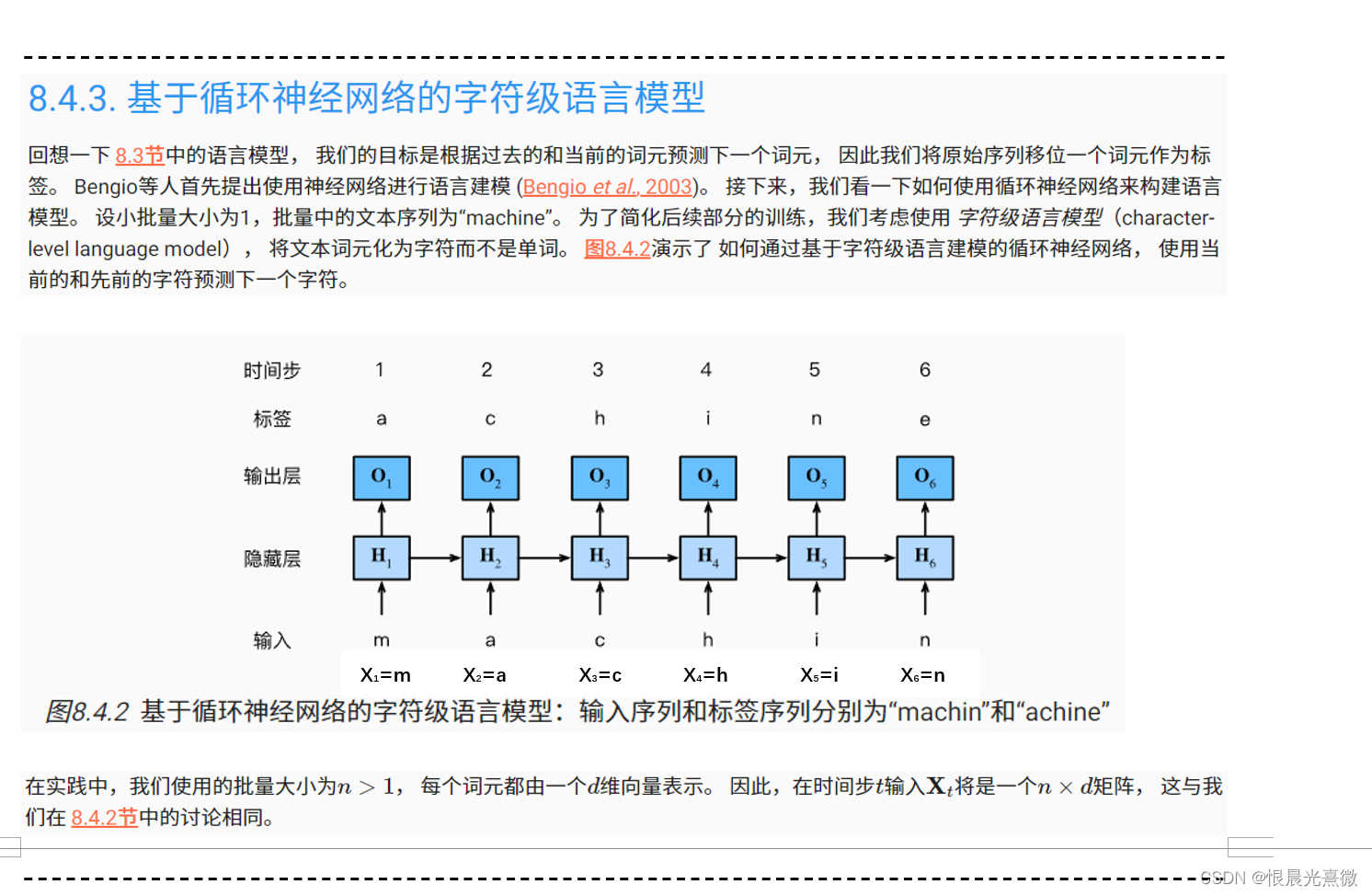

《动手学深度学习 Pytorch版》 8.4 循环神经网络

8.4.1 无隐状态的神经网络

对于无隐藏装态的神经网络来说,给定一个小批量样本 X ∈ R n d \boldsymbol{X}\in\mathbb{R}^{n\times d} X∈Rnd,则隐藏层的输出 H ∈ R n h \boldsymbol{H}\in\mathbb{R}^{n\times h} H∈Rnh 通过下式计算: …

pytorch,tf维度理解RNN

input_t input_t.squeeze(1) 这行代码用于从 input_t 中去除尺寸为1的维度。在深度学习中,经常会出现具有额外尺寸为1的维度,这些维度通常是为了匹配模型的期望输入维度而添加的。

在这里,input_t可能具有形状 (batch_size, 1, feature_dim…

11 Self-Attention相比较 RNN和LSTM的优缺点

博客配套视频链接: https://space.bilibili.com/383551518?spm_id_from=333.1007.0.0 b 站直接看 配套 github 链接:https://github.com/nickchen121/Pre-training-language-model 配套博客链接:https://www.cnblogs.com/nickchen121/p/15105048.html RNN 无法做长序列,当一…

【深度学习实验】循环神经网络(五):基于GRU的语言模型训练(包括自定义门控循环单元GRU)

文章目录 一、实验介绍二、实验环境1. 配置虚拟环境2. 库版本介绍 三、实验内容(一)自定义门控循环单元(GRU,Gated Recurrent Unit)1. get_params2. init_gru_state3. gru (二)创建模型0. 超参数…

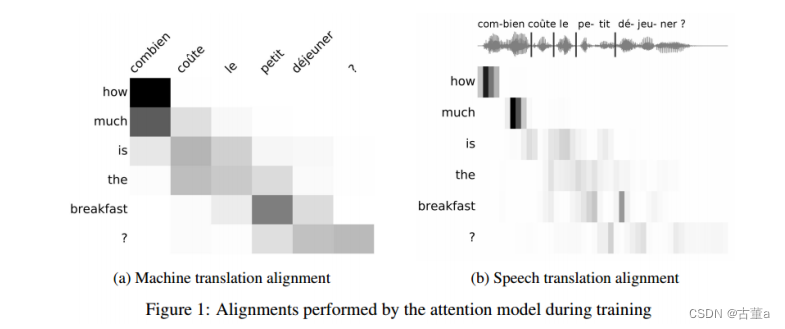

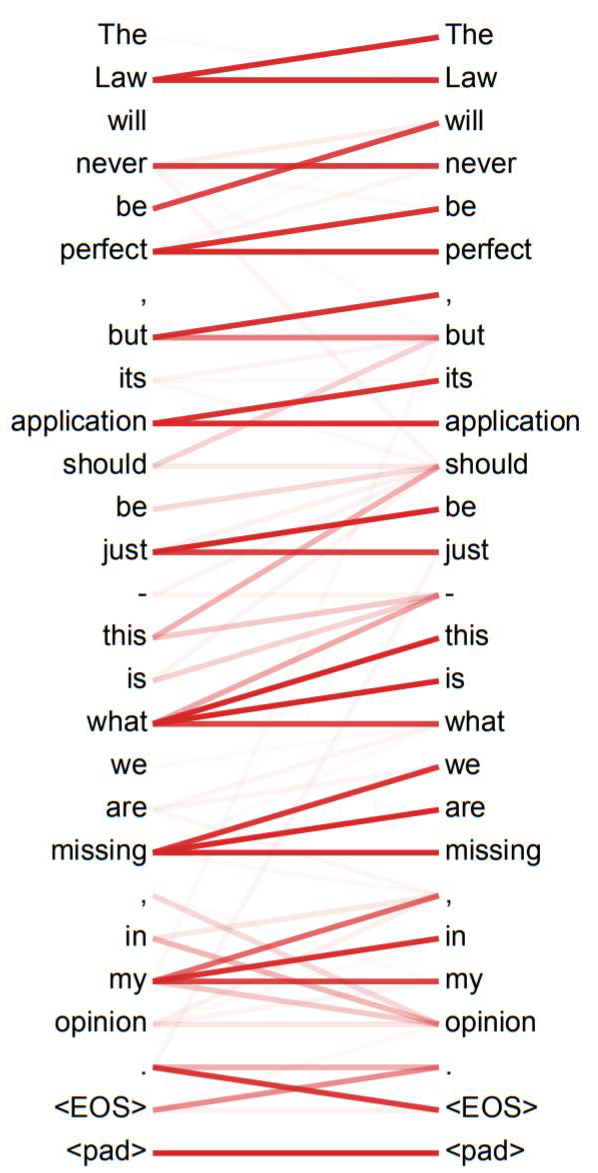

自然语言处理---RNN经典案例之使用seq2seq实现英译法

1 seq2seq介绍

1.1 seq2seq模型架构 seq2seq模型架构分析: seq2seq模型架构,包括两部分分别是encoder(编码器)和decoder(解码器),编码器和解码器的内部实现都使用了GRU模型,这里它要完成的是一个中文到英文的翻译:欢迎…

《动手学深度学习》-55循环神经网络

沐神版《动手学深度学习》学习笔记,记录学习过程,详细的内容请大家购买书籍查阅。

b站视频链接 开源教程链接

循环神经网络 潜变量自回归模型: 循环神经网络结构: 简单来说循环神经网络RNN就是在MLP中加了一项,使它可…

CVer从0入门NLP(一)———词向量与RNN模型

🍊作者简介:秃头小苏,致力于用最通俗的语言描述问题 🍊专栏推荐:深度学习网络原理与实战 🍊近期目标:写好专栏的每一篇文章 🍊支持小苏:点赞👍🏼、…

RNN 单元:分析 GRU 方程与 LSTM,以及何时选择 RNN 而不是变压器

一、说明 深度学习往往感觉像是在雪山上找到自己的道路。拥有坚实的原则会让你对做出决定更有信心。我们都去过那里 在上一篇文章中,我们彻底介绍并检查了 LSTM 单元的各个方面。有人可能会争辩说,RNN方法已经过时了,研究它们是没有意义的。的…

循环神经网络(Recurrent Neural Network)

1. 为什么需要循环神经网络 RNN 上图是一幅全连接神经网络图,我们可以看到输入层-隐藏层-输出层,他们每一层之间是相互独立地,(框框里面代表同一层),每一次输入生成一个节点,同一层中每个节点之间又相互独立的话&#…

保留网络[02/3]:大型语言模型转换器的继任者”

一、说明 在这项工作中,我们提出保留网络(RETNET)作为基础架构大型语言模型的结构,同时实现训练并行, 推理成本低,性能好。我们从理论上推导出这种联系 复发与关注之间。然后我们提出保留机制 序列建模&…

NLP之RNN的原理讲解(python示例)

目录 代码示例代码解读知识点介绍 代码示例

import numpy as np

import tensorflow as tf

from tensorflow.keras.layers import SimpleRNNCell# 第t时刻要训练的数据

xt tf.Variable(np.random.randint(2, 3, size[1, 1]), dtypetf.float32)

print(xt)

# https://www.cnblog…

Pytorch-基于RNN的不同语种人名生成模型

一、RNN背景介绍

循环神经网络(Recurrent Neural Networks, RNN) 是一种常用的神经网络结构,它源自于1982年由Saratha Sathasivam提出的霍普菲尔德网络。 其特有的循环概念及其最重要的结构——长短时记忆网络——使得它在处理和预测序列数据…

Pytorch intermediate(三) RNN分类

使用RNN对MNIST手写数字进行分类。RNN和LSTM模型结构

pytorch中的LSTM的使用让人有点头晕,这里讲述的是LSTM的模型参数的意义。 1、加载数据集

import torch

import torchvision

import torch.nn as nn

import torchvision.transforms as transforms

import torc…

pytorch笔记:PackedSequence对象送入RNN

pytorch 笔记:PAD_PACKED_SEQUENCE 和PACK_PADDED_SEQUENCE-CSDN博客

当使用pack_padded_sequence得到一个PackedSequence对象并将其送入RNN(如LSTM或GRU)时,RNN内部会进行特定的操作来处理这种特殊的输入形式。 使用PackedSequ…

机器学习笔记:RNN值Teacher Forcing

1 基本介绍

Teacher forcing是一种在训练循环神经网络(RNN)时使用的技术,尤其是在序列生成任务中,如机器翻译、文本生成或语音合成。这种方法的目的是更有效地训练网络预测下一个输出,给定一系列先前的观察结果。

1.…

CNN(卷积神经网络)、RNN(循环神经网络)和GCN(图卷积神经网络)

CNN(卷积神经网络): 区别:CNN主要适用于处理网格状数据,如图像或其他二维数据。它通过卷积层、池化层和全连接层来提取和学习输入数据的特征。卷积层使用卷积操作来捕捉局部的空间结构,池化层用于降低特征图…

笔记51:循环神经网络入门

本地笔记地址:D:\work_file\DeepLearning_Learning\03_个人笔记\3.循环神经网络\循环神经网络

a

a

a

a a a a

a

a

a

a

a

a a a

a

a

a

a

a

a a

a

a

a

a

a

a a

a

a

a

a

a

a a

a

a

a

a

a

a a

a

a

a

a

a

a

机器学习笔记 - Ocr识别中的CTC算法原理概述

一、文字识别 在文本检测步骤中,分割出了文本区域。现在需要识别这些片段中存在哪些文本。

机器学习笔记 - Ocr识别中的文本检测EAST网络概述-CSDN博客文章浏览阅读300次。在 EAST 网络的这个分支中,它合并了 VGG16 网络不同层的特征输出。现在,该层之后的特征大小将等于 p…

TensorFlow实战教程(十九)-Keras搭建循环神经网络分类案例及RNN原理详解

从本专栏开始,作者正式研究Python深度学习、神经网络及人工智能相关知识。前一篇文章分享了卷积神经网络CNN原理,并通过Keras编写CNN实现了MNIST分类学习案例。这篇文章将详细讲解循环神经网络RNN的原理知识,并采用Keras实现手写数字识别的RNN分类案例及可视化呈现。基础性文…

机器学习笔记 - 创建CNN + RNN + CTC损失的模型来识别图像中的文本

我们将创建一个具有CTC损失的卷积循环神经网络来实现我们的OCR识别模型。 一、数据集 我们将使用 Visual Geometry Group 提供的数据。

Visual Geometry Group - University of OxfordComputer Vision group from the University of Oxfordhttps://www.robots.ox.ac.uk/~vgg/d…

循环神经网络-02文本预处理

https://zh-v2.d2l.ai/chapter_recurrent-neural-networks/text-preprocessing.html 本节中,我们将解析文本的常见预处理步骤。 这些步骤通常包括: 将文本作为字符串加载到内存中。 将字符串拆分为词元(如单词和字符)。 建立一个…

NLP-D37-nlp比赛D6-DMN《人类语言处理》05

—0450哎,早上网页打不开,把浏览器缓存都清了。内心想哭呜呜呜

现在开始看DMN了hhh

讲的好好

哈达玛积可以计算相似度吗

不理解,感觉只是做一下input和q的交互??然后让参数自己学习到相似性关系?&#…

循环神经网络-简洁实现

参考: https://zh-v2.d2l.ai/chapter_recurrent-neural-networks/rnn-concise.html https://pytorch.org/docs/stable/generated/torch.nn.RNN.html?highlightrnn#torch.nn.RNN

RNN import torch

from torch import nn

from torch.nn import functional as F

from…

RNN-T Training,RNN-T模型训练详解——语音信号处理学习(三)(选修三)

参考文献: Speech Recognition (option) - RNN-T Training哔哩哔哩bilibili 2020 年 3月 新番 李宏毅 人类语言处理 独家笔记 Alignment Train - 8 - 知乎 (zhihu.com) 本次省略所有引用论文 目录

一、如何将 Alignment 概率加和

对齐方式概率如何计算

概率加和计…

RNN(包括GRU和LSTM)和其他seq2seq/encoder-decoder模型

诸神缄默不语-个人CSDN博文目录

本文主要介绍循环神经网络(RNN)及其在自然语言处理等领域的应用。RNN是一种专门处理序列数据的神经网络,它通过维持一个内部状态来捕捉时间序列信息。特别地,我们会深入探讨RNN的两个重要变体&…

03- LSTM 的从零开始实现

一 长短期记忆算法 简介

LSTM(Long Short-Term Memory)算法是一种常见的循环神经网络(RNN)算法,用于处理序列数据,并且在处理时间序列数据时效果非常好。

LSTM算法的主要思路是在RNN的基础上增加一个记忆…

RWKV论文燃爆!将RNN崛起进行到底!可扩百亿级参数,与Transformer表现相当!

深度学习自然语言处理 原创作者:鸽鸽 万众期待的RWKV论文来啦! 这股RNN崛起的“清流”,由民间开源组织发起,号称是第一个可扩展到百亿级参数的非transformer架构! RWKV结合了RNN和Transformer的优势:一方面…

机器学习--循环神经网络(RNN)1

一、简介

循环神经网络(Recurrent Neural Network)是深度学习领域中一种非常经典的网络结构,在现实生活中有着广泛的应用。以槽填充(slot filling)为例,如下图所示,假设订票系统听到用户说&…

机器学习--循环神经网络(RNN)4

一、RNN的学习方式

如果要做学习,需要定义一个损失函数(loss function)来评估模型的好坏,选一个参数要让损失最小。

以槽填充为例,如上图所示,给定一些句子,给定一些标签,告诉机器…

循环神经网络(1)循环神经网络的记忆能力实验

循环神经网络(Recurrent Neural Network,RNN)是一类具有短期记忆能力的神经网络.在循环神经网络中,神经元不但可以接受其他神经元的信息,也可以接受自身的信息,形成具有环路的网络结构ÿ…

深度学习:基于循环神经网络RNN实现语句生成

目录 1 循环神经网络介绍

1.1 什么是循环神经网络

1.2 RNN的网络结构

1.3 RNN的工作原理

编辑

1.4 RNN的应用场景

2 基于RNN实现语句生成

2.1 句子生成介绍

2.2 基于pytorch实现语句生成

2.3 完整代码

2.4 该模型的局限

3 总结 1 循环神经网络介绍

1.1 什么是循环…

理解RNN以及模型搭建代码

RNN结构

这是一张不直观易懂的RNN结构示意图。但也是大家见得最多结构示意图。 RNN模型解释

RNN一文就讲解清楚的博客,看这里:https://zhuanlan.zhihu.com/p/408998328

RNN为什么梯度消失和梯度爆炸,看这里:https://zhuanlan.z…

LSTM和GRU vs 普通的循环神经网络RNN

1、考虑下列三种情况下,对比一下普通RNN的表现和LSTM和GRU表现:

(1)早期观测值对预测未来观测者具有非常重要的意义。 考虑一个极端情况,其中第一个观测值包含一个校验和, 目标是在序列的末尾辨别校验和是…

论文笔记:详解NEUPSL DSI

《Using Domain Knowledge to Guide Dialog Structure Induction via Neural Probabilistic 》

名词解释

Dialog Structure Induction(DSI)是推断给定目标导向对话的潜在对话结构(即一组对话状态及其时间转换)的任务。它是现代对…

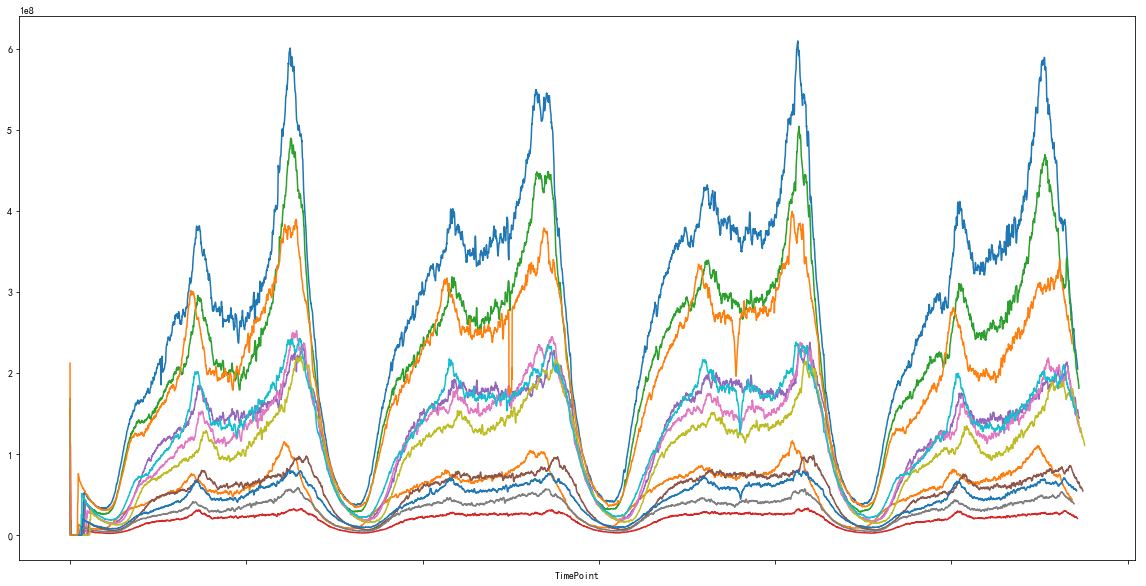

基于OpenAPI工具包以及LSTM的CDN网络流量预测

基于LSTM的CDN网络流量预测

本案例是基于英特尔CDN以及英特尔 OpenAPI Intel Extension for TensorFlow* Intel oneAPIDPC Library 的网络流量预测,CDN是构建在现有网络基础之上的智能虚拟网络,目的是将源站内容分发至最接近用户的节点,使用…

实践:基于双向LSTM模型完成文本分类任务

目录

1 数据处理 1.1 数据加载 1.2 构造Dataset类 1.3 封装DataLoader

2 模型构建

3 模型训练

4 模型评价

5 模型预测

5 拓展实验 5.1 使用Pytorch内置的单向LSTM进行文本分类实验

编辑 5.2 使用Paddle内置的单向LSTM进行文本分类实验 总结 电影评论可以蕴含…

基于LSTM-Adaboost的电力负荷预测的MATLAB程序

微❤关注“电气仔推送”获得资料(专享优惠)

主要内容:

LSTM-AdaBoost负荷预测模型先通过 AdaBoost集成算法串行训练多个基学习器并计算每个基学习 器的权重系数,接着将各个基学习器的预测结果进行线性组合,生成最终的预测结果。代码中的LST…

LSTM长短期记忆网络

LSTM的matlab详解 LSTM(Long Short-Term Memory) 是一种特殊的循环神经网络,它通过引入门机制(gate)来解决传统循环神经网络长序列训练过程中的梯度消失和爆炸问题,从而能够更好地处理序列数据。 LSTM在传…

RNN/LSTM学习记录

一.RNN

什么是循环神经网络:

循环神经网络,从名字上理解“循环”,即为构成一个往复的结构,它有着这样的特点,对时序特征的数据十分敏感,能够挖掘出数据中的书序信息以及语义信息。

什么是序列特性呢&…

【深度学习实验】循环神经网络(二):使用循环神经网络(RNN)模型进行序列数据的预测

目录

一、实验介绍

二、实验环境

1. 配置虚拟环境

2. 库版本介绍

三、实验内容

0. 导入必要的工具包

1. RNN模型

a. 初始化__init__

b. 前向传播方法forward

2. 训练和预测

a. 超参数

b. 创建模型实例

c. 模型训练

d. 预测结果可视化

3. 代码整合 经验是智慧之父…

【MATLAB第88期】基于MATLAB的6种神经网络(ANN、FFNN、CFNN、RNN、GRNN、PNN)多分类预测模型对比含交叉验证

【MATLAB第88期】基于MATLAB的6种神经网络(ANN、FFNN、CFNN、RNN、GRNN、PNN)多分类预测模型对比含交叉验证

前言

本文介绍六种类型的神经网络分类预测模型

1.模型选择 前馈神经网络 (FFNN) 人工神经网络 (ANN) 级联前向神经网络 (CFNN) 循环神经网…

第五周:深度学习知识点回顾

前言: 讲真,复习这块我是比较头大的,之前的线代、高数、概率论、西瓜书、樱花书、NG的系列课程、李宏毅李沐等等等等…那可是花了三年学习佳实践下来的,现在一想脑子里就剩下几个名词就觉得废柴一个了,朋友们有没有同感…

卷积神经网络(CNN)、循环神经网络(RNN)和自注意力(self-attention)对比

考虑同一个的问题:将由个词元组成的序列映射到另一个长度相同的序列,其中的每个输入词元或输出词元由维向量表示。 我们将比较能够解决上述问题的三种常用方法:卷积神经网络(CNN)、循环神经网络(RNN&#x…

【机器学习】循环神经网络(二)-LSTM示例(keras)国际航空乘客问题的回归问题...

使用 Keras 在 Python 中使用 LSTM 循环神经网络进行时间序列预测 国际航空乘客问题的回归问题 这个文件是一个CSV格式的数据集,它包含了从1949年1月到1960年12月的每个月的国际航空乘客的总数(以千为单位)。第一行是列名,分别是&…

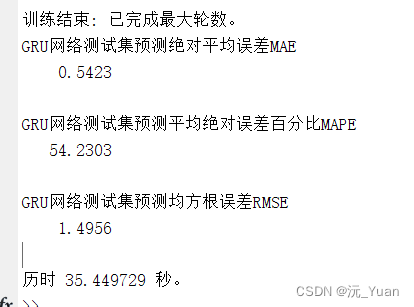

2024/1/14周报

文章目录 摘要Abstract文献阅读题目问题与创新方法A.CEMDAN方法B.LSTM网络C. CEEMDAN-LSTM模型 实验过程数据集与数据预处理参数设置评价指标和参数 实验结果 深度学习GRUGRU前向传播GRU的训练过程 总结 摘要

本周阅读了一篇基于CEEMDAN-LSTM的金融时间序列预测模型的文章&…

递归神经网络 (RNN)

弗朗西斯科佛朗哥 一、说明 循环神经网络非常有趣,因为与前馈网络不同,在前馈网络中,数据只能在一个方向上传播,每个神经元可以与连续层的一个或多个神经元连接,在这种类型的网络中,神经元还可以环回自身或…

基于LSTM encoder-decoder模型实现英文转中文的翻译机器

前言

神经网络机器翻译(NMT, neuro machine tranlation)是AIGC发展道路上的一个重要应用。正是对这个应用的研究,发展出了注意力机制,在此基础上产生了AIGC领域的霸主transformer。我们今天先把注意力机制这些东西放一边,介绍一个对机器翻译…

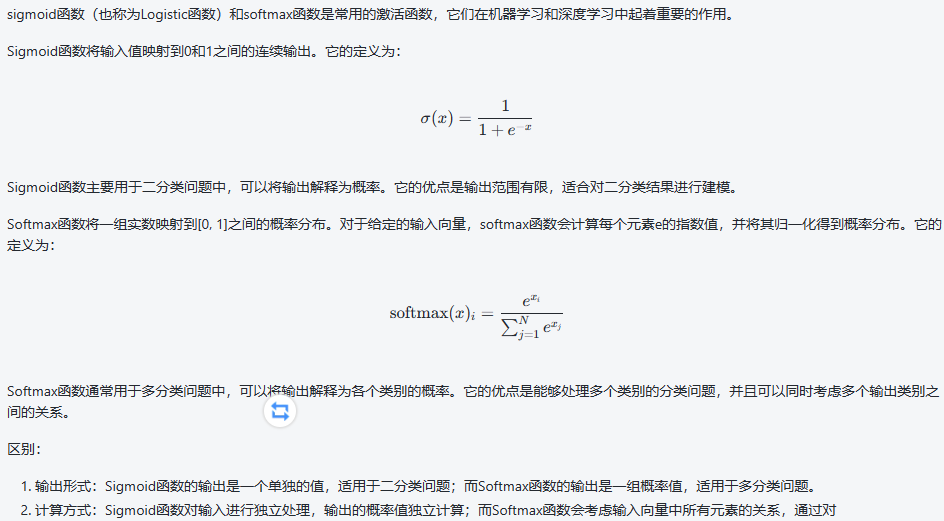

激活函数作用以及 sigmoid和softmax

激活函数

激活函数在神经网络中起着非常重要的作用,它的主要功能是引入非线性性质,使得神经网络可以学习和表示更加复杂的模式和关系。下面是激活函数的几个主要作用:

引入非线性:激活函数通过引入非线性变换,打破了…

自然语言处理的技术进步与应用领域的拓展

文章目录

技术进步:推动NLP前行的关键技术

应用场景:NLP技术的实际应用

挑战与前景:NLP的未来发展

未来的发展趋势可能包括

总结 技术进步:推动NLP前行的关键技术

自然语言处理(NLP)是计算机科学和人…

LSTM的多变量时间序列预测(北京PM2.5预测)

参考博客 文章目录 LSTM简介数据集简介数据预处理多元LSTM预测模型数据准备:定义和拟合模型评估模型 训练多个滞后时间步 LSTM简介 LSTM(Long Short-Term Memory)是一种特殊类型的循环神经网络(RNN),它在处…

循环神经网络(RNN)与长短期记忆网络(LSTM)

前言: 通过前面的学习,我们以BP神经网络为基础,认识到了损失函数,激活函数,以及梯度下降法的原理;而后学习了卷积神经网络,知道图像识别是如何实现的。今天这篇文章,讲述的就是计算机…

循环神经网络RNN专题(01/6)

一、说明 RNN用于处理序列数据。在传统的神经网络模型中,是从输入层到隐含层再到输出层,层与层之间是全连接的,每层之间的节点是无连接的。但是这种普通的神经网络对于很多问题却无能无力。例如,你要预测句子的下一个单词是什么&a…

循环神经网络 - RNN

循环神经网络(Rerrent Neural Network,RNN)是神经网络的一种,类似的还有深度神经网络(DNN)、卷积神经网路(CNN)、生成对抗网络(GAN)等。**RNN对具有时序特性的数据非常有成效,他能挖掘数据中的时…

深度学习本科课程 实验5 循环神经网络

循环神经网络实验

任务内容

理解序列数据处理方法,补全面向对象编程中的缺失代码,并使用torch自带数据工具将数据封装为dataloader分别采用手动方式以及调用接口方式实现RNN、LSTM和GRU,并在至少一种数据集上进行实验从训练时间、预测精度、…

百面深度学习-循环神经网络

循环神经网络

什么是循环神经网络?

循环神经网络(Recurrent Neural Network,RNN)是一类用于处理序列数据的神经网络。你可以将它想象成一个机器,它不仅考虑当前的输入,还考虑之前接收过的输入。这使得它非…

深度学习(CNN+RNN)笔记2

文章目录 第五课:序列模型(Sequence Models)第一周:循环神经网络(Recurrent Neural Networks)【序列模型、语言模型序列生成、对新序列采样。RNN、GRU、LSTM、双向RNN、深度RNN】第二周:自然语言处理与词嵌入ÿ…

深度学习之四(循环神经网络Recurrent Neural Networks,RNNs)

概念

循环神经网络(Recurrent Neural Networks,RNNs)是一类专门用于处理序列数据的神经网络,它在处理时考虑了序列数据的顺序和上下文信息。RNNs 在自然语言处理、时间序列分析、语音识别等领域得到广泛应用。

1. 基本结构:

RNN 的基本结构包含一个或多个循环单元,每个…

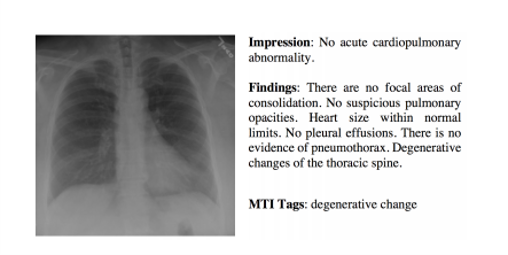

【医学大模型 补全主诉】BioGPT + LSTM 自动补全医院紧急部门主诉

BioGPT LSTM 自动补全医院紧急部门主诉 问题:针对在紧急部门中自动补全主诉的问题子问题1: 提高主诉记录的准确性子问题2: 加快主诉记录的速度子问题3: 统一医疗术语的使用子问题4: 减少打字错误和误解子问题5: 提高非特定主诉的处理能力 解法数据预处理神经网络方…

算法项目(2)—— LSTM、RNN、GRU(SE注意力)、卡尔曼轨迹预测

本文包含什么? 项目运行的方式(包教会)项目代码LSTM、RNN、GRU(SE注意力)、卡尔曼四种算法进行轨迹预测.各种效果图运行有问题? csdn上后台随时售后.项目说明

本文实现了三种深度学习算法加传统算法卡尔曼滤波进行轨迹预测, 预测效果图 首先看下不同模型的指标: 模型RM…

深度学习之循环神经网络

视频链接:6 循环神经网络_哔哩哔哩_bilibili

给神经网络增加记忆能力 对全连接层而言,输入输出的维数固定,因此无法处理序列信息

对卷积层而言,因为卷积核的参数是共享的,所以卷积操作与序列的长度无关。但是因为卷积…

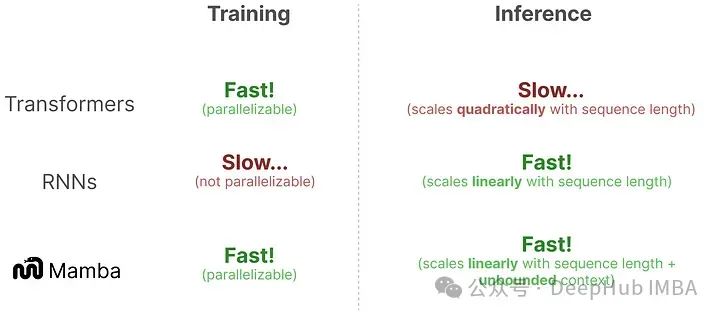

Mamba详细介绍和RNN、Transformer的架构可视化对比

Transformer体系结构已经成为大型语言模型(llm)成功的主要组成部分。为了进一步改进llm,人们正在研发可能优于Transformer体系结构的新体系结构。其中一种方法是Mamba(一种状态空间模型)。 Mamba: Linear-Time Sequence Modeling with Select…

基于pytorch 的RNN实现字符级姓氏文本分类

当使用基于PyTorch的RNN实现字符级姓氏文本分类时,我们可以使用一个非常简单的RNN模型来处理输入的字符序列,并将其应用于姓氏分类任务。下面是一个基本的示例代码,包括数据预处理、模型定义和训练过程。

首先,我们需要导入必要的…

基于pytorch 的RNN实现文本分类

首先,需要导入必要的库,包括torch、torchtext、numpy等:

import torch

import torch.nn as nn

import torch.optim as optim

import numpy as np

from torchtext.datasets import AG_NEWS

from torchtext.data.utils import get_tokenizer

f…

RNN介绍及Pytorch源码解析

介绍一下RNN模型的结构以及源码,用作自己复习的材料。

RNN模型所对应的源码在:\PyTorch\Lib\site-packages\torch\nn\modules\RNN.py文件中。

RNN的模型图如下: 源码注释中写道,RNN的数学公式: 表示在时刻的隐藏状态…

【期末复习向】走进循环神经网络系列-RNN,LSTM,GRU

RNN

上篇文章复习了最简单的神经网络MLP,它是由输入层,隐藏层和输出层构成的。当然这也是所有神经网络最基本的架构。但是MLP过于简单,存在的问题之一就是无法考虑全局的信息,也就是前后输入的信息,这对于解决时间序列…

LSTM和GRU的区别

LSTM(Long Short-Term Memory)和GRU(Gated Recurrent Unit)都是循环神经网络(RNN)的变体,旨在解决传统RNN中的梯度消失和梯度爆炸的问题,使网络能够更好地处理长期依赖关系。

以下是…

《PyTorch深度学习实践》第十二讲循环神经网络基础

一、RNN简介

1、RNN网络最大的特点就是可以处理序列特征,就是我们的一组动态特征。比如,我们可以通过将前三天每天的特征(是否下雨,是否有太阳等)输入到网络,从而来预测第四天的天气。 我们可以看RN…

【深度学习:Recurrent Neural Networks】循环神经网络(RNN)的简要概述

【深度学习】循环神经网络(RNN):连接过去与未来的桥梁 循环神经网络简介什么是循环神经网络 (RNN)?传统 RNN 的架构循环神经网络如何工作?常用激活函数RNN的优点和缺点RNN 的优点:RNN 的缺点: 循…

动手学深度学习—循环神经网络RNN详解

循环神经网络 循环神经网络的步骤:

处理数据 将数据按照批量大小和时间步数进行处理,最后得到迭代器,即每一个迭代的大小是批量大小时间步数,迭代次数根据整个数据的大小决定,最后得出处理的数据(参照第三…

动手学深度学习-现代循环神经网络(GRU、LSTM、编码器-解码器等)

现代循环神经网络

上一章节(循环神经网络)介绍了循环神经网络的基础知识,这种网络可以更好的处理序列数据。我们在文本数据上实现了基于循环神经网络的语言模型,但是对于当今各种各样的序列学习问题,这些技术可能不够…

RNN文本分类任务实战

递归神经网络 (RNN): 定义:RNN 是一类专为顺序数据处理而设计的人工神经网络。 顺序处理:RNN 保持一个隐藏状态,该状态捕获有关序列中先前输入的信息,使其适用于涉及顺序依赖关系的任务。词嵌入…

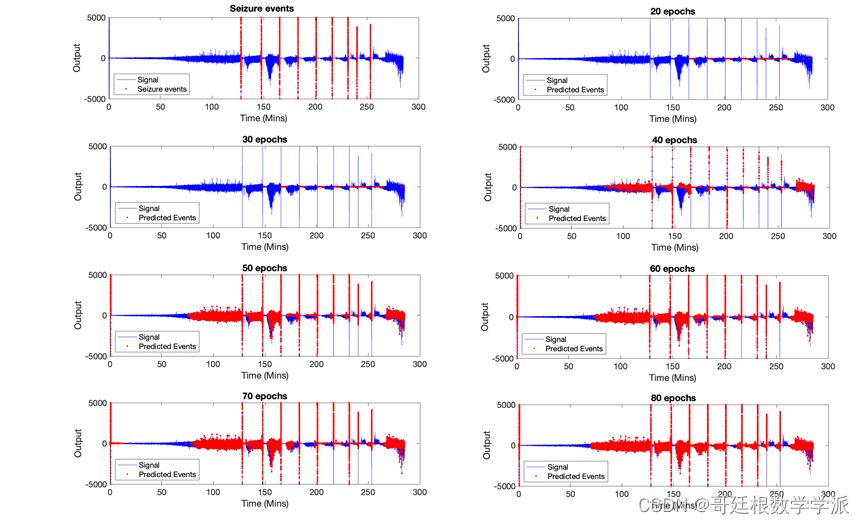

MATLAB环境下基于LSTM模型的癫痫发作检测方法

癫痫预测研究是利用脑电信号对癫痫发病过程做出及时的预测以促进癫痫发病的防治,这一研究的重点在于充分利用癫痫发生前后人体大脑产生的脑电信号。但截至上世纪九十年代初期,医学工作者及相关领域的专家们仍然相信癫痫病的发生过程是一种突发的、毫无规…

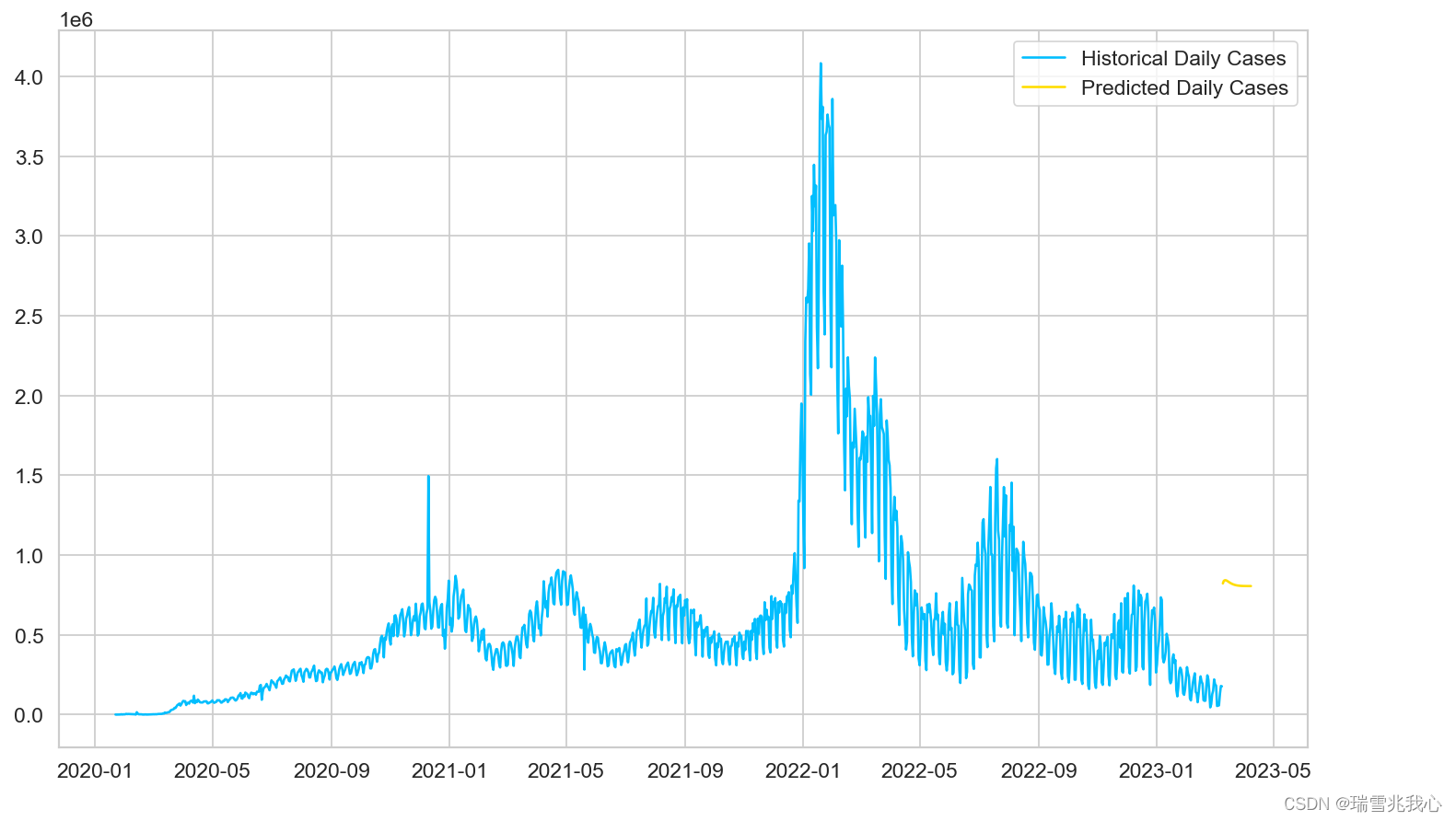

LSTM实战:基于PyTorch的新冠疫情确诊人数预测

目录

引言

一、探索数据集

1、导入相关库文件

2、导入每日确诊人数数据集

3、清洗每日确诊人数数据集

4、每日累计确诊的人数及其数据集可视化

5、每日撤消累计后的确诊人数及其数据集可视化

6、查看总共有多少数据量

二、数据预处理

1、训练和测试数据集

2、数据放…

机器学习--循环神经网络(RNN)3

本篇文章结合具体的例子来介绍一下LSTM运算方式以及原理。请结合上篇文章的介绍食用。

一、具体例子 如上图所示,网络里面只有一个 LSTM 的单元,输入都是三维的向量,输出都是一维的输出。 这三维的向量跟输出还有记忆元的关系是这样的。 假设…

机器学习--循环神经网路(RNN)2

在这篇文章中,我们介绍一下其他的RNN。

一.深层RNN

循环神经网络的架构是可以任意设计的,之前提到的 RNN 只有一个隐藏层,但 RNN 也可以是深层的。比如把 xt 丢进去之后,它可以通过一个隐藏层,再通过第二个隐藏层&am…

RNN 和 Transformer 复杂度比较

这里假设BatchSize为 1,就是单样本的情况。

原始 RNN 块:

(1)单步计算 H,包含两个矩阵向量乘法,和一个激活,复杂度HidSize

(2)一共有SeqLen步,所以整体复杂…

AIGC实战——改进循环神经网络

AIGC实战——改进循环神经网络 0. 前言1. 堆叠循环网络2. 门控制循环单元3. 双向单元相关链接 0. 前言

我们已经学习了如何训练长短期记忆网络 (Long Short-Term Memory Network, LSTM) 模型,以学习使用给定风格生成文本,接下来,我们将学习如…

【深度学习笔记】6_5 RNN的pytorch实现

注:本文为《动手学深度学习》开源内容,部分标注了个人理解,仅为个人学习记录,无抄袭搬运意图 6.5 循环神经网络的简洁实现

本节将使用PyTorch来更简洁地实现基于循环神经网络的语言模型。首先,我们读取周杰伦专辑歌词…

【深度学习笔记】6_10 双向循环神经网络bi-rnn

注:本文为《动手学深度学习》开源内容,部分标注了个人理解,仅为个人学习记录,无抄袭搬运意图 6.10 双向循环神经网络

之前介绍的循环神经网络模型都是假设当前时间步是由前面的较早时间步的序列决定的,因此它们都将信…

循环神经网络-单变量序列预测详解(pytorch)

参考博客 文章目录 (1)导入所需要的包(2)读取数据并展示(3)数据预处理(4)划分训练集和测试集(5)构建RNN回归模型(6)构造训练函数&…

GRU-深度学习循环神经网络情感分类模型搭建

摘要:

本文详细介绍了基于GRU的深度学习循环神经网络在情感分类任务中的应用,涵盖基础知识回顾、功能实现、技巧与实践、性能优化与测试,以及常见问题解答等环节。

阅读时长:约30分钟 关键词:GRU, 深度学习, 循环神经…

【深度学习笔记】6_9 深度循环神经网络deep-rnn

注:本文为《动手学深度学习》开源内容,部分标注了个人理解,仅为个人学习记录,无抄袭搬运意图 6.9 深度循环神经网络

本章到目前为止介绍的循环神经网络只有一个单向的隐藏层,在深度学习应用里,我们通常会用…

理解LSTM一种递归神经网络(RNN)

1 递归神经网络结构

一个简单的传统神经网络结构如下图所示: 给他一些输入x0,x1,x2 … xt, 经过神经元作用之后得到一些对应的输出h0,h1,h2 … ht。每次的训练,神经元和神经元之间不需要传递任何信息。

递归神经网络和传统神经网络不同的一个点在于&am…

[自用代码]基于LSTM的广州车牌售价预测

文章目录 1. 数据2. 代码 明天是拍牌日了,用AI协助生成了一段时间序列预测代码,主要是用来预测明天车牌均价。其实做的挺low的,没有考虑多维数据之间的关系以及社会事件影响,仅仅是单步预测,偏差是挺大的,符…

大白话介绍循环神经网络

循环神经网络实质为递归式的网络,它在处理时序任务表现出优良的效果,毕竟递归本来就是一步套一步的向下进行,而自然语言处理任务中涉及的文本天然满足这种时序性,比如我们写字就是从左到右一步步来的鸭,刚接触深度学习…

深度学习面经-part3(RNN、LSTM)

3.RNN

核心思想:像人一样拥有记忆能力。用以往的记忆和当前的输入,生成输出。

RNN 和 传统神经网络 最大的区别:在于每次都会将前一次的输出结果,带到下一次的隐藏层中,一起训练。 RNN应用场景:

1.文本生成 2.语音识别 3.机器翻…

神经网络 | CNN 与 RNN——深度学习主力军

Hi,大家好,我是半亩花海。本文主要将卷积神经网络(CNN)和循环神经网络(RNN)这两个深度学习主力军进行对比。我们知道,从应用方面上来看,CNN 用于图像识别较多,而 RNN 用于…

CRNN介绍:用于识别图中文本的深度学习模型

CRNN:用于识别图中文本的深度学习模型 CRNN介绍:用于识别图中文本的深度学习模型CRNN的结构组成部分工作原理 CRNN结构分析卷积层(Convolutional Layers)递归层(Recurrent Layers)转录层(Transc…

深度学习入门笔记(八)可以不断思考的模型:RNN与LSTM

8.1 循环神经网络RNN

之前学到的 CNN 和全连接,模型的输入数据之间是没有关联的,比如图像分类,每次输入的图片与图片之间就没有任何关系,上一张图片的内容不会影响到下一张图片的结果。但在自然语言处理领域,这就成了…

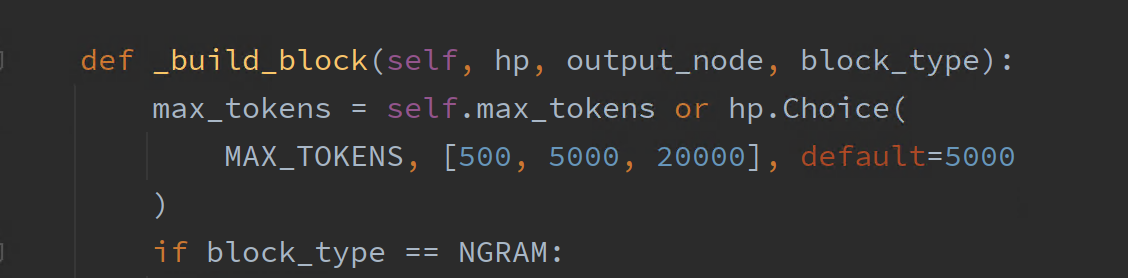

【AutoML】AutoKeras 进行 RNN 循环神经网络训练

由于最近这些天都在人工审查之前的哪些问答数据,所以迟迟都没有更新 AutoKeras 的训练结果。现在那部分数据都已经整理好了,20w 的数据最后能够使用的高质量数据只剩下 2k。这 2k 的数据已经经过数据校验并且对部分问题的提问方式和答案内容进行了不改变…

使用LSTM(长短期记忆)模型处理文本数据的典型流程

目的是将原始文本数据转换成适合LSTM模型处理的格式,并通过模型进行特征提取和分析,以完成各种自然语言处理任务: 原始文本(Raw Text):这是原始的文本数据,可能是一段文章、对话或任何其他形式的…

Transformer的前世今生 day06(Self-Attention和RNN、LSTM的区别

Self-Attention和RNN、LSTM的区别

RNN的缺点:无法做长序列,当输入很长时,最后面的输出很难参考前面的输入,即长序列会缺失上文信息,如下: 可能一段话超过50个字,输出效果就会很差了 LSTM通过忘…

Transformer的前世今生 day06(Self-Attention和RNN、LSTM的区别)

Self-Attention和RNN、LSTM的区别

RNN的缺点:无法做长序列,当输入很长时,最后面的输出很难参考前面的输入,即长序列会缺失上文信息,如下: 可能一段话超过50个字,输出效果就会很差了 LSTM通过忘…

8.6 循环神经网络的简洁实现

每个步长共用参数

加载数据

虽然 8.5节 对了解循环神经网络的实现方式具有指导意义,但并不方便。 本节将展示如何使用深度学习框架的高级API提供的函数更有效地实现相同的语言模型。 我们仍然从读取时光机器数据集开始。

import torch

from torch import nn

from…

【深度学习】图像自然语言描述生成

案例 6:图像自然语言描述生成(让计算机“看图说话”)

相关知识点:RNN、Attention 机制、图像和文本数据的处理

1 任务目标

1.1 任务和数据简介

本次案例将使用深度学习技术来完成图像自然语言描述生成任务,输入…

《PyTorch深度学习实践》第十三讲RNN进阶

一、

双向循环神经网络(Bidirectional Recurrent Neural Network,BiRNN)是一种常见的循环神经网络结构。与传统的循环神经网络只考虑历史时刻的信息不同,双向循环神经网络不仅考虑历史时刻的信息,还考虑未来时刻的信息…

神经网络学习笔记10——RNN、ELMo、Transformer、GPT、BERT

系列文章目录

参考博客1

参考博客2 文章目录 系列文章目录前言一、RNN1、简介2、模型结构3、RNN公式分析4、RNN的优缺点及优化1)LSTM是RNN的优化结构2)GRU是LSTM的简化结构 二、ELMo1、简介2、模型结构1)输入2)左右双向上下文信…

一文弄懂FFN/RNN/CNN参数量计算

1. 引言

为什么我们需要了解计算深度学习模型中的参数数量?我们一般情况下是不需要这么做的。但是,如果我们需要减小模型的大小,甚至缩短模型推理所需的时间,那么了解模型量化前后的参数数量就会派上用场。

计算深度学习模型中的…

【探索AI】二十一 深度学习之第4周:循环神经网络(RNN)与长短时记忆(LSTM)

循环神经网络(RNN)与长短时记忆(LSTM) RNN的基本原理与结构LSTM的原理与实现序列建模与文本生成任务实践:使用RNN或LSTM进行文本分类或生成任务步骤 1: 数据准备步骤 2: 构建模型步骤 3: 定义损失函数和优化器步骤 4: …

基于Python实现电商订单的数据分析

基于Python实现电商订单的数据分析 数据集:技术:功能:创新点:明确需求和目的: 数据集:

项目使用一家全球超市4年内的电商销售订单数据,数据集名为superstore_dataset2011-2015.csv。数据集共有…

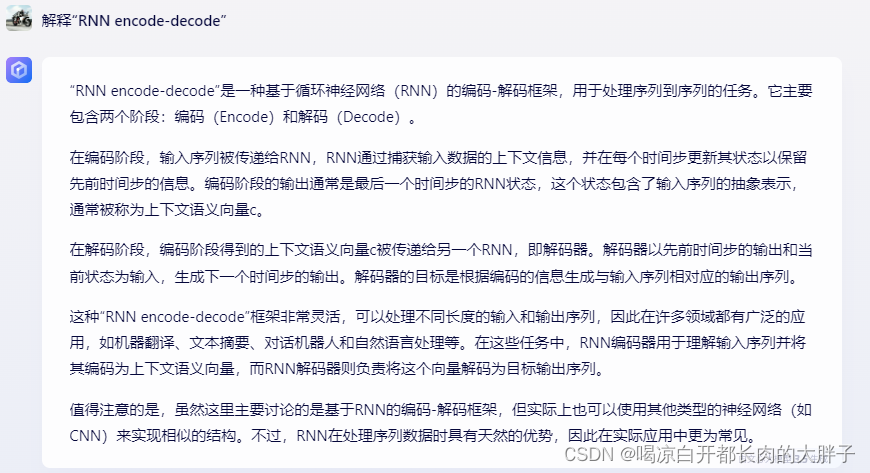

解释“RNN encode-decode”

“RNN encode-decode” 涉及使用循环神经网络(Recurrent Neural Network,RNN)来执行编码和解码操作。这种结构常用于处理序列数据,例如自然语言处理、语音识别和时间序列预测等任务。

以下是 “RNN encode-decode” 的一般概念&a…

基于LSTM实现春联上联对下联

按照阿光的项目做出了学习笔记,pytorch深度学习实战项目100例

基于LSTM实现春联上联对下联

基于LSTM(长短期记忆网络)实现春联上联对下联是一种有趣且具有挑战性的任务,它涉及到自然语言处理(NLP)中的序列…

目标检测C-RNN,Fast C-RNN,Faster C-RNN,SSD,Mask R-CNN 理论简单介绍

参考: https://zh-v2.d2l.ai/chapter_computer-vision/multiscale-object-detection.html

R-CNN 及系列

区域卷积神经网络 region-based CNN

R-CNN

R-CNN首先从输入图像中选取若干(例如2000个)提议区域,并标注它们的类别和边界…

贝叶斯优化的门控循环神经网络BO-GRU(时序预测)的Matlab实现

贝叶斯优化的门控循环神经网络(BO-GRU)是一种结合了贝叶斯优化(Bayesian Optimization, BO)和门控循环单元(Gated Recurrent Unit, GRU)的模型,旨在进行时序预测。这种模型特别适用于时间序列数…

自然语言处理实验2 字符级RNN分类实验

实验2 字符级RNN分类实验 必做题: (1)数据准备:academy_titles.txt为“考硕考博”板块的帖子标题,job_titles.txt为“招聘信息”板块的帖子标题,将上述两个txt进行划分,其中训练集为70%…

【全面了解自然语言处理三大特征提取器】RNN(LSTM)、transformer(注意力机制)、CNN

目录 一 、RNN1.RNN单个cell的结构2.RNN工作原理3.RNN优缺点 二、LSTM1.LSTM单个cell的结构2. LSTM工作原理 三、transformer1 Encoder(1)position encoding(2)multi-head-attention(3)add&norm 残差链…

【循环神经网络rnn】一篇文章讲透

目录

引言

二、RNN的基本原理

代码事例

三、RNN的优化方法

1 长短期记忆网络(LSTM)

2 门控循环单元(GRU)

四、更多优化方法

1 选择合适的RNN结构

2 使用并行化技术

3 优化超参数

4 使用梯度裁剪

5 使用混合精度训练

…

基于CNN-RNN的动态手势识别系统构建与应用

一、引言 随着人机交互技术的不断发展,动态手势识别成为了近年来的研究热点。动态手势识别技术能够识别和理解人类的手势动作,从而实现更自然、更直观的人机交互。本文旨在构建一种基于CNN-RNN的动态手势识别系统,以提高手势识别的准确性和实…

基于CNN-RNN的动态手势识别系统实现与解析

一、环境配置

为了成功实现基于CNN-RNN的动态手势识别系统,你需要确保你的开发环境已经安装了以下必要的库和工具: Python:推荐使用Python 3.x版本,作为主要的编程语言。TensorFlow:深度学习框架,用于构建…

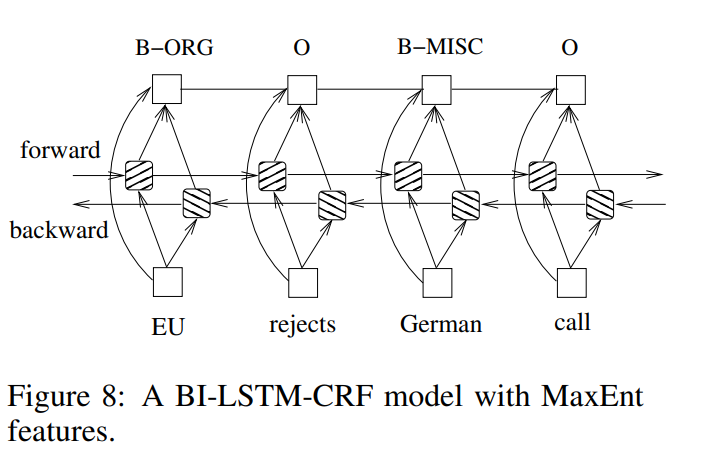

Bi-LSTM-CRF:其结合了 BI-LSTM 的上下文捕获能力和 CRF 的标签关系建模

Bi-LSTM-CRF:其结合了 BI-LSTM 的上下文捕获能力和 CRF 的标签关系建模 提出背景LSTM网络双向LSTM网络 (BI-LSTM)CRF网络LSTM-CRF网络双向LSTM-CRF网络 (BI-LSTM-CRF) 效果对比结构对比 论文:https://arxiv.org/pdf/1508.01991.pdf

代码:htt…

循环神经网络(RNN):处理序列数据的利器

目录

1. 引言

2.RNN原理与时间步展开

3.LSTM与GRU工作机制与优势

3.1.LSTM(Long Short-Term Memory)

3.2.GRU(Gated Recurrent Unit)

4.应用案例

4.1文本生成

4.2情感分析 5.总结 1. 引言 循环神经网络(Recurr…

【机器学习】循环神经网络(四)-应用

五、应用-语音识别 5.1 语音识别问题 详述语音识别的经典方法GMMHMM框架 5.2 深度模型 详述DNN-HMM结构 循环神经网络与CTC技术结构用于语音识别问题 六、自然语言处理 RNN-LM建模方法 6.1 中文分词 6.2 词性标注 6.3 命名实体识别 详述LSTMCRF进行命名实体识别的方法 6.4 文本…

RNN简介(深入浅出)

目录 简介1. 基本理论 简介

要快速掌握RNN,可以考虑以下步骤:

学习基本理论:了解RNN的原理、结构和工作原理。掌握RNN的输入输出形式、时间步、隐藏状态、记忆单元等关键概念。学习常见的RNN变体:了解LSTM(Long Shor…

深度学习知识总结2:主要涉及深度学习基础知识、卷积神经网络和循环神经网络

往期链接:Summer 1 : Summarize linear neural networks and multi-layer perceptron

Summer 2: Summarize CNN and RNN 文章目录 Summer 2: Summarize CNN and RNNPart 1 Deep Learning> 层和块> 参数管理和延后初始化> 读写文件和GPU Part 2 CNN> 从…

复试专业前沿问题问答合集8-3——RNN、Hadoop、GPT大语言模型

复试专业前沿问题问答合集8-3——RNN、Hadoop、GPT大语言模型

深度学习中的的RNN、Hadoop、GPT大语言模型的原理关系问答:

GPT(Generative Pre-trained Transformer)和RNN(Recurrent Neural Network)是两种在自然语言处理(NLP)领域广泛使用的深度学习模型。它们在处理…

【动手学深度学习-pytorch】 9.4 双向循环神经网络

在序列学习中,我们以往假设的目标是: 在给定观测的情况下 (例如,在时间序列的上下文中或在语言模型的上下文中), 对下一个输出进行建模。 虽然这是一个典型情景,但不是唯一的。 还可能发生什么其…

【算法小记】深度学习——循环神经网络相关原理与RNN、LSTM算法的使用

文中程序以Tensorflow-2.6.0为例 部分概念包含笔者个人理解,如有遗漏或错误,欢迎评论或私信指正。 卷积神经网络在图像领域取得了良好的效果,卷积核凭借优秀的特征提取能力通过深层的卷积操作可是实现对矩形张量的复杂计算处理。但是生活中除…

[oneAPI] 使用字符级 RNN 生成名称

[oneAPI] 使用字符级 RNN 生成名称 oneAPI特殊写法使用字符级 RNN 生成名称Intel Optimization for PyTorch数据下载加载数据并对数据进行处理创建网络训练过程准备训练训练网络 结果 参考资料 比赛:https://marketing.csdn.net/p/f3e44fbfe46c465f4d9d6c23e38e0517…

深度学习PyTorch 之 RNN-中文多分类

关于RNN的理论部分我们已经在前面介绍过,所以这里直接上代码

1、 数据部分

1.1 读取数据

# 加载数据

data_path ./data/news.csv

data pd.read_csv(data_path)# 预览数据的前几行

data.head()数据是csv格式,只有两列,第一列是标签&#…

循环神经网络--01 序列模型

生成数据

import torch

from torch import nn

from d2l import torch as d2lT 1000

time torch.arange(1,T1,dtypetorch.float32)

x torch.sin(0.01*time)torch.normal(0,0.2,(T,))

d2l.plot(time,x,time,xlim[1,1000],figsize(6,3))将序列转换为特征-标签对(fe…

深入探索长短期记忆网络(LSTM)

目录

1. 引言

2. LSTM的原理

2.1 循环神经网络(RNN)的问题

2.2 LSTM的解决方案

2.3 主要组件

3. LSTM的结构

4. LSTM的训练方法

4.1 损失函数

4.2 参数优化

4.3 初始化

5. LSTM的应用场景

5.1 自然语言处理(NLP)

5.2…

【VIP专属】Python应用案例——基于TensorFlow 2.3建立RNN搭配Word2Vec Embedding进行文本分类

目录

一、数据准备

二、实验流程

1、加载数据集

2、分词处理

循环神经网络:揭秘长期记忆的魔法之源

在人工智能和机器学习领域,循环神经网络(Recurrent Neural Networks,简称RNN)以其独特的架构和机制,在处理序列数据方面展现出了强大的能力。特别值得一提的是,RNN能够学习到长期的记忆,这使得它…

NLP_循环神经网络(RNN)

文章目录 RNN结构RNN实战RNN小结 RNN结构

NPLM 在处理长序列时会面临一些挑战。首先,由于它仍然是基于词的模型,因此在处理稀有词汇或者词汇表外的词汇时效果不佳。其次,NPLM不能很好地处理长距离依赖关系。而上面这两个局限,恰恰…

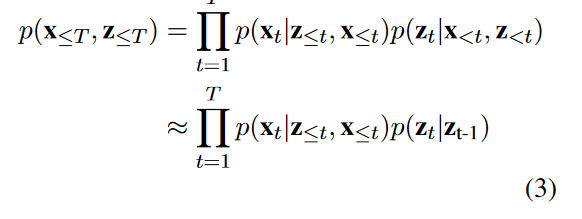

论文《A recurrent latent variable model for sequential data》笔记:详解VRNN

A recurrent latent variable model for sequential data

背景

1 通过循环神经网络的序列建模

循环神经网络(RNN)可以接收一个可变长度的序列 x ( x 1 , x 2 , . . . , x T ) x (x_1, x_2, ..., x_T) x(x1,x2,...,xT)作为输入,并通…

《动手学深度学习 Pytorch版》 8.6 循环神经网络的简洁实现

import torch

from torch import nn

from torch.nn import functional as F

from d2l import torch as d2lbatch_size, num_steps 32, 35

train_iter, vocab d2l.load_data_time_machine(batch_size, num_steps)8.6.1 定义模型

num_hiddens 256

rnn_layer nn.RNN(len(voca…

pytorch学习——循环神经网络RNN讲解及其实现

参考书籍:8.6. 循环神经网络的简洁实现 — 动手学深度学习 2.0.0 documentation 参考视频:54 循环神经网络 RNN【动手学深度学习v2】_哔哩哔哩_bilibili 一.介绍 循环神经网络RNN(Recurrent Neural Network )是一类广泛应用于序列…

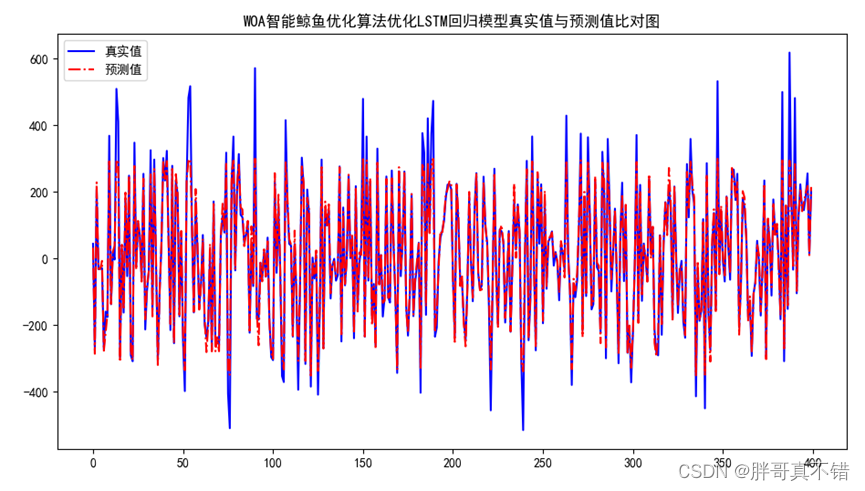

Python实现WOA智能鲸鱼优化算法优化循环神经网络回归模型(LSTM回归算法)项目实战

说明:这是一个机器学习实战项目(附带数据代码文档视频讲解),如需数据代码文档视频讲解可以直接到文章最后获取。 1.项目背景

鲸鱼优化算法 (whale optimization algorithm,WOA)是 2016 年由澳大利亚格里菲斯大学的Mirjalili 等提…

循环神经网络(RNN)简介与应用

循环神经网络(RNN)简介与应用 一、RNN基本概念二、RNN原理解析2.1 RNN网络结构RNN网络主要组件输入层(Input),隐藏层(Hidden State),输出层(Output)循环单元(Recurrent Unit)权重参数(Weights)和偏置项(Bias) RNN的数据流向时间步…

Mamba 基础讲解【SSM,LSSL,S4,S5,Mamba】

文章目录 Mamba的提出动机TransformerRNN Mama的提出背景状态空间模型 (The State Space Model, SSM)线性状态空间层 (Linear State-Space Layer, LSSL)结构化序列空间模型 (Structured State Spaces for Sequences, S4) Mamba的介绍Mamba的特性一&#…

循环神经网络RNN用于分类任务

RNN是一类拥有隐藏状态,允许以前的输出可用于当前输入的神经网络, 输入一个序列,对于序列中的每个元素与前一个元素的隐藏状态一起作为RNN的输入,通过计算当前的输出和隐藏状态。当前的影藏状态作为下一个单元的输入... RNN的种类…

【NLP5-RNN模型、LSTM模型和GRU模型】

RNN模型、LSTM模型和GRU模型

1、什么是RNN模型

RNN(Recurrent Neural Network)中文称为循环神经网络,它一般以序列数据为输入,通过网络内部的结构设计有效捕捉序列之间的关系特征,一般也是以序列形式进行输出

RNN的循环机制使模…

RNN、Seq2Seq、Transformers:NLP 中常用的神经架构简介

循环神经网络是一类神经架构,具有很酷的特性——循环机制——这使得它们成为处理可变长度的顺序数据的自然选择。与标准神经网络不同,RNN 可以在接受新输入的同时保留前一层的信息。

这是它的工作原理 假设我们正在构建一个电子商务聊天机器人ÿ…

【NLP笔记】RNN总结

文章目录 经典RNN单向RNN双向RNNDeep RNNRNN特性总结 变体RNNLSTMGRU 参考及转载内容: 循环神经网络(RNN)深度学习05-RNN循环神经网络完全理解RNN(循环神经网络) 传统的CNN(Covolutional Neural Network&am…

计算机视觉与深度学习-循环神经网络与注意力机制-RNN(Recurrent Neural Network)、LSTM-【北邮鲁鹏】

目录 举例应用槽填充(Slot Filling)解决思路方案使用前馈神经网络输入1-of-N encoding(One-hot)(独热编码) 输出 问题 循环神经网络(Recurrent Neural Network,RNN)定义如何工作深度Elman Netwo…

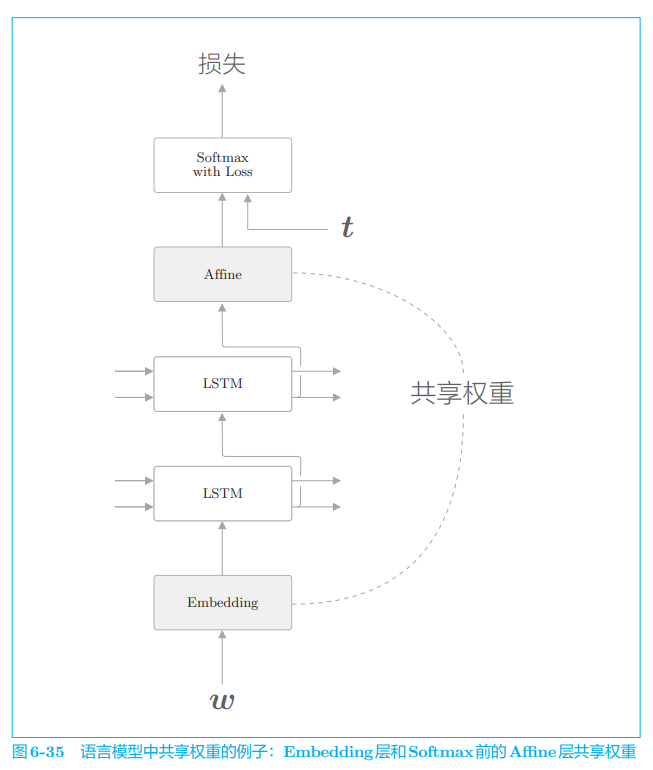

第六章 Gated RNN

目录6.1 RNN的问题6.1.1 RNN的复习6.1.2 梯度消失和梯度爆炸6.1.3 梯度消失和梯度爆炸的原因6.1.4 梯度爆炸的对策6.2 梯度消失和LSTM6.2.1 LSTM的接口6.2.2 LSTM层的结构6.2.3 输出门6.2.4 遗忘门6.2.5 新的记忆单元6.2.6 输入门6.2.7 LSTM的梯度的流动6.3 LSTM的实现6.4 使用…

tf.nn.dynamic_rnn应用案例及RNN中数据填充sequence_length的理解

本文代码来自于其他人的博客:

import tensorflow as tf

import numpy as np

tf.reset_default_graph()

x np.random.randn(2,3, 4)

x[1, 2:] 0

x_length [3, 2]cell tf.nn.rnn_cell.LSTMCell(num_units2, state_is_tupleTrue)outpus, last_states tf.nn.dyn…

【深度学习】第四章:循环神经网络

文章目录1. 为什么要使用循环神经网络?2. 简单循环神经网络3. 双向循环神经网络4. 应用到机器学习5. 参数学习5.1 随时间反向传播算法(BPTT)6. RNN的梯度爆炸与消失、长程依赖问题7. 长短时记忆网络 (LSTM)8. RNN vs CNN vs DNN1. 为什么要使…

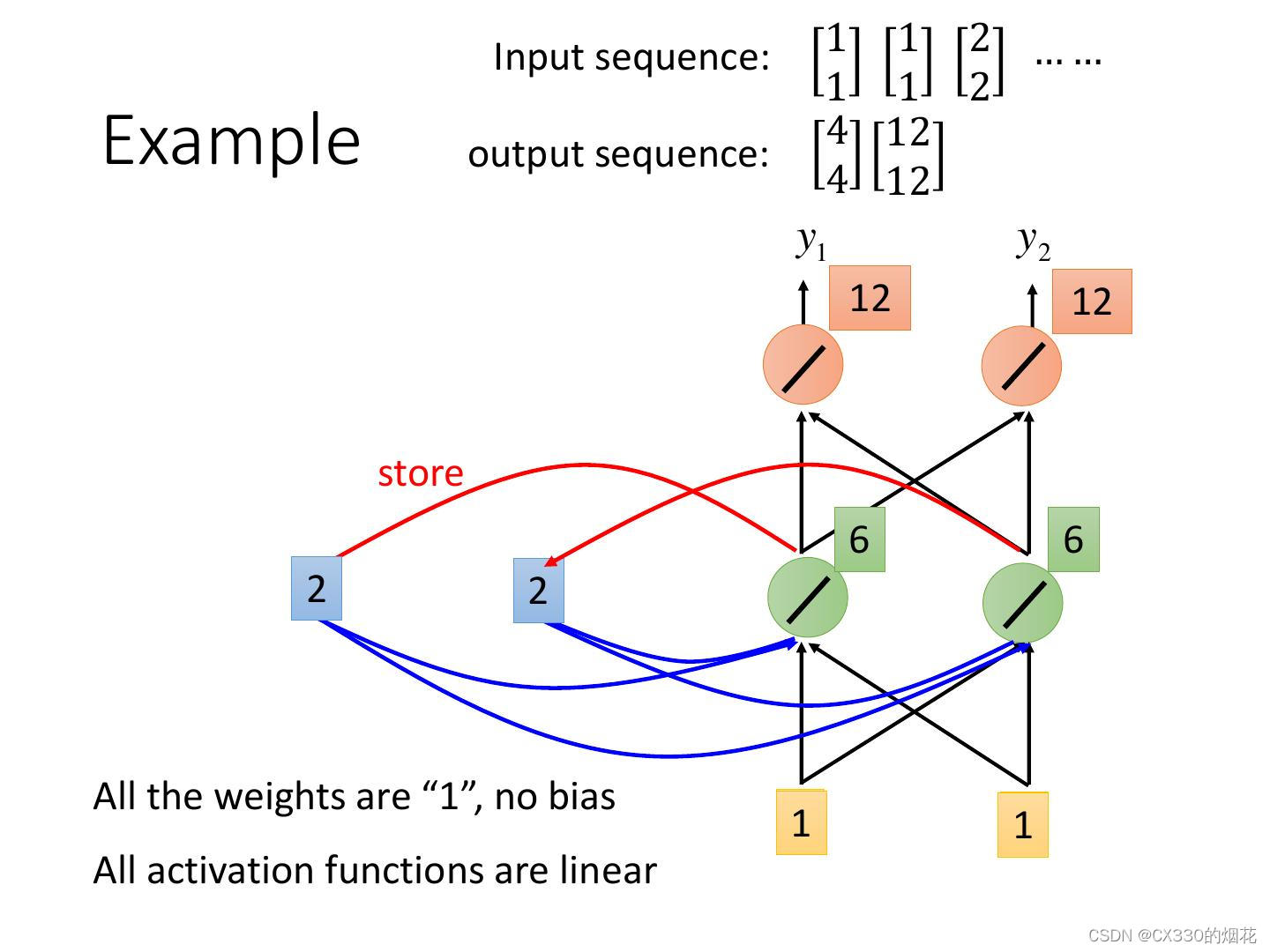

Recurrent Neural Network(循环神经网络)

目录

Slot Filling with RNN

Elman Network & Jordan Network

Bidirectional RNN

LSTM(Long Short-term Memory)

Example

Learning Target

LSTM

GRU (Gated Recurrent Unit)

More Applications

Many to One

Many to Many

Speech Recognition

Sequence to Sequ…

RNN循环神经网络(AI写唐诗)

RNN循环神经网络–潘登同学的深度学习笔记 文章目录RNN循环神经网络--潘登同学的深度学习笔记RNNRNN的数学表达式RNN手写数字识别RNN的拼接操作LSTM 长短时记忆(Long Short Time Memory)LSTM数学表达LSTM手写数字识别双向LSTMGRURNN里面应用的Topology结构AI写唐诗数据预处理RN…

【动手学深度学习-pytorch】-9.3深度循环神经网络

到目前为止,我们只讨论了具有一个单向隐藏层的循环神经网络。 其中,隐变量和观测值与具体的函数形式的交互方式是相当随意的。 只要交互类型建模具有足够的灵活性,这就不是一个大问题。 然而,对一个单层来说,这可能具有…

论文笔记: 循环神经网络进行速度模型反演 (未完)

摘要: 分享对论文的理解, 原文见 Gabriel Fabien-Ouellet and Rahul Sarkar, Seismic velocity estimation: A deep recurrent neural-network approach. Geophysics (2020) U21–U29. 作者应该是领域专家, 对地球科学的理解胜于深度学习. 为方便讨论, 等式编号保持与原文一致.…

神经网络结构——CNN、RNN、LSTM、Transformer !!

文章目录 前言 一、什么是CNN 网络结构 解决问题 工作原理 实际应用 二、什么是RNN 网络结构 解决问题 工作原理 应用场景 三、什么是LSTM 网络结构 解决问题 工作原理 应用场景 四、什么是Transformer 网络结构 解决问题 工作原理 BERT GPT 前言

本文将从什么是CNN࿱…

【项目实践】基于LSTM的一维数据扩展与预测

基于LSTM的一维数据拟合扩展

一、引(fei)言(hua)

我在做Sri Lanka生态系统服务价值计算时,中间遇到了一点小问题。从世界粮农组织(FAO)上获得Sri Lanka主要农作物产量和价格数据时,其中的主要作物Sorghum仅有2001-2006年的数据,而Millet只有…

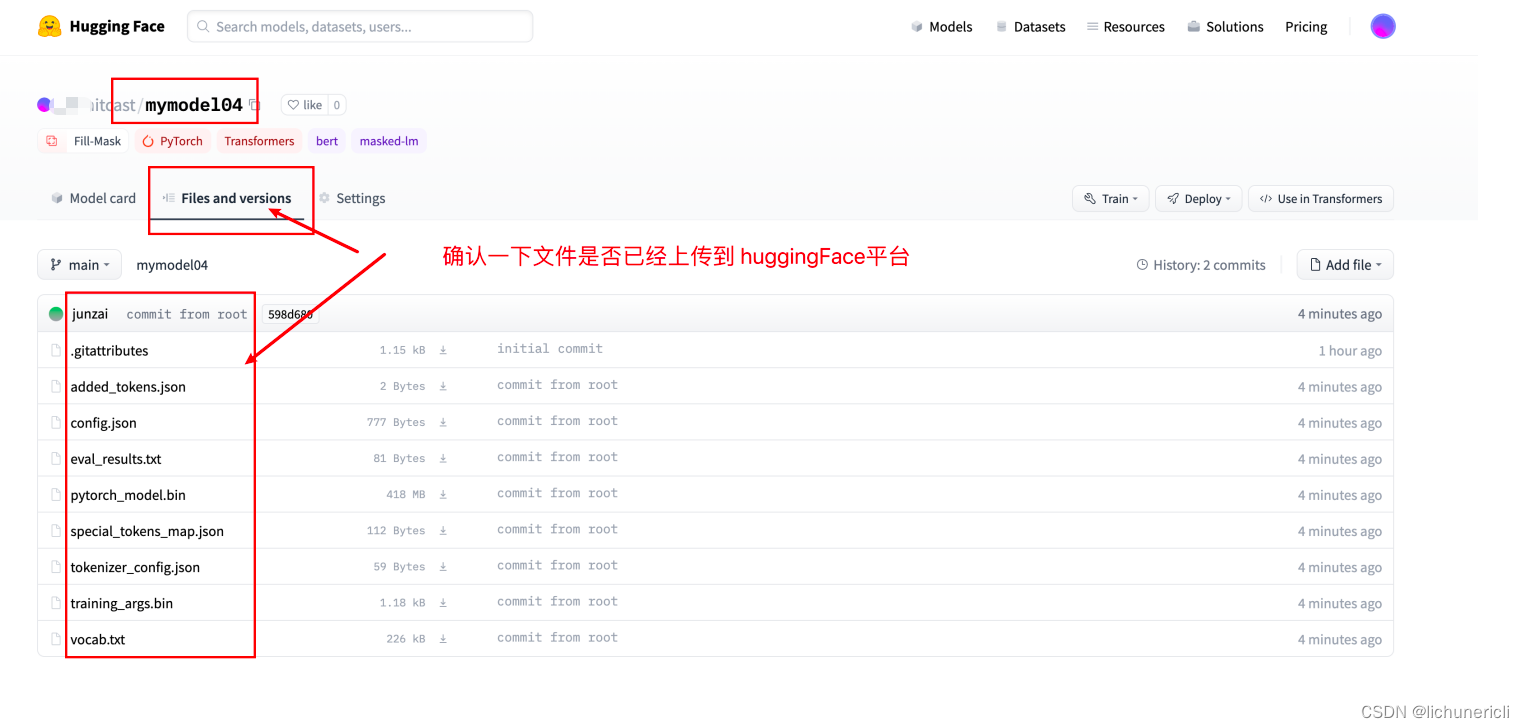

自然语言处理---huggingface平台使用指南

1 huggingface介绍

Huggingface总部位于纽约,是一家专注于自然语言处理、人工智能和分布式系统的创业公司。他们所提供的聊天机器人技术一直颇受欢迎,但更出名的是他们在NLP开源社区上的贡献。Huggingface一直致力于自然语言处理NLP技术的平民化(democr…

李沐机器学习系列5---循环神经网络

1 Introduction

对于样本的分析,通过全连接层处理表格数据,通过卷积神经网络处理图像数据;第一种假设,所有数据都是独立同分布的RNN 处理序列信号 序列数据的更多场景 1)用户使用习惯具有时间的先后性 2)外…

【阅读笔记】时间序列之TPA-LSTM(含Pytorch代码实现)

本文作为自己阅读论文后的总结和思考,不涉及论文翻译和模型解读,适合大家阅读完论文后交流想法,关于论文翻译可以查看参考文献。论文地址:https://arxiv.org/abs/1809.04206 TPA-LSTM 一. 全文总结二. 研究方法三. 结论四. 创新点…

循环神经网络之序列模型

自回归模型

自回归模型: 只与x 有关 ,对自己执行回归隐变量自回归:与X 和过去观测总结h 都有关

案例

%matplotlib inline

import torch

from torch import nn

from d2l import torch as d2lT 1000 # 总共产生1000个点

time torch.aran…

Pytorch搭建循环神经网络RNN(简单实战)

Pytorch搭建循环神经网络RNN(简单实战)

去年写了篇《循环神经网络》,里面主要介绍了循环神经网络的结构与Tensorflow实现。而本篇博客主要介绍基于Pytorch搭建RNN。

通过Sin预测Cos

import torch

import torch.nn as nn

import numpy as np

from matp…

【深度学习】RNN、LSTM、GRU

【深度学习】RNN、LSTM、GRURNNLSTMGRU结语RNN

和普通神经网络一样,RNN有输入层、输出层和隐含层,不一样的是RNN在不同的时间ttt会有不同的状态,其中t−1t-1t−1时刻隐含层的输出会作用到ttt时刻的隐含层。 RNN因为加入了时间序列ÿ…

RNN(Recurrent Neural Networks)循环神经网络

循环神经网络(Recurrent Neural Network,简称RNN)是一种处理序列数据的神经网络结构,它具有记忆能力,能够捕捉序列中的时序信息。RNN在自然语言处理、时间序列预测等方面有着很多的应用。

一、RNN 的基本结构

RNN的包…

股票预测和使用LSTM(长期-短期-记忆)的预测

一、说明 准确预测股市走势长期以来一直是投资者和交易员难以实现的目标。虽然多年来出现了无数的策略和模型,但有一种方法最近因其能够捕获历史数据中的复杂模式和依赖关系而获得了显着的关注:长短期记忆(LSTM)。利用深度学习的力…

基于CNN-RNN的医疗文本生成

🐱 基于CNN-RNN的医疗文本生成

本项目使用经过IMAGENET预训练的resnet101网络对图像特征进行提取后, 将图像特征输入LSTM来生成影像的文本描述。

初步实现了图像到文本的简单生成。 📖 0 项目背景 随着近年来深度学习的飞速发展,…

PyTorch 深度学习之循环神经网络(基础篇)Basic RNN(十一)

0.Revision: DNN dense 重义层 全连接 RNN处理带有序列的数据

1. What is RNNs?

linear layer 1.1 What is RNN?

tanh (-1, 1) 1.2 RNN Cell in PyTorch 1.3 How to use RNNCell *先把维度搞清楚 多了一个序列的维度

2. How to use RNN 2.1 How to use RNN - numLayers…

浅谈wor2vec,RNN,LSTM,Transfermer之间的关系

浅谈wor2vec,RNN,LSTM,Transfermer之间的关系

今天博主谈一谈wor2vec,RNN,LSTM,Transfermer这些方法之间的关系。

首先,我先做一个定位,其实Transfermer是RNN,LSTM&…

循环神经网络之语言模型和数据集

总结重要知识点 在给定这样的文本序列时,语言模型(language model)的目标是估计序列的联合概率 语言模型是自然语言处理的关键。 元语法通过截断相关性,为处理长序列提供了一种实用的模型。 长序列存在一个问题:它们…

机器学习深度学习——RNN的从零开始实现与简洁实现

👨🎓作者简介:一位即将上大四,正专攻机器学习的保研er 🌌上期文章:机器学习&&深度学习——循环神经网络RNN 📚订阅专栏:机器学习&&深度学习 希望文章对你们有所帮…

循环神经网络的网络结构,神经网络训练过程图解

如何使用tensorflow构建,训练和改进循环神经网络

我们利用TensorFlow提供的tf.train.AdamOptimizer来控制学习速度。

AdamOptimizer通过使用动量(参数的移动平均数)来改善传统梯度下降,促进超参数动态调整。

我们可以通过创建标…

TensorFlow2实战-系列教程12:RNN文本分类4

🧡💛💚TensorFlow2实战-系列教程 总目录 有任何问题欢迎在下面留言 本篇文章的代码运行界面均在Jupyter Notebook中进行 本篇文章配套的代码资源已经上传 8、压缩版本网络模型

class Model(tf.keras.Model):def __init__(self, params):supe…

【神经网络】循环神经网络RNN和长短期记忆神经网络LSTM

循环神经网络RNN和长短期记忆神经网络LSTM

欢迎访问Blog总目录! 文章目录 循环神经网络RNN和长短期记忆神经网络LSTM1.循环神经网络RNN(Recurrent Neural Network)1.1.学习链接1.2.RNN结构1.3.RNN缺点 2.长短期记忆递归神经网络LSTM&#x…

深度学习入门(五十四)循环神经网络——文本预处理

深度学习入门(五十四)循环神经网络——文本预处理前言循环神经网络——文本预处理教材1 读取数据集2 词元化3 词表4 整合所有功能5 小结前言

核心内容来自博客链接1博客连接2希望大家多多支持作者 本文记录用,防止遗忘

循环神经网络——文本…

深度学习500问——Chapter06: 循环神经网络(RNN)(2)

文章目录 6.4 CNN和RNN的区别 6.5 RNNs与FNNs有什么区别 6.6 RNNs训练和传统ANN训练异同点 6.7 为什么RNN训练的时候Loss波动很大 6.8 标准RNN前向输出流程 6.9 BPTT算法推导 6.9 RNN中为什么会出现梯度消失 6.10 如何解决RNN中的梯度消失问题 6.4 CNN和RNN的区别

类别特点描述…

使用注意力机制的 LSTM 彻底改变时间序列预测

目录 一、说明二、LSTM 和注意力机制简介三、为什么要将 LSTM 与时间序列注意力相结合?四、模型架构训练与评估 五、验证六、计算指标七、结论 一、说明 在时间序列预测领域,对更准确、更高效的模型的追求始终存在。深度学习的应用为该领域的重大进步铺…

Pytorch 对比TensorFlow 学习:Day 17-18: 循环神经网络(RNN)和LSTM

Day 17-18: 循环神经网络(RNN)和LSTM

在这两天的学习中,我专注于理解循环神经网络(RNN)和长短期记忆网络(LSTM)的基本概念,并学习了它们在处理序列数据时的应用。

1.RNN和LSTM基础…

01- 从零开始完整实现-循环神经网络RNN

一 简介

使用 pytorch 搭建循环神经网络RNN,循环神经网络(Recurrent Neural Network,RNN)是一类用于 处理序列数据的神经网络架构。与传统神经网络不同,RNN 具有内部循环结构,可以在处理序列数据时保持状态…

计算机视觉 Computer Vision Chaper13 图像描述

文章目录深度语言模型RNN 原理解析LSTM 原理解析GRU 门控循环单元图说模型原理与结构Image Captioning 图说模型NIC Neural Image CaptionAttention 注意力机制SAT模型数据集介绍深度语言模型 RNN 原理解析 Y是一个概率vector,最大的概率是希望输出的词。 W其实是乘…

模型部署实战:从训练到上线

目录

1.前言

2.RESTful API设计

3.使用Flask/Django开发后端服务

4.使用TensorFlow Serving部署模型

5.性能监控与服务维护要点

6.总结 1.前言 在机器学习的全周期中,模型部署是至关重要的一环。经过长时间的训练、验证和优化,当模型准备就绪时&am…

CNN,DNN,RNN,GAN,RL+图像处理常规算法(未完待续)

好的,让我们先介绍一些常见的神经网络模型,然后再讨论图像处理的常规算法。

神经网络模型:

1. CNN(卷积神经网络)

原理: CNN主要用于处理图像数据。它包含卷积层、池化层和全连接层。卷积层通过卷积操作…

经典循环神经网络(一)RNN及其在歌词数据集上的应用

经典循环神经网络(一)RNN及其在歌词数据集上的应用

1 RNN概述

在深度学习兴起之前,NLP领域一直是统计模型的天下,例如词对齐算法GIZA,统计机器翻译开源框架MOSES等等。在语言模型方向,n-gram是当时最为流行的语言模型方法。n-gr…

RNN GRU模型 LSTM模型图解笔记

RNN模型图解引用RNN模型GRULSTM深度RNN双向循环神经网络引用

动手学深度学习v2–李沐 LSTM长短期记忆网络3D模型–B站up梗直哥丶

RNN模型 加入了一个隐变量(状态),隐变量由上个隐变量和上一个输入而更新,这样模型就可以达到具有短期记忆的效…

![循环神经网络-RNN记忆能力实验 [HBU]](https://img-blog.csdnimg.cn/direct/038b2e112f4d4ff2ad489a954d93a044.png)

![[Deep Learning 译文] LeCun、Bengio和Hinton三大牛的联合综述(下)](http://img.ptcms.csdn.net/article/201506/01/556c21930765c_middle.jpg?_=36123)

![保留网络[02/3]:大型语言模型转换器的继任者”](https://img-blog.csdnimg.cn/img_convert/c78ed8982f37ee7b946b985d7bb67ee9.png)

![[oneAPI] 使用字符级 RNN 生成名称](https://img-blog.csdnimg.cn/71b6a6705a3449d7bb9657237227a6ad.png)